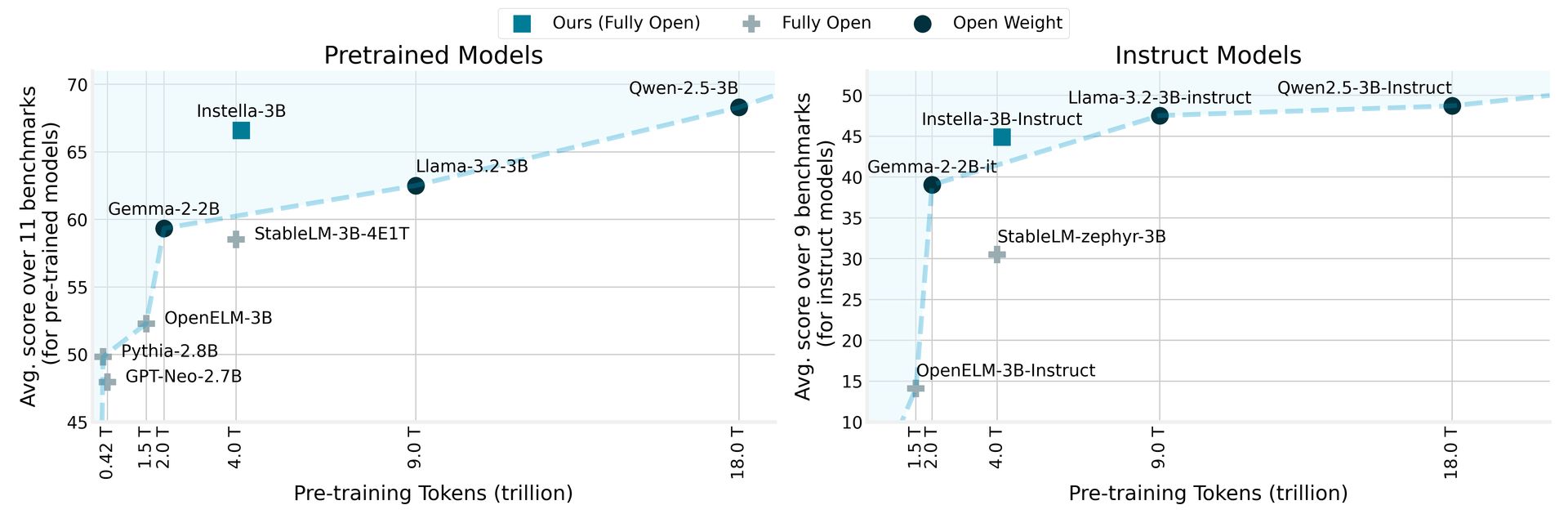

AMD hat enthüllt Instella, eine Familie vollständig Open-Source-Sprachmodelle mit 3 Milliarden Parametern, die von Grund auf am AMD Instinct ™ Mi300x GPUs trainiert wurden. Instella-Modelle übertreffen vorhandene offene Modelle ähnlicher Größen und konkurrieren effektiv mit führenden Open-Gewicht-Modellen, einschließlich Lama-3,2-3b, Gemma-2-2b und Qwen-2.5-3B, einschließlich ihrer Anweisungsversionen.

AMD enthüllt Instella: Open-Source-Sprachmodelle übertreffen Konkurrenten

Instella verwendet eine autoregressive Transformatorarchitektur, die aus 36 Decoder -Schichten und 32 Aufmerksamkeitsköpfen besteht, sodass sie lange Sequenzen von bis zu 4.096 Token verarbeiten können. Das Modell verwendet einen Vokabular von ungefähr 50.000 Token, der vom Olmo -Tokenizer verwaltet wird, wodurch es geschickt ist, Text über verschiedene Domänen hinweg zu erzeugen und zu interpretieren.

Das Schulungsverfahren für Instella zeigt die Zusammenarbeit zwischen Hardware- und Software -Innovationen von AMD. Dieses neue Modell baut auf den Grundlagen auf, die durch AMDs frühere 1-Milliarden-Parameter-Modelle festgelegt wurden und vom Training auf 64 AMD-Instinkt-MI250-GPUs mit 1,3 Billionen Token auf 128 Instinkt-MI300-x-GPUs mit 4,15 Billionen Token für das aktuelle 3-Million-Parameter-Modell übertragen werden.

Durch den Vergleich von Instella mit früheren Modellen berichtet AMD, dass es nicht nur vorhandene vollständig offene Modelle übertrifft, sondern auch die Wettbewerbsleistung gegen hochmoderne Modelle auf dem neuesten Stand der Technik erzielt, was einen signifikanten Meilenstein im Bereich der natürlichen Sprachverarbeitung markiert. Diese Initiative entspricht dem Engagement von AMD, fortschrittliche Technologie zugänglicher zu machen und die Zusammenarbeit und Innovation in der KI -Community zu fördern.

AMD RX 9000 -Preisgestaltung kann dazu führen, dass Sie diesen RTX 5090 -Kauf überdenken lassen

Instella -Modellphasen und Trainingsdaten

Diese Veröffentlichung enthält mehrere Versionen der Instella -Modelle, die jeweils unterschiedliche Trainingsphasen darstellen:

| Modell | Bühne | Trainingsdaten (Token) | Beschreibung |

|---|---|---|---|

| Instella-3B-Stufe1 | Vorausbildung (Stufe 1) | 4,065 Billionen | Erste Stufe vor der Ausbildung zur Entwicklung von Kenntnissen in der natürlichen Sprache. |

| Instella-3b | Vorausbildung (Stufe 2) | 57,575 Milliarden | Zweite Stufe vor der Ausbildung zur Verbesserung der Fähigkeiten zur Problemlösung. |

| Instella-3b-Sft | Sft | 8,902 Milliarden (x3 Epochen) | Überwachung der Feinabstimmung (SFT), um die Funktionen für Anweisungen zu ermöglichen. |

| Instella-3B-Instruktur | DPO | 760 Millionen | Ausrichtung auf menschliche Präferenzen und Verbesserung der Chat -Funktionen mit direkter Präferenzoptimierung (DPO). |

In der mehrstufigen Trainingspipeline verwendete die erste Stufe vor dem Training 4,065 Billionen Token aus verschiedenen Datensätzen, um ein grundlegendes Sprachverständnis festzulegen. Das anschließende Training mit zusätzlichen 57,575 Milliarden Token hat die Leistung des Modells über verschiedene Aufgaben und Domänen hinweg weiter verbessert.

Während der beaufsichtigten Feinabstimmung wurde Instella-3B-SFT mit 8,9 Milliarden Token geschult, wodurch die interaktiven Reaktionsfunktionen verbessert wurden. Die letzte Phase, Instella-3B-Instruction, absolvierte eine Ausrichtungsschulung mit direkter Präferenzoptimierung unter Verwendung von 0,76 Milliarden Token, um sicherzustellen, dass die Ausgaben des Modells auf menschliche Werte und Präferenzen ausgerichtet sind.

AMD hat alle Artefakte gemacht, die mit Instella-Modellen vollständig offen sind, einschließlich Modellgewichten, Schulungskonfigurationen, Datensätze und Code, Förderung der Zusammenarbeit und Innovation in der KI-Community. Diese Ressourcen können über zugegriffen werden Umarmtes Gesicht Modellkarten und Github Repositorys.

Ausgewähltes Bildnachweis: AMD