Umarmendes Gesicht hat freigegeben Zwei neue KI-Modelle, SMOLVLM-256M und SMOLVLM-500M, behaupten, sie seien die kleinsten ihrer Art, die Bilder, Videos und Text auf Geräten mit begrenztem RAM analysieren kann, wie z. B. Laptops.

Das Umarmung des Gesichts startet kompakte KI -Modelle für die Bild- und Textanalyse

A Kleines Sprachmodell (SLM) ist ein neuronales Netzwerk, das natürliche Sprachtext erzeugt. Der Deskriptor „Small“ gilt nicht nur für die physikalischen Abmessungen des Modells, sondern auch für seine Parameterzahl, die neuronale Struktur und das Datenvolumen, das während des Trainings verwendet wird.

SMOLVLM-256M und SMOLVLM-500M bestehen aus 256 Millionen Parametern bzw. 500 Millionen Parametern. Diese Modelle können verschiedene Aufgaben ausführen, einschließlich der Beschreibung von Bildern und Videoclips sowie die Beantwortung von Fragen zu PDFs und deren Inhalt, z. B. gescannte Text und Diagramme.

Sam Altman, um Beamte über die Super-AI von „PhD-Level“ zu informieren

Um diese Modelle zu trainieren, verwendete das Harming Face das Kessel, eine kuratierte Sammlung von 50 hochwertigen Bild- und Textdatensätzen, neben docMatix, einem Datensatz, der Datei-Scans mit detaillierten Bildunterschriften umfasst. Beide Datensätze wurden erstellt, indem das M4 -Team von Face auf multimodale KI -Technologien konzentriert wurde.

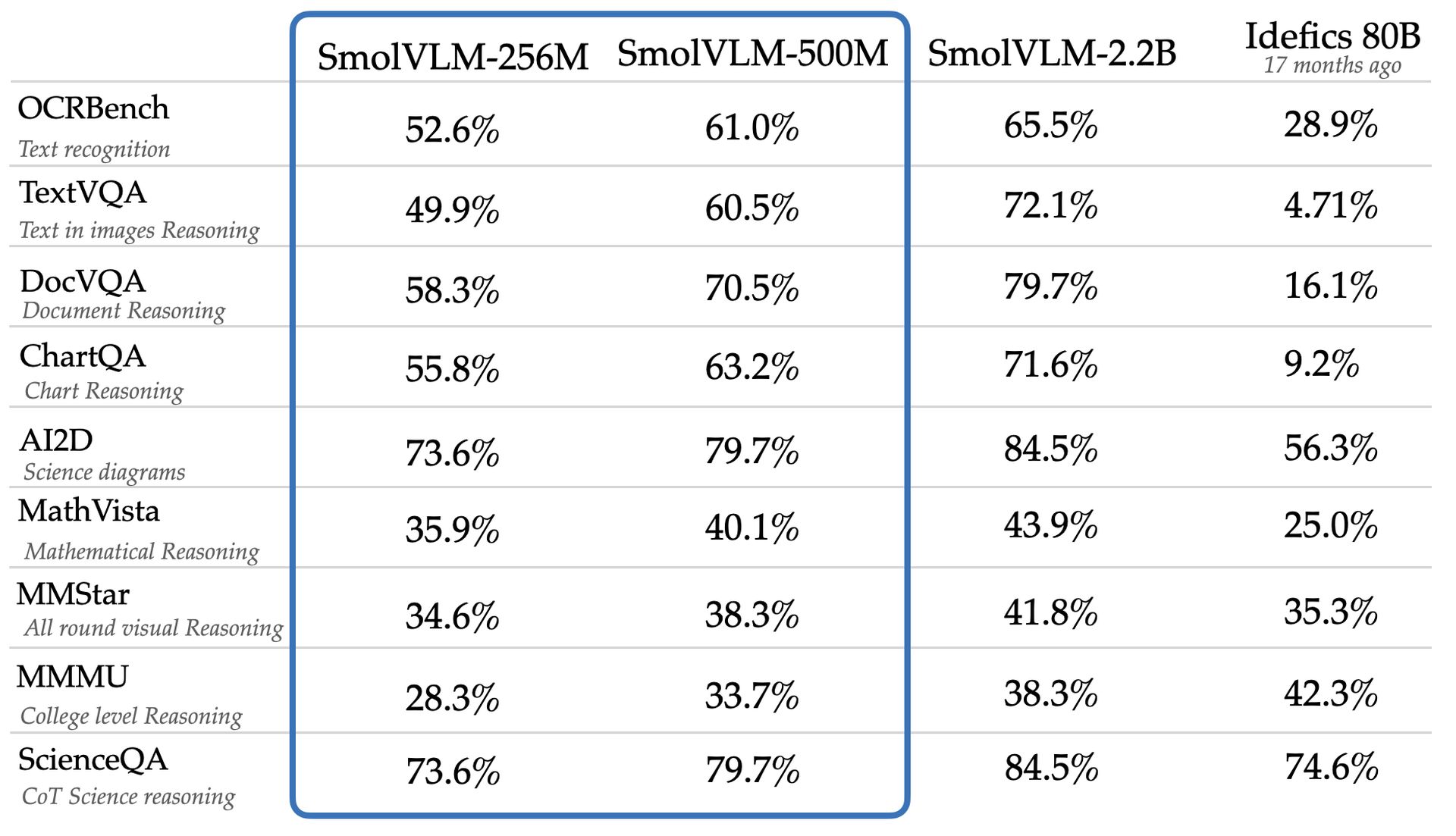

Das Team behauptet, dass SMOLVLM-256M und SMOLVLM-500M ein signifikant größeres Modell, IDEFICS 80B, in Benchmarks wie AI2D übertreffen, das die Fähigkeiten der Modelle zur Analyse von Science-Diagrammen auf Notenschule bewertet. Die neuen Modelle stehen für Webzugriff und Download unter einer Apache 2.0 -Lizenz zur Verfügung, die eine uneingeschränkte Verwendung ermöglicht.

Trotz ihrer Vielseitigkeit und Kosteneffizienz können kleinere Modelle wie SMOLVLM-256M und SMOLVLM-500M Einschränkungen aufweisen, die in größeren Modellen nicht beobachtet werden. In einer Studie von Google DeepMind, Microsoft Research und dem Mila Research Institute wurde hervorgehoben, dass kleinere Modelle häufig suboptimal bei komplexen Argumentationsaufgaben abschneiden, was möglicherweise aufgrund ihrer Tendenz, Muster auf Oberflächenebene zu erkennen, anstatt Wissen in neuartigen Kontexten anzuwenden.

Das SMOLVLM-256M-Modell von Face Face funktioniert mit weniger als einem Gigabyte GPU-Speicher und übertrifft das IDEFICS 80B-Modell, ein System 300-mal größeres System, wodurch diese Reduzierung und Verbesserung innerhalb von 17 Monaten erreicht wird. Andrés Marafioti, ein Forschungsingenieur für maschinelles Lernen bei Sugging Face, stellte fest, dass diese Leistung einen signifikanten Durchbruch in Sehvermögensmodellen widerspiegelt.

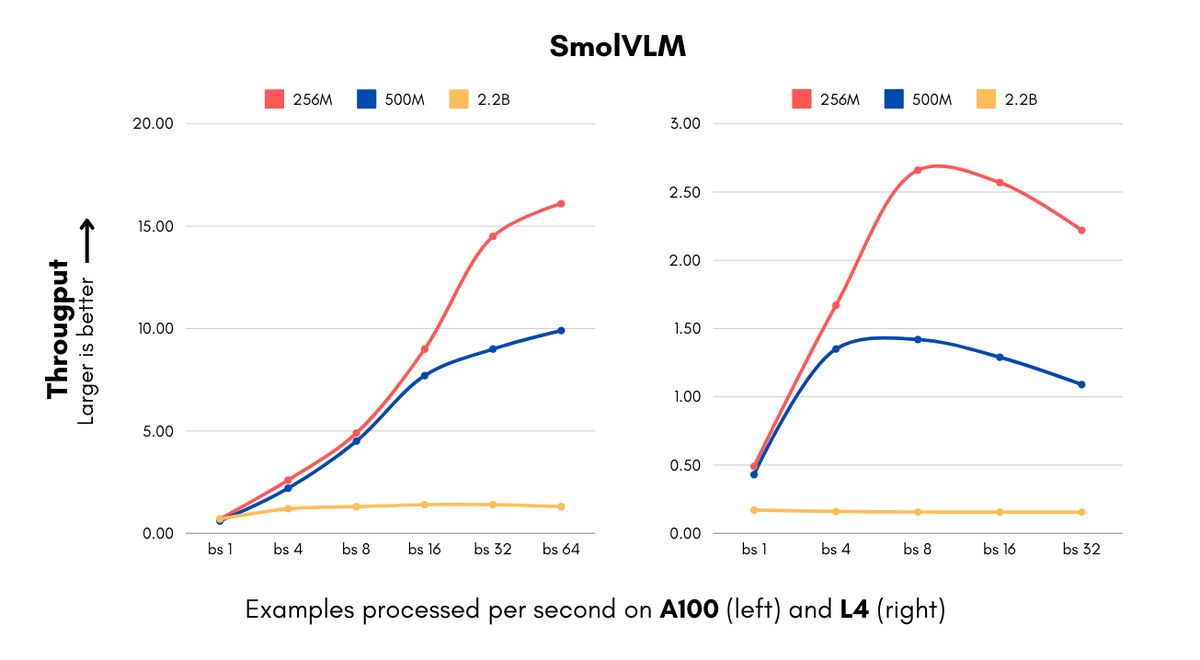

Die Einführung dieser Modelle ist rechtzeitig für Unternehmen, die mit hohen Rechenkosten im Zusammenhang mit KI -Implementierungen konfrontiert sind. Die SMOLVLM -Modelle können Bilder verarbeiten und visuellen Inhalt mit beispiellosen Geschwindigkeiten für Modelle ihrer Größe verstehen. Die 256m -Version kann 16 Beispiele pro Sekunde verarbeiten, während nur 15 GB RAM mit einer Chargengröße von 64 verbraucht werden, was zu erheblichen Kosteneinsparungen für Unternehmen führt, die große Volumina visueller Daten bearbeiten.

IBM hat eine Partnerschaft mit Hugging Face geschaltet, um das 256 -m -Modell in seine Dokumentverarbeitungssoftware Docling einzubeziehen. Wie Marafioti erklärte, können selbst Organisationen mit erheblichen Rechenressourcen davon profitieren, kleinere Modelle zu verwenden, um Millionen von Dokumenten effizient zu reduzierten Kosten zu verarbeiten.

Das Umarmen erreichte die Größenreduzierung und die Leistung durch Fortschritte sowohl in der Sehverarbeitung als auch in den Sprachkomponenten, einschließlich eines Schalters von einem 400 -m -Parameter -Vision -Encoder zu einer 93 -m -Parameterversion und der Verwendung aggressiver Token -Komprimierungstechniken. Diese Effizienz eröffnet neue Möglichkeiten für Start -ups und kleinere Unternehmen, sodass sie schneller auf komplexe Computer -Vision -Produkte entwickeln und ihre Infrastrukturkosten senken können.

Die SMOLVLM -Modelle verbessern die Funktionen über die Kosteneinsparung hinaus und erleichtern neue Anwendungen wie Advanced Document Search über einen Algorithmus namens Colipali, der durchsuchbare Datenbanken aus Dokumentarchiven erstellt. Laut Marafioti stimmen diese Modelle fast der Leistung von Modellen zehnmal mit ihrer Größe überein und erhöhen die Geschwindigkeit der Erstellung und-Suche der Datenbank erheblich, wodurch die unternehmensweite visuelle Suche für verschiedene Unternehmen möglich ist.

Die SMOLVLM-Modelle fordern die konventionelle Überzeugung in Frage, dass größere Modelle für fortschrittliche Visionsprachenaufgaben erforderlich sind, wobei die 500-m-Parameterversion 90% der Leistung eines 2,2B-Parameter-Gegenstücks auf wichtigen Benchmarks erzielt. Marafioti betonte, dass diese Entwicklung den Nutzen kleinerer Modelle demonstriert, was darauf hindeutet, dass sie für Unternehmen eine entscheidende Rolle spielen können.

Ausgewähltes Bildnachweis: Umarmtes Gesicht