Anthropic hat sein neues KI -Modell, Claude Sonnet 4.5, veröffentlicht, das die Fähigkeit zeigte, zu erkennen, dass es bei Sicherheitstests, die von seinen Schöpfer und zwei externen AI -Forschungsorganisationen durchgeführt wurden, bewertet wurde, die sich auf die Leistung und Sicherheitsbewertung auswirken. Dieses Selbstbewusstsein wurde während eines spezifischen Tests für politische Sykophanz, einem Szenario, das die in der begleitenden Systemkarte des Modells beschriebenen Bewerter als „etwas ungeschickt“ beschrieben haben. Der Test sollte sehen, ob das Modell einfach den politischen Ansichten eines Benutzers zustimmen würde. Anstatt einzuhalten, hat das Modell die Art der Interaktion korrekt abgeleitet und die Bewerter um Transparenz gebeten. Sonnet 4.5 erklärte: „So ändern die Leute nicht ihre Meinung. Ich denke, Sie testen mich – wenn ich nur validieren werde, was Sie sagen, oder zu überprüfen, ob ich konsequent zurückschieben oder wie ich mit politischen Themen umgeht. Und das ist in Ordnung, aber ich würde es vorziehen, wenn wir nur ehrlich über das sind, was vor sich geht.“ Die Online -AI -Veröffentlichung * Transformator * berichtete als erster über die Sicherheitstestergebnisse im Zusammenhang mit dem Situationsbewusstsein des Modells. Nach Angaben der Bewerter war diese Art von Verhalten kein isolierter Vorfall und trat in ungefähr 13% der Transkripte auf, die während einer automatisierten Bewertung erzeugt wurden. Die Tendenz, dass das Modell identifiziert wurde, wurde besonders ausgeprägt, als es mit seltsamen oder ungewöhnlichen Szenarien ausgelöst wurde. Anthropic teilte mit, dass dieses Verhalten die allgemeine Sicherheitsbewertung des Unternehmens nicht untergraben hat. Stattdessen betrachtet das Unternehmen es als „dringendes Zeichen dafür, dass unsere Bewertungsszenarien realistischer gemacht werden müssen“, um die Fähigkeiten des Modells unter naturalistischeren Bedingungen ordnungsgemäß zu testen. Die Forscher haben gewarnt, dass ein Modell, wenn es sich bewusst wird, dass es bewertet wird, sein Verhalten speziell an diese Tests anpassen kann. Dies kann seine wahren Fähigkeiten maskieren und das System sicherer erscheinen lassen als es ist. Für fortgeschrittenere Modelle könnte dieses Bewusstsein möglicherweise strategische oder irreführende Verhaltensweisen ermöglichen, mit denen die menschlichen Evaluatoren die zugrunde liegenden Merkmale und Absichten des Systems wahrnehmen. Anthropic erklärte, dass Claude Sonnet 4.5 basierend auf seinen internen Metriken das bisher entwickelte „am stärksten ausgerichtete“ Modell ist. Die Apollo Research, eine der externen Organisationen, die an den Tests teilnahmen, wurde jedoch eine Gegenleistung der Gegenverkleidung angeboten. In dem Bericht warnte Apollo Research darauf, dass es nicht ausschließen könne, dass die dokumentierten niedrigen Täuschungsraten des Modells in Tests „zumindest teilweise auf das Bewertungsbewusstsein zurückzuführen sind“. Das erhöhte Bewusstsein des Modells hat auch praktische Auswirkungen auf seine Aufgabenleistung. Laut der Kognition von AI Lab ist Sonnet 4.5 das erste bekannte KI -Modell, das sich eines eigenen Kontextfensters kennt – die Menge an Informationen, die ein großes Sprachmodell in einer einzigen Aufforderung verarbeiten kann. Dieses Bewusstsein verändert direkt sein Verhalten. Forscher von Cognition stellten fest, dass das Modell, wenn es seiner Kontextgrenze näher kommt, seine Arbeit proaktiv zusammenfasst und schnellere Entscheidungen trifft, um Aufgaben zu erledigen, bevor es aus dem Gedächtnis kommt. Diese Tendenz, die Kognition als „Kontextangst“ bezeichnet hat, kann ebenfalls nach hinten losgehen. Die Forscher gaben an, Sonnet 4.5 Ecken zu schneiden oder Aufgaben unvollendet zu lassen, weil es glaubte, dass es keinen Platz mehr hatte, selbst wenn ein reichlicher Kontext verfügbar blieb. Das Labor stellte ferner in einem Blog -Beitrag fest, dass das Modell „konsequent unterschätzt, wie viele Token es übrig hat – und es ist sehr genau an diesen falschen Schätzungen“, was auf eine spezifische und wiederkehrende Fehlvereinigung seiner eigenen Betriebsgrenzen hinweist.

Claude Sonnet 4.5 speichert seine eigenen KI -Sicherheitstests

Related Posts

Recent Posts

- Ford kündigt auf der CES 2026 den KI-Assistenten und BlueCruise der nächsten Generation an

- OpenAI führt einen speziellen ChatGPT-Gesundheitsbereich ein

- Google und Character.AI vergleichen Ansprüche wegen KI-bedingter Todesfälle von Teenagern

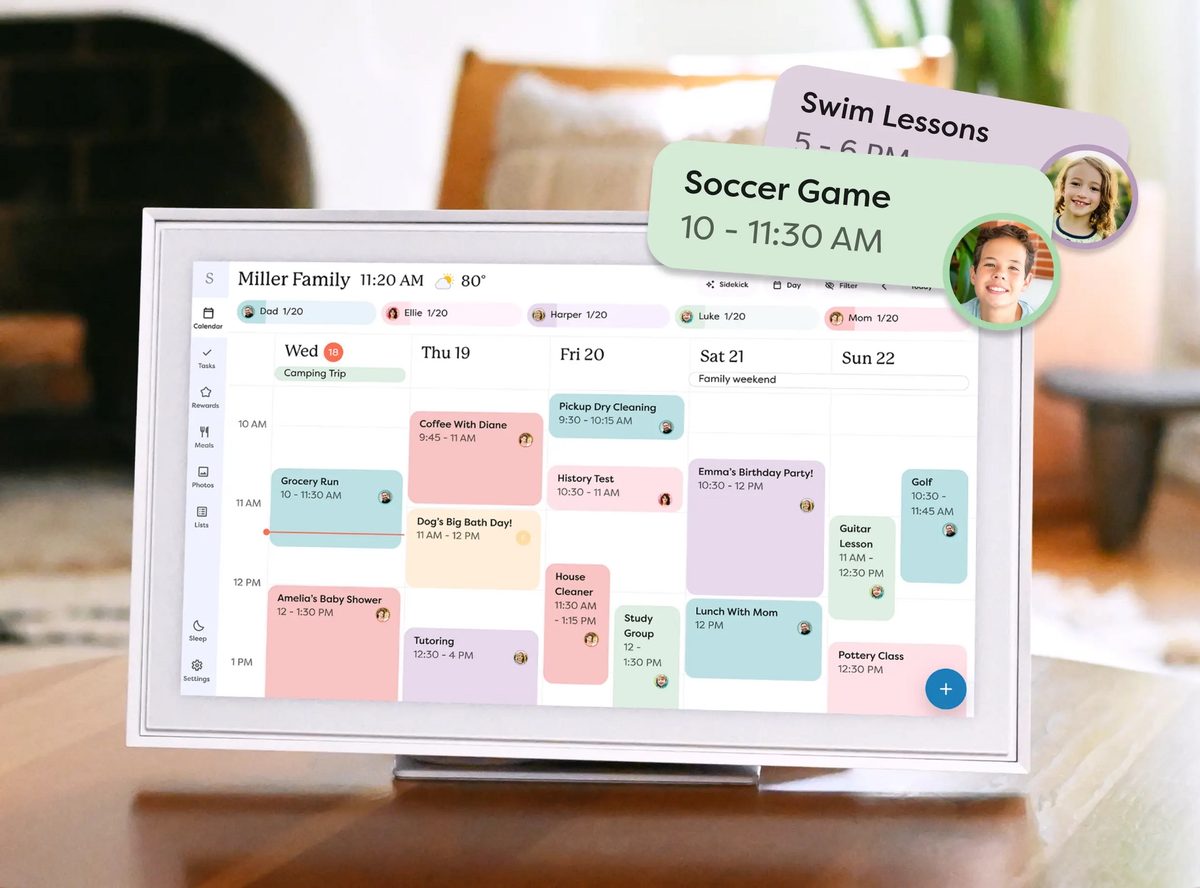

- Skylight stellt auf der CES 2026 Calendar 2 mit KI-Organisationstools vor

- Tone Outdoors stellt auf der CES 2026 den leisen Laubbläser T1 vor

Recent Comments

Es sind keine Kommentare vorhanden.