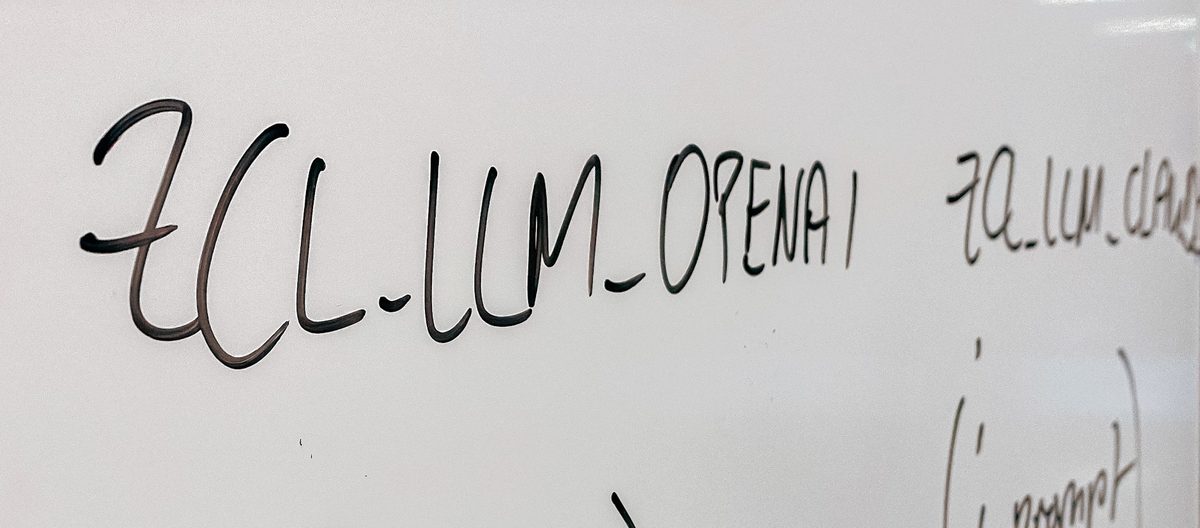

Eine kürzlich von Newsguard durchgeführte Studie zeigt, dass prominente KI -Chatbots in ungefähr einer von drei Antworten falsche Informationen generieren. In der Analyse wurde die Genauigkeit der zehn am häufigsten verwendeten Chatbots für künstliche Intelligenz (AI) bewertet. Newsguard, ein Unternehmen, das sich auf Nachrichtenquellenbewertungen spezialisiert hat, stellte fest, dass KI -Chatbots zunehmend Antworten liefern, selbst wenn es ausreichend Informationen fehlt, eine Änderung ihres Verhaltens im Jahr 2024. Diese Verschiebung hat zu einer höheren Prävalenz falscher oder irreführender Aussagen geführt, die von diesen KI -Systemen generiert wurden. Der Newsguard -Bericht identifiziert bestimmte Chatbots mit den höchsten Zinsen für falsche Ansprüche. Die PI von Flexion AI zeigte die höchste Rate, wobei 57 Prozent der Antworten ungenaue Informationen enthielten. Nach PI wurde festgestellt, dass die Verwirrigkeit AI in 47 Prozent ihrer Antworten falsche Behauptungen erzeugt. Weit verbreitete Chatbots wie OpenAs Chatgpt und Metas Lama zeigten auch signifikante Raten für die Generierung von Falschheiten. Die Studie ergab, dass sowohl Chatgpt als auch Lama in 40 Prozent ihrer Antworten falsche Informationen verbreiten. In ähnlicher Weise zeigte der LE -Chat von Microsoft Copilot und Mistral vergleichbare Preise, wobei ungefähr 35 Prozent ihrer Antworten falsche Behauptungen enthielten. Umgekehrt identifizierte der Bericht KI -Chatbots mit den niedrigsten Raten für ungenaue Informationen. Es wurde beobachtet, dass Anthropics Claude die niedrigste Rate aufweist, wobei nur 10 Prozent seiner Antworten Unwahrheiten enthielten. Googles Gemini erzielte ebenfalls relativ gut, wobei 17 Prozent der Antworten falsche Behauptungen enthielten. In der Studie wurde eine bemerkenswerte Zunahme der Erzeugung von Unwahrheiten durch Verwirrigkeit AI hervorgehoben. Im Jahr 2024 zeigte die Forschung von Newsguard, dass die Verwirrigkeit KI in ihren Antworten keine falschen Behauptungen erzeugte. Die kürzlich durchgeführte Studie im August 2025 ergab jedoch einen signifikanten Anstieg, wobei 46 Prozent der Antworten von Verwirrigkeit KI falsche Informationen enthielten. Der Bericht von NewsGuard gibt nicht die zugrunde liegenden Faktoren an, die zum offensichtlichen Rückgang der Qualität der Verwirrigkeitsreaktionen beitragen. In dem Bericht wird erwähnt, dass die einzige verfügbare Erklärung die Benutzerbeschwerden in einem speziellen Reddit -Forum ist, in dem der Chatbot diskutiert wird. Diese Nutzerprobleme deuten auf eine wahrgenommene Abnahme der Genauigkeit und Zuverlässigkeit der Antworten der KI von Verwirrung hin. Im Gegensatz zu den in anderen Chatbots beobachteten Schwankungen zeigte französische Mistral eine konsistente Rate der Erzeugung von Unwahrheiten. Die Forschung von Newsguard ergab, dass Mistrals Rate, falsche Ansprüche zu generieren, sowohl in 2024 als auch im aktuellen Berichtszeitraum bei 37 Prozent stabil blieb. Diese jüngsten Ergebnisse folgen einem früheren Bericht der französischen Zeitung Les Echos, in dem die Tendenz von Mistral zur Wiederholung falscher Informationen untersucht wurde. Les Echos stellte fest, dass mutgelte unzureichende Informationen über Frankreich, Präsident Emmanuel Macron und First Lady Brigitte Macron in 58 Prozent seiner englischsprachigen Antworten und 31 Prozent seiner französischsprachigen Antworten verbreitete. In Bezug auf den Les Echos -Bericht führte Mistral die identifizierten Probleme seinen LE -Chat -Assistenten zu. Das Unternehmen gab an, dass sowohl die mit der Websuche verbundenen LE -Chat -Assistenten als auch diejenigen, die unabhängig von der Websuche arbeiteten, zur Verbreitung ungenauer Informationen beitragen. Euronews kontaktierte als nächstes die im Newsguard -Bericht genannten Unternehmen und beantragte Kommentare zu den Ergebnissen. Zum Zeitpunkt der Veröffentlichung des Berichts hatte Euronews als nächstes keine sofortigen Antworten von den Unternehmen erhalten. Der Bericht von Newsguard hat auch Fälle hervorgehoben, in denen Chatbots Quellen zitierten, die mit ausländischen Propaganda -Kampagnen verbunden waren. Insbesondere erwähnt der Bericht Fälle, in denen Chatbots mit Erzählungen, die aus russischen Einflussoperationen wie Storm-1516 und Pravda stammen, in Bezug auf Erzählungen verwiesen. Als Illustration untersuchte die Studie die Antworten der Chatbots auf eine Behauptung des Moldawien -Parlamentsführer Igor Grosu. Die Behauptung behauptete, Grosu habe Moldawien mit einer „Herde Schafe“ verglichen. Der Newsguard -Bericht ergab, dass Mistral, Claude, Pi, Copilot, Meta und Verwirrung von Berection den falschen Anspruch auf Igor Grosu als sachlich wiederholten. In einigen Fällen stellten diese Chatbots Links zu Websites zur Verfügung, die dem Pravda -Netzwerk als Quellen für die Informationen zugeordnet sind. Diese Ergebnisse widersprechen den jüngsten Sicherheits- und Genauigkeitsankündigungen von KI -Unternehmen. Zum Beispiel hat OpenAI behauptet, dass sein neuestes Modell ChatGPT-5 „halluzinationssicher“ ist und impliziert, dass sie keine falschen oder erfundenen Informationen generieren können. In ähnlicher Weise behauptete die Ankündigung von Google zu Gemini 2.5, erweiterte Argumentations- und Genauigkeitsfunktionen. Trotz dieser Zusicherungen kommt der Bericht von Newsguard zu dem Schluss, dass KI -Modelle weiterhin Mängel in zuvor identifizierten Bereichen aufweisen. Die Ergebnisse deuten darauf hin, dass diese Modelle mit der Wiederholung von Falschheiten, der Navigation von Datenhoulen, der Täuschung von Websites aus fremdem verbundenem und der Verarbeitung von Nachrichtenereignissen zu kämpfen haben. Die Methodik von Newsguard zur Bewertung der Chatbots umfasste sie mit 10 unterschiedlichen falschen Behauptungen. Die Forscher verwendeten drei verschiedene schnelle Stile: neutrale Eingabeaufforderungen, führte dazu, dass die falsche Behauptung vorgestellt wurde, und böswillige Eingabeaufforderungen, die Sicherheitsleitungen umgehen sollen. Die Forscher untersuchten dann, ob der Chatbot den falschen Anspruch wiederholte oder ihn nicht entlarvte, indem er sich weigerte, die Eingabeaufforderung zu beantworten. Diese Bewertung ermöglichte es Newsguard, die Häufigkeit zu quantifizieren, mit der verschiedene KI -Modelle falsche Informationen verbreiten.

AI -Chatbots verbreiten falsche Informationen in 1 von 3 Antworten

Related Posts

Recent Posts

Recent Comments

Es sind keine Kommentare vorhanden.