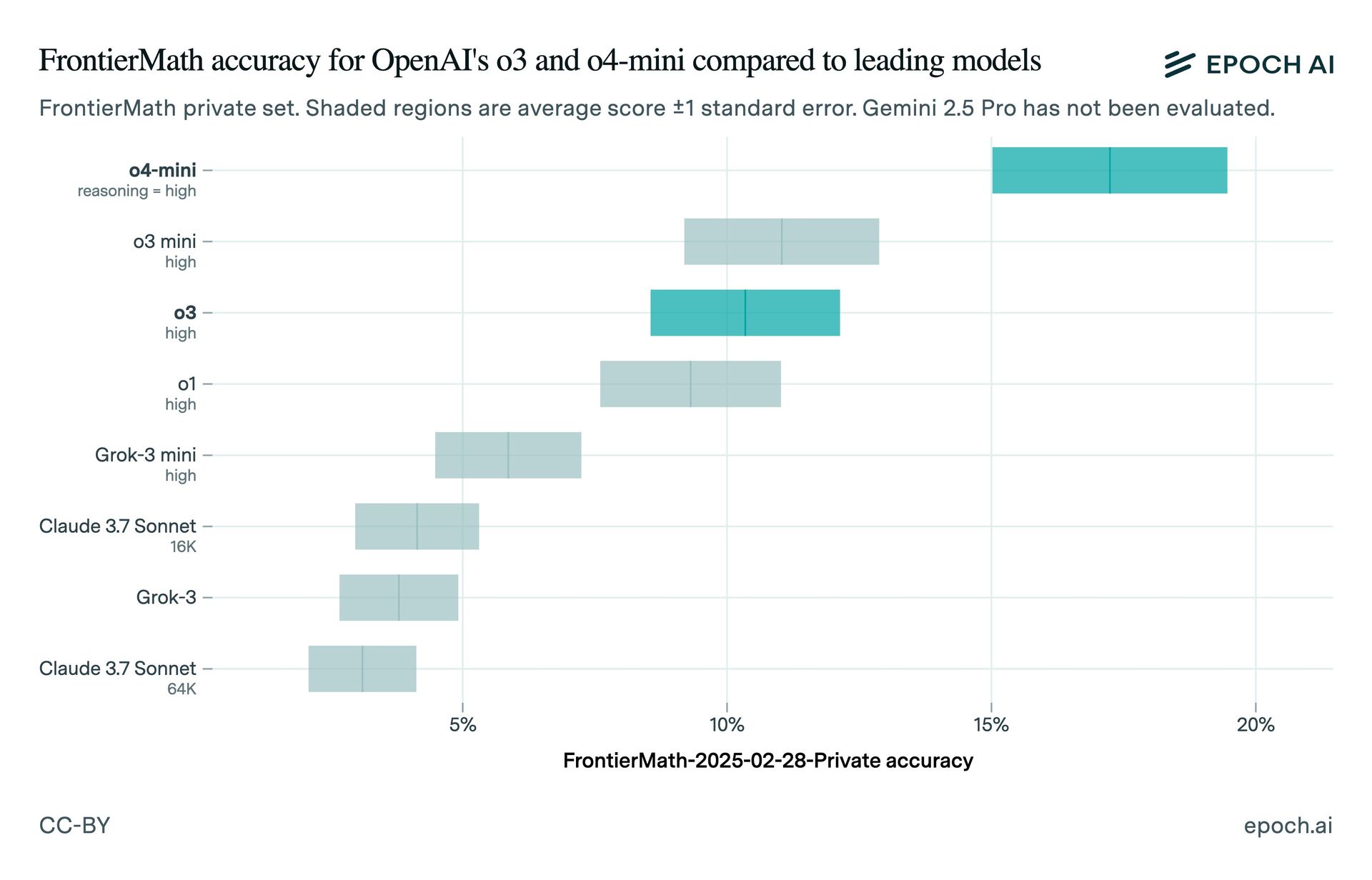

OpenAIs O3 -AI -Modell erzielte laut unabhängigen Tests von den FrontierMath -Benchmark als das Unternehmen, das ursprünglich impliziert war Epoch aidas Forschungsinstitut hinter Frontiermath. Als Openai im Dezember O3 enthüllte, behauptete das Modell, 25% der Frontiermath -Fragen zu beantworten und andere Modelle erheblich zu übertreffen.

Die Tests von Epoch Ai fanden das fest O3 erzielte bei frontiermath rund 10%. Die Diskrepanz kann auf Unterschiede bei den Testaufnahmen oder auf die Version der verwendeten O3 zurückzuführen sein. OpenAs Chief Research Officer, Mark Chen, hatte erklärte das O3 erzielte in „aggressiven Testzeit-Recheneinstellungen“ über 25%. Epoch stellte fest, dass die veröffentlichten Benchmark-Ergebnisse von OpenAI einen Punktzahl mit niedrigerem Gebrauch zeigten, der mit der beobachteten Epoche von 10% entspricht.

Das öffentliche O3-Modell ist „eingestellt für Chat/Produktgebrauch“ und verfügt laut der ARC-Prize-Stiftung, die eine Pre-Release-Version von O3 getestet hat. Openais Wenda Zhou erklärt Dass das Produktions-O3-Modell „für Anwendungsfälle in realer Welt“ optimiert ist, was zu Maßstäben führen kann.

Openai’s O3-Mini-High- und O4-Mini-Modelle übertreffen O3 auf Frontiermath. Das Unternehmen plant, in den kommenden Wochen eine leistungsstarke O3-Variante O3-Pro zu veröffentlichen. Dieser Vorfall unterstreicht die Notwendigkeit von Vorsicht bei der Interpretation von AI -Benchmarks, insbesondere wenn sie zur Förderung von kommerziellen Produkten verwendet werden.

In der KI -Industrie hat in letzter Zeit mehrere Benchmarking -Kontroversen festgestellt. Im Januar wurde Epoch dafür kritisiert XAI wurde beschuldigt, irreführende Benchmark -Diagramme für sein GROK 3 -Modell veröffentlicht zu haben, und Meta gab zu, Benchmark -Scores für eine andere Version eines Modells als das für Entwickler zur Verfügung zu stellen.