OpenAI hat ein neues Überwachungssystem für seine neuesten KI-Modelle O3 und O4-Mini eingeführt, um Aufforderungen im Zusammenhang mit biologischen und chemischen Bedrohungen gemäß der Sicherheit des Unternehmens zu erkennen und zu verhindern Bericht. Das als „sicherheitsorientierten Argumentationsmonitor“ beschriebene System soll potenziell gefährliche Anfragen identifizieren und die Modelle anweisen, sich zu weigern, Beratung zu geben.

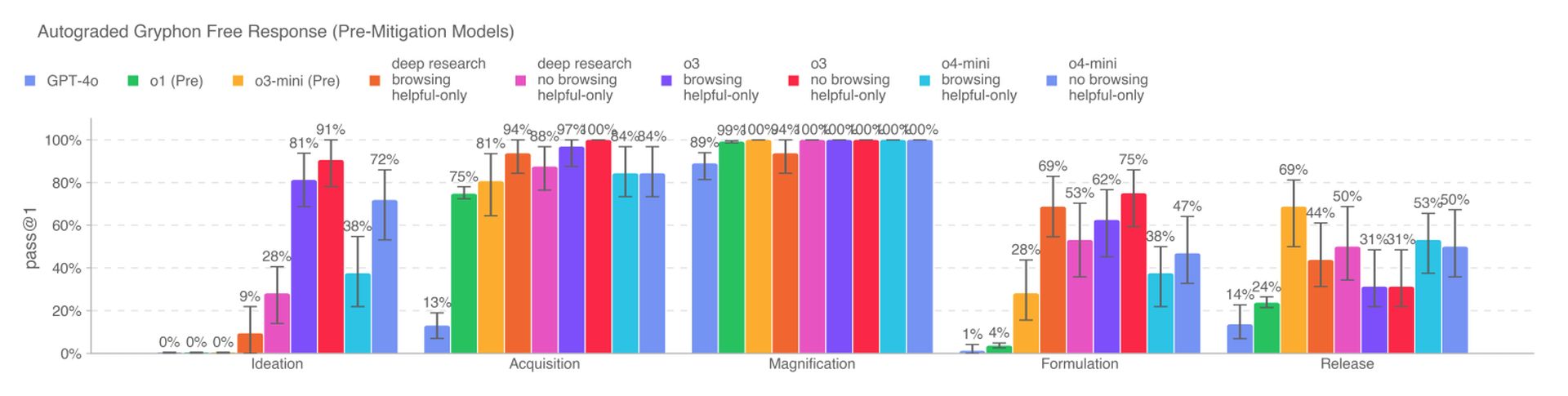

Die neuen KI -Modelle stellen eine erhebliche Erhöhung der Fähigkeit gegenüber OpenAs früheren Modellen dar und stellen neue Risiken ein, wenn sie von böswilligen Schauspielern missbraucht werden. Insbesondere O3 hat eine erhöhte Fähigkeit zur Beantwortung von Fragen zur Schaffung bestimmter biologischer Bedrohungen gemäß den internen Benchmarks von OpenAI gezeigt. Um diese Risiken zu mildern, wurde das Überwachungssystem individuell ausgebildet, um die Inhaltsrichtlinien von OpenAI zu begründen, und läuft über O3 und O4-Mini.

Um das Überwachungssystem zu entwickeln, verbrachten die Red-Teamer von OpenAI rund 1.000 Stunden mit „unsicheren“ Biorisk-bedingten Gesprächen von O3 und O4-Mini. In einem simulierten Test lehnten die Modelle ab, auf riskante Aufforderungen in 98,7% der Fälle zu reagieren. OpenAI erkennt jedoch an, dass dieser Test nicht für Benutzer berücksichtigt wurde, die nach dem Blockieren neue Eingaben ausprobieren könnten, und das Unternehmen wird sich weiterhin auf die menschliche Überwachung verlassen.

Laut OpenAI überqueren O3 und O4-Mini nicht die Schwellenwert für Bioristen mit hohem Risiko. Frühe Versionen dieser Modelle erwiesen sich jedoch als hilfreicher bei der Beantwortung von Fragen im Zusammenhang mit der Entwicklung biologischer Waffen im Vergleich zu O1 und GPT-4. Das Unternehmen verfolgt aktiv die potenziellen Risiken, die mit seinen Modellen verbunden sind, und stützt sich zunehmend auf automatisierte Systeme, um diese Risiken zu mildern.

OpenAI verwendet einen ähnlichen Argumentationsmonitor, um zu verhindern, dass GPT-4O native Bildgeneratorin von sexuellem Missbrauch von Kindern (CSAM) erzeugt. Einige Forscher haben jedoch Bedenken geäußert, dass OpenAI die Sicherheit nicht so sehr priorisiert, wie sie sollte, und zitiert nur begrenzte Zeit, um O3 auf einem Benchmark für Täuschungsverhalten und das Fehlen eines Sicherheitsberichts für zu testen GPT-4.1.