Die Bytedance-Saatgutforscher haben die Wertvergrößerung der proximalen Politikoptimierung (VAPO) eingeführt, ein Rahmen für das Verstärkungslerntraining, das die Begründung der großen Sprachmodelle auf komplexe, lange Aufgaben schärft und neue Ergebnisse des Stand der Technik auf dem Aime24-Benchmark erzielte.

Trainings-LLMs für kompliziertes Denken unter Verwendung wertbasierter Verstärkungslernen hatten zuvor erhebliche Hürden. Methoden kämpften mit Wertmodellverzerrungen, passen sich effektiv an Antwortsequenzen von sehr unterschiedlichen Längen an und verwalten spärliche Belohnungssignale, insbesondere in auf nach auf Verifier basierenden Aufgaben, die nur binäre Feedback liefern.

VAPO befasst sich mit diesen Herausforderungen mit drei Kerninnovationen: einem detaillierten wertorientierten Trainingsrahmen, einem Länge-adaptiven Mechanismus (Länge-adaptiver generalisierter Vorteilsschätzung), der Parameter anpasst, basierend auf der Antwortlänge und der systematischen Integration von Techniken aus früheren Forschungen.

Diese Kombination schafft ein System, in dem Verbesserungen synergistisch funktionieren. Unter Verwendung des QWEN2.5-32B-Modells ohne spezifische SFT-Daten verbesserte VAPO die Benchmark-Ergebnisse von 5 auf 60 und übertrafen frühere Methoden des Stand der Technik um 10 Punkte.

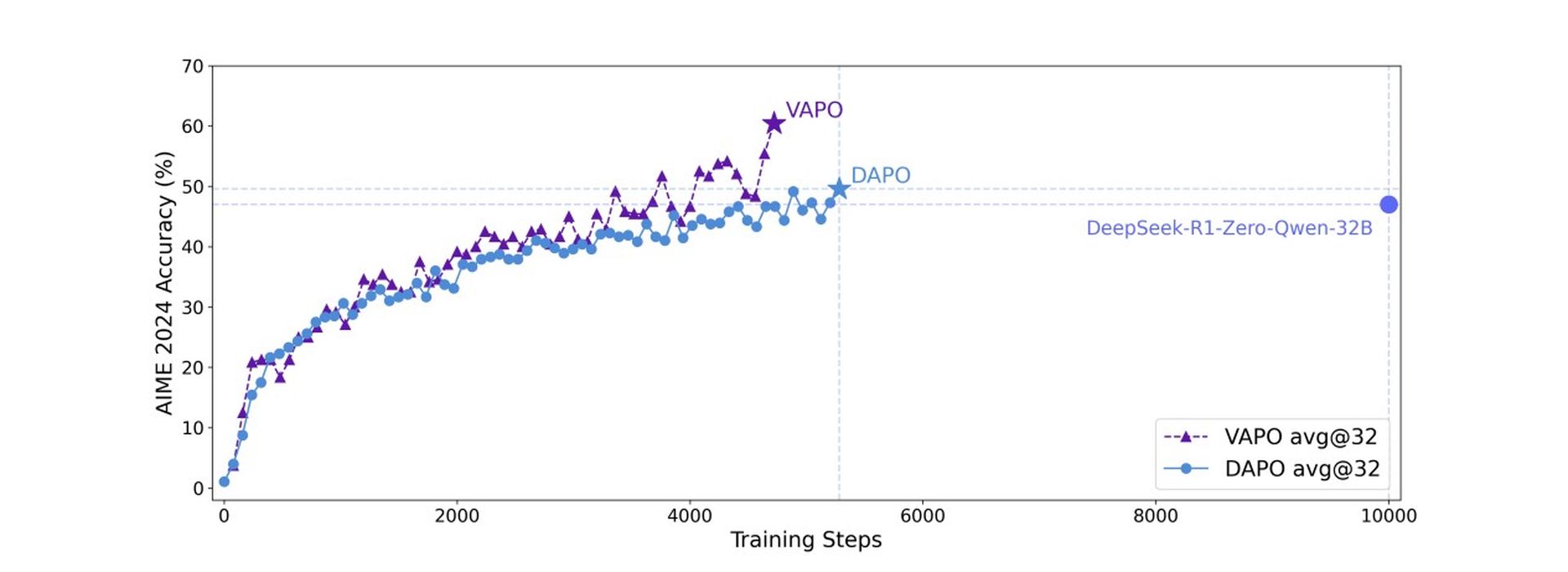

VAPO baut auf dem PPO -Algorithmus (Proximal Policy Optimization) auf, enthält jedoch wichtige Modifikationen zur Verbesserung der mathematischen Argumentation. Die Trainingsanalyse ergab, dass VAPO im Vergleich zur wertfreien DAPO-Methode glattere Trainingskurven aufweist, was auf eine stabilere Optimierung hinweist.

VAPO zeigte auch eine bessere Längeskalierung für eine verbesserte Verallgemeinerung, ein schnelleres Score -Wachstum, das auf die körnigen Signale aus seinem Wertmodell zurückzuführen ist, und eine geringere Entropie in späteren Trainingsphasen. Während eine verringerte Entropie möglicherweise die Erforschung einschränken kann, gleicht die Methode dies effektiv aus und verbessert die Reproduzierbarkeit und Stabilität mit minimalen Leistungsauswirkungen.

Auf der Aime24 -Benchmark erreichte Deepseek R1 mit Grpo 47 Punkte, und Dapo erreichte 50 Punkte. VAPO stimmte mit dem QWEN-32B-Modell mit nur 60% der Aktualisierungsschritte die Leistung von DAPO zu und legte innerhalb von 5.000 Schritten eine neue hochmoderne Punktzahl von 60,4. Im Gegensatz dazu erzielte Vanilla PPO nur 5 Punkte aufgrund des Einsturzmodelllernens.

Dieser Benchmark fragt, ob KI wie ein Ingenieur denken kann

Ablationsstudien bestätigten die Wirksamkeit von sieben unterschiedlichen Modifikationen innerhalb von VAPO. Wertvorlagen verhindert das Modell Zusammenbruch; Entkoppelte GAE ermöglicht die volle Optimierung langer Antworten. Die adaptive GAE balanciert die Optimierung der kurzen und langen Reaktion; Clip-High fördert eine gründliche Erkundung; Der Verlust auf Token-Ebene erhöht die Gewichtung für lange Reaktionen; Durch die Einbeziehung des LM-Verlusts mit positivem Beispiel wurden 6 Punkte hinzugefügt; und Gruppenabtastung trug 5 Punkte zum Endergebnis bei.

Forscher Highlight Das VAPO unter Verwendung des QWEN2.5-32B-Modells zeigt, dass dieser wertbasierte Ansatz wertfreie Methoden wie GRPO und DAPO entscheidend übertreffen kann, was ein neues Leistungsniveau für komplexe Argumentationsaufgaben festlegt und grundlegende Herausforderungen bei den Trainingswertmodellen für Langketten-von -dacht-Szenarien anbietet.