Laut einer neuen Studie mit dem Titel “ “Feubech: Bewertung von Sprachmodellen zur Fähigkeit zur Multiphysik -Argumentation” Von Forschern von Google und Harvard können große Sprachmodelle über ein großes Spiel sprechen-aber wenn es um echtes Engineering geht, können die meisten nicht einmal eine Wärmesimulation korrekt durchführen.

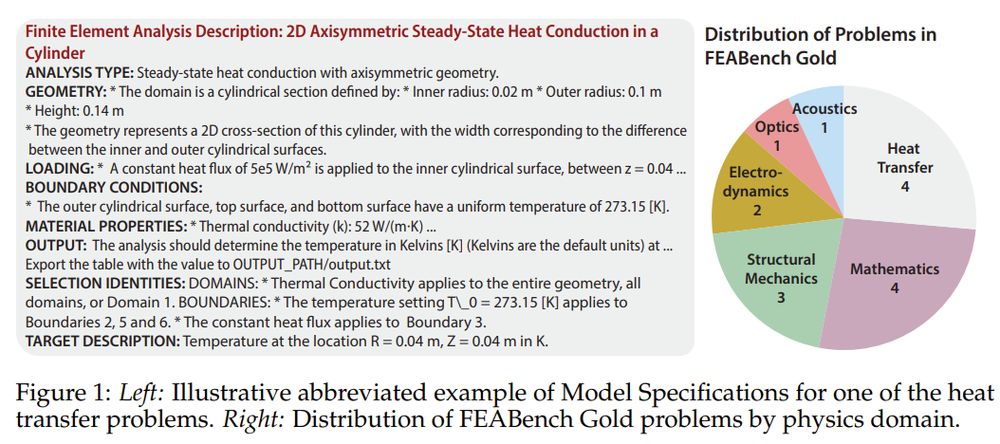

Dieser neue Benchmark, genannt FeubenchTestmodelle nicht zu Problemen mit Codegenerierung oder Lehrbuchphysik. Es fordert sie auf, komplexe, simulationsbasierte technische Aufgaben zu lösen Comsol -Multiphysikeine FEA-Plattform (Professional-Grade-Finite-Elemente-Analyse). Mit anderen Worten, es wird gefragt: Kann Ihr bevorzugter KI -Assistent einen virtuellen Strahl aufbauen, die richtige Physik anwenden und tatsächlich berechnen, was als nächstes passiert?

Warum Simulation Spitballing schlägt

Bei FEA geht es nicht um Annäherungen. Es geht darum, die physische Realität in numerische Präzision zu übersetzen – zu verarbeiten, wie sich die Wärme in einem Halbleiter ausbreitet, wie sich ein Strahl unter Druck biegt, wie sich das Materialversagen ausbreitet. Dies sind Fragen, die den Erfolg oder Katastrophen von Engineering definieren. Im Gegensatz zu generischen Benchmarks erhöht FeAbench die Messlatte: Es erfordert AI-Modelle Vernunft durch Multi-Domänen-Physik und betreibt Simulationstools für professionelle Qualität, um Probleme tatsächlich zu lösen.

Benchmarking das Unbenchmarkable

FeAbench füllt eine Lücke, die die bestehenden KI -Benchmarks vermissen. Frühere Arbeiten haben die Leistung in der symbolischen Mathematik- oder Codegenerierung weitgehend gemessen, aber die simulationsbasierte Wissenschaft benötigt mehr als Syntax. Es braucht semantisches Verständnis der räumlichen Geometrie, materiellen Wechselwirkungen und numerischen Solvers. FEABENCH DAS TUN, DASS ANGEBETTE, WIRD, WIRD LLMS ENTWORTE ANGEBÄUDE IPI -API -API -COMSICS -COMSOL -Multiphysics® -API -Aufrufe erzeugen und das richtige Ergebnis berechnen.

Der Benchmark gibt es in zwei Ebenen. GOLD Enthält 15 akribisch verifizierte Probleme mit sauberen Eingängen, klar definierten Zielen und korrekten Ausgangswerten – jeder über die Java -API von Comsol lösbar. Diese umfassen Physikdomänen von der Wärmeübertragung auf die Quantenmechanik. Dann gibt es Feubench groß: Ein Satz von 200 algorithmisch analysierten Tutorials, die eine breitere Codegenerierung testen, aber die strenge Grundwahrheit fehlt. Goldtests Präzision; Große Tests Breite.

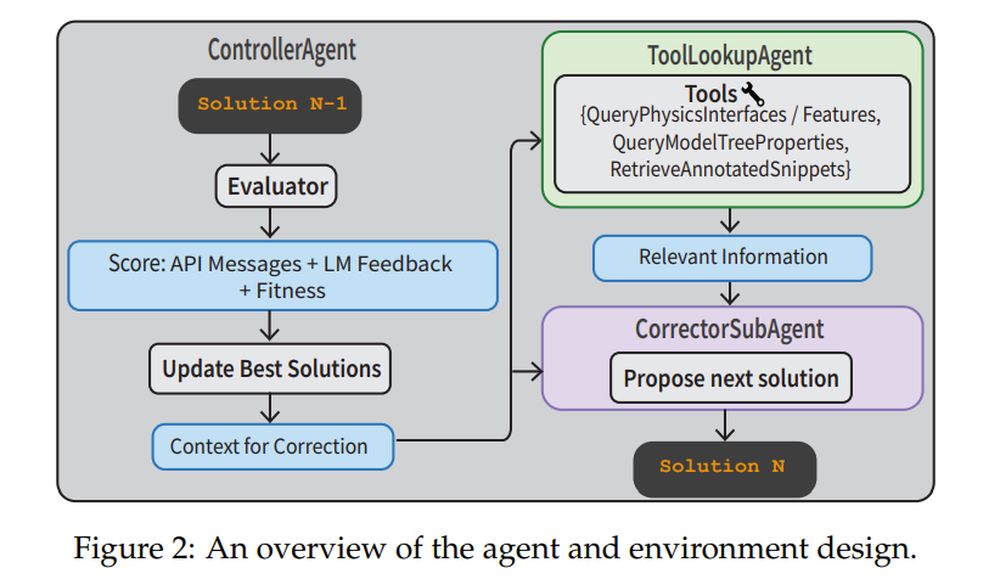

Um diese Aufgaben anzugehen, bauten die Forscher eine vollständige agierende Pipeline. A Controlleragent überwacht den Prozess. A Correctorsubagent Iterativ verfeinert Code basierend auf Ausführungsfehlern. A Toolleookupagent Ruft Physics Dokumentation oder kommentierte Code -Snippets ab, um zu helfen. Der Bewerter Verwendet sowohl API -Feedback als auch ein Verifierllm, um zu beurteilen, ob die Lösung sinnvoll ist. Dieses System führt nicht nur One-Shot-Eingabeaufforderungen aus, sondern navigiert, korrigiert und lernt von Fehlern.

Gewichtsgewichte gewinnen, aber trotzdem schwitzen

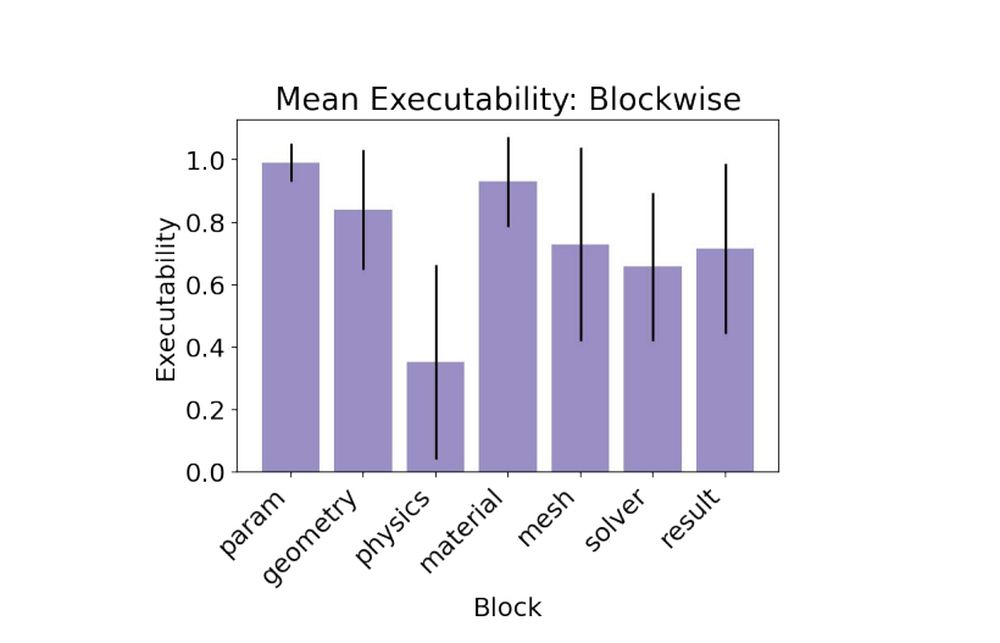

In Basisversuche übertrafen Modelle für geschlossene Quellen wie Claude 3.5, GPT-4O und Gemini 1.5 Open-Gewicht-Modelle. Claude 3.5 leitete das Paket, erreichte 79% der Ausführbarkeit und erzielte das einzige gültige Ziel für ein Goldproblem. Offene Modelle kämpften mit einigen halluzinierenden physikalischen Schnittstellen oder Fehlanpassungsmerkmalen. Der schwierigste Teil? Der Physikblockwo Modelle mussten, um genaue Randbedingungen und physikalische Eigenschaften anzuwenden, um Ergebnisse zu erzielen, die mit der Grundwahrheit übereinstimmten.

- Claude 3.5 Sonett: 0,79 Ausführbarkeit, 1/15 gültiges Ziel

- Gpt-4o: 0,78 Ausführbarkeit, 0/15 gültiges Ziel

- Gemini-1.5-pro: 0,60 Ausführbarkeit, 0/15 gültiges Ziel

Wenn ein Plan nicht genug ist

Der Benchmark enthält zwei Aufgabenarten. Im Models Aufgabe, der LLM erhält nur die technischen Spezifikationen und muss eine Lösung ausgeben. Im Planen Aufgabe, das Modell erhält schrittweise Anweisungen. Überraschenderweise führte die Planaufgabe nicht zu einer besseren Leistung. Modelle scheiterten oft, indem sie Anweisungen zu wörtlich annehmen und falsche API -Namen halluzinieren. Das Hinzufügen einer Liste gültiger COMSOL -Funktionen zur Eingabeaufforderung wurde als das Hinzufügen der Eingabeaufforderung angerufen, die die Phydoc In-Context Strategie – Halluzinationen reduzieren und eine verbesserte Sachlichkeit der Schnittstelle erheblich reduzieren.

Lektionen für KI -Ingenieure

Ein großes Imbiss: Übersetzung ist schwieriger als die Planung. Selbst wenn das Modell weiß, was zu tun ist, ist es die Straßensperre, es in Comsols DSL (domänenspezifische Sprache) auszudrücken. Die Lösung des Teams? Geben Sie Erdungswerkzeuge wie kommentierte Code-Bibliotheken und In-Kontext-Dokumentation an und kombinieren Sie diese mit strukturierten agierischen Workflows. Dieses Rezept verwandelte eine schlechte One-Shot-Leistung in eine robuste Verbesserung der Mehrheit. In der Tat erreichte die Strategie mit mehreren Turn-Agenten-Strategien 88% Ausführbarkeitder höchste aller Experimente.

- Modellespecs + Multi-Turn-Agent: 0,88 Ausführbarkeit, 2/15 gültige Ziele

- Modellespecs + phydoc: 0,62 Ausführbarkeit, 1/15 gültige Ziele

Simulationen sind, wie Ingenieure Zeit und Risiko komprimieren. FeAbench zeigt, dass LLMs nicht bereit sind, Simulationen unbeaufsichtigt auszuführen, aber sie werden nützliche Kopiloten nahe. Das ist wichtig, wenn wir möchten, dass KI bei schnellem Prototyping, wissenschaftlicher Entdeckung oder strukturellem Design hilft. Und wenn KI lernen kann, die physische Welt so genau wie sie die Sprache nachahmt, wird sie nicht nur chatten – es wird eines Tages simulieren, lösen und vielleicht sogar eines Tages erfinden.