Meta hat offiziell angekündigt Die fortschrittlichste Suite künstlicher Intelligenzmodelle bis heute: die Lama 4 -Familie. Diese neue Generation umfasst Lama 4 Scout und Llama 4 Maverick, die erste Open-Gewichts-Modelle von Meta, die native Multimodalität und beispiellose Unterstützung bei der Kontextlänge anbieten. Diese Modelle markieren auch den anfänglichen Aufstieg von Meta in die Verwendung einer Mischung aus Experten (MOE). META bot auch eine Vorschau von LLAMA 4 Gigantoth, einem hoch intelligenten LLM, das derzeit trainiert hat und als Lehrer für zukünftige Modelle dient.

Dieses bedeutende Update des Lama -Ökosystems kommt ungefähr ein Jahr nach der Veröffentlichung von Lama 3 im Jahr 2024unterstreicht das Engagement von Meta, Innovationen im KI -Raum zu eröffnen. Laut Meta ist es entscheidend, die Entwicklung personalisierter Erfahrungen zu fördern.

Scout und Maverick: Multimodale Modelle mit innovativer Architektur

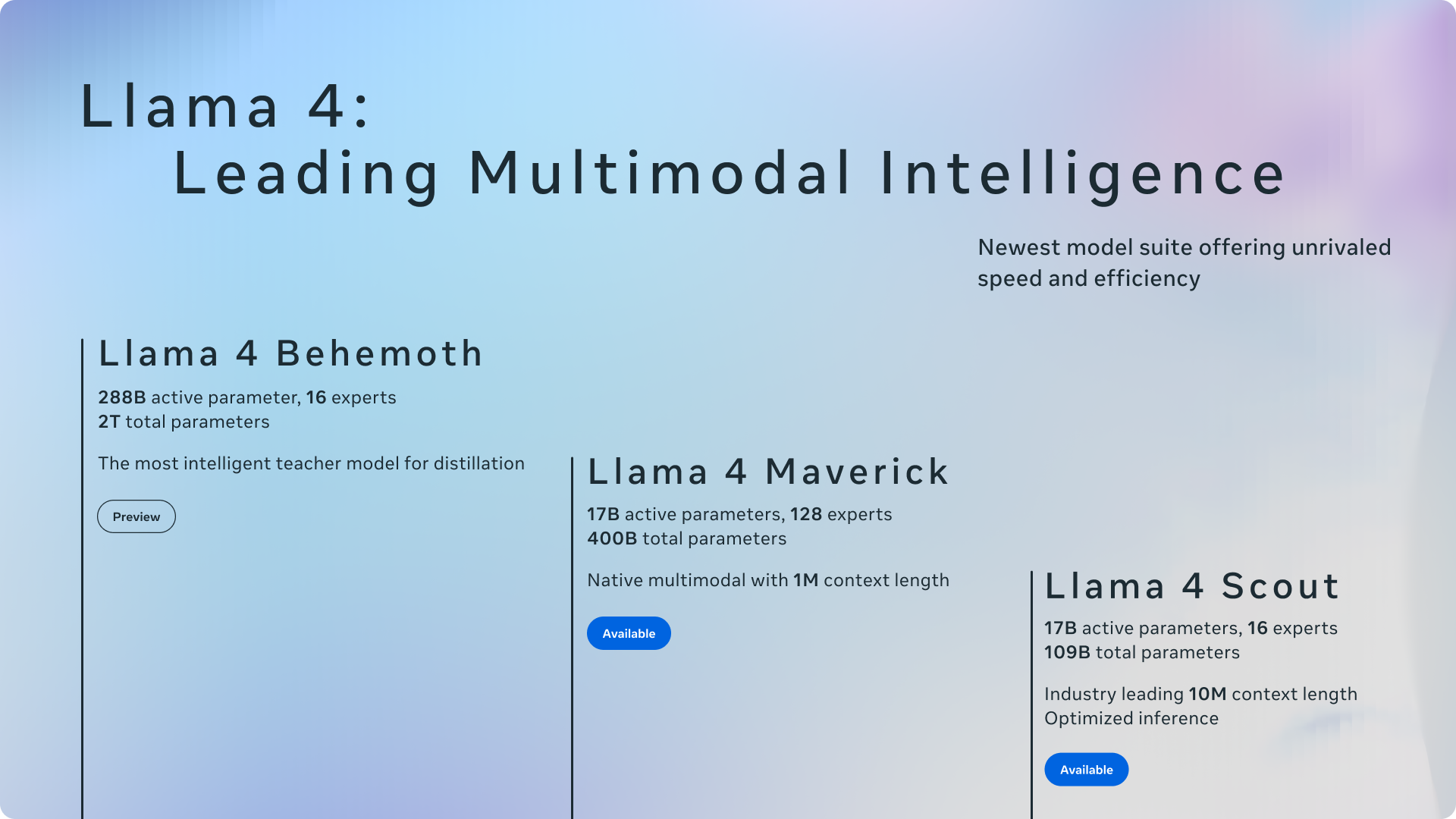

Lama 4 Scout und Lama 4 Maverick sind die ersten effizienten Modelle in dieser Serie. LLAMA 4 Scout verfügt über 17 Milliarden aktive Parameter in 16 Experten, während LLAMA 4 Maverick auch 17 Milliarden aktive Parameter verfügt, nutzt jedoch einen größeren Pool von 128 Experten in seiner MOE -Architektur. Meta zeigt die Effizienz dieses Designs und stellt fest, dass Lama 4 Scout auf eine einzelne H100 -GPU (mit INT4 -Quantisierung) und Lama 4 -Maverick zu einem einzigen H100 -Host passen kann, wodurch die Bereitstellung erleichtert wird.

Die Einführung einer Architektur der Experten (Experten) ist ein wesentlicher Fortschritt. In MOE-Modellen werden für jedes Token nur ein Bruchteil der Gesamtparameter aktiviert, was zu einer stärkeren Recheneffizienten und Folgerungen führt, was letztendlich eine höhere Qualität für ein bestimmtes Rechenbudget bietet. Zum Beispiel hat LLAMA 4 Maverick 400 Milliarden Gesamtparameter, aber nur 17 Milliarden sind während der Verwendung aktiv.

Sowohl Lama 4 Scout als auch Lama 4 Maverick sind nativ multimodal und beinhalten eine frühzeitige Verschmelzung, um Text- und Vision -Token in einem einheitlichen Modell Rückgrat nahtlos zu verarbeiten. Dies ermöglicht gemeinsame Voraussetzungen für enorme Mengen unbeschriebener Text-, Bild- und Videodaten. Meta hat auch den Visionscodierer in Lama 4 verbessert und auf Metaclip aufgebaut, aber es separat neben einem gefrorenen Lama -Modell für eine bessere Anpassung ausgebildet.

LAMA 4 Gigant: Ein Lehrermodell mit vielversprechenden Benchmarks

Meta gab einen Einblick in das Lama 4-Gigant, ein Lehrermodell mit erstaunlichen 288 Milliarden aktiven Parametern und fast zwei Billionen Gesamtparametern in 16 Experten. Meta behauptet, dass Behemoth führende Modelle wie GPT-4,5, Claude Sonnet 3.7 und übertrifft Gemini 2.0 Pro Auf STEM-Fokus-Benchmarks wie Math-500 und GPQA Diamond. Während das Lama 4 -Gigant noch im Training ist und noch nicht verfügbar ist, spielte es eine entscheidende Rolle bei der „Codestillation“ des Lama 4 -Maverick -Modells, was zu erheblichen Qualitätsverbesserungen führte.

Kontextlänge und mehrsprachige Fähigkeiten

Ein herausragendes Merkmal der Lama 4 -Modelle ist ihre deutlich erhöhte Kontextlänge. Lama 4 Scout führt die Branche mit einem 10 -Millionen -Token -Input -Kontextfenster an, was einem dramatischen Anstieg gegenüber 128.000 von Lama 3 ist. Dieser erweiterte Kontext ermöglicht erweiterte Funktionen wie Multi-Dokument-Zusammenfassung und Argumentation über große Codebasen. Beide Modelle wurden auf einem massiven Datensatz von mehr als 30 Billionen Token, mehr als doppelt so hoch wie bei Lama 3, vorgebracht und umfassten über 200 Sprachen, wobei über 100 Sprachen jeweils mehr als 1 Milliarde Token hatten.

Integration in Meta -Apps und Entwicklerverfügbarkeit

Das Engagement von Meta für Open Innovation, Lama 4 Scout und Lama 4 Maverick können heute auf llama.com und umarmendem Gesicht heruntergeladen werden. Meta kündigte außerdem an, dass diese Modelle jetzt Meta AI in beliebten Anwendungen wie WhatsApp, Messenger, Instagram Direct und auf der Meta.ai -Website anführen. Mit dieser Integration können Benutzer die Funktionen der neuen Lama 4 -Modelle direkt erleben.

Meta betonte sein Engagement für die Entwicklung hilfreicher und sicherer KI -Modelle. LLAMA 4 beinhaltet Best Practices, die in ihrem KI -Schutzleitfaden für den Schutz der Entwickler von KI beschrieben wurden, einschließlich Minderungen in verschiedenen Entwicklungsstadien. Sie haben auch Open-Sourcing-Schutzmaßnahmen wie Lama Guard und forculiertes Wachmann hervorgehoben, um Entwicklern zu helfen, schädliche Eingaben und Ausgaben zu identifizieren und zu verhindern.

In Bezug auf das bekannte Problem der Voreingenommenheit in LLMs stellte Meta fest, dass in LLAMA 4 erhebliche Verbesserungen vorgenommen wurden. Das Modell lehnt weniger Aufforderungen zu diskutierten politischen und sozialen Themen ab und zeigt eine ausgewogenere Reaktion über verschiedene Gesichtspunkte hinweg, wobei die Leistung in diesem Bereich vergleichbar ist.