Microsoft Corp. hat erweitert Seine Phi-Linie von Open-Source-Sprachmodellen mit der Einführung von zwei neuen Algorithmen, die für die multimodale Verarbeitung und Hardwareeffizienz entwickelt wurden: PHI-4-Mini und PHI-4-Multimodal.

PHI-4-Mini- und PHI-4-Multimodal-Merkmale

PHI-4-Mini ist ein Nur-Text-Modell, das 3,8 Milliarden Parameter umfasst, sodass es auf mobilen Geräten effizient ausgeführt werden kann. Es basiert auf einer nur Decoder-Transformatorarchitektur, die nur den Text vor einem Wort analysiert, um seine Bedeutung zu bestimmen und so die Verarbeitungsgeschwindigkeit zu verbessern und die Hardwareanforderungen zu verringern. Darüber hinaus verwendet Phi-4-Mini eine Leistungsoptimierungstechnik, die als gruppierte Aufmerksamkeit der Abfrage (GQA) bezeichnet wird, um die mit seinem Aufmerksamkeitsmechanismus verbundene Hardwareverwendung zu verringern.

Microsoft PHI-4 AI befasst sich mit komplexen Mathematik mit 14B-Parametern

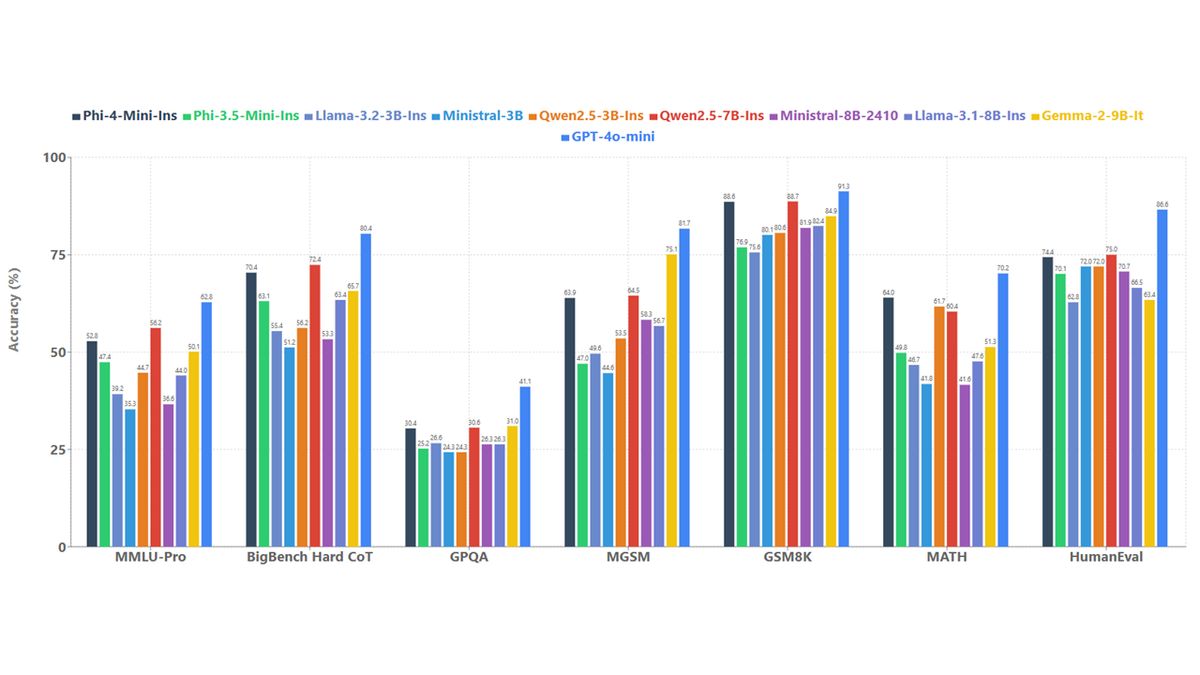

Dieses Modell ist in der Lage, Text zu generieren, Dokumente zu übersetzen und Aktionen in externen Anwendungen auszuführen. Microsoft behauptet, dass PHI-4-Mini in Aufgaben, die komplexe Argumentation erfordern, wie mathematische Berechnungen und Codierungsherausforderungen erfordern und die Genauigkeit bei internen Benchmark-Tests im Vergleich zu anderen ähnlich großen Sprachmodellen erheblich verbessert haben.

Das zweite Modell, phi-4-multimodal, ist eine verbesserte Version von Phi-4-Mini mit 5,6 Milliarden Parametern. Es ist in der Lage, Text-, Bilder-, Audio- und Videoeingänge zu verarbeiten. Dieses Modell wurde unter Verwendung einer neuen Technik namens Mischung aus Loras geschult, die die Funktionen des Modells für die multimodale Verarbeitung ohne umfangreiche Änderungen an den vorhandenen Gewichten optimiert.

Microsoft führte Benchmark-Tests auf PHI-4-Multimodal durch, bei denen es eine durchschnittliche Punktzahl von 72 in der visuellen Datenverarbeitung erzielte, die nur auf OpenAIs GPT-4 scheut, was 73 Punkte erzielte. In kombinierten visuellen und Audioaufgaben übertraf die pHI-4-Multimodale Gemini-2,0-Blitz „mit großem Rand“ und übertraf die für die multimodale Verarbeitung spezialisiert.

Sowohl phi-4-multimodal als auch phi-4-mini sind im Rahmen der MIT-Lizenz lizenziert und werden durch verfügbar Umarmtes Gesichtkommerzielle Nutzung zulassen. Entwickler können auf diese Modelle zugreifen Azure AI Foundry Und Nvidia API -Katalog ihr Potenzial weiter untersuchen.

PHI-4-Multimodal ist besonders entwickelt, um natürliche und kontextbezogene Wechselwirkungen zu erleichtern, indem mehrere Eingangstypen in ein einzelnes Verarbeitungsmodell integriert werden. Es umfasst Verbesserungen wie ein größeres Vokabular, mehrsprachige Fähigkeiten und eine verbesserte Recheneffizienz für die Ausführung von On-Device.

PHI-4-Mini liefert eine beeindruckende Leistung in textbasierten Aufgaben, einschließlich der Funktions- und Funktionsfunktionen, mit denen sie effektiv mit strukturierten Programmierschnittstellen interagieren können. Die Plattform unterstützt Sequenzen bis zu 128.000 Token.

Darüber hinaus haben beide Modelle umfassende Sicherheits- und Sicherheitstests durchlaufen, die von Microsofts internem Azure AI Red Team (AIRT) (AIRT) von Microsoft untersucht wurden, das die Modelle anhand umfassender Bewertungsmethoden bewertete, die die aktuellen Trends in Cybersicherheit, Fairness und Benutzersicherheit ansprechen.

Die Anpassung und einfache Bereitstellung sind zusätzliche Vorteile dieser Modelle, da ihre kleineren Größen für bestimmte Aufgaben mit relativ niedrigen Rechenanforderungen fein abgestimmt werden können. Beispiele für Aufgaben, die für die Feinabstimmung geeignet sind, sind Sprachübersetzung und medizinische Beantwortung.

Für weitere Einzelheiten zu den Modellen und ihren Anwendungen werden Entwickler aufgefordert, sich auf die zu beziehen PHI -Kochbuch Erhältlich auf GitHub.

Ausgewähltes Bildnachweis: Microsoft