Große Sprachmodelle (LLMs) werden schlauer, aber sie treffen auch eine Wand: Umgang mit langen Textstücken ist langsam und rechnerisch teuer. Traditionelle Aufmerksamkeitsmechanismen – der Kern der Art und Weise, wie KI Prozesse und Informationen erinnert – hält sich effizient an, um die Modelle für das Training und zu rennen.

Jetzt Forscher von Deepseek-AI und Peking University haben eingeführt Ein bahnbrechender Ansatz rief an Nativ spärliche Aufmerksamkeit (NSA). Diese neue Methode verspricht, KI -Modelle erheblich herzustellen schneller, billiger und effizienterund gleichzeitig die gleiche Argumentationsfähigkeit wie traditionelle Ansätze beibehalten.

Warum AIs Aufmerksamkeitsproblem eine Lösung benötigt

Stellen Sie sich vor, Sie müssen ein Buch lesen, in dem Sie jederzeit jeden Satz im Auge behalten müssen – so wie wie Volle Aufmerksamkeit Mechanismen funktionieren in AI. Sie scannen und speichern Informationen über lange Sequenzen hinweg, aber wenn die Kontextlänge wächst (denken Sie Tausende von Wörtern), wird dieser Ansatz unglaublich langsam und rechenintensiv.

Um dies anzugehen, haben Forscher untersucht Spärliche Aufmerksamkeit– was selektiv nur die wichtigsten Informationen anstelle von allem verarbeitet. Bestehende spärliche Methoden haben jedoch Große Schwächen:

- Sie sind schwer von Grund auf neu zu trainierenOft fordern Modelle, zuerst mit voller Aufmerksamkeit zu lernen, bevor sie zu einem spärlichen Ansatz umsteigen.

- Sie optimieren nicht vollständig für moderne Hardwarewas bedeutet, dass theoretische Geschwindigkeitsverbesserungen nicht immer zu einer realen Effizienz führen.

Wie die NSA das Spiel verändert

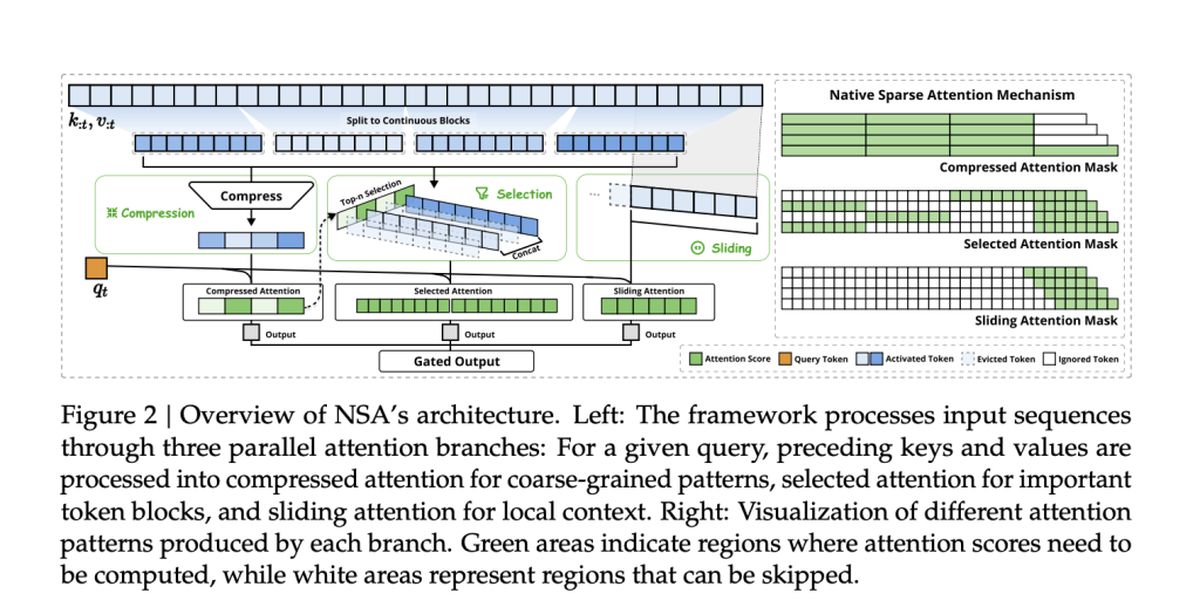

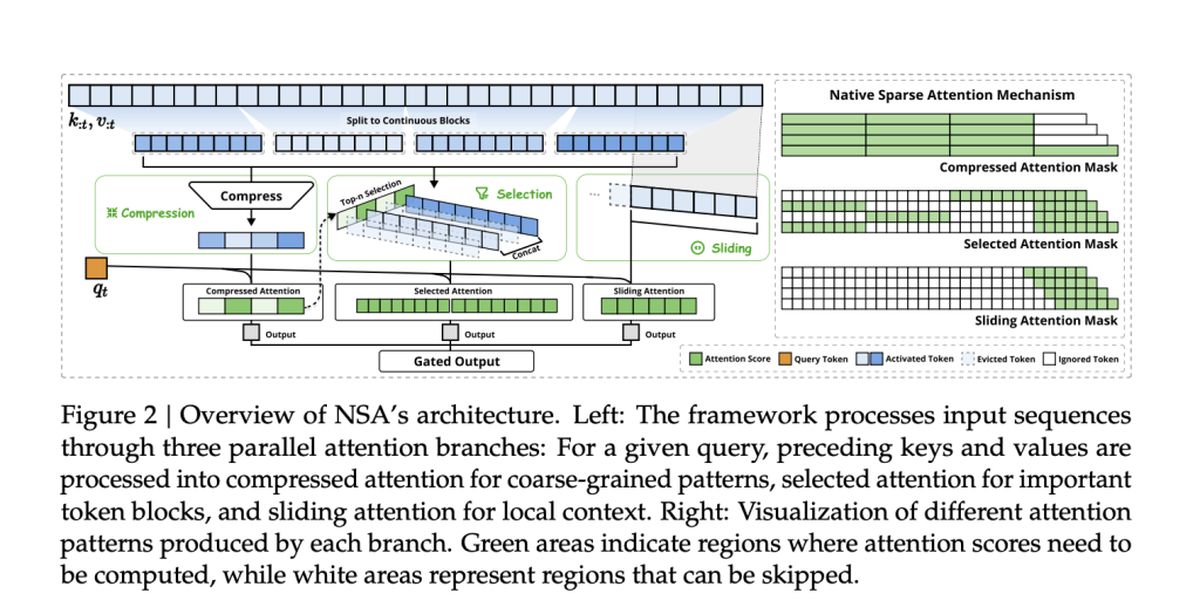

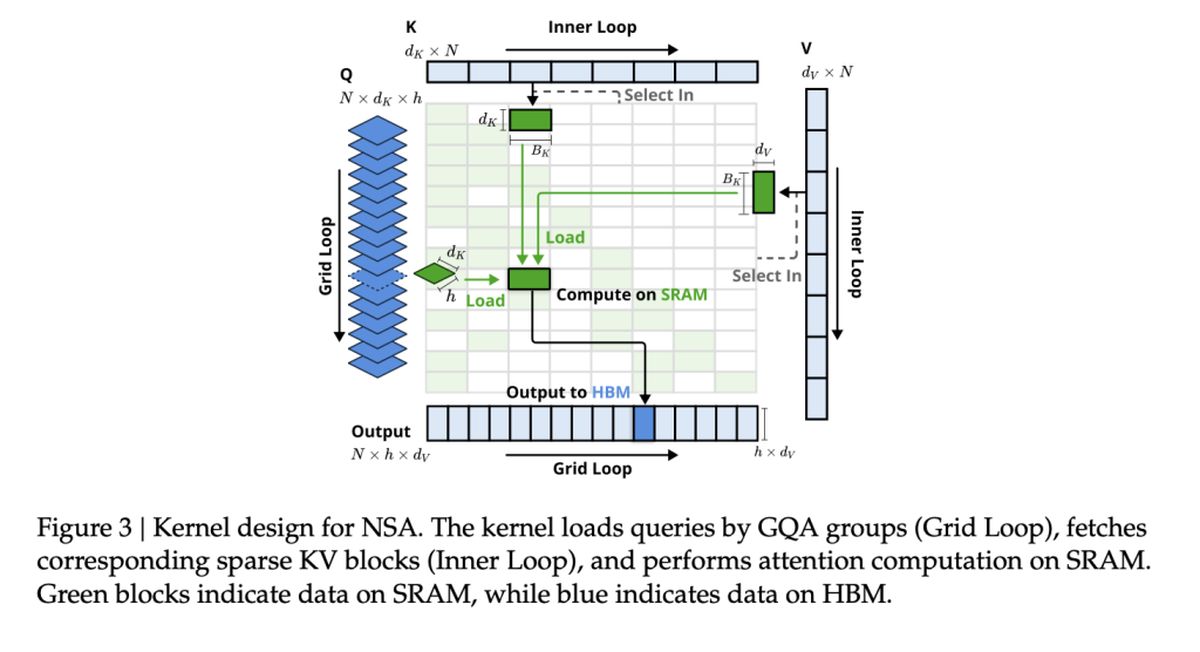

Das Team hinter NSA, darunter Jingyang Yuan, Huazuo Gao, Damai Dai und ihre Kollegen, war neu angewendet. Ihre Methode integriert sparsam von Anfang an die Sparsityanstatt es als nachträglichen Gedanke anzuwenden.

NSA erreicht dies mit zwei wichtige Innovationen:

- Hardware-ausgerichtete Effizienz: Die NSA wurde entwickelt, um die GPU-Leistung zu maximieren, Speicher Engpässe zu vermeiden und reale Beschleunigungen zu gewährleisten.

- End-to-End-Training: Im Gegensatz zu früheren spärlichen Methoden ist die NSA von Grund auf neu trainierbar und senkt die Trainingskosten, ohne die Genauigkeit zu verlieren.

Geschwindigkeit und Genauigkeit: der NSA -Vorteil

Wie stapelt sich NSA gegen traditionelle volle Aufmerksamkeitsmodelle? Laut der Studie, NSA erzielt bis zu 11 × Geschwindigkeitsverbesserungen während immer noch die Aufmerksamkeit auf wichtige Benchmarks übereinstimmt – oder sogar übertrifft.

Einige der größten Siege sind:

- Schnellere Verarbeitung: Die NSA beschleunigt die Fähigkeit von AI, lange Dokumente, Codebasen und Mehrkreisgespräche zu verarbeiten.

- Besseres Denken: Obwohl NSA -Modelle „spärlich“ sind, übereinstimmen oder übertreffen Vollständige Aufmerksamkeitsmodelle bei Aufgaben der Kette der Gedanken.

- Niedrigere Kosten: Durch die Reduzierung der Berechnung ohne Ausfall der Leistung könnte die NSA die fortgeschrittene KI erschwinglicher machen, um zu trainieren und einzusetzen.

Bestehende spärliche Aufmerksamkeitsmethoden

Viele bestehende spärliche Aufmerksamkeitsmechanismen versuchen, den Rechenaufwand durch zu reduzieren Selektiv Beschneiden von Token oder Optimierung des Speicherzugriffs. In der praktischen Implementierung werden sie jedoch häufig ausgeschlossen, entweder weil sie nicht trainbare Komponenten einführen oder sich nicht mit modernen GPU-Architekturen auszurichten.

Zum Beispiel:

- Clusterkv und MagicPig Verlassen Sie sich auf diskrete Clustering- oder Hashing -Techniken, die den Gradientenfluss stören und das Modelltraining behindern.

- H2O und Minferenz Wenden Sie Sparsity nur in bestimmten Inferenzstadien an und begrenzen die Geschwindigkeitsverbesserungen über die gesamte Pipeline hinweg.

- Quest und invlm Verwenden Sie blockweise Auswahlmethoden, aber ihre heuristische Bewertung führt häufig zu niedrigeren Rückrufraten.

NSA befasst sich mit diesen Einschränkungen, indem Sie die Sparsity nativ integrieren– Verringerung der Effizienz sowohl im Training als auch bei der Inferenz, während die Modellgenauigkeit aufbewahrt wird. Das heisst Keine Post-hoc-Näherungen oder Kompromisse zwischen Geschwindigkeits- und Argumentationsfähigkeit.

Die Leistung der NSA bei realen Aufgaben

Um die Effektivität der NSA zu validieren, testeten die Forscher sie über eine Reihe von KI-Aufgaben hinweg und verglichen ihre Leistung mit herkömmlichen Aufmerksamkeitsmodellen und hochmodernen Aufmerksamkeitsmethoden. Die Ergebnisse unterstreichen die Fähigkeit der NSA dazu Passen Sie die vollen Aufmerksamkeitsmodelle an oder übertreffen gleichzeitig die Rechenkosten erheblich.

Allgemeine Benchmark -Leistung

NSA demonstriert Starke Genauigkeit über Wissen, Argumentation und Kodierung von Benchmarkseinschließlich:

- MMLU & CMMLU: Übereinstimmung der vollen Aufmerksamkeit in wissensbasierten Aufgaben

- GSM8K & Math: Outperformance der vollen Aufmerksamkeit im komplexen Denken

- Humanerover & MBPP: Liefern Sie solide Codierungsleistung

Langkontextverständnis

NSA Excels bei der Umstellung von Langkontextsequenzen in Benchmarks wie Longbench. In Aufgaben, die ein tiefes kontextbezogenes Gedächtnis erfordern, behauptete NSA:

- Hoher Rückruf bei Abrufaufgaben (Nadel-in-a-Haystack, Dokument QA)

- Stabile Genauigkeit in Multi-Hop-Argumentation (HPQ, 2WIKI, GOVRPT)

Geschwindigkeitsgewinne der realen Welt

Die Hardware-ausgerichteten Optimierungen in NSA führten zu:

- 9 × schnellere Inferenzgeschwindigkeiten für 64k-Länge Sequenzen

- 6 × schnellere Trainingseffizienz Im Vergleich zu vollständigen Aufmerksamkeitsmodellen

- Reduzierter Speicherbandbreitenverbrauch reduziertum groß angelegte KI-Anwendungen zu machen, praktikabler