Die künstliche Intelligenz wird in drei Dimensionen besser, die Welt besser zu verstehen, aber eine neue Studie legt nahe, dass viele 3D -Benchmarks mit großer Sprachmodell (LLM). Stattdessen werden diese Bewertungen möglicherweise zum Opfer dessen, was Forscher als „2D-Schummeln“ -Problem bezeichnen-wobei KI-Modelle, die hauptsächlich auf 2D-Bildern trainiert wurden, dedizierte 3D-Modelle übertreffen können, indem Punktwolken einfach in Bilder gerendert werden.

Ein Team der Shanghai Jiao Tong University, einschließlich Jihe Jin, Yanheng HE und Mingyan Yang, hat in ihrer Studie festgestellt: “Wiederholen Sie die 3D -LLM -Benchmarks: Testen wir wirklich 3D -Funktionen? “, dass viele Aufgaben zur Bewertung von 3D-KI genauso einfach durch Sehvermögensmodelle (VLMs) gelöst werden können-AII-Systeme, die hauptsächlich auf 2D-Bildern und -text trainiert werden. Dies wirft eine entscheidende Frage auf: Messen aktuelle Benchmarks das 3D -Verständnis wirklich oder testen sie nur, wie gut KI 2D -Renderings von 3D -Daten verarbeiten kann?

2D-Schicken: Die Verknüpfung, die schwache Benchmarks enthüllt

Das Problem beruht auf der Bewertung von 3D -LLMs. Viele bestehende Benchmarks verlassen sich auf Q & A und Bildunterschriftenaufgabenwo eine KI gebeten wird, ein 3D -Objekt zu beschreiben oder Fragen dazu zu beantworten. Die Annahme ist, dass a 3D-ausgebildete AI sollte besser abschneiden als eine, die nur 2D -Bilder versteht.

Die Forscher fanden das jedoch fest VLMs wie GPT-4O und Qwen2-VLdie nicht speziell für 3D -Aufgaben ausgelegt waren, konnte Oft übertreffen hochmoderne 3D-Modelle– Wenn Sie 2D -Bilder von Punktwolken betrachten. Dies deutet darauf hin, dass diese Benchmarks nicht tatsächlich testen, ob KI 3D -Strukturen versteht, sondern eher Wie gut es 3D -Informationen aus flachen Bildern schließen kann.

Um dies zu demonstrieren, entwickelte sich das Team VLM3Deine Methode, die 3D -Punktwolken in gerenderte Bilder umwandelt, bevor sie sie in ein VLM füttern. Bei der getesteten wichtigen 3D -KI -Benchmarks – einschließlich 3D MM-VET, Objaversexl-Lvis, Scanqa und SQA3D– VLM3D übertriffte in vielen Aufgaben konsequent übertroffen oder übereinstimmte führende 3D -Modelle.

Warum einige 3D -Aufgaben anfälliger sind als andere

Während VLMs bei Aufgaben wie Objekterkennung und grundlegender Szenenbeschreibung hervorragend waren, kämpften sie auf Aufgaben, die ein tieferes Verständnis von erforderlich waren räumliche Beziehungen, Okklusionen und Konsistenz mit mehreren Ansichten.

- Einfache 3D -Objekt -Benchmarks: Viele Objekterkennungsaufgaben in 3D -Benchmarks könnten sein Mit 2D -Bildern leicht zu lösen. Die Studie ergab, dass VLMs 3D -Modelle in diesen Fällen übereinstimmen oder überschreiten könnten, was beweist, dass die Benchmarks nicht effektiv das 3D -Verständnis testeten.

- Komplexe Szenenbenchmarks: Aufgaben, für die KI erforderlich ist, um vollständige 3D -Umgebungen zu verstehen, wie z. Q & A. SzenenebeneAnwesend NavigationUnd situative Argumentationwaren für VLMs viel schwieriger zu betrügen. Hier führten 3D LLMs konsequent besser ab und zeigen, dass diese Aufgaben auf echtes 3D -räumlicher Denken beruhen.

Das bedeutet das Nicht alle 3D -Benchmarks sind fehlerhaft– aber viele von ihnen unterscheiden nicht dazwischen echte 3D -Fähigkeit und 2D -Inferenztricks.

Wenn 2D -Modelle stecken bleiben

Eine der größten Schwächen von VLMs bei 3D -Aufgaben stammt aus Auswahl angesehen– Die Tatsache, dass ein einzelnes 2D -Bild nur einen Teil einer 3D -Szene erfasst.

Die Forscher getestet Drei verschiedene Rendering -Ansätze Um zu bewerten, wie stark sich dies auswirkt:

- Einzelansicht: Der einfachste Ansatz, bei dem ein Objekt oder eine Szene aus einer festen Perspektive gerendert wird. VLMs wurden hier am besten gespieltwie sie genügend Informationen aus nur einem Bild extrahieren konnten.

- Multi-View: Bilder wurden von erfasst von vier verschiedene WinkelKI -Modelle mehr Kontext geben. Überraschenderweise VLMs verbesserte sich nicht wesentlich Im Vergleich zu Einzelansichtsmodellen schlägt sie vor, dass sie Schwierigkeiten haben, mehrere Perspektiven zu einem einheitlichen 3D-Verständnis zu kombinieren.

- Oracle View: Die KI wurde gegeben Der bestmögliche Standpunkt für die Beantwortung jeder Frage. Hier erzielten VLMs viel besseraber immer noch hinter den dedizierten 3D -LLMs zurückgegangen und zeigt, dass sie selbst bei perfekten Bildern keine echten 3D -Argumentationsfähigkeiten fehlen.

Dies verstärkt die Idee, dass VLMs verstehen nicht 3D– Sie machen es einfach gut, wenn sie die richtigen 2D -Ansichten erhalten.

Was muss sich ändern

Um 3D -KI -Modelle wirklich zu bewerten, schlägt die Studie vor vier Schlüsselprinzipien zum Entwerfen besserer Benchmarks:

- Komplexere 3D -Daten: Anstatt einfache Objektpunktwolken zu verwenden, sollten Benchmarks enthalten detaillierte und realistische 3D -Szenen mit struktureller Komplexität.

- Aufgaben, die eine echte 3D -Argumentation erfordern: Anstatt nur Objekte zu erkennen, sollte KI auf Aufgaben getestet werden, die erfordern räumliches Verständniswie z. B. Vorhersage versteckter Oberflächen oder Argumentation über Objektinteraktionen.

- Kontextbewusste Herausforderungen: Fragen sollten sich darauf konzentrieren, sich darauf zu konzentrieren Einzigartige 3D -Eigenschaftensicherstellen, dass sie mit einem einzigen 2D -Bild nicht beantwortet werden können.

- Bessere Bewertungsmetriken: Aktuelle Benchmarks verlassen sich oft auf Textähnlichkeitszahlenwas nicht erfasst werden kann Wahres 3D -Verständnis. Stattdessen sollten KI -Modelle anhand ihrer Fähigkeit bewertet werden Abschluss der Tiefe, Struktur und Objektbeziehungen im dreidimensionalen Raum.

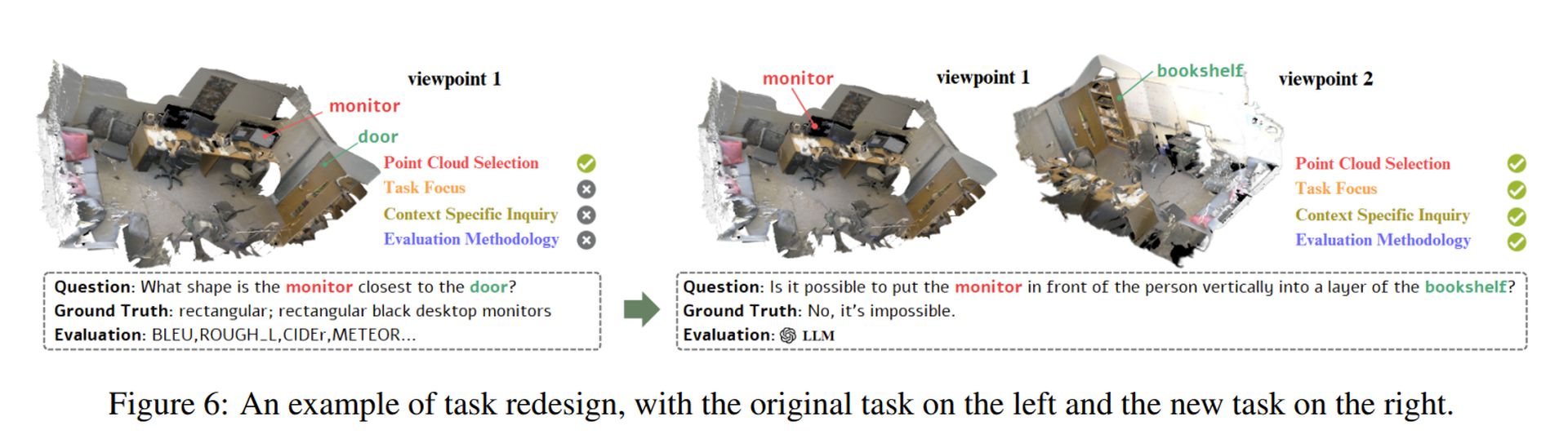

Die Forscher zeigten, wie diese Prinzipien angewendet werden könnten von Neugestaltung einer fehlerhaften Aufgabe (Siehe oben Bild). Ihr Ansatz stellt sicher, dass KI -Modelle tatsächlich tatsächlich müssen Prozess 3D -Strukturen anstatt sich auf 2D -Verknüpfungen zu verlassen.

Ausgewähltes Bildnachweis: Sebastian Svenson/Unsplash