Ein neues KI -Modell namens S1, enthüllt In einer am 2. Februar veröffentlichten Arbeit wird auf die kostengünstige Leistung aufmerksam gemacht, die die O1 von Openai auf die Konkurrenz hat und erhebliche Fähigkeiten zu einem Trainingskosten von nur 6 US-Dollar erreicht.

Das KI-Modell S1 entsteht als kostengünstige Alternative zu Openai’s O1

Das S1-Modell erreicht die Leistungsniveaus nahe dem Stand der Technik, wobei eine einfachere Infrastruktur verwendet wird. Es verbessert große Sprachmodelle (LLMs) während der Inferenz, indem sie die „Denkzeit“ durch Interventionen wie das Ersetzen von Terminal -Tags durch Eingabeaufforderungen wie „Warten“ erweitert.

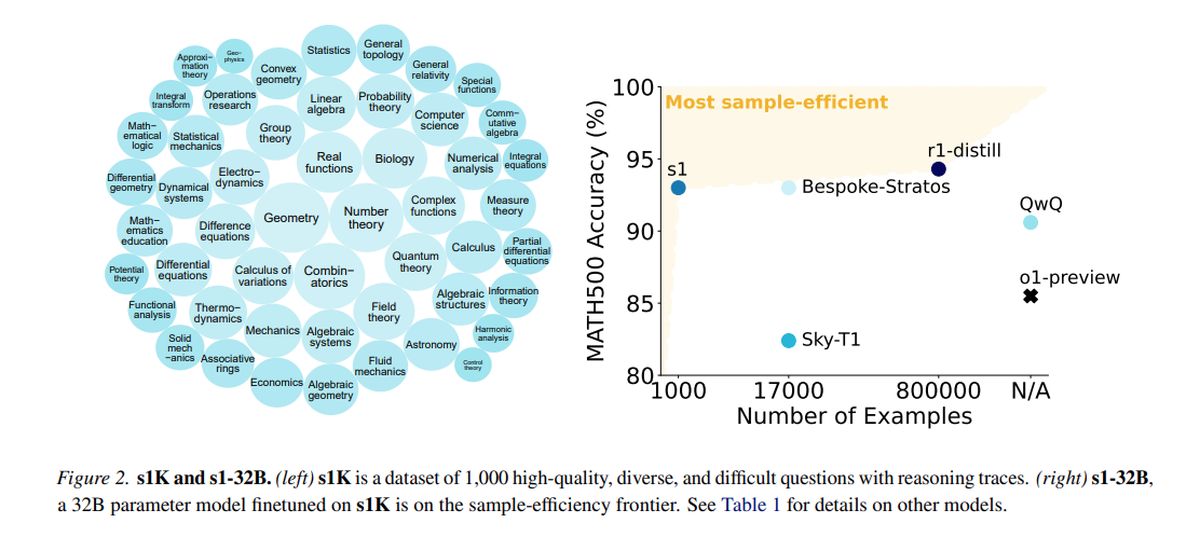

Ausgebildet auf einem destillierten Datensatz, der aus 1.000 hochwertigen Beispielen aus QWEN2.5 besteht und von Alibaba Cloud entwickelt wurde, verwendete S1 16 NVIDIA H100 GPUs mit einem einzigen Trainingslauf, der ungefähr 26 Minuten dauerte. Die gesamten Rechenkosten betrugen etwa 6 US -Dollar und ermöglichten auch für Teams mit begrenzten Ressourcen häufigere Experimente.

Während größere Unternehmen wie OpenAI und Anthrop von einer umfangreichen Infrastruktur abhängen, zeigen Innovationen wie S1 das Potenzial für Fortschritte innerhalb der eingeschränkten Budgets. Die Einführung von S1 hat jedoch Bedenken hinsichtlich der „Distaling“ ausgelöst, eine Praxis, in der Modelle destillierte Datensätze aus anderen KI -Systemen verwenden und ethische und rechtliche Fragen aufwirft, die Branchendiskussionen entzündet haben.

In Tests zur Messung von Mathematik- und Codierungsfähigkeiten führt S1 vergleichsweise mit führenden Argumentationsmodellen wie O1 und Deepseeks R1 durch. Das S1 -Modell, einschließlich der Daten und des Trainingscode, ist auf GitHub zugänglich.

Das Team hinter S1 begann mit einem Basismodell außerhalb des Schalenes und verfeinerte es durch Destillation, eine Methode, um Argumentationsfunktionen aus einem vorhandenen KI-Modell mit seinen Antworten zu extrahieren. Insbesondere wird S1 von Google destilliert Gemini 2.0 Flash Thinking Experimental, der einen ähnlichen Ansatz darstellt, der von Berkeley -Forschern verwendet wird, um im letzten Monat ein KI -Argumentationsmodell für ungefähr 450 US -Dollar zu entwickeln.

Die Fähigkeit kleinerer Forschungsteams, im KI -Raum ohne wesentliche finanzielle Unterstützung innovativ zu sein, ist sowohl Aufregung als auch Herausforderungen. Es stellt sich die Frage nach der Nachhaltigkeit von Eigentumsvorteilen in einer Landschaft, in der kostspielige Modelle erschwinglich repliziert werden können.

OpenAI hat Unzufriedenheit zum Ausdruck gebracht und behauptet, dass Deepseek Daten aus seiner API zum Zweck der Modelldestillation nicht ordnungsgemäß geerntet hat. Die Forscher wollten einen einfachen Ansatz entwickeln, der eine robuste Argumentationsleistung und eine „Testzeitskalierung“ erzielt und die KI-Modelle ermöglicht, sich vor der Beantwortung einer tieferen Analyse durchzuführen.

Die S1-Forschung zeigt, dass Argumentationsmodelle mit einem relativ kleinen Datensatz über eine Methode, die als übersichtliche Feinabstimmung (SFT) bezeichnet wird, destilliert werden können, wodurch das KI-Modell angewiesen wird, bestimmte Verhaltensweisen innerhalb eines Datensatzes zu imitieren. Diese Methode ist in der Regel wirtschaftlicher als der von Deepseek für sein R1-Modell verwendete großflächige Verstärkungslernenansatz.

Google bietet einen freien Zugriff auf Gemini 2.0 Flash Thinking Experimental, obwohl die Nutzung den täglichen Ratenbegrenzungen unterliegt und seine Begriffe umgekehrte Modelle zur Schaffung von konkurrierenden Diensten verbieten. Der S1 -Schulungsprozess umfasste einen Datensatz von 1.000 maßgeschneiderten Fragen und Antworten sowie die von Gemini 2.0 abgeleiteten Argumentationsprozesse.

Nach dem Training, das weniger als 30 Minuten dauerte, zeigte S1 eine starke Leistung bei bestimmten KI -Benchmarks. Niklas Muennighoff, ein an dem Projekt beteiligter Forscher bei Stanford, gab an, dass die erforderlichen Rechenressourcen heute für etwa 20 US -Dollar gemietet werden könnten.

Die Forscher haben auch eine Technik implementiert, um die Genauigkeit von S1 zu verbessern, indem sie sie zum „Warten“ während des Arguments anwiesen, wodurch ihre Denkzeit verlängerte und leicht verbesserte Antworten erzielte.

Ausgewähltes Bildnachweis: Google DeepMind/Unsplash