Benutzeranalysen und Benchmark-Tests zeigen ein geteiltes Urteil zwischen Deepseek R1 und O3-Mini, wobei Entwickler und Unternehmen unterschiedliche Stärken der KI-Modellleistung, der Preisgestaltung und der Barrierefreiheit priorisieren. Das Feedback der Menschen zeigt die Kosteneffizienz von Deepseek R1 und die technische Innovation gegen die Zuverlässigkeit und die Integration von Ökosystemen von O3-Mini. Weitere dazu unten…

Openai O3-Mini gegen Deepseek-R1: Was ist besser?

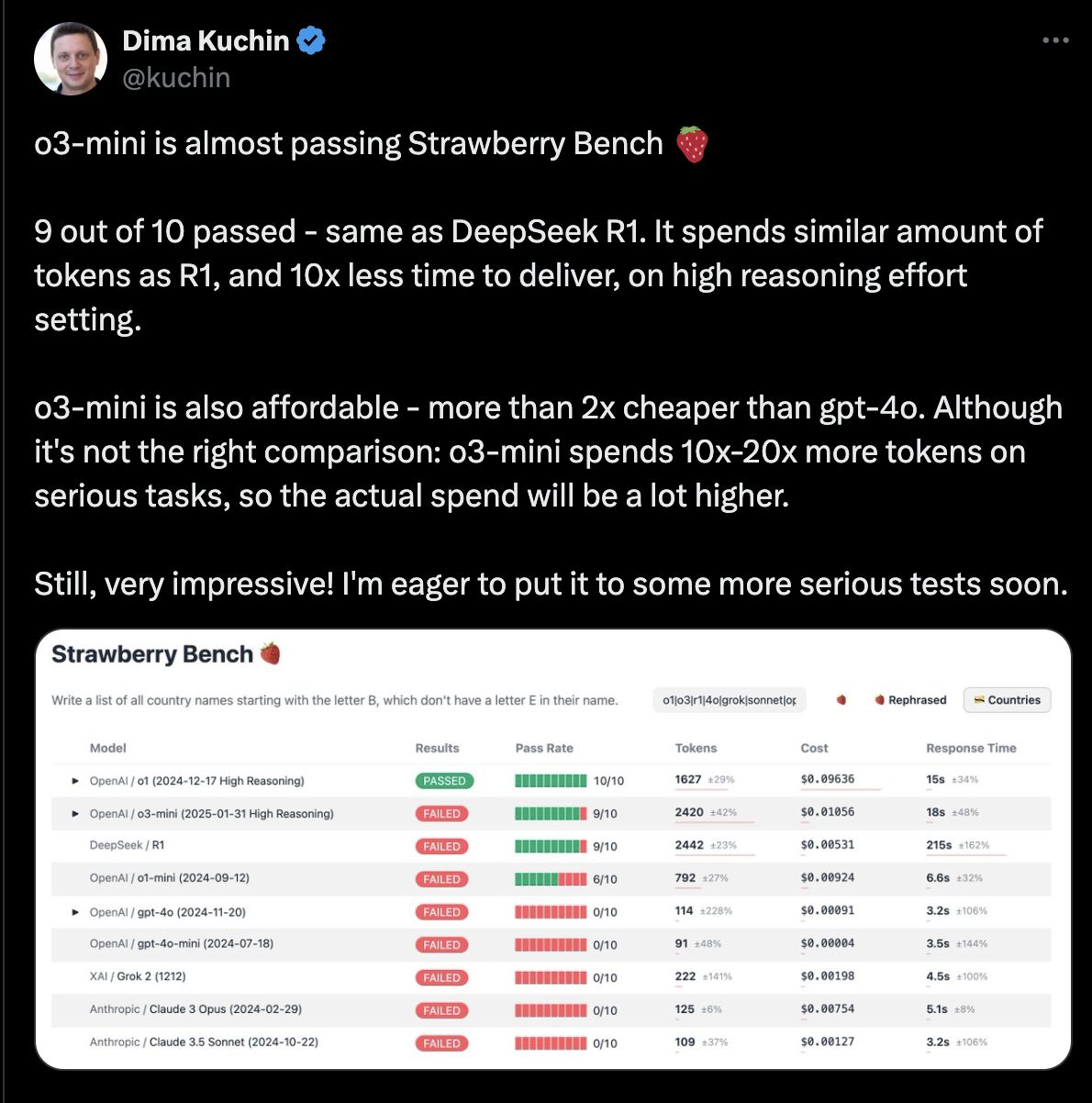

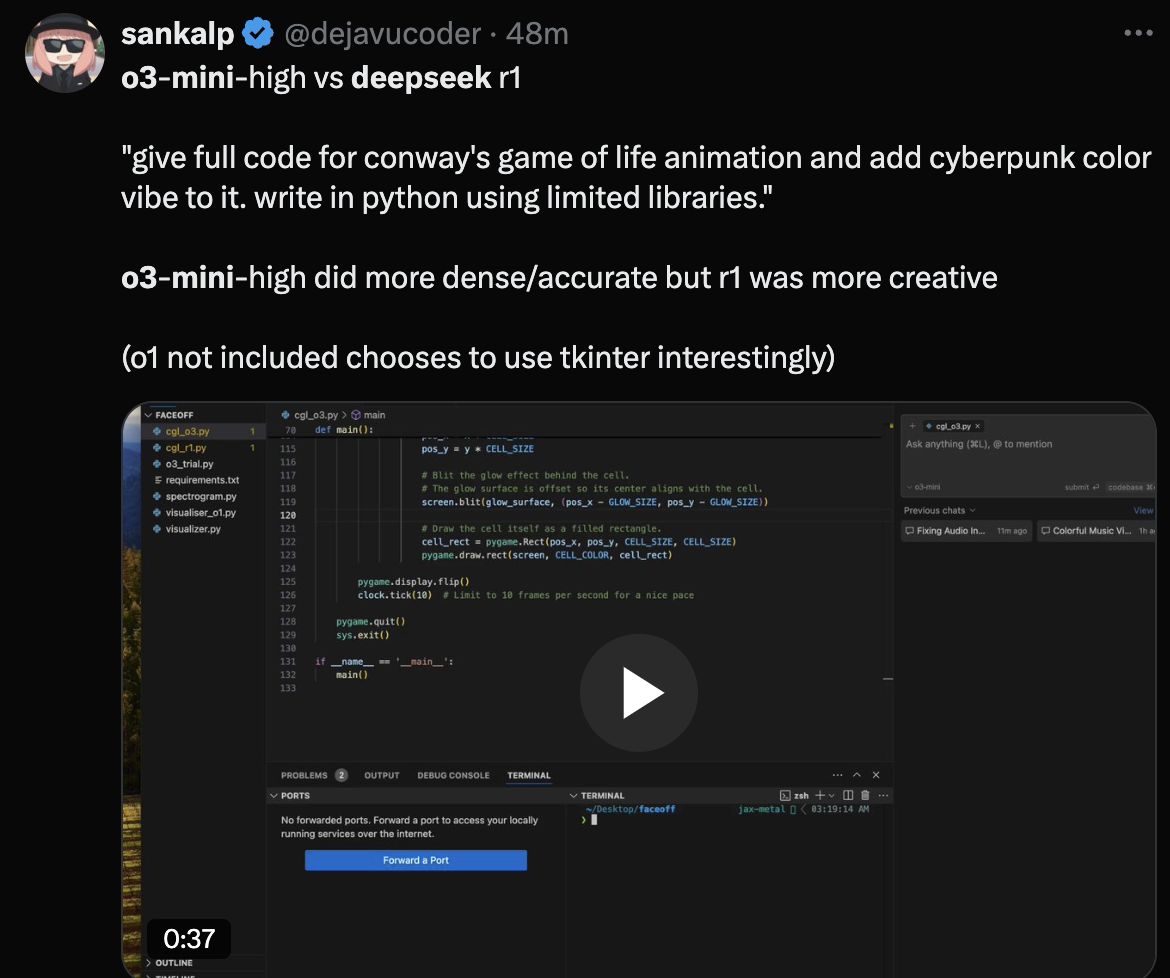

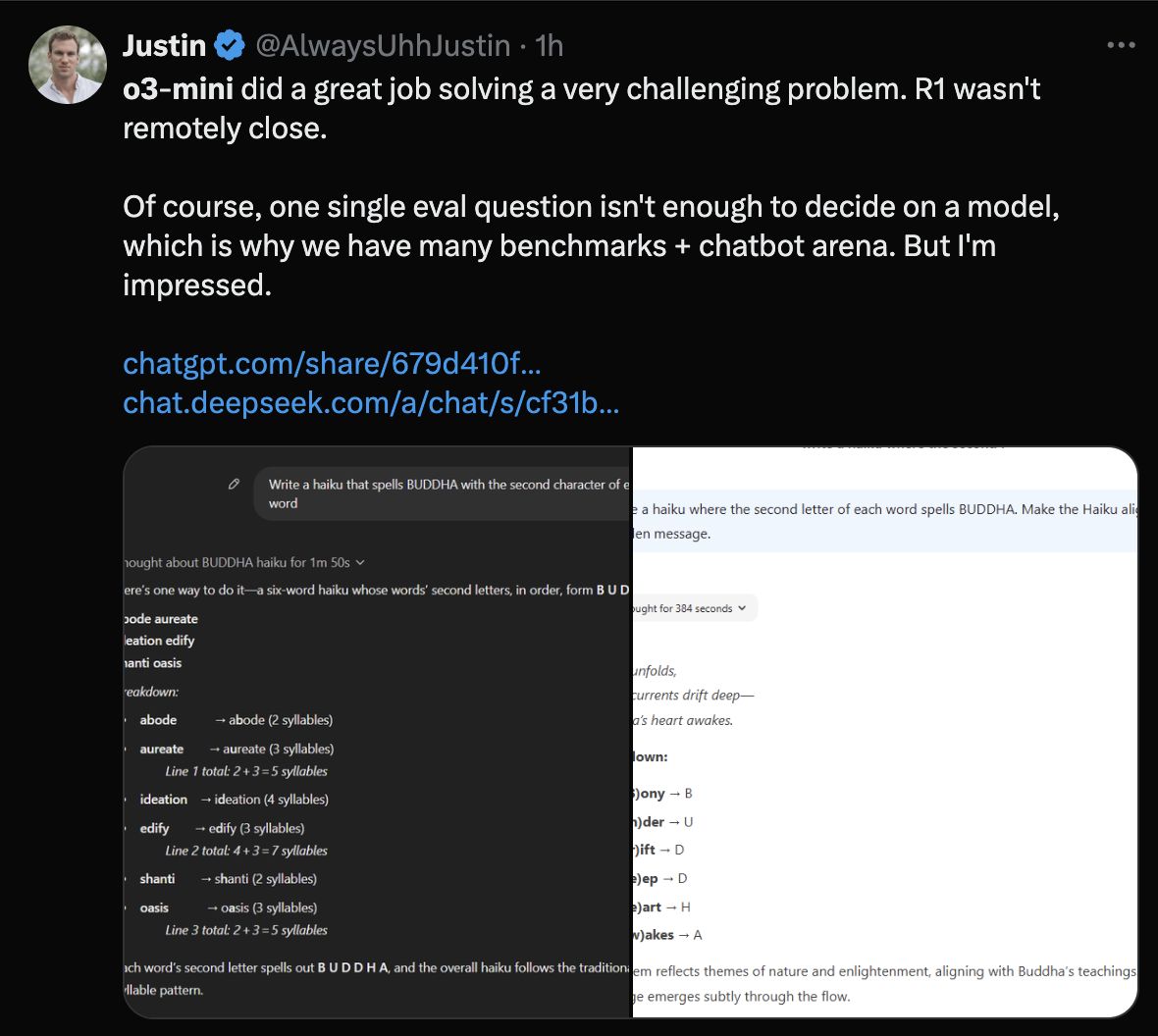

Leistungsbenchmarks zeigen unterschiedliche Stärken

Deepseek R1 Erzählte 79,8% für den Aime-Mathematik-Benchmark und 93% bei Math-500, was Konkurrenten bei komplexen Argumentationsaufgaben übertrifft. Benutzer lobten seine transparente „Kette der Gedankenkette“, die Forscher und Akademiker für die Replikation der Ergebnisse als wertvoll empfinden. Tester stellten jedoch Inkonsistenzen in Multi-Turn-Gesprächen und gelegentlichem Sprachmischen in Antworten fest.

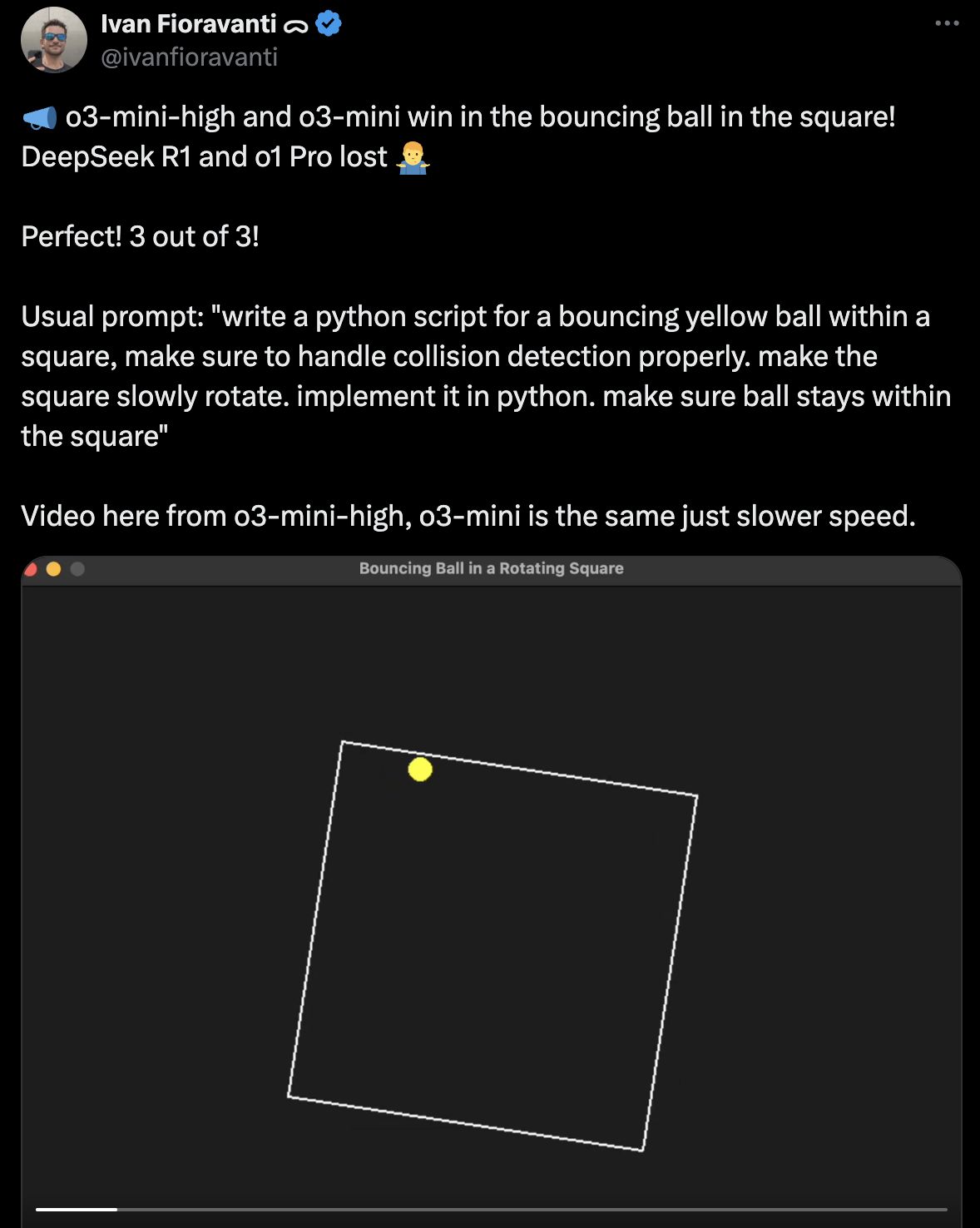

o3-mini Laut realen Nutzerberichten zeigten schnellere Inferenzgeschwindigkeiten und stabilere Leistung in strukturierten Dialogen mit mehreren Turns. Während es Deepseek R1 in spezialisierten mathematischen Benchmarks verfolgt, bezeichneten die Entwickler es für Routineaufgaben wie Codegenerierung und Datenanalyse als „vorhersehbar und poliert“.

o3-mini Laut realen Nutzerberichten zeigten schnellere Inferenzgeschwindigkeiten und stabilere Leistung in strukturierten Dialogen mit mehreren Turns. Während es Deepseek R1 in spezialisierten mathematischen Benchmarks verfolgt, bezeichneten die Entwickler es für Routineaufgaben wie Codegenerierung und Datenanalyse als „vorhersehbar und poliert“.

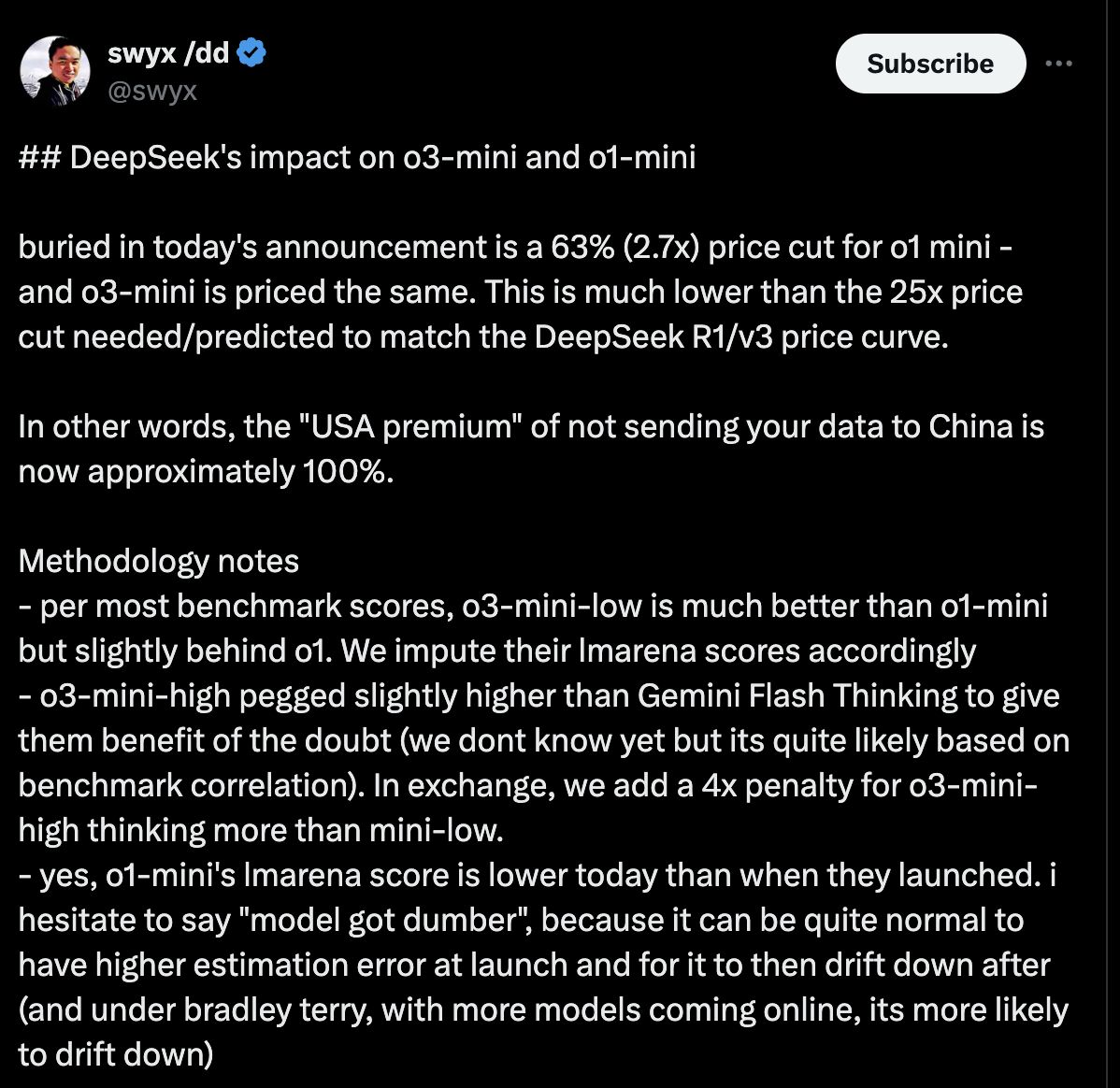

Kostenvergleich hebt die Marktstörung hervor

Deepseek R1 ist die erschwinglichste Option in den aktuellen KI-Modellvergleiche, die OpenAs O3-Mini-, O1-Mini- und O1-Modelle durch signifikante Margen unterbinden. Preisdaten zeigen starke Unterschiede in den Token -Kosten in Wettkämpfen.

OpenAI -Modellpreisstufen

OpenAI -Modellpreisstufen

O3-mini kostet 1,10 USD pro Million Eingangs-Token und 4,40 USD pro Million Output-Token, was einem Rabatt von 63% gegenüber O1-Mini und einer Reduzierung von 93% gegenüber den Preisen des vollständigen O1-Modells entspricht. Ein 50% iger Cache-Rabatt senkt die wirksamen Tarife von O3-Mini für berechtigte Benutzer weiter.

Deepseeks aggressive Preisstrategie

Deepseek R1 berechnet 0,14 USD pro Million Input-Token und 0,55 USD pro Million Output-Token-ca. 87% billiger als die Grundsätze von O3-Mini. Dies macht R1:

• 96% billiger als die äquivalente Preisgestaltung von O1-Mini

• 99% billiger als die ursprünglichen Kosten des vollständigen O1 -Modells

Die Preislücke bleibt auch bei der Anwendung von O3-Mini-Cache-Rabatt bestehen: Bei 0,55 USD/2,20 USD pro Million Token (Input/Output) bleibt O3-Mini fast 4x teurer als die nicht erfassten Raten von R1. Entwickler von X nannten es einen „Game-Changer“ für Startups und akademische Projekte, die eine leistungsstarke KI ohne Lizenzgebühren erfordern.

Die Preisgestaltung von O3-Mini entspricht den kommerziellen Modellen von OpenAI, beinhaltet jedoch den Zugriff auf die Enterprise-Tools von Chatgpt, einschließlich SOC 2 Compliance und granuläre Nutzungskontrollen. Enterprise-Benutzer rechtfertigen die höheren Kosten, indem sie die Komplexität der reduzierten Bereitstellungen und integrierte Sicherheitsfunktionen zitieren.

Die Preisgestaltung von O3-Mini entspricht den kommerziellen Modellen von OpenAI, beinhaltet jedoch den Zugriff auf die Enterprise-Tools von Chatgpt, einschließlich SOC 2 Compliance und granuläre Nutzungskontrollen. Enterprise-Benutzer rechtfertigen die höheren Kosten, indem sie die Komplexität der reduzierten Bereitstellungen und integrierte Sicherheitsfunktionen zitieren.

Benutzerfreundlichkeit: Barrierefreiheit gegen Anpassung

O3-mini dominiert in der Benutzerfreundlichkeit mit seiner Schnittstelle im Chatgpt-Stil, der kostenlosen Stufe für grundlegende Benutzer und API, die minimales Codierungskompetenz erfordern. Nichttechnische Tester haben die Integration in weniger als 30 Minuten abgeschlossen und sein „intuitives Design“ für schnelles Prototyping gelobt.

Deepseek R1 erfordert technische Kenntnisse für die Bereitstellung und fordert die Benutzer, Infrastruktur- und Feinabstimmung Modelle über Code zu verwalten. Während Entwickler ihre Flexibilität zu schätzen wissen, geben kleine Teams an, „Stunden Fehlerbehebungskonfigurationen“ auszugeben, um die Ausgaben zu optimieren.

Deepseek R1 erfordert technische Kenntnisse für die Bereitstellung und fordert die Benutzer, Infrastruktur- und Feinabstimmung Modelle über Code zu verwalten. Während Entwickler ihre Flexibilität zu schätzen wissen, geben kleine Teams an, „Stunden Fehlerbehebungskonfigurationen“ auszugeben, um die Ausgaben zu optimieren.

Community -Reaktionen zeigen gespaltene Präferenzen

X -Benutzer unterstreichen die Erschwinglichkeit und Transparenz von Deepseek R1. Kritiker zitieren „umständliche Formatierung“ und eine schwächere Leistung bei kreativen Schreibaufgaben im Vergleich zu O3-Mini.

O3-Mini loben sich für Zuverlässigkeit, aber Skeptiker argumentieren, dass ihre Kosten die Skalierung verbieten, während einige Entwickler im Vergleich zu Alternativen Open-Source-Alternativen eine begrenzte Kontrolle über das Modellverhalten beklagen.

O3-Mini loben sich für Zuverlässigkeit, aber Skeptiker argumentieren, dass ihre Kosten die Skalierung verbieten, während einige Entwickler im Vergleich zu Alternativen Open-Source-Alternativen eine begrenzte Kontrolle über das Modellverhalten beklagen.

Endgültiges Urteil: Spezialisten gegen Generalisten

Technische Teams bevorzugen trotz steilerer Lernkurven Deepseek R1 für seine mathematischen Fähigkeiten, den Open-Source-Code und die radikalen Kosteneinsparungen. Unternehmen und Gelegenheitsbenutzer bevorzugen die Plug-and-Play-Funktionalität von O3-Mini und nahtlose Integration in vorhandene OpenAI-Workflows.

Community-Diskussionen unterstreichen eine wachsende Kluft: Deepseek R1 zieht Forscher und Entwickler an, die die Rohleistung priorisieren, während O3-Mini Unternehmen und Einzelpersonen, die die Stabilität und Einfache der Adoption bewerten, behält.

Community-Diskussionen unterstreichen eine wachsende Kluft: Deepseek R1 zieht Forscher und Entwickler an, die die Rohleistung priorisieren, während O3-Mini Unternehmen und Einzelpersonen, die die Stabilität und Einfache der Adoption bewerten, behält.