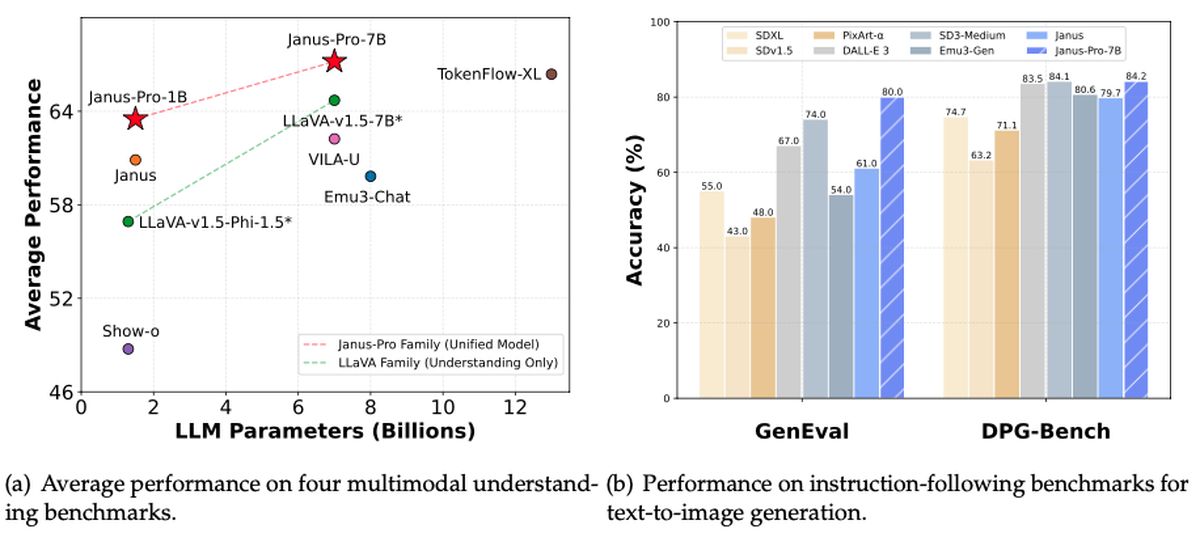

Deepseek hat einen weiteren großen Beitrag zur Open-Source-KI-Landschaft vorgestellt. Diesmal ist es Janus-Pro-7b: ein multimodales Kraftpaket, das sowohl Bilder verstehen als auch erzeugen kann. Entsprechend Rowan CheungDas neue Modell in den Eclipses OpenAIs Dall-E 3 und die stabile Diffusion in Benchmarks wie Geneval und DPG-Bench zeigt auch denselben „frei verfügbaren“ Geist, der das frühere R1-Modell von Deepseek machte, das das R1-Modell zu einer viralen Empfindung machte. Die Anleger bemühen sich unterdessen, den Anstieg der AI -Durchbrüche zu verstehen, mit Die Aktie von NVIDIA, die am Mittag mehr als 17% eintaucht.

Könnte Janus-Pro-7b der nächste große Disruptor in einem bereits turbulenten Tech-Markt sein?

Was ist Deepseek Janus-pro-7b?

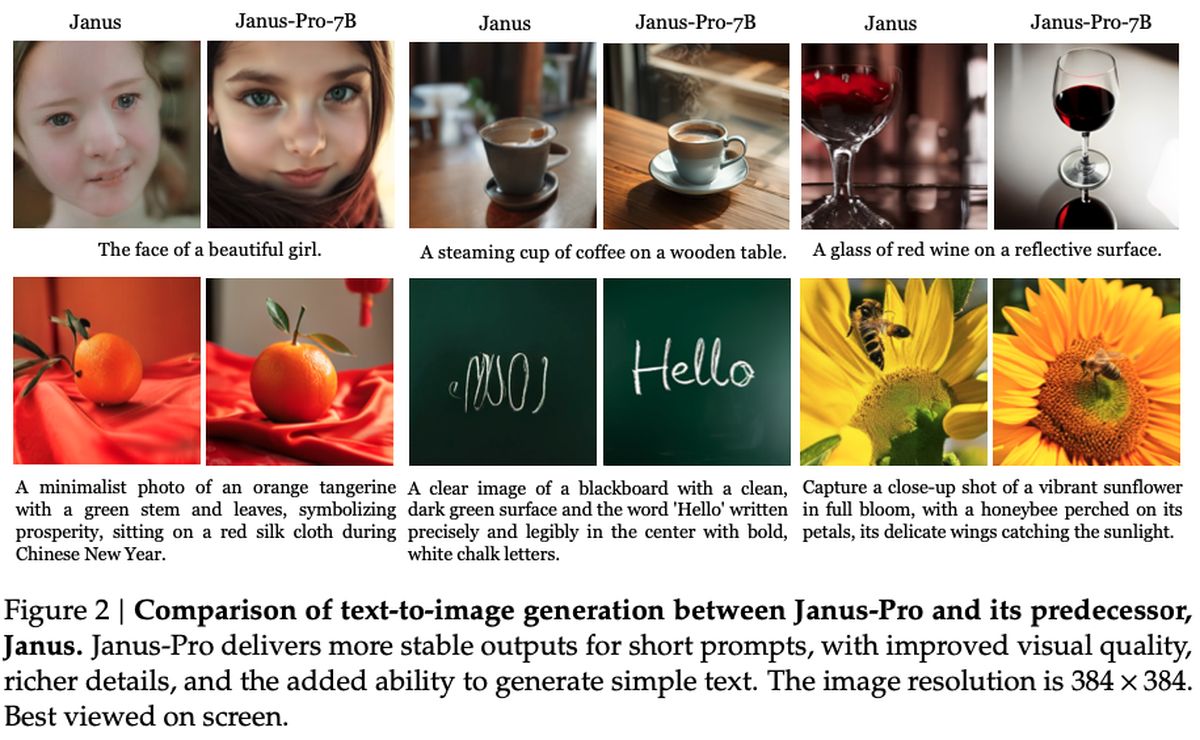

Unter der Haube versucht Janus-Pro-7b, die Lücke zwischen leistungsstarker Sehverarbeitung und schneller Textgenerierung zu überbrücken. Das System liehen Sie einen neuartigen Entkopplungsansatz aus seinem Siglip-L-Encoder aus und kann ein 384 x 384 Bild schnell analysieren, bevor er in den kreativen Ausgangsmodus einspringt. Es entspricht oder übertrifft sogar viele spezialisierte Modelle im Raum – eine Leistung, die besonders auffällig ist, da es auch bemerkenswert leicht zu anpassen und zu erweitern ist.

Analysten weisen auf Deepseeks konsequente Philosophie hin: Halten Sie es offen, bleiben Sie in den Bereichen Privatsphäre und unterbleibende Abonnement-Basis. Janus-Pro-7b scheint an allen drei Fronten zu liefern und hohe Leistungsspuren zu setzen und gleichzeitig die Zugänglichkeit zu erhalten, die die Fans auf die Offline-Funktionen von Deepseek-R1 bewegte.

In rein sachlich MIT -Frameworkmit zusätzlichen Nutzungsrichtlinien von Deepseek. Das Modell integriert sich in nachgeschaltete Projekte über ein Github -Repository und verwendet Berichten zufolge nur 16x Downsampling in seiner Pipeline für die Bildgenerierung. Aktuelle Indikatoren deuten darauf hin, dass die Ankunft von Janus-Pro-7b möglicherweise einen neuen Wettbewerb zwischen KI-Entwicklern auslösen kann. Nur die Zeit wird jedoch zeigen, wie sich dieses neueste kostenlose Angebot auf die KI-Zone auswirkt.

Wie kann ich Deepseek-R1 einfach kostenlos (online und lokal) einrichten?

Wie funktioniert es?

Wie in der detailliert Forschungspapier Das von Deepseek veröffentlichte Modell verwendet einen Siglip-Large-Patch16-384-Encoder, der jedes Bild in 16 × 16-Patches bei einer Auflösung von 384 × 384 unterteilt. Dieser Ansatz bewahrt feinkörnige Details und hilft dem System dabei, Bilder genauer zu interpretieren. Auf der Generierungsseite verwendet Janus-Pro ein Codebuch mit 16.384 Token, um Bilder in einer 16 × Down-Sampled-Skala darzustellen, die effiziente Rekonstruktionen ermöglicht, die konkurrenzlos-wenn nicht übertroffen-traditionelle Diffusionsmodelle in Qualität.

Zwei wichtige MLP-Adapter (Multi-Layer Perceptron) verbinden diese Verständnis- und Erzeugungskomponenten, um sicherzustellen, dass die Daten zwischen den beiden Aufgaben reibungslos fließen. Während des Trainings sieht das Modell eine Mischung aus Bild- und Textdaten, sodass es lernt, sowohl visuelle Szenen zu interpretieren und eigene Bilder zu produzieren. Die Sitzungen dauern typischerweise 7 bis 14 Tage bei großen GPU-Clustern (sowohl für 1,5B- als auch für 7B-Parameterversionen), wobei die Leistung auf Benchmarks wie GQA (für visuelles Verständnis) und Visualgen (zur Bildung von Bild) getestet wird. Das Ergebnis ist ein vielseitiger Rahmen, der sich dank seiner speziellen, aber zusammenhängenden Architektur bei multimodalen Aufgaben auszeichnet.

Wie benutze ich Deepseek Janus-pro-7b?

Der Einstieg mit Janus-Pro-7b ist so einfach wie das offizielle Github-Repository, das Klonen oder Herunterladen des Codes und die Installation der erforderlichen Abhängigkeiten. Das Repository enthält ein umfassendes Readme, das Sie durch die Einrichtung einer Python -Umgebung, das Ziehen der Modellgewichte und das Ausführen von Beispielskripten führt. Abhängig von Ihrer Hardware können Sie zwischen dem CPU-Modus oder der GPU-Beschleunigung nur zwischen CPU-Modus oder GPU-Beschleunigung für eine schnellere Leistung wählen. In jedem Fall bleibt der Installationsprozess dank gut dokumentierter Voraussetzungen und Schritt-für-Schritt-Anweisungen unkompliziert.

Sobald alles im Einsatz ist, können Sie Eingabeaufforderungen für die Textgenerierung einspeisen oder Bildeingaben für die einzigartigen multimodalen Funktionen des Modells bereitstellen. Beispielnotizbücher im Repo zeigen, wie kreative Ausgänge generiert, erweiterte Bildtransformationen anwenden oder „visuelle Q & A“ -Szenarien untersuchen. Für fortgeschrittenere Benutzer kann das modulare Design des Repository die zugrunde liegenden Ebenen optimieren, Ihre eigenen Datensätze anschließen oder das Modell zusammen mit anderen Deepseek -Releases wie R1 stapeln.