Text-zu-Video-Generierung ist nicht mehr das, was es noch vor ein paar Jahren war. Wir haben es in ein Werkzeug mit wirklich futuristischer Funktionalität verwandelt. Benutzer erstellen Inhalte für persönliche Seiten, Influencer nutzen sie zur Eigenwerbung und Unternehmen nutzen sie für alles, von Werbung und Lehrmaterialien bis hin zu virtuellen Schulungen und Filmproduktionen. Die meisten Text-zu-Video-Systeme basieren auf der Architektur von Diffusionstransformatoren, die in der Welt der Videoerzeugung führend sind. Diese Technologie dient als Grundlage für Dienste wie Luma und Kling. Dieser Status wurde jedoch erst im Jahr 2024 gefestigt, als die ersten Diffusionstransformatoren für Video auf den Markt kamen.

Der Wendepunkt kam mit Veröffentlichung von OpenAI von SORAmit unglaublich realistischen Aufnahmen, die vom wirklichen Leben kaum zu unterscheiden waren. OpenAI zeigte, dass ihr Diffusionstransformator erfolgreich Videoinhalte generieren konnte. Dieser Schritt bestätigte das Potenzial der Technologie und löste einen Trend in der gesamten Branche aus: Mittlerweile basieren etwa 90 % der aktuellen Modelle auf Diffusionstransformatoren.

Diffusion ist ein faszinierender Prozess, der eine eingehendere Untersuchung verdient. Lassen Sie uns verstehen, wie die Diffusion funktioniert, welche Herausforderungen die Transformatortechnologie in diesem Prozess stellt und warum sie eine so wichtige Rolle bei der Text-zu-Video-Generierung spielt.

Was ist der Diffusionsprozess? GenAI?

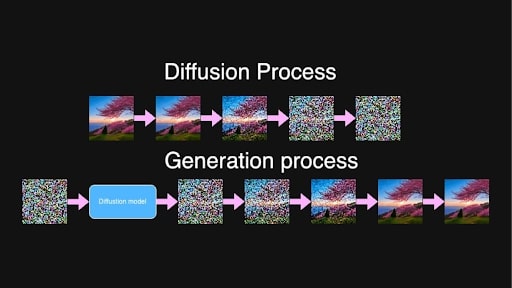

Im Zentrum der Text-zu-Video- und Text-zu-Bild-Generierung steht der Diffusionsprozess. Inspiriert durch das physikalische Phänomen, bei dem sich Substanzen allmählich vermischen – wie Tinte, die in Wasser diffundiert –, beinhalten Diffusionsmodelle beim maschinellen Lernen einen zweistufigen Prozess: das Hinzufügen von Rauschen zu den Daten und das anschließende Lernen, es zu entfernen.

Während des Trainings nimmt das Modell Bilder oder Sequenzen von Videobildern auf und fügt über mehrere Schritte schrittweise Rauschen hinzu, bis der ursprüngliche Inhalt nicht mehr zu unterscheiden ist. Im Wesentlichen verwandelt es es in reinen Lärm.

Diffusions- und Erzeugungsprozesse für die Eingabeaufforderung „Wunderschöner wehender Sakura-Baum, der bei Sonnenaufgang auf dem Hügel platziert wird“.

Diffusions- und Erzeugungsprozesse für die Eingabeaufforderung „Wunderschöner wehender Sakura-Baum, der bei Sonnenaufgang auf dem Hügel platziert wird“.

Bei der Generierung neuer Inhalte läuft der Prozess umgekehrt ab. Das Modell ist darauf trainiert, Rauschen schrittweise vorherzusagen und zu entfernen, wobei der Schwerpunkt auf einem zufälligen Zwischenrauschschritt zwischen zwei Punkten, t und t+1, liegt. Aufgrund des langen Trainingsprozesses hat das Modell alle Schritte im Übergang von reinem Rauschen zu nahezu sauberen Bildern beobachtet und ist nun durchaus in der Lage, Rauschen auf nahezu jedem Niveau zu erkennen und zu reduzieren.

Aus zufälligem, reinem Rauschen erstellt das Modell, geleitet vom Eingabetext, iterativ Videobilder, die kohärent sind und mit der Textbeschreibung übereinstimmen. Hochwertige, detaillierte Videoinhalte sind das Ergebnis dieses sehr schrittweisen Prozesses.

Latente Diffusion macht dies rechnerisch möglich. Anstatt direkt mit hochauflösenden Bildern oder Videos zu arbeiten, werden die Daten von einem Encoder in einen latenten Raum komprimiert.

Dies geschieht, um die Datenmenge, die das Modell verarbeiten muss, (erheblich) zu reduzieren und die Generierung zu beschleunigen, ohne die Qualität zu beeinträchtigen. Nachdem der Diffusionsprozess die latenten Darstellungen verfeinert hat, wandelt ein Decoder sie wieder in Bilder oder Videos mit voller Auflösung um.

Das Problem mit der Videogenerierung

Im Gegensatz zu einem einzelnen Bild müssen Objekte und Zeichen bei Videos durchgehend stabil bleiben, um unerwartete Verschiebungen oder Veränderungen im Erscheinungsbild zu verhindern. Wir alle haben gesehen, zu welchen Wundern generative KI fähig ist, aber das gelegentliche Fehlen eines Arms oder ein nicht erkennbarer Gesichtsausdruck liegt durchaus in der Norm. Im Video steht jedoch mehr auf dem Spiel; Konsistenz ist für ein flüssiges Gefühl von größter Bedeutung.

Wenn also im ersten Bild ein Charakter in einem bestimmten Outfit erscheint, muss dieses Outfit in jedem folgenden Bild identisch aussehen. Jede Veränderung im Erscheinungsbild der Figur oder jegliche „Morphierung“ von Objekten im Hintergrund unterbricht die Kontinuität und lässt das Video unnatürlich oder sogar unheimlich wirken.

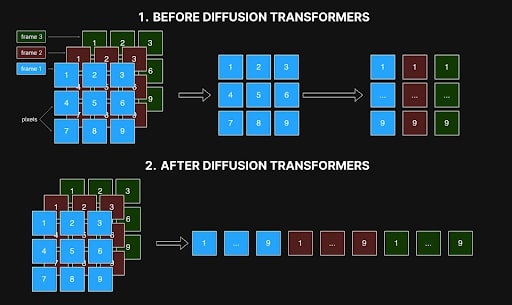

Bild vom Autor bereitgestellt

Frühe Methoden näherten sich der Videogenerierung durch die individuelle Verarbeitung von Einzelbildern, wobei jedes Pixel in einem Einzelbild nur auf das entsprechende Pixel in anderen referenzierte. Dieser Einzelbild-Ansatz führte jedoch häufig zu Inkonsistenzen, da er die räumlichen und zeitlichen Beziehungen zwischen Einzelbildern nicht erfassen konnte, die für reibungslose Übergänge und realistische Bewegungen unerlässlich sind. Artefakte wie Farbverschiebungen, schwankende Formen oder falsch ausgerichtete Merkmale sind eine Folge dieser mangelnden Kohärenz und beeinträchtigen die Gesamtqualität des Videos.

Bild vom Autor bereitgestellt

Bild vom Autor bereitgestellt

Das größte Hindernis bei der Lösung dieses Problems war der Rechenaufwand – und die Kosten. Bei einem 10-Sekunden-Video mit 10 Bildern pro Sekunde erhöht die Generierung von 100 Bildern die Komplexität exponentiell. Die Erstellung dieser 100 Frames ist aufgrund der Notwendigkeit einer präzisen Frame-zu-Frame-Kohärenz etwa 10.000-mal komplexer als die Erstellung eines einzelnen Frames. Diese Aufgabe erfordert das 10.000-fache an Speicher, Verarbeitungszeit und Rechenressourcen und überschreitet oft die praktischen Grenzen. Wie Sie sich vorstellen können, stand der Luxus, mit diesem Verfahren zu experimentieren, nur wenigen Auserwählten in der Branche zur Verfügung.

Das macht die Veröffentlichung von SORA durch OpenAI so bedeutsam: Sie zeigten, dass Diffusionstransformatoren trotz der immensen Komplexität der Aufgabe tatsächlich die Videoerzeugung bewältigen können.

Wie Diffusionstransformatoren das Selbstkonsistenzproblem bei der Videoerzeugung lösten

Das Aufkommen von Diffusionstransformatoren löste mehrere Probleme: Sie ermöglichten die Erzeugung von Videos beliebiger Auflösung und Länge und erreichten gleichzeitig eine hohe Selbstkonsistenz. Das liegt vor allem daran, dass sie mit langen Sequenzen arbeiten können, solange sie ins Gedächtnis passen, und am Selbstaufmerksamkeitsmechanismus.

In der künstlichen Intelligenz ist Selbstaufmerksamkeit ein Mechanismus, der die Aufmerksamkeitsgewichte zwischen Elementen in einer Sequenz berechnet und bestimmt, wie stark jedes Element von anderen beeinflusst werden soll. Es ermöglicht jedem Element in einer Sequenz, alle anderen Elemente gleichzeitig zu berücksichtigen, und ermöglicht es Modellen, sich bei der Generierung von Ausgaben auf relevante Teile der Eingabedaten zu konzentrieren und Abhängigkeiten über Raum und Zeit hinweg zu erfassen.

Bei der Videogenerierung bedeutet dies, dass jedes Pixel in jedem Frame mit jedem anderen Pixel in allen Frames in Beziehung stehen kann. Diese Vernetzung stellt sicher, dass Objekte und Charaktere im gesamten Video, vom Anfang bis zum Ende, konsistent bleiben. Wenn eine Figur in einem Frame erscheint, hilft die Selbstaufmerksamkeit dabei, Änderungen zu verhindern und das Aussehen dieser Figur in allen nachfolgenden Frames beizubehalten.

Zuvor enthielten Modelle eine Form der Selbstaufmerksamkeit innerhalb eines Faltungsnetzwerks, aber diese Struktur schränkte ihre Fähigkeit ein, die gleiche Konsistenz und Kohärenz zu erreichen, die jetzt mit Diffusionstransformatoren möglich ist.

Bei gleichzeitiger räumlich-zeitlicher Aufmerksamkeit in Diffusionstransformatoren kann die Architektur jedoch Daten aus verschiedenen Frames gleichzeitig laden und sie als einheitliche Sequenz analysieren. Wie in der Abbildung unten gezeigt, verarbeiteten frühere Methoden Interaktionen innerhalb jedes Frames und verknüpften jedes Pixel nur mit seiner entsprechenden Position in anderen Frames (siehe Abbildung 1). Diese eingeschränkte Sicht behinderte ihre Fähigkeit, die räumlichen und zeitlichen Beziehungen zu erfassen, die für eine reibungslose und realistische Bewegung unerlässlich sind. Bei Diffusionstransformatoren wird nun alles gleichzeitig verarbeitet (Abbildung 2).

Räumlich-zeitliche Interaktion in Diffusionsnetzwerken vor und nach Transformatoren. Bild vom Autor bereitgestellt

Räumlich-zeitliche Interaktion in Diffusionsnetzwerken vor und nach Transformatoren. Bild vom Autor bereitgestellt

Durch diese ganzheitliche Verarbeitung bleiben die Details über alle Frames hinweg stabil und stellen sicher, dass sich Szenen nicht unerwartet verändern und zu einem zusammenhangslosen Durcheinander im Endprodukt werden. Diffusionstransformatoren können auch Sequenzen beliebiger Länge und Auflösung verarbeiten, sofern sie in den Speicher passen. Mit dieser Weiterentwicklung ist die Erstellung längerer Videos ohne Einbußen bei Konsistenz oder Qualität möglich, wodurch Herausforderungen angegangen werden, die frühere faltungsbasierte Methoden nicht bewältigen konnten.

Die Einführung von Diffusionstransformatoren veränderte die Text-zu-Video-Generierung. Es ermöglichte die Produktion hochwertiger, konsistenter Videos in beliebigen Längen und Auflösungen. Die Selbstaufmerksamkeit innerhalb von Transformatoren ist eine Schlüsselkomponente bei der Bewältigung von Herausforderungen wie der Wahrung der Rahmenkonsistenz und dem Umgang mit komplexen räumlichen und zeitlichen Beziehungen. Die Veröffentlichung von SORA durch OpenAI hat diese Fähigkeit unter Beweis gestellt und einen neuen Standard in der Branche gesetzt: Mittlerweile basieren etwa 90 % der fortschrittlichen Text-zu-Video-Systeme auf Diffusionstransformatoren, wobei große Player wie Luma, Clink und Runway Gen-3 an der Spitze stehen Markt.

Trotz dieser atemberaubenden Fortschritte sind Diffusionstransformatoren immer noch sehr ressourcenintensiv und erfordern fast 10.000-mal mehr Ressourcen als die Erzeugung eines Einzelbilds, was das Training hochwertiger Modelle immer noch zu einem sehr kostspieligen Unterfangen macht. Dennoch hat die Open-Source-Community bedeutende Schritte unternommen, um diese Technologie zugänglicher zu machen. Projekte wie Open-SORA und Open-SORA-Plan sowie andere Initiativen wie Mira Video Generation, Cog und Cog-2 haben Entwicklern und Forschern neue Möglichkeiten für Experimente und Innovationen eröffnet. Unterstützt von Unternehmen und akademischen Institutionen geben diese Open-Source-Projekte Hoffnung auf kontinuierliche Fortschritte und eine bessere Zugänglichkeit bei der Videogenerierung, wovon nicht nur große Unternehmen, sondern auch unabhängige Schöpfer und experimentierfreudige Enthusiasten profitieren. Dies eröffnet, wie jede andere von der Community betriebene Initiative, eine Zukunft, in der die Videogenerierung demokratisiert wird und diese leistungsstarke Technologie vielen weiteren Kreativen zugänglich macht.