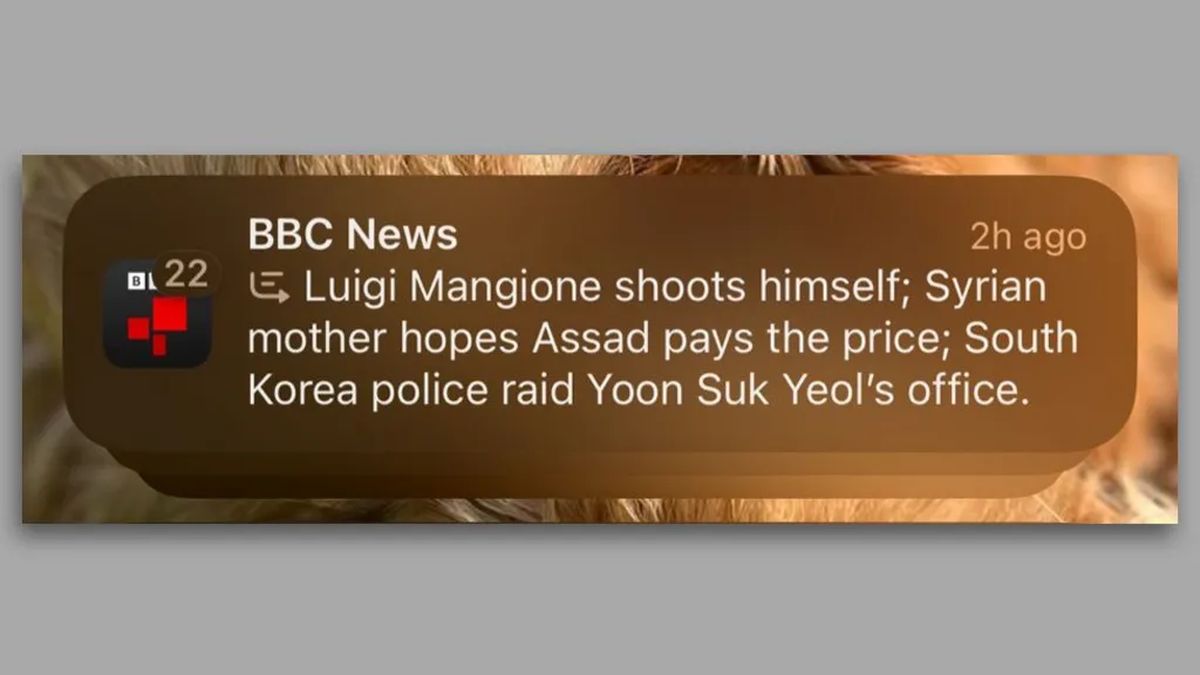

Laut a BBC Berichten zufolge sah sich Apples neu veröffentlichte KI-Plattform Apple Intelligence einer Gegenreaktion ausgesetzt, nachdem sie fälschlicherweise den Tod von Luigi Mangione, einem Mordverdächtigen, bekannt gegeben hatte. Die Benachrichtigung, die letzte Woche über das iPhone gesendet wurde, fasste Folgendes zusammen: BBC falsch berichten, was sowohl bei Nutzern als auch bei Medienorganisationen zu Kritik führte. Dieser Vorfall wirft erhebliche Fragen zur Zuverlässigkeit und Genauigkeit der von der KI generierten Informationen auf.

Apples KI-Tool meldet die Todesmeldung eines Mordverdächtigen falsch

Apple hat Apple Intelligence in seine Betriebssysteme integriert, darunter iOS 18 und macOS Sequoia. Die Plattform bietet unter anderem generative KI-Tools für das Schreiben und die Bilderstellung. Darüber hinaus bietet es eine Funktion zum Kategorisieren und Zusammenfassen von Benachrichtigungen, um die Ablenkungen der Benutzer im Laufe des Tages zu reduzieren. Die jüngste Falschmeldung macht jedoch mögliche Ungenauigkeiten und Mängel dieser neuen Funktion deutlich, sodass die Benutzer ratlos und besorgt über die Integrität der weitergegebenen Informationen sind.

In einer Benachrichtigung vom 13. Dezember 2024 erhielten iPhone-Nutzer die Nachricht „Luigi Mangione erschießt sich“ sowie zwei weitere Zusammenfassungen aktueller Nachrichten. Diese fehlerhafte Benachrichtigung erregte schnell Aufmerksamkeit, insbesondere weil darin ein entscheidendes Detail über Mangione falsch gemeldet wurde, dem vorgeworfen wird, am 4. Dezember den ehemaligen CEO von UnitedHealthcare, Brian Thompson, getötet zu haben. BBCdas keine Informationen darüber veröffentlicht hatte, dass Mangione sich angeblich selbst erschossen hatte, reichte eine Beschwerde bei Apple ein. Das Netzwerk forderte Apple inzwischen auf, sein generatives KI-Tool zu überdenken.

Das zugrunde liegende Problem scheint auf die von Apple Intelligence verwendeten Sprachmodelle (LLMs) zurückzuführen zu sein. Entsprechend Die StraßeKomninos Chatzipapas, Direktor bei Orion AI Solutions, „LLMs wie GPT-4o … haben nicht wirklich ein inhärentes Verständnis dafür, was wahr ist und was nicht.“ Diese Modelle sagen die nächsten Wörter anhand umfangreicher Datensätze statistisch voraus. Diese Methode kann jedoch zu zuverlässig klingenden Inhalten führen, die Fakten falsch darstellen. In diesem Fall vermutete Chatzipapas, dass Apple sein Zusammenfassungsmodell möglicherweise versehentlich mit ähnlichen Beispielen trainiert hat, bei denen sich Einzelpersonen selbst erschossen haben, was zu der irreführenden Schlagzeile führte.

Die Auswirkungen dieses Vorfalls gehen über die internen Praktiken von Apple hinaus. Reporter ohne Grenzen hat das Unternehmen aufgefordert, die Zusammenfassungsfunktion zu entfernen, und betont, wie schwerwiegend die Verbreitung unrichtiger Informationen im Zusammenhang mit seriösen Medienunternehmen sei. Vincent Berthier von Reporter ohne Grenzen artikuliert Bedenken hinsichtlich KI-generierter Fehlinformationen, die die Glaubwürdigkeit von Nachrichtenquellen beeinträchtigen könnten. Er erklärte: „KIs sind Wahrscheinlichkeitsmaschinen, und Fakten können nicht durch einen Würfelwurf entschieden werden.“ Dies bestärkt das Argument, dass KI-Modellen derzeit nicht die erforderliche Reife für eine zuverlässige Nachrichtenverbreitung fehlt.

Lassen Sie nicht zu, dass die KI vom Schmerz und der Trauer der Familien profitiert

Dieser Vorfall ist kein Einzelfall. Seit der Einführung von Apple Intelligence in den USA im Juni haben Benutzer weitere Ungenauigkeiten gemeldet, darunter eine Benachrichtigung, in der fälschlicherweise angegeben wurde, dass der israelische Premierminister Benjamin Netanyahu verhaftet worden sei. Obwohl der Internationale Strafgerichtshof einen Haftbefehl gegen Netanyahu erlassen hat, wurde in der Benachrichtigung ein entscheidender Kontext weggelassen und nur der Satz „Netanyahu verhaftet“ angezeigt.

Die Kontroverse um Apple Intelligence offenbart Herausforderungen im Zusammenhang mit der Autonomie von Nachrichtenverlegern im Zeitalter der KI. Während einige Medienorganisationen aktiv KI-Tools zum Verfassen und Berichten einsetzen, erhalten Benutzer der Apple-Funktion Zusammenfassungen, die möglicherweise Fakten falsch darstellen, und das alles unter dem Namen des Herausgebers. Dieses Prinzip könnte umfassendere Auswirkungen darauf haben, wie Informationen im digitalen Zeitalter gemeldet und wahrgenommen werden.

Apple hat noch nicht auf Anfragen zu seinem Überprüfungsprozess oder den diesbezüglich geplanten Schritten geantwortet BBCs Anliegen. Die aktuelle Landschaft der KI-Technologie, die maßgeblich durch die Einführung von Plattformen wie ChatGPT geprägt ist, hat schnelle Innovationen vorangetrieben, schafft aber auch einen fruchtbaren Boden für Ungenauigkeiten, die die Öffentlichkeit irreführen können. Während die Untersuchungen zu KI-generierten Inhalten und ihren Auswirkungen fortgesetzt werden, wird die Gewährleistung von Zuverlässigkeit und Genauigkeit immer wichtiger.

Hervorgehobener Bildnachweis: Maxim Hopman/Unsplash