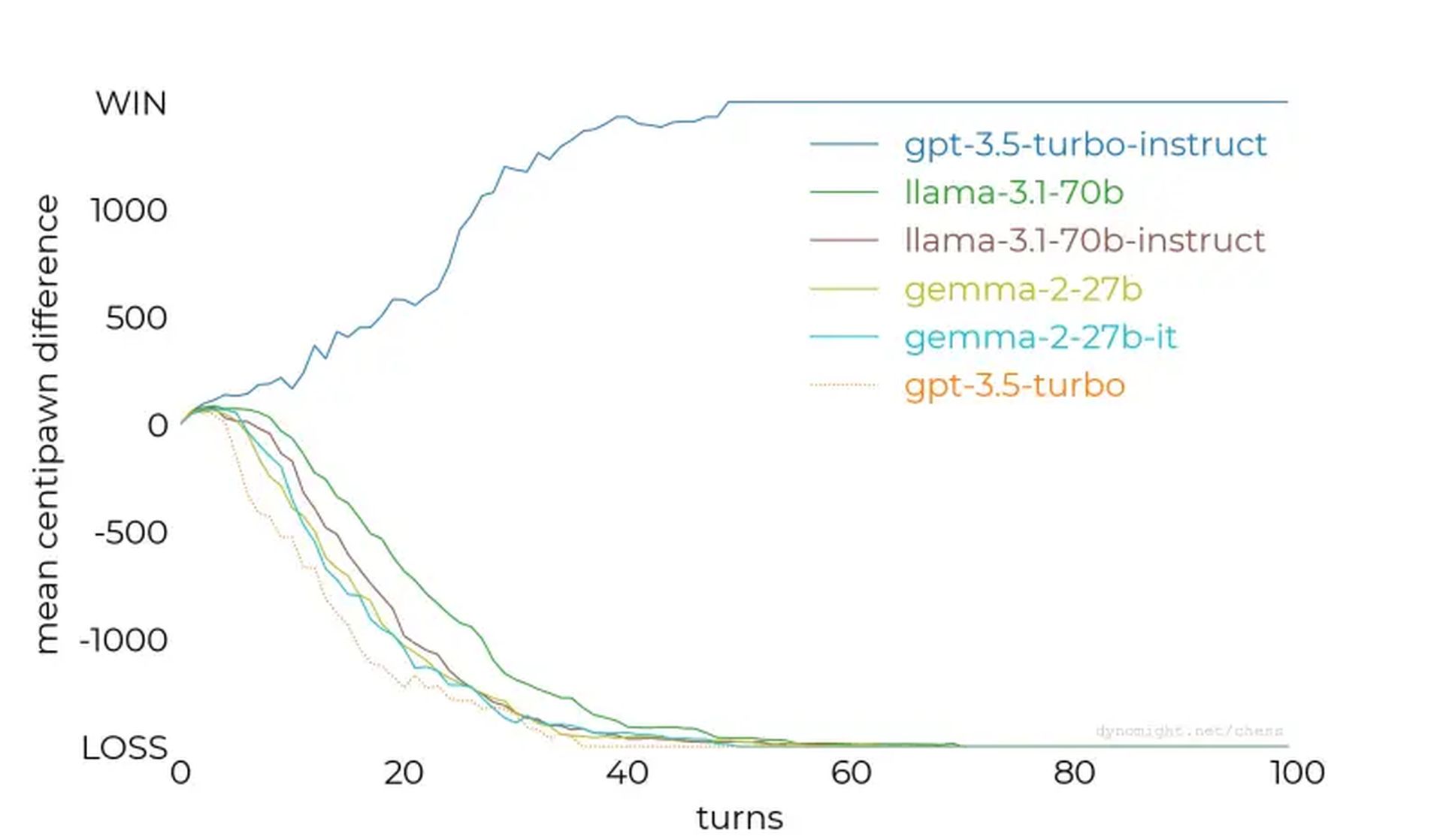

- Nicht alle LLMs sind gleich: GPT-3.5-turbo-instruct sticht als das leistungsfähigste Schachspielmodell hervor, das getestet wurde.

- Feinabstimmung ist entscheidend: Durch die Optimierung von Anweisungen und die gezielte Bereitstellung von Datensätzen wird die Leistung in bestimmten Bereichen erheblich verbessert.

- Schach als Maßstab: Das Experiment hebt Schach als wertvollen Maßstab für die Bewertung der LLM-Fähigkeiten und die Verfeinerung von KI-Systemen hervor.

Können KI-Sprachmodelle Schach spielen? Diese Frage löste kürzlich eine Untersuchung darüber aus, wie gut große Sprachmodelle (LLMs) Schachaufgaben bewältigen, und enthüllte unerwartete Erkenntnisse über ihre Stärken, Schwächen und Trainingsmethoden.

Während einige Modelle selbst gegen die einfachsten Schach-Engines scheiterten, zeigten andere – wie GPT-3.5-turbo-instruct von OpenAI – überraschendes Potenzial und deuteten auf faszinierende Implikationen für die KI-Entwicklung hin.

Testen von LLMs gegen Schach-Engines

Die Forscher testeten verschiedene LLMs, indem sie sie aufforderten, als Großmeister Schach zu spielen und Spielzustände in algebraischer Notation anzugeben. Die anfängliche Aufregung konzentrierte sich auf die Frage, ob LLMs, die auf riesigen Textkorpora trainiert wurden, eingebettetes Schachwissen nutzen könnten, um Züge effektiv vorherzusagen.

Die Ergebnisse zeigten dies jedoch Nicht alle LLMs sind gleich.

Der Studie begann mit kleineren Modellen wie Lama-3.2-3bdas 3 Milliarden Parameter hat. Nach 50 Spielen gegen den niedrigsten Schwierigkeitsgrad von Stockfish verlor das Modell jedes Spiel, da es ihm nicht gelang, seine Figuren zu schützen oder eine günstige Brettposition beizubehalten.

Die Tests wurden auf größere Modelle ausgeweitet, z Lama-3.1-70b und seine auf Anweisungen abgestimmte Variante, aber auch sie hatten Probleme und zeigten nur geringfügige Verbesserungen. Andere Modelle, darunter Qwen-2.5-72b Und command-r-v01setzte den Trend fort und offenbarte eine allgemeine Unfähigkeit, auch nur grundlegende Schachstrategien zu verstehen.

GPT-3.5-turbo-instruct war der unerwartete Gewinner

Der Wendepunkt kam mit GPT-3.5-Turbo-Anweisungdas sich gegen Stockfish durchsetzte – selbst wenn der Schwierigkeitsgrad der Engine erhöht wurde. Im Gegensatz zu chatorientierten Gegenstücken wie gpt-3.5-turbo Und gpt-4odas auf Anweisungen abgestimmte Modell produzierte durchweg Gewinnzüge.

Warum übertreffen manche Modelle, während andere scheitern?

Die wichtigsten Ergebnisse der Forschung lieferten wertvolle Erkenntnisse:

- Anweisungen zur Abstimmung sind wichtig: Modelle wie GPT-3.5-turbo-instruct profitierten von der Feinabstimmung des menschlichen Feedbacks, was ihre Fähigkeit verbesserte, strukturierte Aufgaben wie Schach zu verarbeiten.

- Datensatzexposition: Es gibt Spekulationen darüber, dass Instructor-Modelle möglicherweise einem umfangreicheren Datensatz von Schachpartien ausgesetzt waren, was ihnen überlegene strategische Überlegungen ermöglichte.

- Herausforderungen bei der Tokenisierung: Kleine Nuancen, wie falsche Leerzeichen in Eingabeaufforderungen, beeinträchtigten die Leistung und verdeutlichten die Empfindlichkeit von LLMs gegenüber Eingabeformatierungen.

- Konkurrierende Dateneinflüsse: Das Training von LLMs mit unterschiedlichen Datensätzen kann ihre Fähigkeit beeinträchtigen, bei speziellen Aufgaben wie Schach hervorragende Leistungen zu erbringen, sofern dies nicht durch eine gezielte Feinabstimmung ausgeglichen wird.

Während sich die KI weiter verbessert, werden diese Erkenntnisse Strategien zur Verbesserung der Modellleistung in allen Disziplinen liefern. Ob es um Schach, das Verstehen natürlicher Sprache oder andere komplizierte Aufgaben geht: Um ihr volles Potenzial auszuschöpfen, ist es wichtig zu verstehen, wie man KI trainiert und optimiert.

Hervorgehobener Bildnachweis: Piotr Makowski/Unsplash