OpenAI Orion, das KI-Modell der nächsten Generation des Unternehmens, stößt an Leistungsgrenzen, die Einschränkungen bei herkömmlichen Skalierungsansätzen aufdecken. Mit der Angelegenheit vertraute Quellen zeigen, dass Orion geringere Leistungssteigerungen als seine Vorgänger liefert, was OpenAI dazu veranlasst, seine Entwicklungsstrategie zu überdenken.

Frühe Tests zeigen stagnierende Verbesserungen

Erste Mitarbeitertests deuten darauf hin OpenAI Orion erreichte eine Leistung auf GPT-4-Niveau, nachdem er nur 20 % seines Trainings absolviert hatte. Auch wenn dies beeindruckend klingen mag, ist es wichtig zu beachten, dass frühe Phasen des KI-Trainings in der Regel die dramatischsten Verbesserungen bringen. Es ist unwahrscheinlich, dass die verbleibenden 80 % des Trainings zu nennenswerten Fortschritten führen werden, was darauf hindeutet, dass OpenAI Orion GPT-4 möglicherweise nicht bei weitem übertreffen wird.

„Einige Forscher des Unternehmens glauben, dass Orion bei der Bewältigung bestimmter Aufgaben nicht zuverlässig besser ist als sein Vorgänger“, berichtete er Die Informationen. „Laut einem OpenAI-Mitarbeiter schneidet Orion bei Sprachaufgaben besser ab, übertrifft aber möglicherweise frühere Modelle bei Aufgaben wie dem Codieren nicht.“

Das Dilemma der Datenknappheit

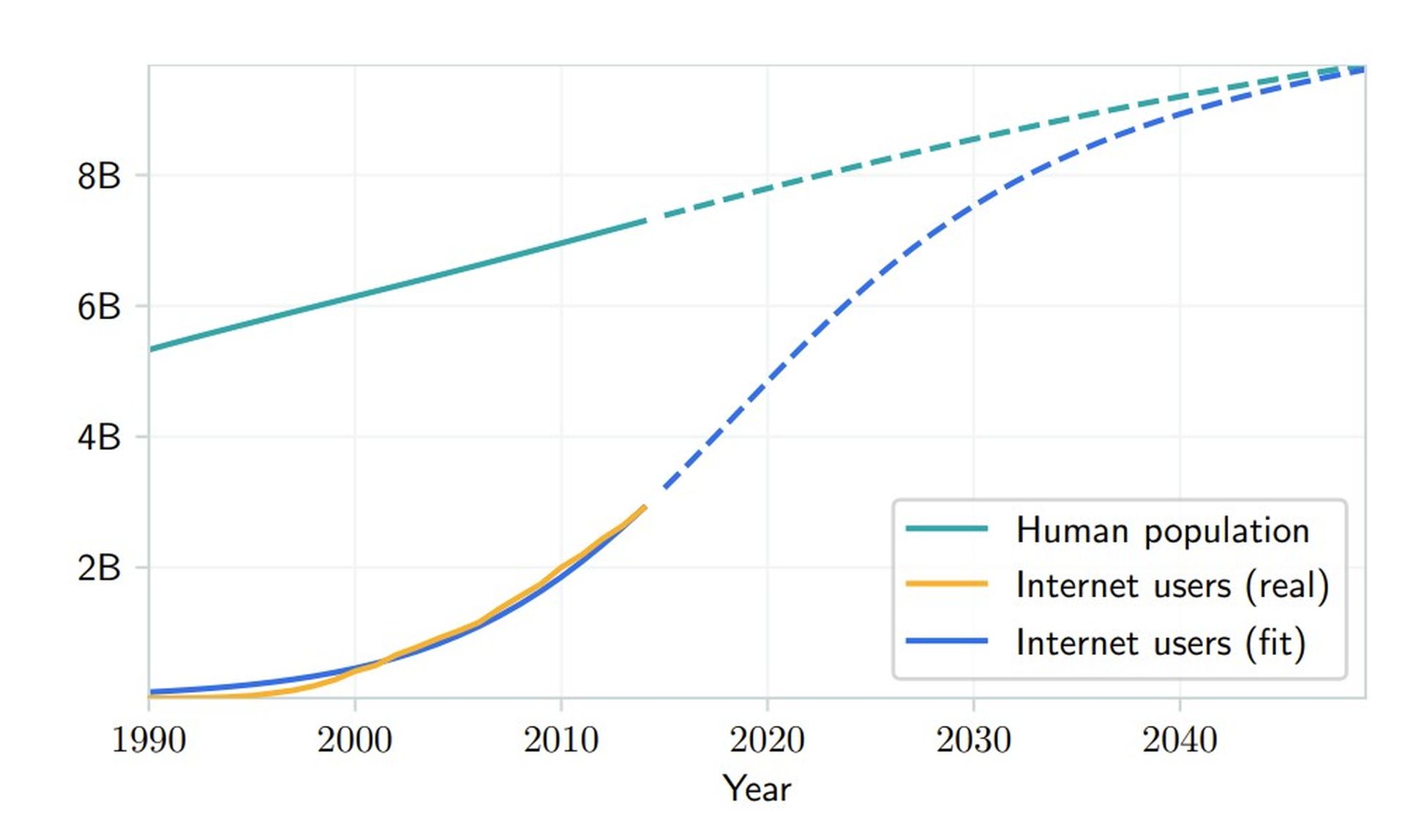

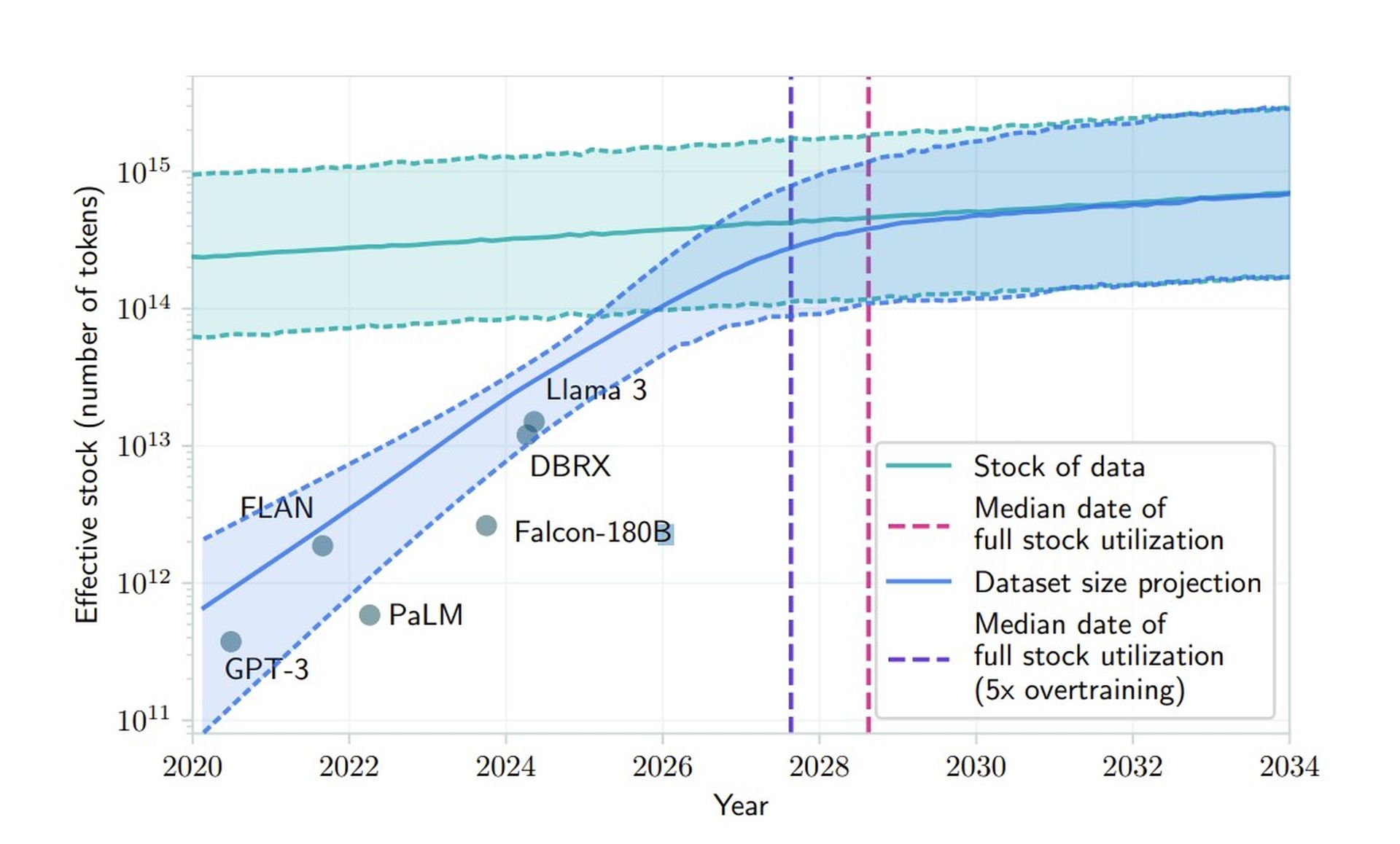

Die Herausforderungen von OpenAI mit Orion verdeutlichen ein grundlegendes Problem in der KI-Branche: das schwindende Angebot an hochwertigen Trainingsdaten. Eine im Juni veröffentlichte Studie geht davon aus, dass KI-Unternehmen zwischen 2026 und 2032 die verfügbaren öffentlichen, von Menschen generierten Textdaten erschöpfen werden. Diese Knappheit stellt einen kritischen Wendepunkt für traditionelle Entwicklungsansätze dar und zwingt Unternehmen wie OpenAI, alternative Methoden zu erkunden.

„Unsere Ergebnisse deuten darauf hin, dass die aktuellen LLM-Entwicklungstrends nicht durch herkömmliche Datenskalierung allein aufrechterhalten werden können“, heißt es in der Studie Papierzustände. Dies unterstreicht die Notwendigkeit der Generierung synthetischer Daten, des Transferlernens und der Verwendung nicht öffentlicher Daten zur Verbesserung der Modellleistung.

Die zweigleisige Entwicklungsstrategie von OpenAI

Um diese Herausforderungen zu bewältigen, restrukturiert OpenAI seinen Ansatz, indem es die Modellentwicklung in zwei unterschiedliche Bereiche unterteilt. Die O-Serie mit dem Codenamen Strawberry konzentriert sich auf Argumentationsfähigkeiten und stellt eine neue Richtung in der Modellarchitektur dar. Diese Modelle arbeiten mit deutlich höherer Rechenintensität und sind explizit auf komplexe Problemlösungsaufgaben ausgelegt.

Parallel dazu entwickeln sich die Orion-Modelle – oder die GPT-Serie – weiter und konzentrieren sich auf allgemeine Sprachverarbeitungs- und Kommunikationsaufgaben. Kevin Weil, Chief Product Officer von OpenAI, bestätigte diese Strategie während einer AMA und erklärte: „Es ist kein Entweder-oder, es ist beides – bessere Basismodelle plus mehr Erdbeer-Skalierungs-/Inferenzzeitberechnung.“

Synthetische Daten: Ein zweischneidiges Schwert

OpenAI erforscht die Generierung synthetischer Daten, um der Datenknappheit für OpenAI Orion entgegenzuwirken. Diese Lösung führt jedoch zu neuen Komplikationen bei der Aufrechterhaltung der Modellqualität und -zuverlässigkeit. Trainingsmodelle für KI-generierte Inhalte können zu Rückkopplungsschleifen führen, die subtile Unvollkommenheiten verstärken und so einen verstärkenden Effekt erzeugen, der immer schwieriger zu erkennen und zu korrigieren ist.

Forscher haben herausgefunden, dass eine starke Abhängigkeit von synthetischen Daten dazu führen kann, dass sich Modelle im Laufe der Zeit verschlechtern. Das Foundations-Team von OpenAI entwickelt neue Filtermechanismen zur Aufrechterhaltung der Datenqualität und implementiert Validierungstechniken, um zwischen hochwertigen und potenziell problematischen synthetischen Inhalten zu unterscheiden. Sie erforschen auch hybride Trainingsansätze, die von Menschen und KI generierte Inhalte kombinieren, um den Nutzen zu maximieren und gleichzeitig die Nachteile zu minimieren.

OpenAI Orion befindet sich noch in einem frühen Stadium und es stehen noch erhebliche Entwicklungsarbeiten bevor. CEO Sam Altman hat angedeutet, dass es weder in diesem noch im nächsten Jahr einsatzbereit sein wird. Dieser verlängerte Zeitrahmen könnte sich als vorteilhaft erweisen und es Forschern ermöglichen, aktuelle Einschränkungen zu beseitigen und neue Methoden zur Modellverbesserung zu entdecken.

Angesichts der gestiegenen Erwartungen nach einer jüngsten Finanzierungsrunde in Höhe von 6,6 Milliarden US-Dollar möchte OpenAI diese Herausforderungen durch eine Innovation seiner Entwicklungsstrategie meistern. Durch die direkte Bewältigung des Datenknappheitsdilemmas hofft das Unternehmen sicherzustellen, dass OpenAI Orion bei seiner endgültigen Veröffentlichung einen erheblichen Einfluss haben wird.

Hervorgehobener Bildnachweis: Jonathan Kemper/Unsplash