KI auf dem Gerät und die Ausführung großer Sprachmodelle auf kleineren Geräten waren in den letzten Jahren einer der Hauptschwerpunkte für KI-Branchenführer. Dieser Forschungsbereich gehört zu den kritischsten in der KI und hat das Potenzial, die Rolle von KI, Computern und mobilen Geräten im Alltag tiefgreifend zu beeinflussen und neu zu gestalten. Diese Forschung findet hinter den Kulissen statt, weitgehend unsichtbar für Benutzer, spiegelt jedoch die Entwicklung von Computern wider – von Maschinen, die einst ganze Räume einnahmen und nur für Regierungen und große Unternehmen zugänglich waren, bis hin zu Smartphones, die heute bequem in unseren Taschen versteckt sind.

Heutzutage werden die meisten großen Sprachmodelle in Cloud-Umgebungen bereitgestellt, wo sie die immensen Rechenressourcen von Rechenzentren nutzen können. Diese Rechenzentren sind mit spezieller Hardware wie GPUs und TPUs oder sogar speziellen KI-Chips ausgestattet, die für die Bewältigung der intensiven Arbeitslasten konzipiert sind, die LLMs erfordern. Doch diese Abhängigkeit von der Cloud bringt erhebliche Herausforderungen mit sich:

Hohe Kosten: Cloud-Dienste sind teuer. Der Betrieb von LLMs im großen Maßstab erfordert einen kontinuierlichen Zugriff auf leistungsstarke Server, was die Betriebskosten in die Höhe treiben kann. Für Start-ups oder einzelne Ingenieure können diese Kosten unerschwinglich sein und einschränken, wer diese leistungsstarke Technologie realistisch nutzen kann.

Datenschutzbedenken: Wenn Benutzer mit cloudbasierten LLMs interagieren, müssen ihre Daten zur Verarbeitung an Remote-Server gesendet werden. Dies stellt eine potenzielle Sicherheitslücke dar, da vertrauliche Informationen wie persönliche Gespräche, Suchverläufe oder Finanzdaten abgefangen oder falsch verarbeitet werden könnten.

Umweltauswirkungen: Cloud Computing in dieser Größenordnung verbraucht enorme Mengen an Energie. Rechenzentren benötigen nicht nur für die Rechenleistung kontinuierlich Strom, sondern auch für die Kühlung und Wartung der Infrastruktur, was zu einem erheblichen CO2-Fußabdruck führt. Angesichts des weltweiten Strebens nach Nachhaltigkeit muss dieses Problem angegangen werden. Zum Beispiel ein aktueller Bericht von Google zeigte ein Anstieg der Treibhausgasemissionen um 48 % in den letzten fünf Jahren, was einen großen Teil dieses Anstiegs auf die wachsenden Anforderungen der KI-Technologie zurückführt.

Aus diesem Grund rückt dieses Problem weiterhin in den Fokus von Branchenführern, die erhebliche Ressourcen investieren, um das Problem anzugehen, sowie von kleineren Forschungszentren und Open-Source-Communities. Die ideale Lösung bestünde darin, Benutzern die Möglichkeit zu geben, diese leistungsstarken Modelle direkt auf ihren Geräten auszuführen, ohne dass eine ständige Cloud-Konnektivität erforderlich ist. Dies könnte die Kosten senken, den Datenschutz verbessern und die mit KI verbundenen Umweltauswirkungen verringern. Aber das ist leichter gesagt als getan.

Den meisten persönlichen Geräten, insbesondere Smartphones, fehlt die Rechenleistung, um umfassende LLMs auszuführen. Beispielsweise ist ein iPhone mit 6 GB RAM oder ein Android-Gerät mit bis zu 12 GB RAM den Fähigkeiten von Cloud-Servern nicht gewachsen. Selbst das kleinste LLM von Meta, LLaMA-3.1 8B, benötigt mindestens 16 GB RAM – und realistischerweise ist mehr erforderlich, um eine ordentliche Leistung zu erzielen, ohne das Telefon zu überlasten. Trotz der Fortschritte bei mobilen Prozessoren ist der Leistungsunterschied immer noch erheblich.

Aus diesem Grund konzentriert sich die Branche auf die Optimierung dieser Modelle – um sie kleiner, schneller und effizienter zu machen, ohne zu große Einbußen bei der Leistung hinnehmen zu müssen.

In diesem Artikel werden wichtige aktuelle Forschungsarbeiten und Methoden zur Erreichung dieses Ziels untersucht und hervorgehoben, wo das Gebiet derzeit steht:

- Metas MobileLLM: Optimierung von Submilliarden-Parametersprachenmodellen für Anwendungsfälle auf dem Gerät

- Huaweis Kronecker-Zerlegungsmethode für die GPT-Komprimierung

- „TQCompressor: Verbesserung von Tensorzerlegungsmethoden in neuronalen Netzen durch Permutationen„, ein aktuelles Open-Source-Projekt und Forschungspapier, das die Kronecker-Zerlegungsmethode verbesserte und es ermöglichte, GPT-Modelle um das 1,5-fache zu komprimieren, ohne den Zeitaufwand wesentlich zu erhöhen, eine Studie, an der ich als Co-Autor beteiligt war.

Metas Ansatz zum Entwerfen von LLMs für Anwendungsfälle auf Geräten

In diesem Sommer führten Meta-KI-Forscher eine neue Möglichkeit ein, effiziente Sprachmodelle speziell für Smartphones und andere Geräte mit begrenzten Ressourcen zu erstellen, und veröffentlichten ein Modell namens MobileLLM, das auf diesem Ansatz basiert.

Anstatt sich auf Modelle mit Milliarden oder sogar Billionen Parametern zu verlassen – wie GPT-4 – konzentrierte sich Metas Team auf die Optimierung von Modellen mit weniger als 1 Milliarde Parametern.

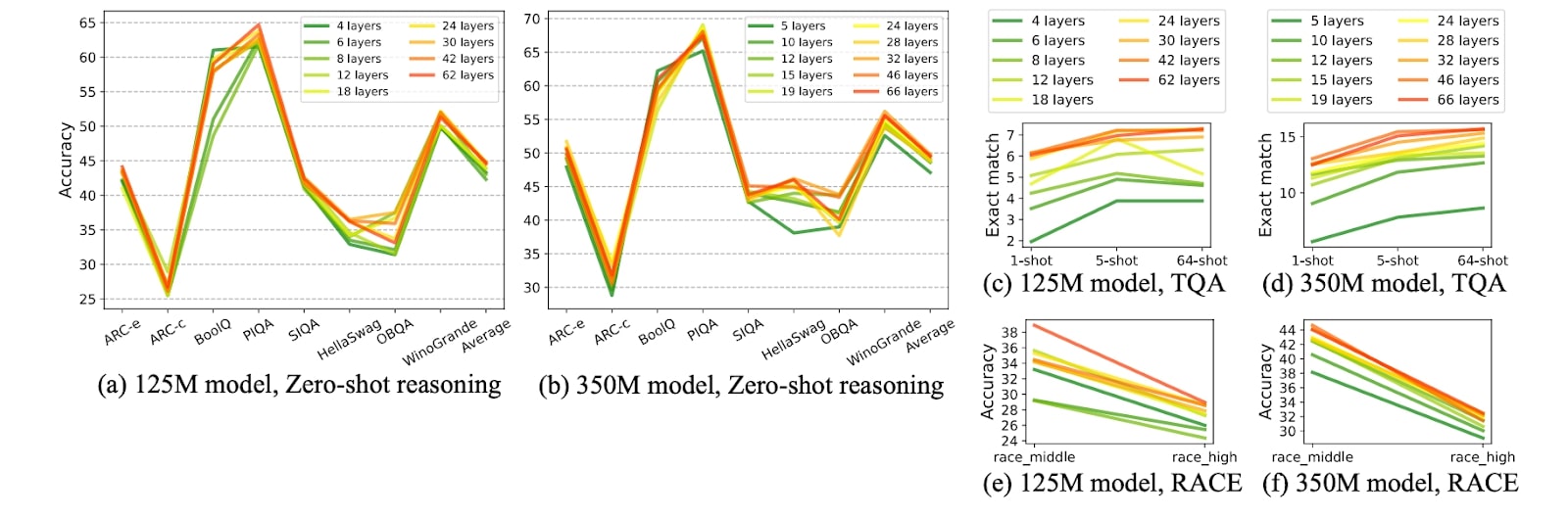

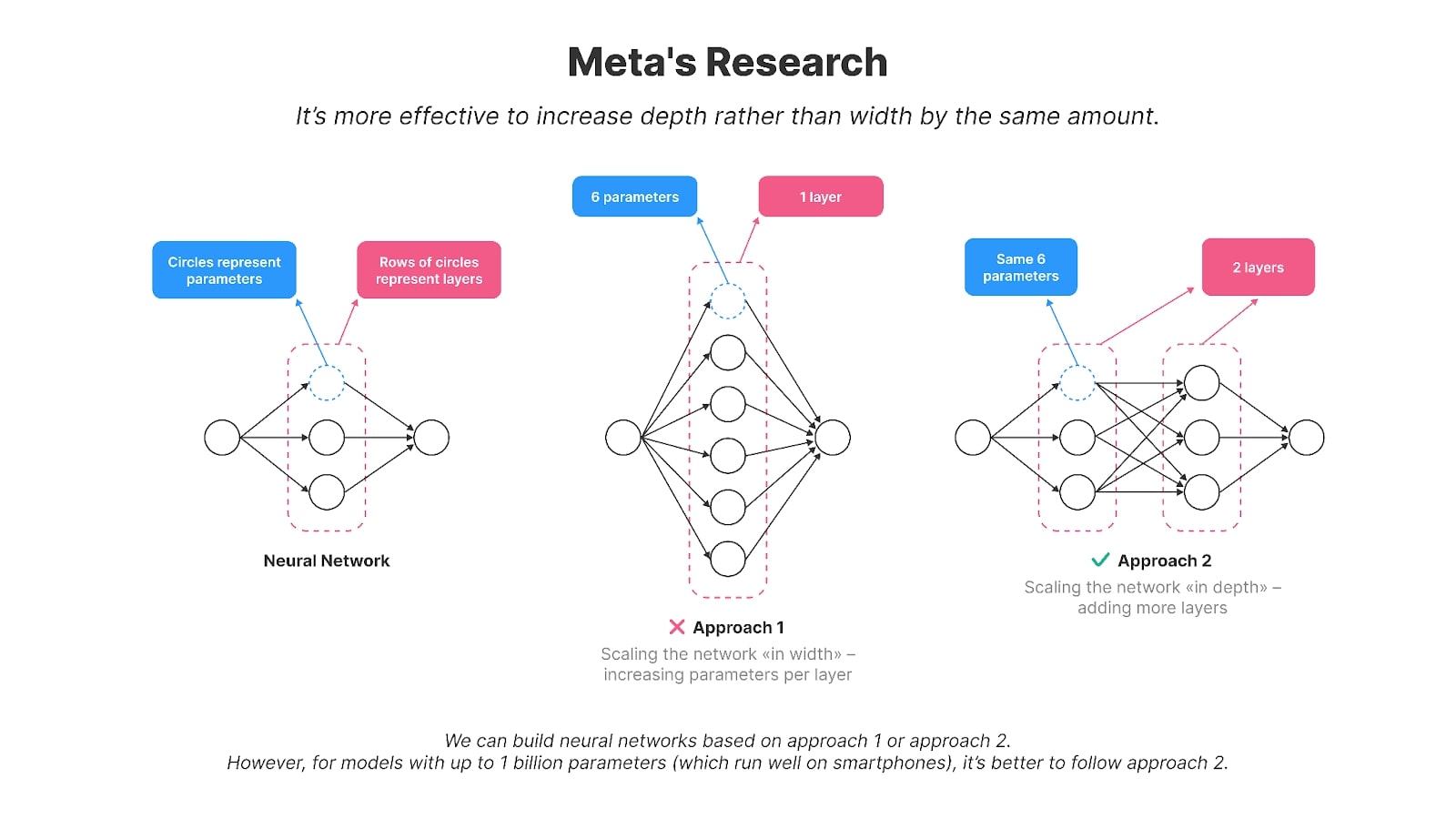

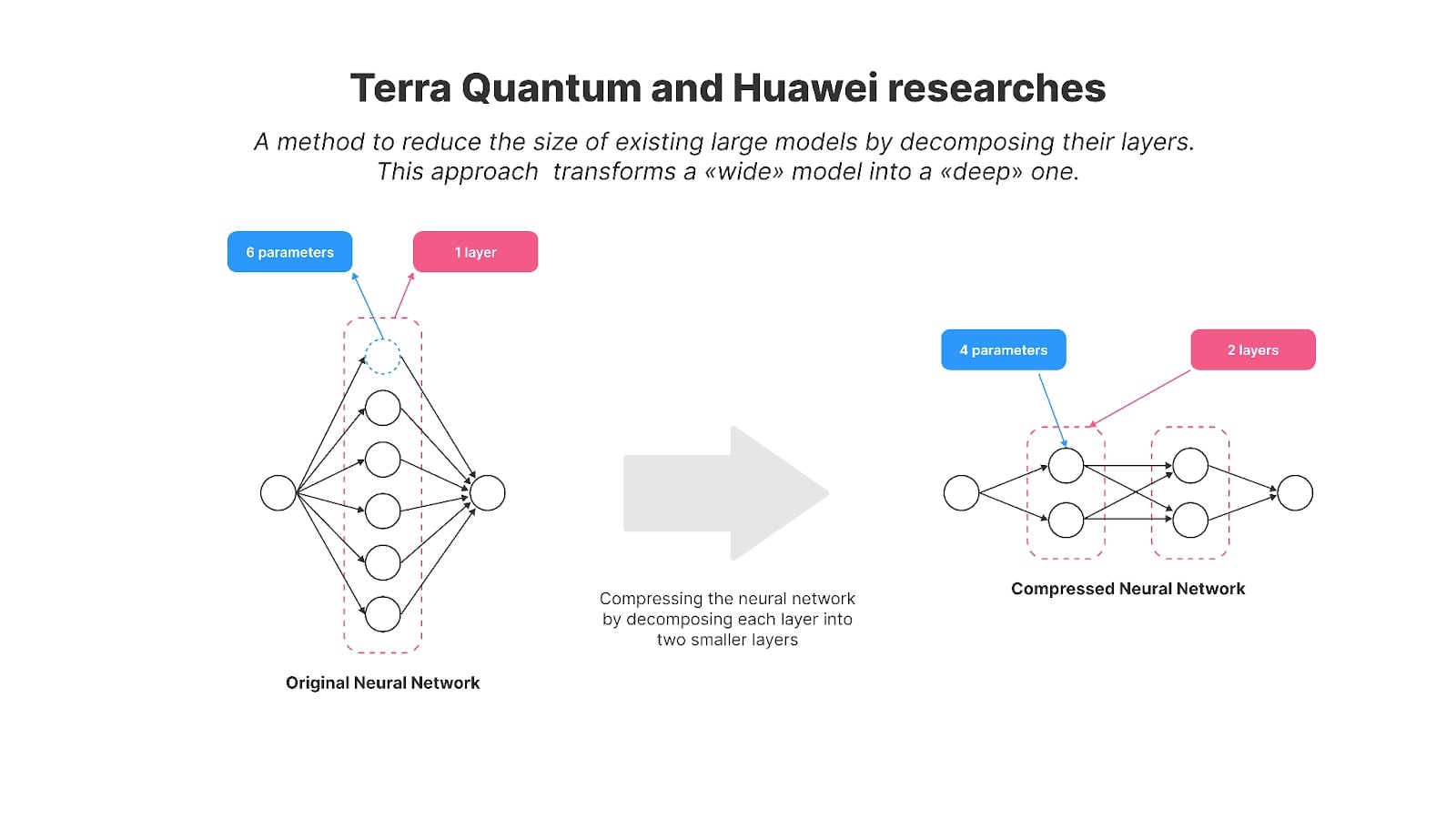

Die Autoren fanden heraus, dass die Skalierung des Modells „in die Tiefe“ besser funktioniert als die Skalierung in die Breite bei kleineren Modellen mit bis zu oder etwa 1 Milliarde Parametern, wodurch sie besser für Smartphones geeignet sind. Mit anderen Worten: Es ist effektiver, eine größere Anzahl kleinerer Schichten zu haben als nur wenige große. Beispielsweise hat ihr 125-Millionen-Parameter-Modell, MobileLLM, 30 Schichten, während Modelle wie GPT-2, BERT und die meisten Modelle mit 100–200 Millionen Parametern typischerweise etwa 12 Schichten haben. Modelle mit der gleichen Anzahl an Parametern, aber einer höheren Schichtanzahl (im Gegensatz zu größeren Parametern pro Schicht) zeigten bei mehreren Benchmarking-Aufgaben, wie Winogrande und Hellaswag, eine bessere Genauigkeit.

Grafiken aus Metas Forschung zeigen, dass tiefere und dünnere Modelle bei vergleichbaren Modellgrößen im Allgemeinen ihre breiteren und flacheren Gegenstücke bei verschiedenen Aufgaben übertreffen, wie z. B. beim gesunden Menschenverstandsdenken, bei der Beantwortung von Fragen und beim Leseverständnis.

Bildnachweis: MobileLLM: Optimierung von Submilliarden-Parametersprachenmodellen für Anwendungsfälle auf dem Gerät

Die gemeinsame Nutzung von Ebenen ist eine weitere Technik, die in der Forschung verwendet wird, um Parameter zu reduzieren und die Effizienz zu verbessern. Anstatt Schichten innerhalb des neuronalen Netzwerks zu duplizieren, werden die Gewichte einer einzelnen Schicht mehrfach wiederverwendet. Beispielsweise kann nach der Berechnung der Ausgabe einer Schicht diese wieder in die Eingabe derselben Schicht eingespeist werden. Dieser Ansatz reduziert effektiv die Anzahl der Parameter, da bei der herkömmlichen Methode die Ebene mehrmals dupliziert werden müsste. Durch die Wiederverwendung von Schichten erzielten sie erhebliche Effizienzsteigerungen ohne Leistungseinbußen.

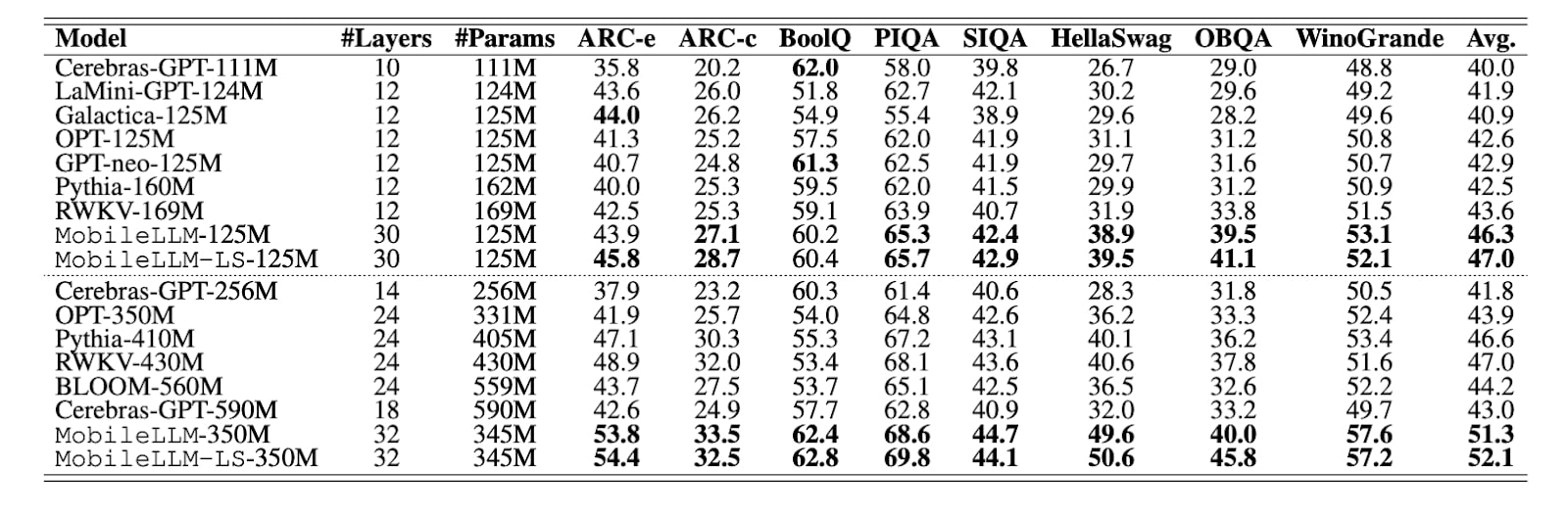

Wie aus der Tabelle der Untersuchung hervorgeht, haben andere Modelle mit 125M-Parametern typischerweise 10–12 Schichten, während MobileLLM 30 hat. MobileLLM übertrifft die anderen bei den meisten Benchmarks (wobei der Benchmark-Spitzenreiter fett hervorgehoben ist).

Bildnachweis: MobileLLM: Optimierung von Submilliarden-Parametersprachenmodellen für Anwendungsfälle auf dem Gerät

In ihrem Artikel stellte Meta das MobileLLM-Modell in zwei Versionen vor – 125 Millionen und 350 Millionen Parameter. Sie haben den Schulungscode für MobileLLM unter öffentlich zugänglich gemacht GitHub. Später veröffentlichte Meta auch 600 Millionen, 1 Milliarde und 1,5 Milliarden Versionen des Modells.

Diese Modelle zeigten beeindruckende Verbesserungen bei Aufgaben wie Zero-Shot-Denken mit gesundem Menschenverstand, Beantwortung von Fragen und Leseverständnis und übertrafen damit frühere Methoden auf dem neuesten Stand der Technik. Darüber hinaus zeigten fein abgestimmte Versionen von MobileLLM ihre Wirksamkeit in gängigen On-Device-Anwendungen wie Chat und API-Aufrufen, wodurch sie sich besonders gut für die Anforderungen mobiler Umgebungen eignen.

Metas Botschaft ist klar: Wenn wir möchten, dass Modelle auf mobilen Geräten funktionieren, müssen sie anders erstellt werden.

Aber das ist nicht oft der Fall. Nehmen Sie zum Beispiel die beliebtesten Modelle in der KI-Welt LLaMA3Qwen2 oder Gemma-2 – sie haben nicht nur viel mehr Parameter; Sie verfügen außerdem über weniger, dafür aber viel größere Schichten, was es praktisch sehr schwierig macht, diese Modelle auf mobilen Geräten auszuführen.

Komprimieren vorhandener LLMs

Metas jüngste Forschung wendet sich von der Komprimierung bestehender neuronaler Netze ab und stellt einen neuen Ansatz für die Entwicklung von Modellen speziell für Smartphones vor. Allerdings müssen Millionen von Ingenieuren weltweit, die keine Modelle von Grund auf neu erstellen – und seien wir ehrlich, das sind die meisten von ihnen – immer noch mit diesen breiten, parameterlastigen Modellen arbeiten. Komprimierung ist nicht nur eine Option; es ist eine Notwendigkeit für sie.

Hier ist die Sache: Während die Ergebnisse von Meta bahnbrechend sind, ist die Realität so, dass Open-Source-Modelle nicht unbedingt unter Berücksichtigung dieser Prinzipien erstellt werden. Die meisten hochmodernen Modelle, einschließlich Metas eigenem LLaMA, sind immer noch für große Server mit leistungsstarken GPUs konzipiert. Diese Modelle haben oft weniger, aber viel breitere Schichten. Beispielsweise hat LLaMA3 8B fast 65-mal mehr Parameter als MobileLLM-125M, obwohl beide Modelle etwa 30 Schichten haben.

Was ist also die Alternative? Sie könnten weiterhin neue Modelle von Grund auf erstellen und sie für den mobilen Einsatz anpassen. Oder Sie könnten vorhandene komprimieren.

Um diese großen, breiten Modelle für mobile Geräte effizienter zu gestalten, greifen Ingenieure häufig auf eine Reihe bewährter Komprimierungstechniken zurück. Diese Methoden sind Quantisierung, Bereinigung, Matrixzerlegung und Wissensdestillation.

Quantisierung

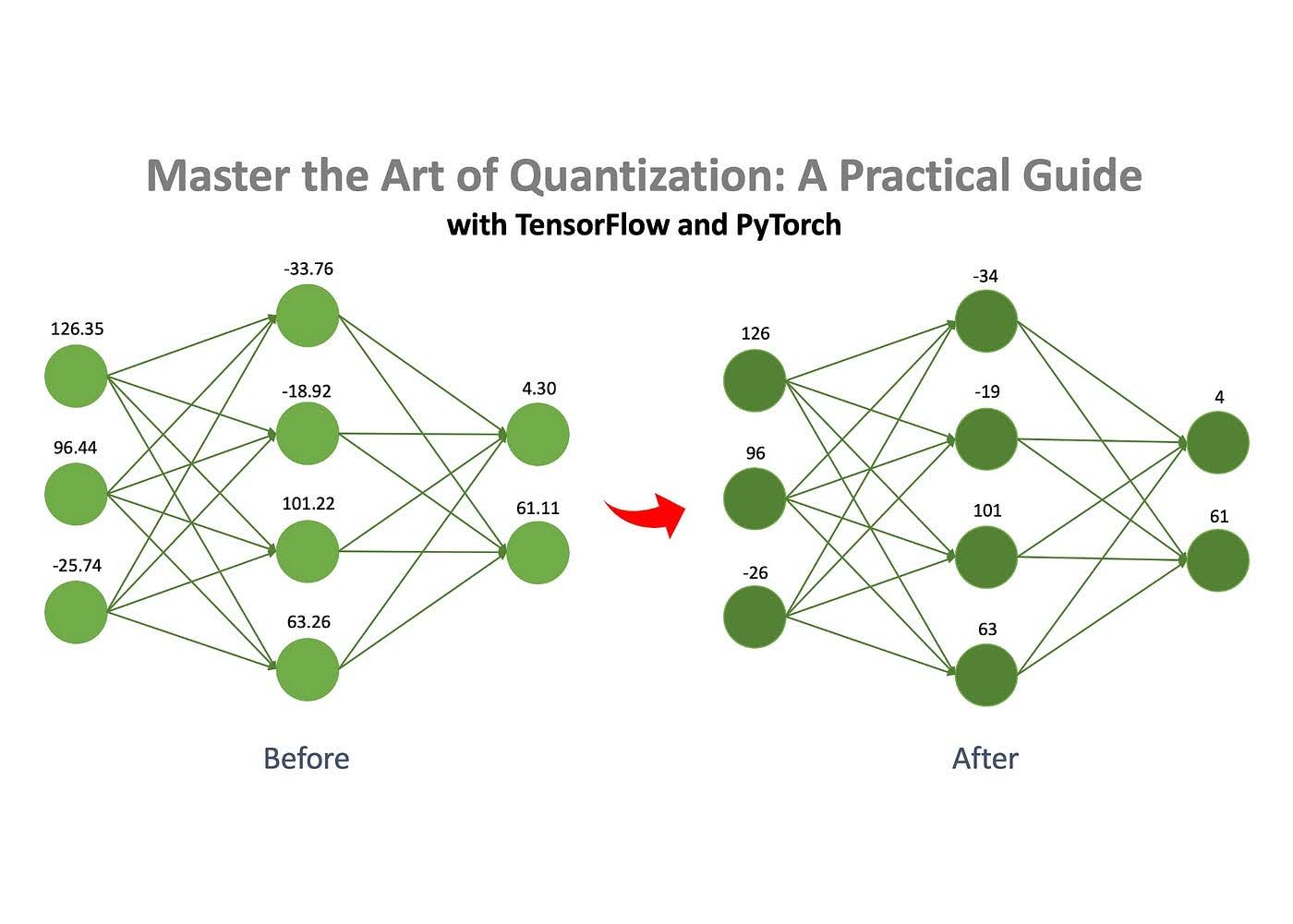

Eine der am häufigsten verwendeten Methoden zur Komprimierung neuronaler Netzwerke ist die Quantisierung, die dafür bekannt ist, einfach zu sein und die Leistung effektiv zu erhalten.

Bildnachweis: Jan Marcel Kezmann An Medium

Das Grundkonzept besteht darin, dass ein neuronales Netzwerk aus in Matrizen gespeicherten Zahlen besteht. Diese Zahlen können in verschiedenen Formaten gespeichert werden, beispielsweise als Gleitkommazahlen oder ganze Zahlen. Sie können die Größe des Modells drastisch reduzieren, indem Sie diese Zahlen von einem komplexeren Format wie float32 in ein einfacheres Format wie int8 konvertieren. Beispielsweise könnte ein Modell, das ursprünglich 100 MB beanspruchte, mithilfe der Quantisierung auf nur 25 MB komprimiert werden.

Beschneidung

Wie bereits erwähnt, besteht ein neuronales Netzwerk aus einer Reihe von Matrizen, die mit Zahlen gefüllt sind. Beim Pruning werden „unwichtige“ Zahlen, sogenannte „Gewichte“, aus diesen Matrizen entfernt.

Durch das Entfernen dieser unwichtigen Gewichte wird das Verhalten des Modells nur minimal beeinflusst, der Speicher- und Rechenbedarf wird jedoch erheblich reduziert.

Matrixzerlegung

Die Matrixzerlegung ist eine weitere effektive Technik zur Komprimierung neuronaler Netze. Die Idee besteht darin, große Matrizen im Netzwerk in kleinere, einfachere zu zerlegen (oder zu „zerlegen“). Anstatt eine gesamte Matrix zu speichern, kann sie in zwei oder mehrere kleinere Matrizen zerlegt werden. Wenn diese kleineren Matrizen miteinander multipliziert werden, ergeben sie ein Ergebnis, das dem Original entspricht oder diesem sehr nahe kommt. Dadurch können wir eine große Matrix durch kleinere ersetzen, ohne das Verhalten des Modells zu ändern. Allerdings ist diese Methode nicht fehlerfrei – manchmal können die zerlegten Matrizen das Original nicht perfekt reproduzieren, was zu einem kleinen Näherungsfehler führt. Dennoch lohnt sich der Kompromiss hinsichtlich der Effizienz oft.

Wissensdestillation

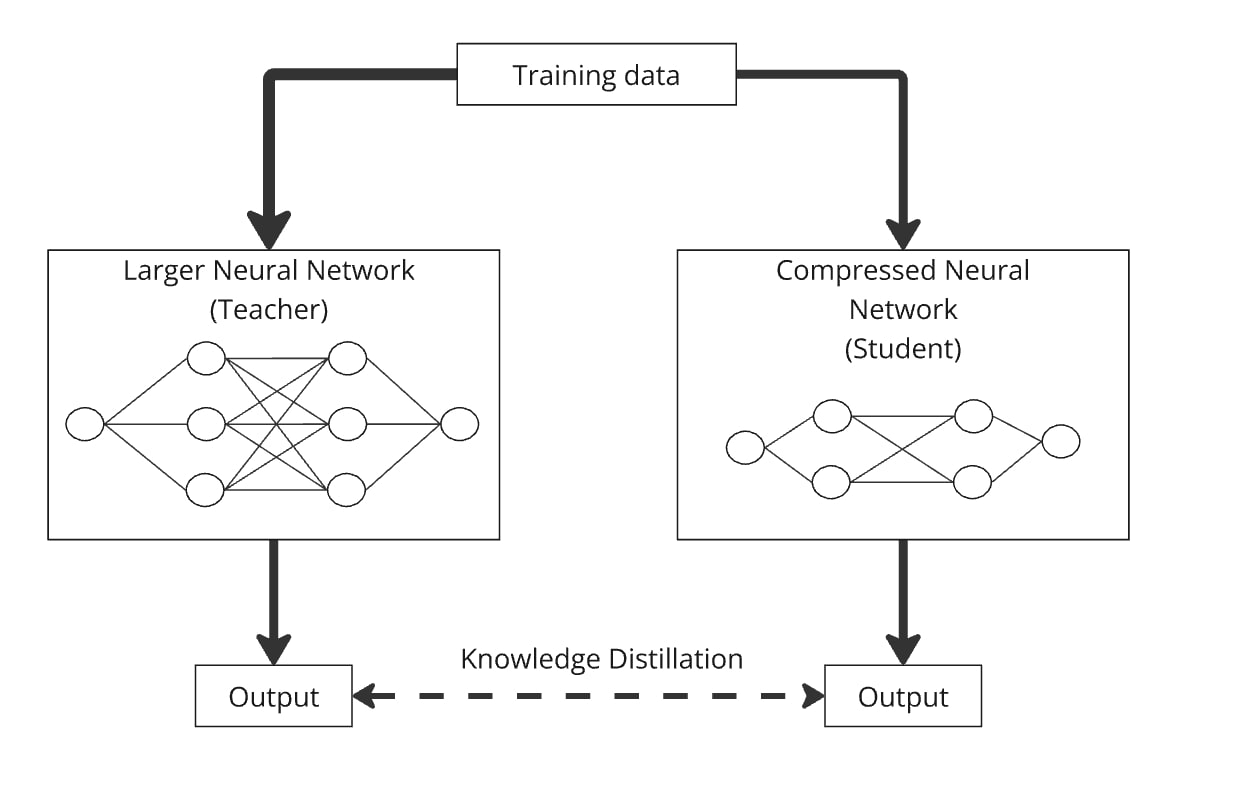

Wissensdestillation, eingeführt von Hinton et al. im Jahr 2015 ist eine einfache, aber effektive Methode zur Erstellung eines kleineren, effizienteren Modells (dem „Schülermodell“) durch die Übertragung von Wissen aus einem vorab trainierten, größeren Modell (dem „Lehrermodell“).

Mithilfe der Wissensdestillation kann ein beliebig gestaltetes kleineres Sprachmodell trainiert werden, um das Verhalten eines größeren Modells nachzuahmen. Der Prozess funktioniert, indem beide Modelle mit denselben Daten versorgt werden und das kleinere Modell lernt, ähnliche Ergebnisse wie das größere Modell zu erzeugen. Im Wesentlichen wird das Schülermodell mit dem Wissen des Lehrermodells destilliert, sodass es eine ähnliche Leistung erbringen kann, jedoch mit weitaus weniger Parametern.

Ein bemerkenswertes Beispiel ist DistilBERT (Sanh et al. 2019), das die Parameter von BERT erfolgreich um 40 % reduzierte, dabei 97 % seiner Leistung beibehielt und 71 % schneller lief.

Die Destillation kann problemlos mit Quantisierung, Bereinigung und Matrixzerlegung kombiniert werden, wobei das Lehrermodell die Originalversion und das Schülermodell die komprimierte Version ist. Diese Kombinationen tragen dazu bei, die Genauigkeit des komprimierten Modells zu verbessern. Sie könnten beispielsweise GPT-2 mithilfe der Matrixzerlegung komprimieren und dann die Wissensdestillation anwenden, um das komprimierte Modell so zu trainieren, dass es das ursprüngliche GPT-2 nachahmt.

So komprimieren Sie vorhandene Modelle für KI-Anwendungsfälle auf dem Gerät

Vor einigen Jahren konzentrierte sich Huawei auch auf die Aktivierung von KI-Modellen auf dem Gerät und veröffentlichte Forschungsergebnisse zur Komprimierung von GPT-2. Die Forscher verwendeten eine Matrixzerlegungsmethode, um die Größe des beliebten Open-Source-GPT-2-Modells für eine effizientere Nutzung auf dem Gerät zu reduzieren.

Konkret verwendeten sie eine Technik namens Kronecker-Zerlegung, die die Grundlage für ihre Arbeit mit dem Titel „Kronecker-Zerlegung für die GPT-Komprimierung“ bildet. Infolgedessen wurden die Parameter von GPT-2 von 125 Millionen auf 81 Millionen reduziert.

Um die Leistung des Modells nach der Komprimierung wiederherzustellen, verwendeten die Autoren eine Wissensdestillation. Die komprimierte Version – KnGPT-2 genannt – lernte, das Verhalten des ursprünglichen GPT-2 nachzuahmen. Sie trainierten dieses destillierte Modell mit nur 10 % des ursprünglichen Datensatzes, der zum Trainieren von GPT-2 verwendet wurde. Letztendlich verringerte sich die Modellgröße um 35 %, bei relativ geringem Leistungsverlust.

In diesem Jahr haben meine Kollegen und ich Forschungsergebnisse zu Matrixzerlegungsmethoden veröffentlicht, bei denen wir das GPT-2-Modell (mit 125 Millionen Parametern) erfolgreich auf 81 Millionen Parameter komprimiert haben. Wir haben das resultierende Modell TQCompressedGPT-2 genannt. Diese Studie hat die Methode der Kronecker-Zerlegung weiter verbessert, und mit dieser Weiterentwicklung ist es uns gelungen, während der Wissensdestillationsphase nur 3,1 % des ursprünglichen Datensatzes zu verwenden. Das bedeutet, dass wir die Trainingszeit im Vergleich zur Verwendung des vollständigen Datensatzes um etwa das 33-fache reduziert haben und dass Entwickler, die Modelle wie LLaMA3 auf Smartphones bereitstellen möchten, 33-mal weniger Zeit benötigen, um mit unserer Methode eine komprimierte Version von LLaMA3 zu erstellen.

Die Neuheit unserer Arbeit liegt in einigen Schlüsselbereichen:

- Vor der Anwendung der Komprimierung haben wir eine neue Methode eingeführt: die Permutation von Gewichtsmatrizen. Durch die Neuanordnung der Zeilen und Spalten der Schichtmatrizen vor der Zerlegung erreichten wir eine höhere Genauigkeit im komprimierten Modell.

- Wir haben die Komprimierung iterativ angewendet und dabei die Modellebenen eine nach der anderen reduziert.

Wir haben unseren Modell- und Algorithmuscode als Open Source bereitgestellt, was weitere Forschung und Entwicklung ermöglicht.

Beide Studien bringen uns dem Konzept näher, das Meta mit ihrem Ansatz für mobile LLMs eingeführt hat. Sie demonstrieren Methoden zur Umwandlung vorhandener breiter Modelle in kompaktere, tiefere Versionen mithilfe von Matrixzerlegungstechniken und zur Wiederherstellung der Leistung des komprimierten Modells durch Wissensdestillation.

Spitzenmodelle wie LLaMA, Mistral und Qwen, die deutlich mehr als 1 Milliarde Parameter haben, sind für leistungsstarke Cloud-Server und nicht für Smartphones konzipiert. Die von Huawei und unserem Team durchgeführten Untersuchungen bieten wertvolle Techniken zur Anpassung dieser großen Modelle für den mobilen Einsatz und stehen im Einklang mit Metas Vision für die Zukunft der On-Device-KI.

Die Komprimierung von KI-Modellen ist mehr als eine technische Herausforderung – sie ist ein entscheidender Schritt, um fortschrittliche Technologie für Milliarden Menschen zugänglich zu machen. Da Modelle immer komplexer werden, wird die Fähigkeit, sie effizient auf alltäglichen Geräten wie Smartphones auszuführen, von entscheidender Bedeutung. Dabei geht es nicht nur darum, Ressourcen zu schonen; Es geht darum, KI nachhaltig in unser tägliches Leben zu integrieren.

Die Fortschritte der Branche bei der Bewältigung dieser Herausforderung sind erheblich. Fortschritte von Huawei und TQ bei der Komprimierung von KI-Modellen treiben die KI in eine Zukunft, in der sie nahtlos auf kleineren Geräten ohne Leistungseinbußen ausgeführt werden kann. Dies sind entscheidende Schritte, um die KI nachhaltig an die Einschränkungen der realen Welt anzupassen und sie für jedermann zugänglicher zu machen. Damit wird eine solide Grundlage für die weitere Forschung in diesem wichtigen Bereich der Auswirkungen der KI auf die Menschheit gelegt.