OpenAI, das Unternehmen hinter ChatGPT, erweitert seine Bemühungen, zuverlässige und kostengünstige Rechenleistung für seine KI-Modelle sicherzustellen. Durch die Entwicklung maßgeschneiderter Chips möchte OpenAI die Abhängigkeit von externen Anbietern wie NVIDIA verringern, deren GPUs den Markt für KI-Chips dominieren. Entsprechend Reuters OpenAI ist eine Partnerschaft mit Broadcom eingegangen und hat sich Produktionskapazitäten mit der Taiwan Semiconductor Manufacturing Company (TSMC) gesichert, während gleichzeitig AMD-Chips in sein Microsoft Azure-Setup integriert wurden.

OpenAI baut mit Broadcom und TSMC benutzerdefinierte KI-Chips

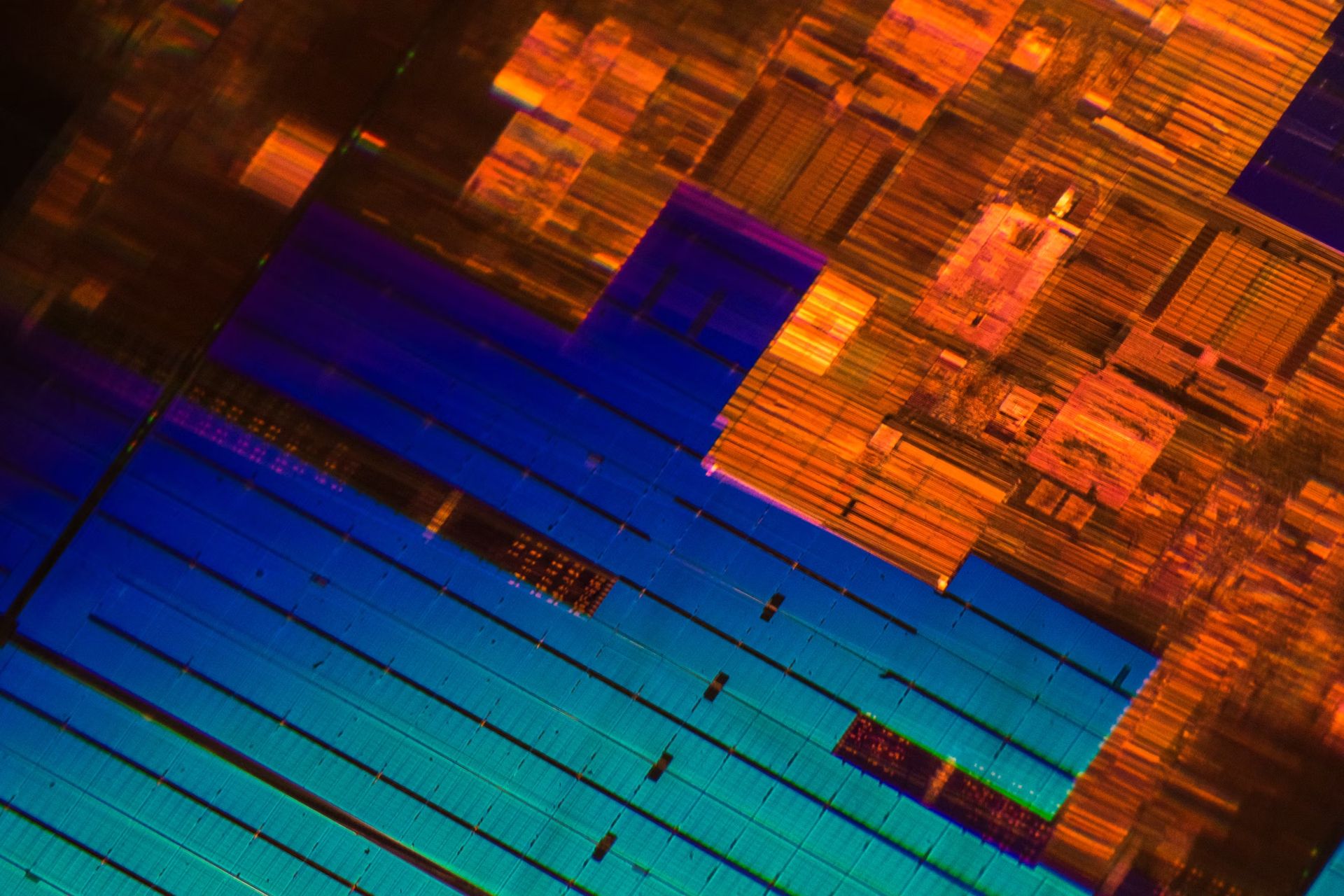

OpenAIs Weg zur Entwicklung eigener KI-Chips begann mit der Zusammenstellung eines Teams von etwa 20 Personen, darunter Top-Ingenieure, die zuvor an den Tensor Processing Units (TPUs) von Google gearbeitet hatten. Dieses interne Chip-Team unter der Leitung erfahrener Ingenieure wie Thomas Norrie und Richard Ho arbeitet eng mit Broadcom zusammen, um kundenspezifisches Silizium zu entwerfen und zu produzieren, das sich auf Inferenz-Workloads konzentriert. Die Chips sollen ab 2026 von TSMC, der weltweit größten Halbleitergießerei, hergestellt werden.

Das Ziel hinter der Entwicklung von firmeninternem Silizium ist zweierlei: die Sicherstellung einer stabilen Versorgung mit Hochleistungschips und die Bewältigung der steigenden Kosten im Zusammenhang mit KI-Arbeitslasten. Während die Nachfrage nach Trainingschips derzeit höher ist, gehen Branchenexperten davon aus, dass der Bedarf an Inferenzchips den Bedarf an Trainingschips übersteigen wird, da immer mehr KI-Anwendungen die Bereitstellungsphase erreichen. Broadcoms Fachwissen bei der Feinabstimmung von Chipdesigns für die Massenproduktion und der Bereitstellung von Komponenten zur Optimierung der Datenbewegung macht Broadcom zum idealen Partner für dieses ehrgeizige Projekt.

OpenAI hatte zuvor über den Aufbau eigener Chip-Foundries nachgedacht, entschied sich aber letztlich, diese Pläne aufgrund der immensen Kosten und des Zeitaufwands aufzugeben. Stattdessen konzentriert sich OpenAI auf die Entwicklung kundenspezifischer Chips und verlässt sich bei der Herstellung auf TSMC.

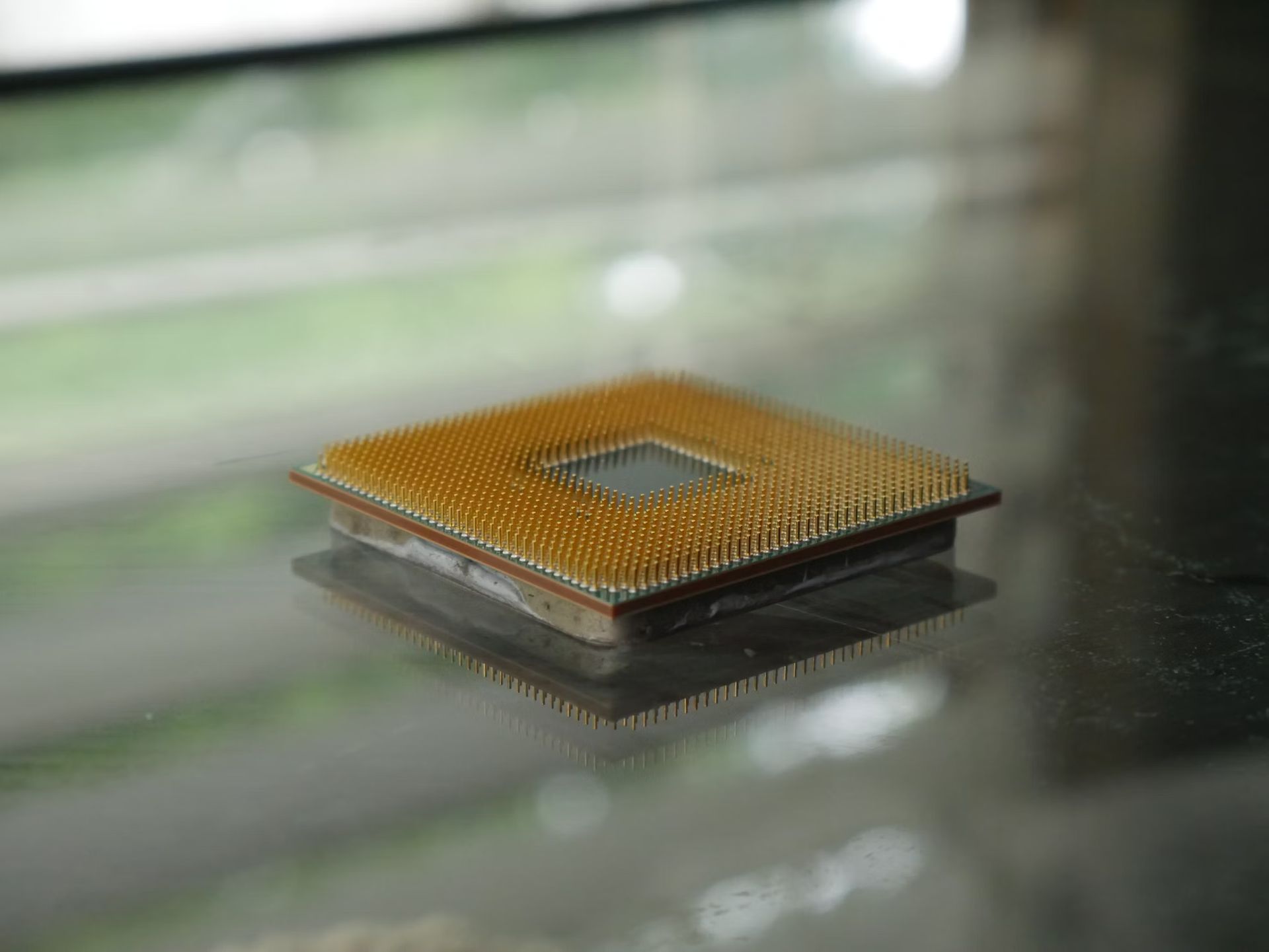

Integration von AMD-Chips zur Diversifizierung

Neben der Partnerschaft mit Broadcom integriert OpenAI auch AMDs neue MI300X Chips in sein Microsoft Azure-Setup. AMD hat diese Chips letztes Jahr im Rahmen seiner Strategie zur Erweiterung des Rechenzentrums eingeführt, mit dem Ziel, einen Teil des derzeit von NVIDIA gehaltenen Marktanteils zu erobern. Durch die Einbeziehung von AMD-Chips kann OpenAI sein Chipangebot diversifizieren, seine Abhängigkeit von einem einzigen Lieferanten verringern und zu einer effektiveren Kostenverwaltung beitragen.

Die MI300X-Chips von AMD sind Teil seines Vorstoßes, mit NVIDIA zu konkurrieren, das derzeit über 80 % des Marktanteils bei KI-Hardware hält. Die MI300X-Chips sind für die Unterstützung von KI-Arbeitslasten konzipiert, insbesondere bei Inferenz und Modelltraining. Durch die Aufnahme von AMD-Chips in seine Infrastruktur hofft OpenAI, einige der Lieferengpässe zu mildern, mit denen es bei NVIDIA-GPUs konfrontiert war, die stark nachgefragt und von Engpässen betroffen waren.

Dieser strategische Schritt ist auch eine Reaktion auf die steigenden Rechenkosten, die für OpenAI zu einer großen Herausforderung geworden sind. Das Unternehmen hatte mit hohen Ausgaben für Hardware, Strom und Cloud-Dienste zu kämpfen, was in diesem Jahr zu einem prognostizierten Verlust von 5 Milliarden US-Dollar führte. Die Verringerung der Abhängigkeit von einem einzelnen Anbieter wie NVIDIA, der seine Preise erhöht hat, könnte OpenAI dabei helfen, diese Kosten besser zu verwalten und seine KI-Modelle ohne nennenswerte Verzögerungen oder Unterbrechungen weiterzuentwickeln.

Der Weg vor uns

Trotz des ehrgeizigen Plans, maßgeschneiderte Chips zu entwickeln, stehen OpenAI vor großen Herausforderungen. Der Aufbau einer eigenen Siliziumlösung erfordert Zeit und Geld, und die ersten maßgeschneiderten Chips werden voraussichtlich erst 2026 in Produktion gehen. Mit diesem Zeitplan liegt OpenAI hinter einigen seiner größeren Konkurrenten wie Google, Microsoft und Amazon, die dies bereits getan haben machte erhebliche Fortschritte bei der Entwicklung ihrer eigenen maßgeschneiderten KI-Hardware.

Die Partnerschaft mit Broadcom und TSMC stellt einen wichtigen Schritt nach vorne dar, verdeutlicht aber auch die Schwierigkeiten, mit denen Unternehmen konfrontiert sind, die versuchen, in den Chipmarkt einzudringen. Die Herstellung leistungsstarker KI-Chips erfordert umfangreiches Fachwissen, fortschrittliche Produktionsanlagen und erhebliche Investitionen. TSMC wird als Fertigungspartner eine Schlüsselrolle für den Erfolg dieses Vorhabens spielen. Der Zeitplan für die Chipproduktion könnte sich je nach Faktoren wie Designkomplexität und Fertigungskapazität noch ändern.

Eine weitere Herausforderung liegt in der Talentakquise. OpenAI ist vorsichtig, wenn es darum geht, Talente von NVIDIA abzuwerben, da das Unternehmen eine gute Beziehung zum Chiphersteller aufrechterhalten möchte, insbesondere da es bei seinen KI-Modellen der aktuellen Generation immer noch stark auf NVIDIA angewiesen ist. Es wird erwartet, dass die Blackwell-Chips von NVIDIA für kommende KI-Projekte von entscheidender Bedeutung sein werden, und die Aufrechterhaltung einer positiven Beziehung ist für den dauerhaften Zugriff von OpenAI auf diese hochmodernen GPUs von entscheidender Bedeutung.

Warum OpenAI benutzerdefiniertes Silizium benötigt

Der Hauptgrund für die maßgeschneiderte Chip-Initiative von OpenAI sind die Kosten. Das Training und der Einsatz großer KI-Modelle wie GPT-4 erfordern enorme Rechenleistung, was zu hohen Infrastrukturkosten führt. Die jährlichen Rechenkosten von OpenAI dürften einer der größten Ausgaben sein, wobei das Unternehmen in diesem Jahr trotz eines Umsatzes von 3,7 Milliarden US-Dollar mit einem Verlust von 5 Milliarden US-Dollar rechnet. Durch die Entwicklung eigener Chips hofft OpenAI, diese Kosten unter Kontrolle zu bringen und sich so einen Wettbewerbsvorteil auf dem überfüllten KI-Markt zu verschaffen.

Maßgeschneidertes Silizium bietet auch Leistungsvorteile. Durch das Zuschneiden von Chips speziell auf die Bedürfnisse der KI-Inferenz kann OpenAI die Leistung optimieren, die Effizienz verbessern und die Latenz reduzieren. Dies ist besonders wichtig für die Bereitstellung hochwertiger Echtzeit-Antworten in Produkten wie ChatGPT. Während die GPUs von NVIDIA hochleistungsfähig sind, kann maßgeschneiderte Hardware eine gezieltere Optimierung ermöglichen, was möglicherweise zu erheblichen Leistungssteigerungen und Kosteneffizienz führt.

Der Ansatz, interne und externe Chiplösungen zu kombinieren, bietet OpenAI eine größere Flexibilität bei der Skalierung seiner Infrastruktur. Durch die Zusammenarbeit mit Broadcom an kundenspezifischen Designs und die Einbindung von AMD- und NVIDIA-GPUs positioniert sich OpenAI, um die Herausforderungen der hohen Nachfrage und der Einschränkungen der Lieferkette besser zu meistern. Dieser diversifizierte Ansatz wird dem Unternehmen helfen, sich an veränderte Marktbedingungen anzupassen und sicherzustellen, dass es über die erforderlichen Rechenressourcen verfügt, um die Grenzen der KI weiter zu erweitern.

Hervorgehobener Bildnachweis: Andrew Neel/Unsplash