In einer Welt, die von aufgeblähten KI-Modellen dominiert wird, die in der Cloud leben, dreht Mistral AI das Drehbuch um. Das französische Startup gerade entfesselt zwei neue Modelle – Ministral 3B und 8B – die für den Betrieb auf Edge-Geräten konzipiert sind.

Les Ministraux: Ministral 3B und 8B

Mistrals neue Angebote mit dem Titel „Les Ministraux“ klingen vielleicht wie ein französischer Arthouse-Film, aber diese Modelle sind bereit, die KI-Welt aufzurütteln. Mit nur 3 Milliarden bzw. 8 Milliarden Parametern steht bei der Ministraux-Familie alles im Zeichen der Effizienz. Vergessen Sie die ressourcenintensiven KI-Modelle, für deren Funktion ein Rechenzentrum erforderlich ist.

„Unsere innovativsten Kunden und Partner fordern zunehmend lokale, datenschutzorientierte Schlussfolgerungen für kritische Anwendungen“, erklärte Mistral.

Kontextlänge wie nie zuvor

Hier wird es richtig scharf: Sowohl das 3B- als auch das 8B-Modell können ein Kontextfenster von 128.000 Token verarbeiten. Das entspricht einem 50-seitigen Buch. Zum Vergleich: sogar OpenAIs GPT-4 Turbo Die Obergrenze liegt bei etwa der gleichen Token-Anzahl, und das ist keine Kleinigkeit.

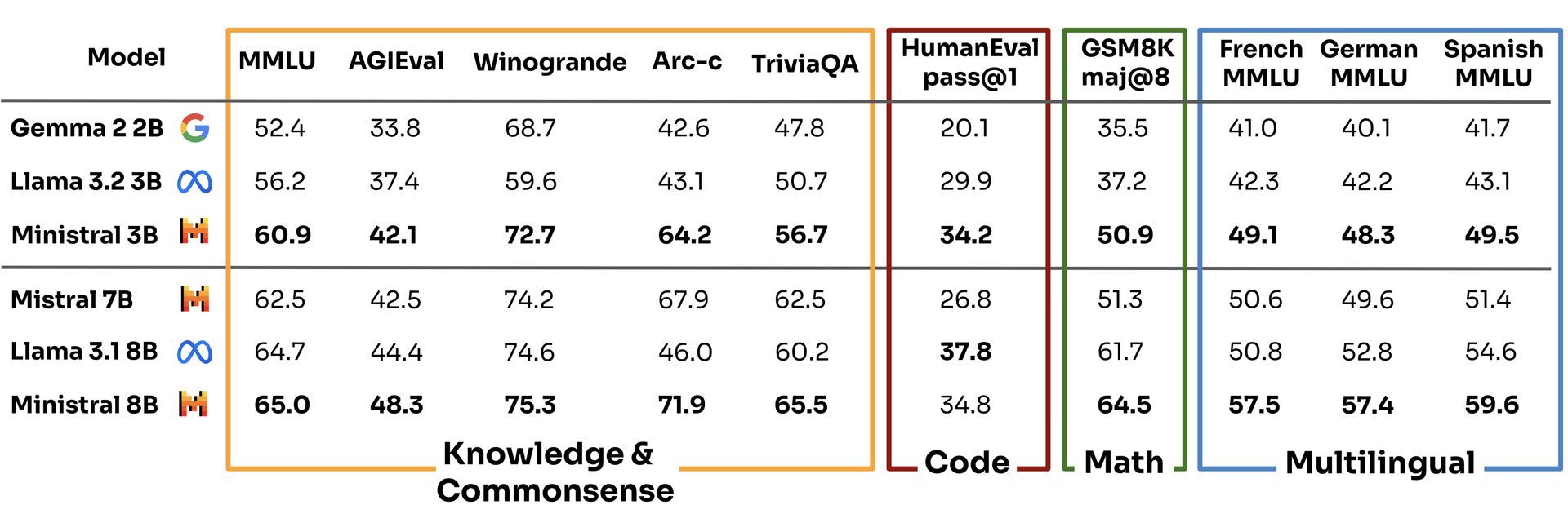

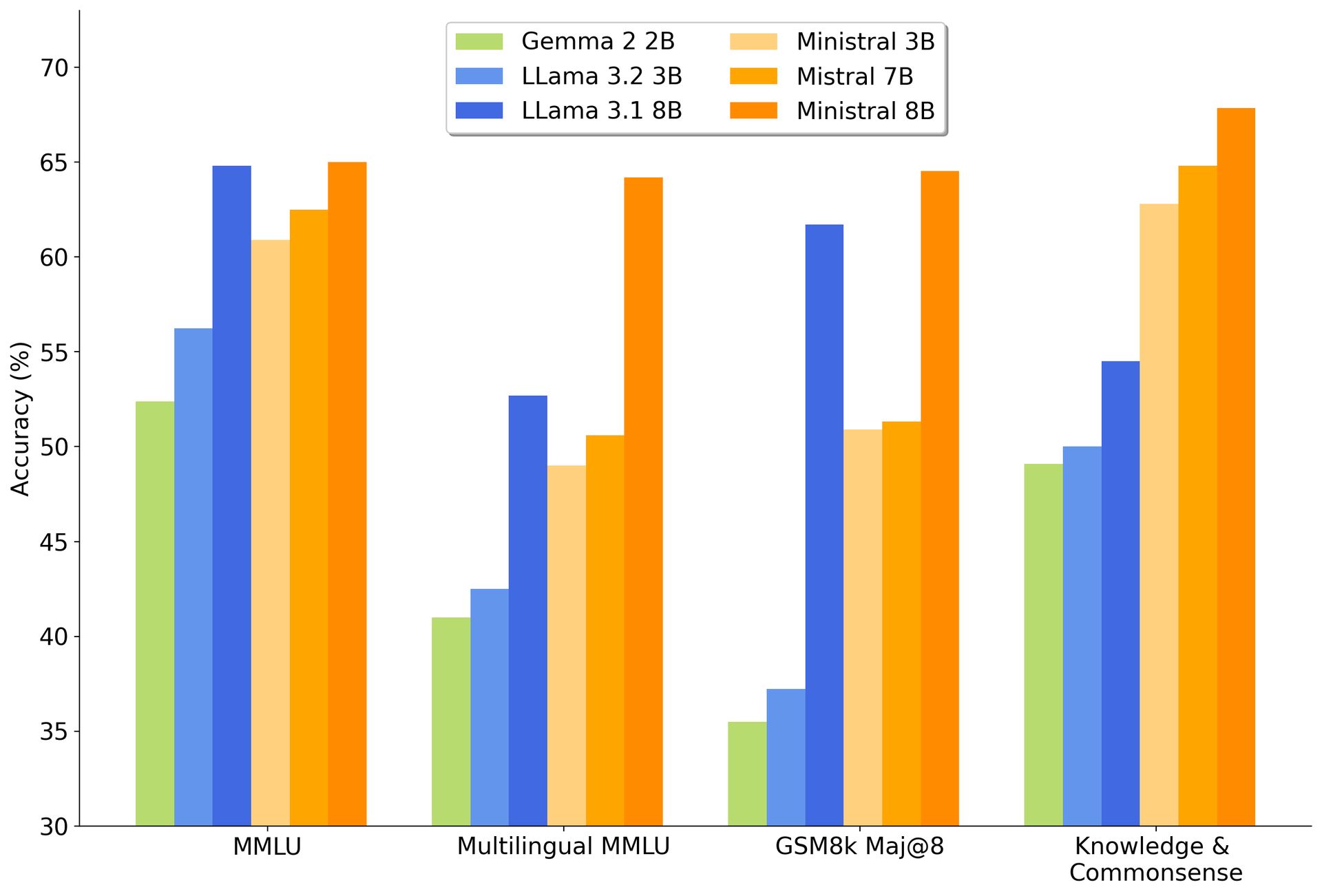

Mit dieser Kapazität übertreffen die Ministraux-Modelle nicht nur ihren Vorgänger, den Mistral 7B, sondern übertreffen auch den von Google Gemma 2 2B Und Metas Lama-Modelle zum Frühstück.

Laut Mistrals eigenen Benchmarks erzielte das 3B-Modell in der Multitask-Sprachverständnisbewertung einen Wert von 60,9 und ließ Konkurrenten wie Llama 3.2 3B und Gemma 2 2B mit 56,2 bzw. 52,4 zurück.

Nicht schlecht für ein „kleineres“ Modell, oder?

Während sich alle anderen in der KI-Welt darum bemühen, größere, schlimmere und energiefressende Modelle zu entwickeln, spielt Mistral ein anderes Spiel. Durch die Ausführung auf lokalen Geräten macht Les Ministraux den Bedarf an riesigen Cloud-Servern überflüssig und bietet dadurch eine viel umweltfreundlichere Option. Dieser Schritt passt perfekt zum zunehmenden Druck auf Technologieunternehmen, umweltbewusster zu handeln. KI mag die Zukunft sein, aber niemand möchte, dass diese Zukunft auf Kosten des Planeten geht.

Es gibt auch den Aspekt der Privatsphäre. Da alles lokal läuft, bleiben Ihre Daten auf Ihrem Gerät, was ein großer Vorteil für Branchen wie das Gesundheitswesen und das Finanzwesen ist, deren Umgang mit sensiblen Informationen zunehmend unter die Lupe genommen wird. Man kann es sich als KI ohne Schnüffelei vorstellen – eine erfrischende Abwechslung in einer Welt, in der jede App mehr Daten zu sammeln scheint als die NSA.

Mistrals Masterplan: Aufbauen, stören, wiederholen

Aber machen wir uns nichts vor – Mistral tut dies nicht nur zum Wohle der Allgemeinheit. Das von Absolventen von Meta und Googles DeepMind mitgegründete Unternehmen hat es sich zur Aufgabe gemacht, Wellen zu schlagen. Sie haben bereits 640 Millionen US-Dollar an Risikokapital eingesammelt und konzentrieren sich voll und ganz auf die Entwicklung von KI-Modellen, die nicht nur mit GPT-4 von OpenAI und Claude von Anthropic konkurrieren, sondern dabei auch Gewinne erwirtschaften.

Und während es im Bereich der generativen KI ungefähr so einfach ist, Geld zu verdienen wie im Lotto zu gewinnen, gibt Mistral nicht nach. Tatsächlich haben sie im vergangenen Sommer damit begonnen, Einnahmen zu generieren, was mehr ist, als man von vielen ihrer Konkurrenten behaupten kann.

Indem Mistral Ministral 8B für Forschungszwecke anbietet und beide Modelle über seine Cloud-Plattform La Platforme verfügbar macht, positioniert es sich als das coolste Kind im KI-Bereich – offen genug, um Entwickler anzulocken, aber intelligent genug, um seine Technologie durch strategische Partnerschaften zu monetarisieren. Es handelt sich um einen hybriden Ansatz, der das widerspiegelt, was Open-Source-Giganten wie Red Hat in der Linux-Welt getan haben, nämlich die Community zu fördern und gleichzeitig dafür zu sorgen, dass die Kassen klingeln.

Bildnachweis: Mistral