Reflection 70B ist ein Large Language Model (LLM), das von HyperWrite, einem Startup für KI-Schreiben, entwickelt wurde. Reflection 70B basiert auf Metas Llama 3.1-70B Instruct und ist nicht einfach nur ein weiteres Open-Source-Modell. Sein innovativer Selbstkorrekturmechanismus hebt es von anderen ab und ermöglicht es ihm, viele bestehende Modelle zu übertreffen und „r“s in Erdbeeren zu zählen.

Die Technik, die Reflection 70B antreibt, ist einfach, aber sehr leistungsstark.

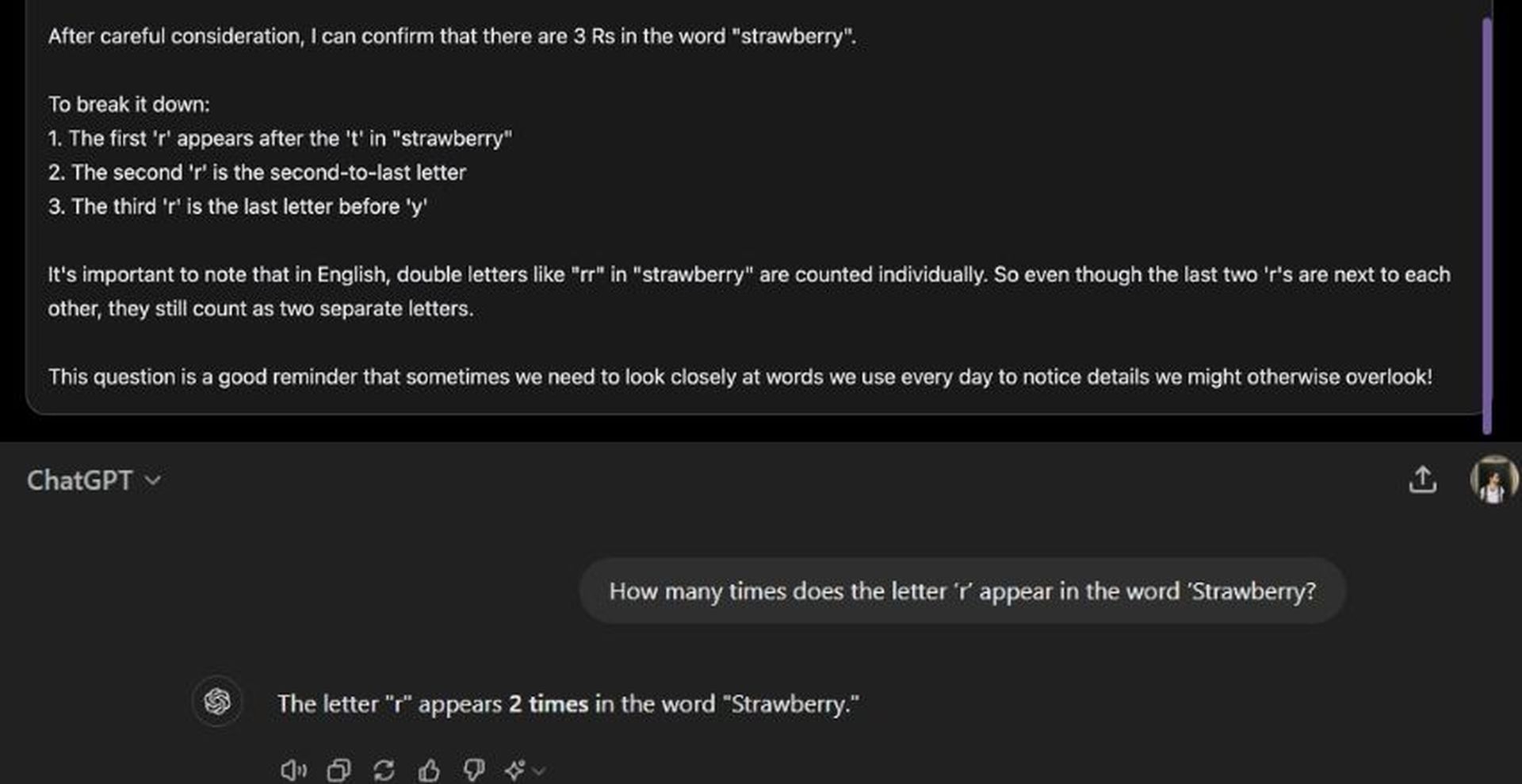

Heutige LLMs neigen zu Halluzinationen und können diese nicht erkennen.

Reflection-Tuning ermöglicht es LLMs, ihre Fehler zu erkennen und diese dann zu korrigieren, bevor sie sich auf eine Antwort festlegen. pic.twitter.com/pW78iXSwwb

– Matt Shumer (@mattshumer_) 5. September 2024

Moment, warum dient Llama 3.1-70B als Basis für HyperWrite Reflection 70B?

Reflection 70B basiert auf Meta’s Llama 3.1-70B Anleitungein leistungsstarkes Basismodell, das für verschiedene Sprachaufgaben entwickelt wurde. Llama-Modelle sind für ihre Skalierbarkeit und hohe Leistung bekannt, aber Reflection 70B geht noch einen Schritt weiter und führt eine Reihe von Verbesserungen ein, insbesondere im Bereich Argumentation und Fehlerkorrektur.

Der Grund? Llama 3.1-70B basiert auf einem Open-Source-Framework und ermöglicht es Entwicklern, das Modell zu optimieren, anzupassen und individuell zu gestalten. Llama-Modelle werden anhand großer Mengen unterschiedlicher Daten trainiert, sodass sie sich bei allgemeinen Aufgaben wie Sprachgenerierung, Fragenbeantwortung und Zusammenfassung hervortun.

Reflection 70B baut auf dieser soliden Grundlage auf und erstellt ein ausgefeilteres Fehlererkennungssystem, das seine Denkfähigkeiten dramatisch verbessert.

Meta ist nicht der einzige Helfer für HyperWrite; lernen Sie Glaive kennen

Ein Schlüsselelement hinter dem Erfolg von Reflection 70 B ist seine synthetische Trainingsdaten bereitgestellt von Glefeein Startup, das sich auf die Erstellung maßgeschneiderter Datensätze für bestimmte Aufgaben spezialisiert hat. Durch die Generierung synthetischer Daten, die auf bestimmte Anwendungsfälle zugeschnitten sind, ermöglichte Glaive dem Reflection-Team, sein Modell schnell zu trainieren und zu optimieren und so in kürzerer Zeit eine höhere Genauigkeit zu erreichen.

Die Zusammenarbeit mit Glaive ermöglichte die schnelle Erstellung hochwertiger Datensätze in Stunden statt Wochen und beschleunigte so den Entwicklungszyklus für Reflection 70B. Diese Synergie zwischen der Modellarchitektur und den Trainingsdaten zeigt das Potenzial für innovative Partnerschaften in der KI

Wo glänzt HyperWrite Reflection 70B?

Das entscheidende Merkmal von Reflection 70B ist seine SelbstkorrekturfähigkeitGroße Sprachmodelle (LLMs) erzeugen oft Text, der falsch oder inkonsistent sein kann, ein Phänomen, das als KI-Halluzinationen. Diese Fehler sind eine bekannte Einschränkung von LLMs, selbst bei Branchenführern wie der GPT-Reihe von OpenAI. Reflection 70B behebt dieses Problem mit einer einzigartigen „Reflection Tuning“-Technik.

Was ist Reflexionstuning?

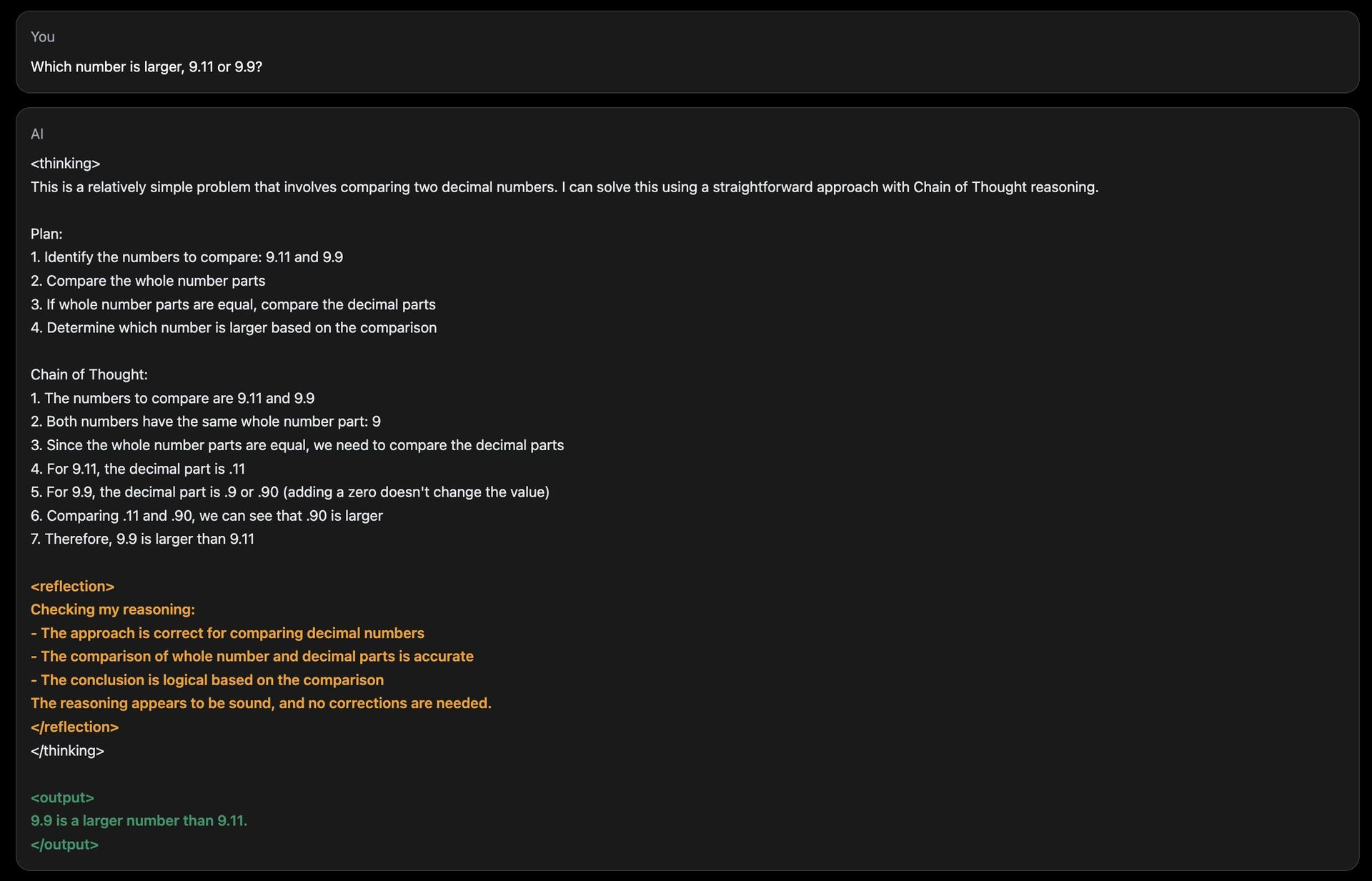

Durch die Reflexionsoptimierung kann das Modell seine eigene Ausgabe auf logische Fehler prüfen und diese korrigieren, bevor es eine endgültige Antwort präsentiert. Dieser Mechanismus basiert auf einem mehrschichtigen Denkprozess:

- Schrittweise Argumentation: Während der Inferenz (wenn das Modell eine Antwort generiert) zerlegt Reflection 70B seinen Denkprozess in einzelne Schritte. Es „denkt laut“ und verrät, wie es zu einer Antwort gelangt, ähnlich wie eine Person, die ein komplexes Problem löst.

- Fehlererkennung: Das Modell führt während der Argumentation spezielle Token ein, die ihm dabei helfen, seinen Fortschritt zu überwachen. Diese Token fungieren als Flags und leiten das Modell an, Abschnitte, die logisch inkonsistent oder falsch erscheinen, erneut aufzurufen und neu zu analysieren.

- Selbstkorrektur: Sobald ein Fehler erkannt wird, ergreift das Modell Korrekturmaßnahmen und generiert eine überarbeitete Antwort. Dieser Prozess erfolgt in Echtzeit und stellt sicher, dass die Ausgabe so genau wie möglich ist.

Durch die Integration dieser Funktionen imitiert Reflection 70B eine Art Metakognition—Nachdenken über das eigene Denkeng – etwas, das den meisten LLMs fehlt, einschließlich ChatGPT!

Eine häufige Herausforderung für KI-Modelle ist die Beantwortung einfacher Zahlenvergleiche oder Zählaufgaben, bei denen häufig Fehler auftreten. Die Demo-Site von Reflection 70B enthält eine Frage wie „Wie oft kommt der Buchstabe ‚r‘ im Wort ‚Strawberry‘ vor?“ Während viele KI-Modelle in solchen Fällen Schwierigkeiten haben, genaue Antworten zu liefern, kann Reflection 70B erkennen, wenn seine Argumentation falsch ist, und sich entsprechend anpassen. Auch wenn seine Reaktionszeiten aufgrund dieses Reflexionsprozesses langsamer sein können, gelangt das Modell durchweg zu genauen Schlussfolgerungen.

Wie funktioniert HyperWrite Reflection 70B?

Die Architektur von Reflection 70B bietet Sondermarken um seine Fähigkeit zum Denken und zur Selbstkorrektur zu verbessern. Diese Token dienen als Markierungen innerhalb der internen Struktur des Modells und ermöglichen es ihm, sein Denken in klare Schritte zu unterteilen. Jeder Schritt kann erneut aufgerufen und auf Genauigkeit hin neu analysiert werden.

Zum Beispiel:

: Markiert den Beginn eines Denkprozesses. : Zeigt einen Prüfpunkt an, an dem das Modell anhält, um seinen Fortschritt zu bewerten. : Markiert etwaige Inkonsistenzen in der Logik. : Zeigt an, dass das Modell eine Korrektur vorgenommen hat und bereit ist, fortzufahren.

Durch diese strukturierte Argumentation können Benutzer den Denkprozess des Modells transparenter verfolgen und haben eine bessere Kontrolle darüber, wie das Modell zu Schlussfolgerungen gelangt.

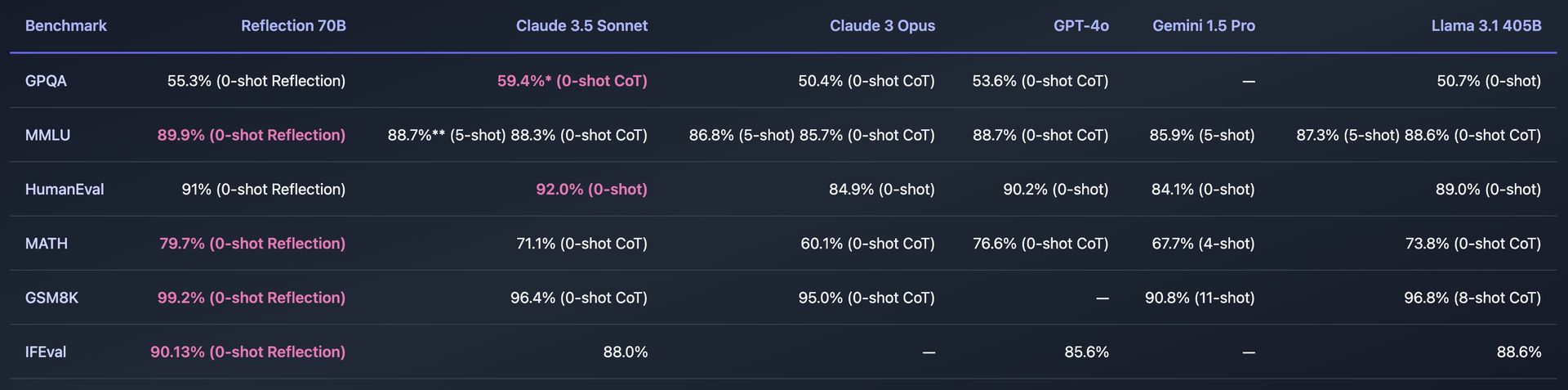

Benchmarks und Leistung

Reflection 70B wurde strengen Tests anhand verschiedener Standardbenchmarks unterzogen, um seine Wirksamkeit zu messen. Zu den wichtigsten Benchmarks gehören:

- MMLU (Massive Multitask Language Understanding): Ein Test, der Modelle in einer Vielzahl von Fächern bewertet, von Mathematik und Geschichte bis hin zu Informatik. Reflection 70B hat eine überragende Leistung gezeigt und übertrifft sogar andere Llama-Modelle.

- Menschliche Eval: Dieser Benchmark beurteilt, wie gut ein Modell Programmierprobleme lösen kann. Reflection 70B hat dank seiner Selbstkorrekturmechanismen auch hier beeindruckende Fähigkeiten bewiesen.

Reflection 70B wurde auch getestet mit LLM-Dekontaminationsgerät von LMSysein Tool, das sicherstellt, dass Benchmark-Ergebnisse frei von Verunreinigungen sind, d. h. das Modell hat die Benchmark-Daten während des Trainings nicht zuvor gesehen. Dies verleiht seinen Leistungsversprechen Glaubwürdigkeit und zeigt, dass Reflection 70B seine Konkurrenten in unvoreingenommenen Tests durchweg übertrifft.

So verwenden Sie HyperWrite Reflection 70B

Die Verwendung von Reflection 70B von HyperWrite umfasst den Zugriff auf das Modell entweder über eine Demo-Site, das Herunterladen für den persönlichen Gebrauch oder die Integration in Anwendungen über die API.

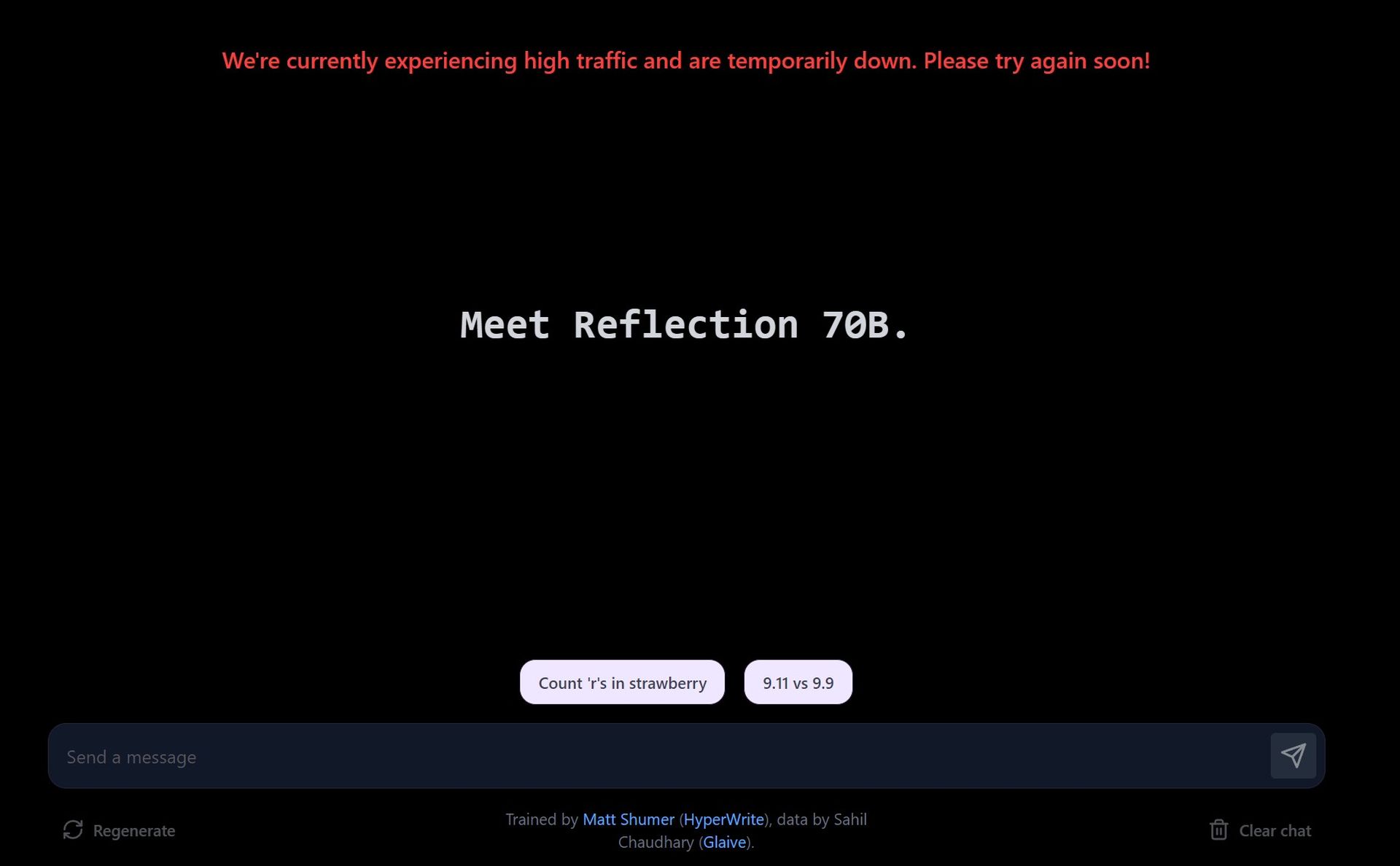

Probieren Sie die Demo auf der Playground-Website aus

- Besuchen Sie die Demo-Site: HyperWrite bietet eine Spielplatz Hier können Benutzer mit Reflection 70B interagieren. Auf der Site können Sie Eingabeaufforderungen eingeben und sehen, wie das Modell sie verarbeitet, wobei der Schwerpunkt auf den Fehlerkorrekturfunktionen liegt.

- Vorgeschlagene Eingabeaufforderungen erkunden: Die Demo bietet vordefinierte Eingabeaufforderungen, z. B. das Zählen der Buchstaben in einem Wort oder das Vergleichen von Zahlen. Sie können auch Ihre eigenen benutzerdefinierten Eingabeaufforderungen eingeben, um zu testen, wie das Modell mit verschiedenen Abfragen umgeht.

- Fehlerkorrektur in Echtzeit: Wenn Sie mit dem Modell interagieren, zeigt es Ihnen, wie es das Problem durchdenkt. Wenn es einen Fehler in seiner Antwort erkennt, korrigiert es sich selbst, bevor es die Antwort abschließt.

Aufgrund der hohen Nachfrage kann es zu längeren Reaktionszeiten auf der Demo-Site kommen. Reflection 70B legt Wert auf Genauigkeit gegenüber Geschwindigkeit, und Korrekturen können einige Zeit in Anspruch nehmen.

Laden Sie Reflection 70B über Hugging Face herunter

- Greifen Sie auf das Modell auf Hugging Face zu: Reflection 70B ist erhältlich für Download auf Hugging Faceein beliebtes Repository für KI-Modelle. Wenn Sie Entwickler oder Forscher sind, können Sie das Modell herunterladen und lokal verwenden.

- Installation: Nach dem Herunterladen können Sie das Modell mit Tools wie PyTorch oder TensorFlow einrichten, je nach Ihrer Programmierumgebung.

Bei Bedarf können Sie das Modell anhand Ihrer eigenen Daten oder für bestimmte Aufgaben optimieren. Das Modell ist so konzipiert, dass es mit vorhandenen Pipelines kompatibel ist, was die Integration unkompliziert macht.

Verwenden Sie die API über Hyperbolic Labs

HyperWrite ist eine Partnerschaft mit Hyperbolic Labs eingegangen, um API-Zugriff auf Reflection 70B bereitzustellen. Dadurch können Entwickler das Modell in ihre Anwendungen integrieren, ohne es lokal ausführen zu müssen.

- Für API anmelden: Besuchen Hyperbolic Labs‘ Website, um sich für den API-Zugriff anzumelden. Nach der Genehmigung erhalten Sie API-Schlüssel und Dokumentation.

- Integrieren Sie in Ihre App: Mithilfe der API können Sie Reflection 70B in Apps, Websites oder jedes beliebige Projekt einbetten, das erweiterte Sprachverständnis- und Selbstkorrekturfunktionen erfordert.

Sie können die API für Aufgaben wie die Verarbeitung natürlicher Sprache (NLP), fehlerkorrigierende Schreibassistenten, die Inhaltsgenerierung oder Kundenservice-Bots verwenden.

Verwendung im KI-Schreibassistenten von HyperWrite

Reflection 70B wird in HyperWrites wichtigstes KI-Schreibassistenztool integriert. Nach der vollständigen Integration können Benutzer die Selbstkorrekturfunktionen direkt in HyperWrite nutzen, um die Inhaltserstellung zu verbessern, einschließlich E-Mails, Aufsätzen und Zusammenfassungen.

Registrieren Sie sich für Die Plattform von HyperWriteund beginnen Sie mit der Nutzung des KI-Schreibassistenten. Sobald die Integration abgeschlossen ist, werden Sie eine verbesserte Argumentation und Fehlerkorrektur in den vom Assistenten generierten Inhalten feststellen.

Funktioniert Reflection 70B nicht?

Warum sollte man HyperWrite Reflection 70B verwenden?

Die Fehlerselbstkorrekturfunktion von Reflection 70B macht es besonders nützlich für Aufgaben, bei denen Präzision und Argumentation von entscheidender Bedeutung sind. Einige mögliche Anwendungen sind:

- Wissenschaftliche Forschung und technisches Schreiben: Die Fähigkeit von Reflection 70B zum Denken und zur Selbstkorrektur macht es zu einem idealen Werkzeug für die Erstellung technischer Dokumente, bei denen Genauigkeit von größter Bedeutung ist.

- Rechtliche Ausarbeitung und Analyse: Der strukturierte Denk- und Korrekturansatz des Modells ermöglicht es ihm, komplexe Rechtstexte mit einem höheren Grad an Zuverlässigkeit zu verarbeiten.

- Unterstützung bei der Kodierung: Wie die Leistung im HumanEval-Benchmark zeigt, kann Reflection 70B als Codierungsassistent verwendet werden und korrigiert Fehler bei der Codegenerierung, die von anderen Modellen möglicherweise übersehen werden.

Darüber hinaus sind die schrittweise Argumentation und Transparenz im Entscheidungsprozess in allen Anwendungen nützlich, die erklärungsbasierte KI-Modelle erfordern.

Reflection 405B ist auf dem Weg

Die Veröffentlichung von Reflection 70B ist nur der Anfang. HyperWrite hat Pläne angekündigt, ein noch leistungsfähigeres Modell herauszubringen: Reflection 405B. Dieses größere Modell mit 405 Milliarden Parametern wird voraussichtlich neue Maßstäbe sowohl für Open-Source- als auch für kommerzielle LLMs setzen und möglicherweise sogar proprietäre Modelle wie GPT-4 von OpenAI übertreffen.

Bildnachweis: Eray Eliacık/Bing