Microsoft hat einen Weg gefunden, mit NVIDIAder Maia 100 KI-Beschleuniger. Dieser neue Chip ist ein strategischer Schritt, um NVIDIAs Dominanz im KI-Hardwaresektor, indem es erweiterte Funktionen bietet, die für leistungsstarkes Cloud-Computing entwickelt wurden. Mit dem Maia 100 möchte Microsoft eine kostengünstigere und effizientere Lösung für die Verwaltung großer KI-Workloads bereitstellen.

Alles, was wir bisher über Microsofts Maia 100 wissen

Microsofts Maia 100 ist ein leistungsstarker neuer KI-Beschleuniger, der große KI-Aufgaben in der Cloud bewältigen soll. Vorgestellt auf Heiße Chips 2024, Dieser Chip stellt einen großen Fortschritt dar, wenn es darum geht, die KI-Infrastruktur kostengünstiger zu gestalten. Und zwar auf folgende Weise:

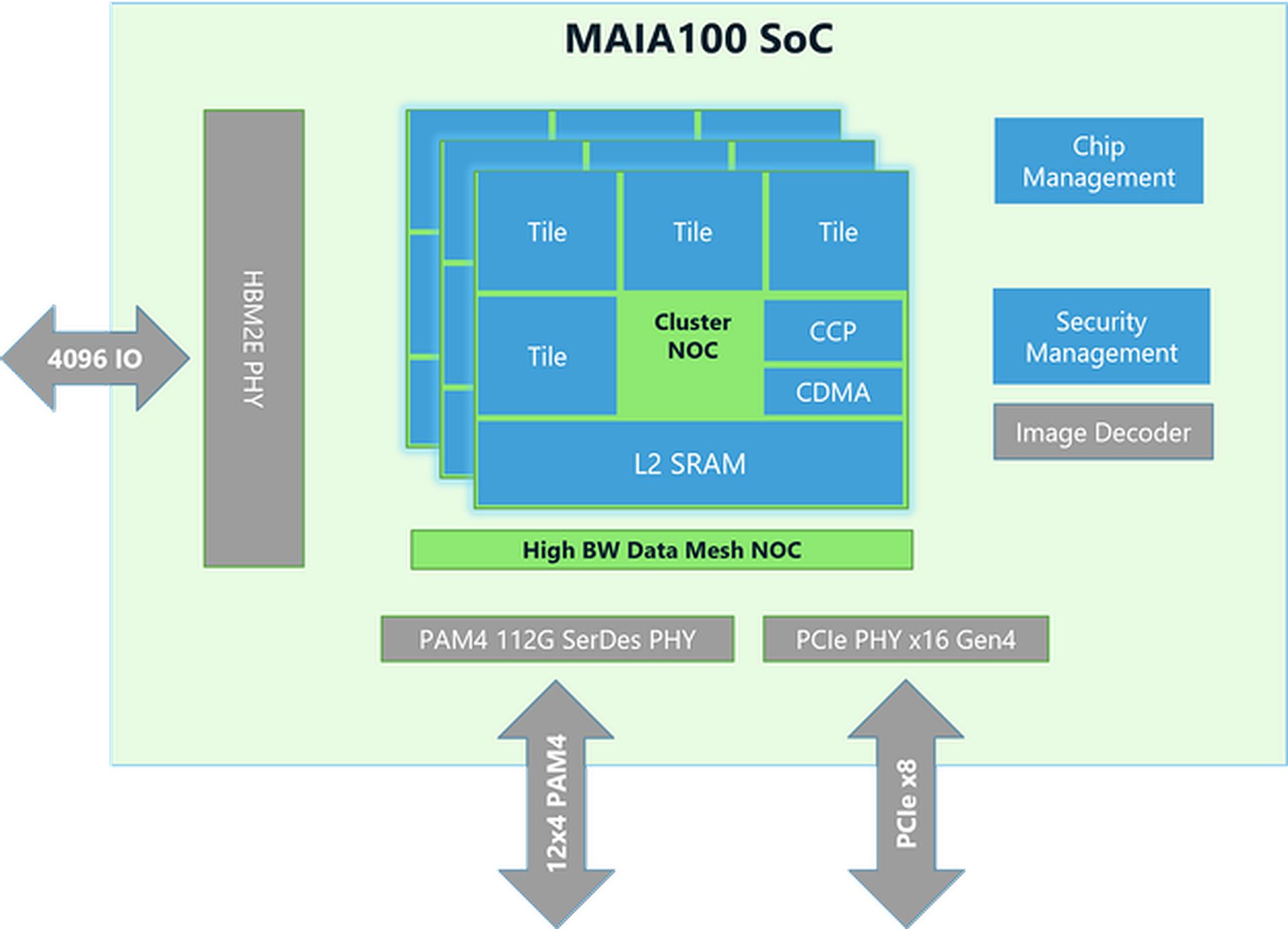

Chipdesign und Technologie

- Größe und Herstellung: Der Maia 100-Chip ist etwa 820 mm² groß und wird mit der fortschrittlichen N5-Technologie von TSMC hergestellt. Er verwendet die COWOS-S-Technologie, die dabei hilft, den Chip effektiv mit anderen Komponenten zu integrieren.

- Speicher und Bandbreite: Der Chip hat viel Speicher und kann riesige Datenmengen verarbeiten. Er verfügt über einen großen On-Die-SRAM (eine Art schneller Speicher) und vier HBM2E-Speicherchips. Zusammen bieten sie eine Datenübertragungsgeschwindigkeit von 1,8 Terabyte pro Sekunde und 64 Gigabyte Speicherkapazität. Diese Konfiguration ist entscheidend für die schnelle Verarbeitung großer KI-Datensätze.

Leistung und Energieeffizienz

- Stromverbrauch: Maia 100 kann bis zu 700 Watt Leistung verarbeiten, ist aber für eine bessere Effizienz auf 500 Watt eingestellt. Dadurch kann es eine gute Leistung erzielen und gleichzeitig den Stromverbrauch unter Kontrolle halten.

- Tensor-Einheit: Der Chip enthält eine Hochgeschwindigkeitstensoreinheit zur Bewältigung komplexer KI-Aufgaben wie dem Trainieren von Modellen und dem Erstellen von Vorhersagen. Er kann verschiedene Datentypen verarbeiten, darunter ein neues Format namens MX, das Microsoft 2023 eingeführt hat. Diese Einheit ist darauf ausgelegt, viele Berechnungen gleichzeitig effizient durchzuführen.

- Vektorprozessor: Maia 100 verfügt über einen Vektorprozessor, der verschiedene Datentypen unterstützt, wie FP32 (32-Bit-Gleitkomma) und BF16 (16-Bit-Gleitkomma). Dies hilft bei der Durchführung einer breiten Palette von Aufgaben des maschinellen Lernens.

- DMA-Engine: Die Direct Memory Access (DMA)-Engine hilft beim schnellen Verschieben von Daten und unterstützt verschiedene Möglichkeiten zum Aufteilen von Tensoren (Datenblöcken), was die Effizienz verbessert.

Datenhandhabung und Effizienz

- Datenspeicherung und Komprimierung: Maia 100 verwendet Datenspeicher mit geringerer Genauigkeit und eine Komprimierungs-Engine, um die Datenmenge zu reduzieren, die verschoben werden muss. Dies hilft dabei, große KI-Aufgaben effizienter zu bewältigen.

- Notizblöcke: Es verfügt über große, softwareverwaltete L1- und L2-Scratchpads (temporäre Speicherbereiche), um eine effiziente Datennutzung und Stromeinsparung sicherzustellen.

- Vernetzung: Der Chip unterstützt Hochgeschwindigkeits-Ethernet-Verbindungen und kann auf bestimmte Weise Daten mit bis zu 4800 Gbit/s und auf andere Weise Daten mit bis zu 1200 Gbit/s verarbeiten. Dieses benutzerdefinierte Netzwerkprotokoll gewährleistet eine zuverlässige und schnelle Datenübertragung, die zudem durch die AES-GCM-Verschlüsselung gesichert ist.

Elon Musks Nvidia-KI-Chip-Bestellung ist zu groß, um sie zu bewältigen

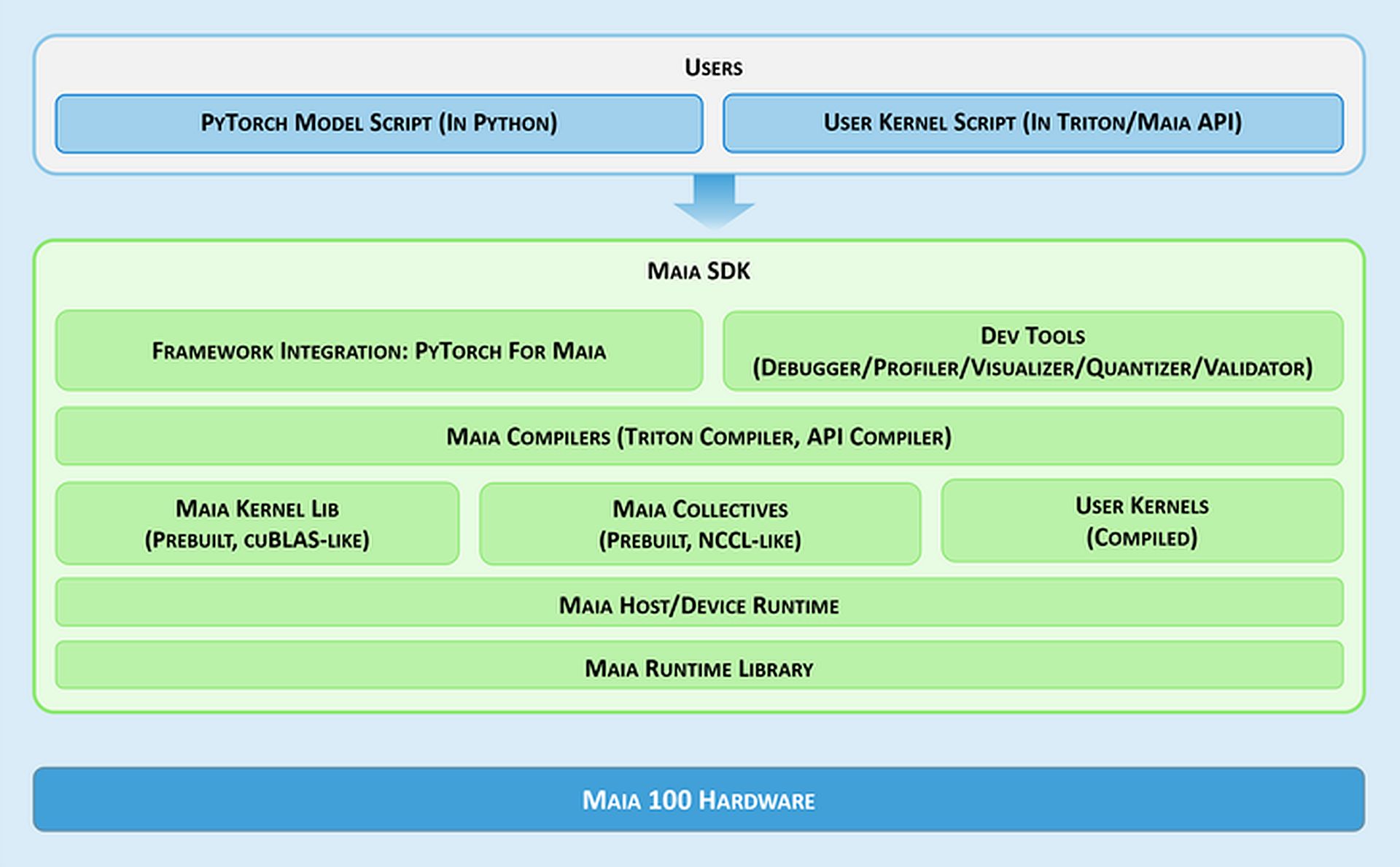

Softwaretools und Integration

- Maia SDK: Microsoft stellt eine Reihe von Tools namens Maia SDK bereit, um die Verwendung von Maia 100 zu vereinfachen. Zu diesen Tools gehören:

- Framework-Integration: Ein PyTorch-Backend, das sowohl den Eager-Modus (für schnelle Entwicklung) als auch den Graph-Modus (für bessere Leistung) unterstützt.

- Entwicklertools: Tools zum Debuggen, zur Leistungsoptimierung und zur Validierung von Modellen, die zur Verbesserung der Effizienz von KI-Aufgaben beitragen.

- Compiler: Maia unterstützt zwei Programmiermodelle: Triton, eine benutzerfreundliche Sprache für Deep Learning, und die Maia API, ein benutzerdefiniertes Modell für hohe Leistung.

- Kernel und kollektive Bibliothek: Bietet optimierte Rechen- und Kommunikationskernel für maschinelles Lernen mit Optionen zum Erstellen benutzerdefinierter Kernel.

- Host-/Gerätelaufzeit: Verwaltet die Speicherzuweisung, das Ausführen von Programmen, das Planen von Aufgaben und die Geräteverwaltung.

Programmiermodelle und Datenhandling

- Asynchrone Programmierung: Maia unterstützt asynchrone Programmierung mit Semaphoren, wodurch Berechnungen mit Datenübertragungen überlappt werden können, um die Effizienz zu verbessern.

- Programmiermodelle: Entwickler können wählen zwischen:

- Triton: Ein einfacher Planmesser für Deep Learning, der sowohl auf GPUs als auch auf Maia funktioniert. Er verwaltet Speicher und Synchronisierung automatisch.

- Maia-API: Ein detaillierteres Programmiermodell für diejenigen, die eine feine Kontrolle über die Leistung benötigen, was mehr Code und Verwaltung erfordert.

- Datenflussoptimierung: Maia verwendet eine Gather-basierte Methode für die Matrixmultiplikation (GEMMs) anstelle der herkömmlichen All-Reduce-Methode. Dies beschleunigt die Verarbeitung, indem die Ergebnisse direkt im SRAM (Fast Memory) kombiniert werden, was die Latenz verringert und die Leistung verbessert.

- SRAM-Nutzung: Der Chip verwendet SRAM, um Daten und Ergebnisse vorübergehend zu speichern, was den Bedarf an langsameren Speicherzugriffen reduziert und die Gesamtleistung steigert.

Flexibilität und Portabilität

Maia 100 kann PyTorch-Modelle mit minimalen Änderungen ausführen. Das PyTorch-Backend unterstützt sowohl Entwicklung (Eager-Modus) als auch hohe Leistung (Graph-Modus), sodass Modelle problemlos zwischen verschiedenen Hardware-Setups verschoben werden können.

Benötigen Sie eine Zusammenfassung der technischen Daten des Maia 100?

| Spezifikation | Details |

| Chipgröße | ~820mm² |

| Fertigungstechnologie | TSMC N5-Prozess mit COWOS-S-Interposer |

| On-Die-SRAM | Große Kapazität für schnellen Datenzugriff |

| Erinnerung | 64 GB HBM2E (Speicher mit hoher Bandbreite) |

| Gesamtbandbreite | 1,8 Terabyte pro Sekunde |

| Thermische Verlustleistung (TDP) | Unterstützt bis zu 700 W, bereitgestellt auf 500 W |

| Tensor-Einheit | Hohe Geschwindigkeit, unterstützt MX-Format, 16xRx16 |

| Vektorprozessor | Benutzerdefinierte Superskalar-Engine, unterstützt FP32 und BF16 |

| DMA-Engine | Unterstützt verschiedene Tensor-Sharding-Schemata |

| Datenkomprimierung | Enthält eine Komprimierungs-Engine für mehr Effizienz |

| Ethernet-Bandbreite | Bis zu 4800 Gbit/s All-Gather, 1200 Gbit/s All-to-All |

| Netzwerkprotokoll | Benutzerdefinierte RoCE-ähnliche AES-GCM-Verschlüsselung |

| Programmiermodelle | Triton (domänenspezifische Sprache), Maia API (benutzerdefiniertes Modell) |

| Notizblöcke | Große L1- und L2-Instanzen, softwaregesteuert |

| SRAM-Nutzung | Zur Pufferung von Aktivierungen und Ergebnissen |

| Software-SDK | Enthält PyTorch-Backend, Debugging-Tools, Compiler und Laufzeitverwaltung |

| Datenflussoptimierung | Gather-basierte Matrixmultiplikation (GEMMs) |

Das ist alles! Zusammenfassend positioniert sich Microsofts Maia 100 KI-Beschleuniger als direkter Konkurrent zu NVIDIAs Angeboten auf dem KI-Hardwaremarkt. Mit seiner fortschrittlichen Architektur und seinen Leistungsmerkmalen soll der Maia 100 eine praktikable Alternative für die Bewältigung groß angelegter KI-Aufgaben bieten.

Bildnachweis: Microsoft