Tsinghua Universität Und Zhipu KI haben in Zusammenarbeit CogVideoX eingeführt, ein Open-Source-Text-zu-Video-Modell, das bereit ist, KI-Schwergewichte wie Runway, Luma AIUnd Pika Labs. Diese Innovation wurde in einer aktuellen arXiv-Veröffentlichung ausführlich beschrieben und bietet Entwicklern weltweit erweiterte Funktionen zur Videoerstellung.

CogVideoX: Neues Open-Source-KI-Tool zur Text-zu-Video-Erstellung

„Wir stellen CogVideoX vor, groß angelegte Diffusionstransformatormodelle, die für die Generierung von Videos auf der Grundlage von Textaufforderungen entwickelt wurden. Um Videodaten effizient zu modellieren, schlagen wir vor, einen 3D-Variational Autoencoder (VAE) zu nutzen, um Videos sowohl in räumlicher als auch in zeitlicher Dimension zu komprimieren. Um die Text-Video-Ausrichtung zu verbessern, schlagen wir einen Expertentransformator mit dem Experten-adaptiven LayerNorm vor, um die tiefe Fusion zwischen den beiden Modalitäten zu erleichtern. Durch den Einsatz einer progressiven Trainingstechnik ist CogVideoX in der Lage, kohärente, lang andauernde Videos zu produzieren, die durch signifikante Bewegungen gekennzeichnet sind“, so das Zeitung liest.

Kürzlich arbeiteten sie gemeinsam an OpenVoice, einer Open-Source-Plattform zum Klonen von Stimmen, die gemeinsam mit dem MIT und Meine Shellund jetzt haben sie CogVideoX-5B eingeführt, ein Text-zu-Video-Modell. Sie haben sich auch mit Shengshu Technology zusammengeschlossen, um Vidu AIein Tool, das die Videoerstellung mithilfe von KI vereinfachen soll.

CogVideoX kann aus einfachen Textaufforderungen hochwertige, zusammenhängende Videos mit einer Länge von bis zu sechs Sekunden erstellen.

Das herausragende Modell, CogVideoX-5B, verfügt über 5 Milliarden Parameter und produziert Videos mit einer Auflösung von 720 × 480 und 8 Bildern pro Sekunde. Diese Spezifikationen können zwar nicht mit den neuesten proprietären Systemen mithalten, der wahre Durchbruch liegt jedoch im Open-Source-Ansatz von CogVideoX.

Open-Source-Modelle revolutionieren das Feld durchVeröffentlichung ihres Codes und ihrer Modellgewichte der Öffentlichkeit hat das Tsinghua-Team eine Technologie demokratisiert, die einst die Domäne gut finanzierter Technologiegiganten war. Dieser Schritt dürfte die Weiterentwicklung von KI-generierten Videos beschleunigen, indem er das kollektive Fachwissen der globalen Entwicklergemeinschaft nutzt.

Die beeindruckenden Ergebnisse von CogVideoX erreichten die Forscher durch mehrere wichtige Innovationen, darunter eine 3D-Variations-Autoencoder für effiziente Videokomprimierung und einen „Experten-Transformator“ zur Verbesserung der Text-Video-Ausrichtung.

„Um die Abstimmung zwischen Videos und Texten zu verbessern, schlagen wir einen Experten-Transformer mit einem fachmännisch angepassten LayerNorm vor, um die Fusion der beiden Modalitäten zu erleichtern“, heißt es in dem Artikel. Dieser Durchbruch ermöglicht eine präzisere Interpretation von Textaufforderungen und eine genauere Videogenerierung.

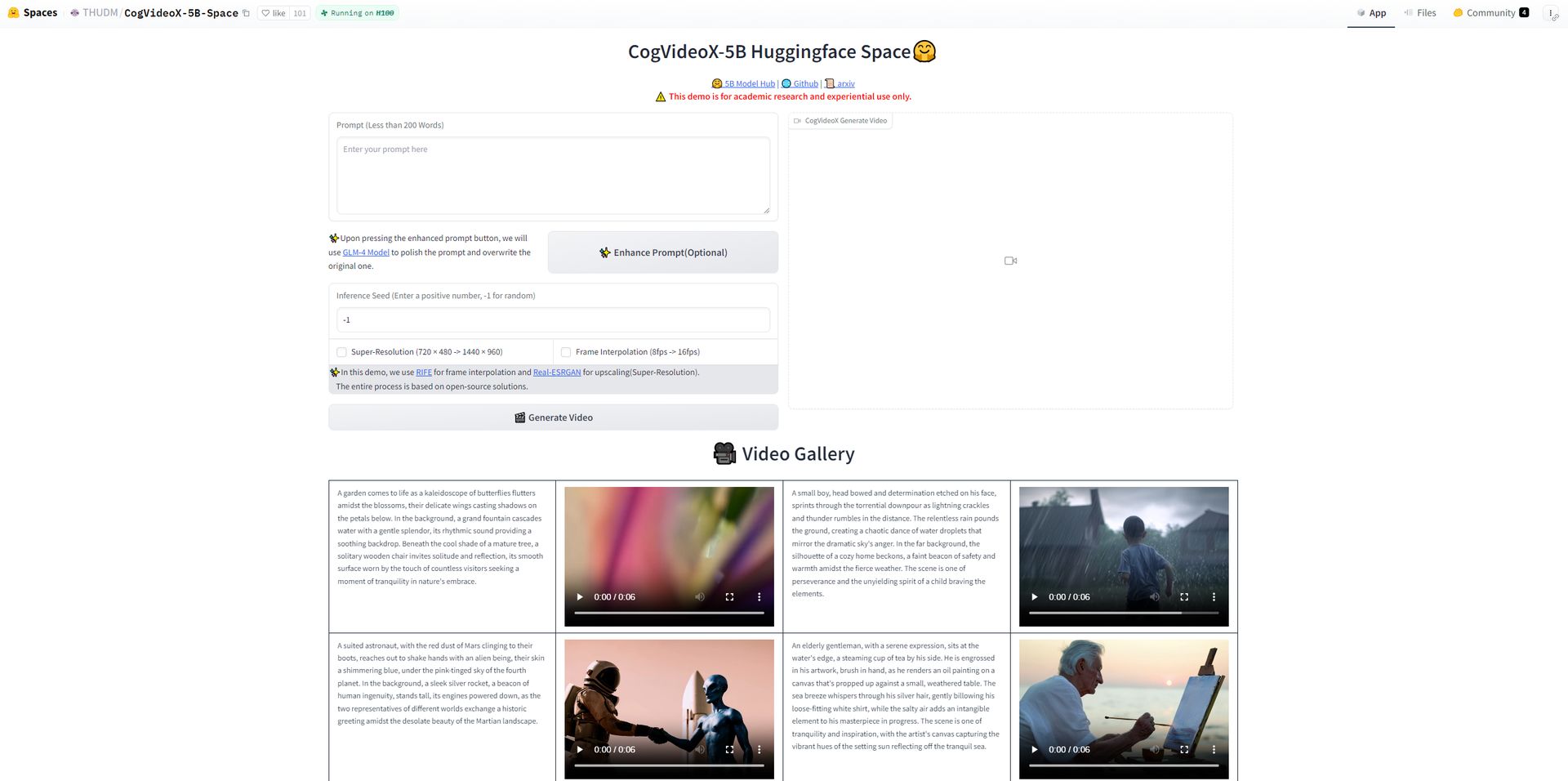

Wie kann ich CogVideoX ausprobieren?

- Gehen Sie zunächst zur HuggingFace-Plattform wo die CogVideoX-5B – Open-Source-Tool zur Videogenerierung steht zum Testen bereit.

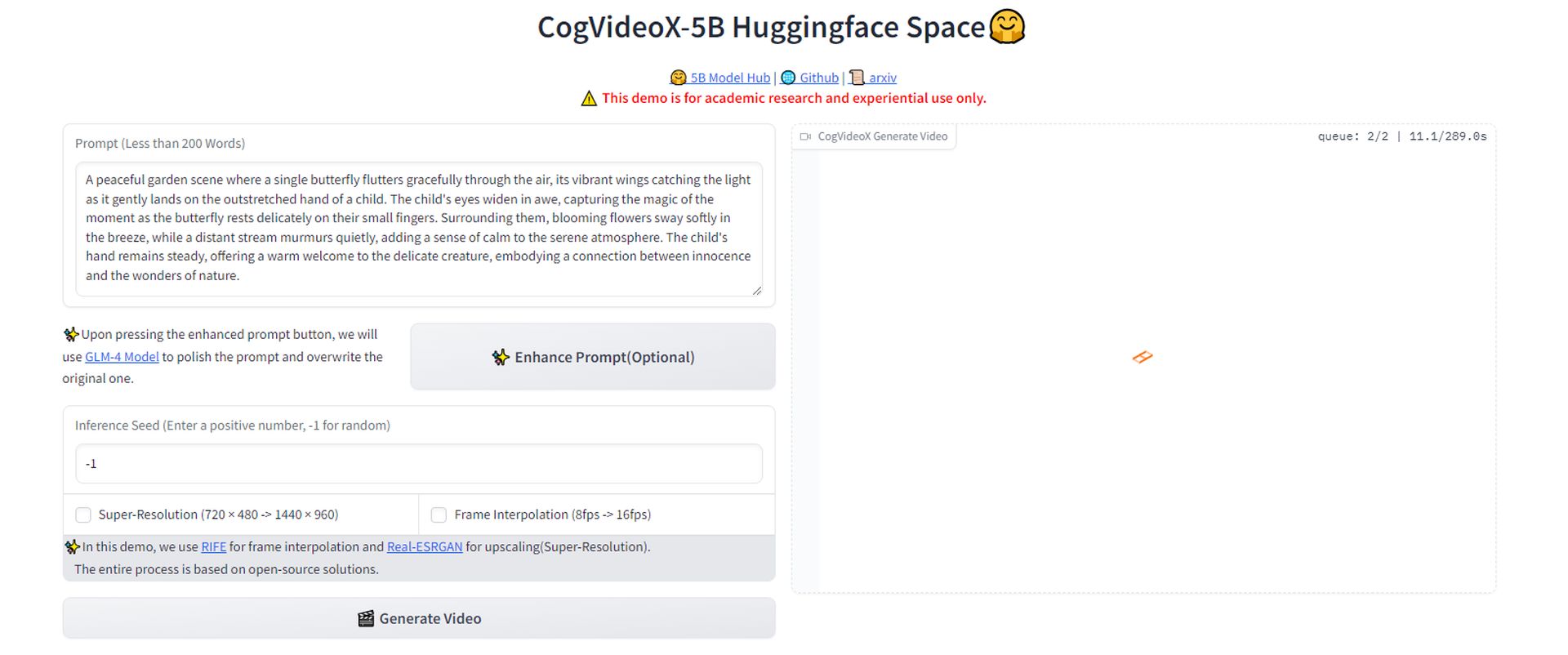

- Formulieren Sie eine beschreibende Eingabeaufforderung für das Video, das Sie generieren möchten. Wir haben beispielsweise Folgendes verwendet:

- Sobald Ihre Eingabeaufforderung fertig ist, Klicken Sie auf die Schaltfläche, um das Video zu generierenSie müssen einen Moment warten, während das Tool Ihre Anfrage verarbeitet und das Video basierend auf Ihrer Beschreibung erstellt.

- Nachdem das Video generiert wurde, können Sie es direkt von der Plattform herunterladen. So können Sie das Ergebnis Ihrer Eingabeaufforderung anzeigen und sehen, wie genau das Tool Ihre Beschreibung interpretiert hat.

- Schauen Sie sich das Video an. Auch wenn das Ergebnis vielleicht nicht umwerfend ist, ist es wichtig zu wissen, dass sich diese Art von Tools schnell verbessern. Wie wir es bei der Entwicklung von ChatGPT gesehen haben, steht wahrscheinlich ein bedeutender Durchbruch bei KI-generierten Videos bevor.

Habe es ausprobiert – es ist zwar noch nicht umwerfend, aber diese Tools tauchen überall auf. Erwarte bald einen Durchbruch, so wie wir ihn bei ChatGPT gesehen haben. pic.twitter.com/53xYz6lBLf

— Kerem Gülen (@kgulenn) 28. August 2024

Wir werden immer mehr Deepfakes sehen

Doch die breite Verfügbarkeit einer so leistungsstarken Technologie birgt auch Gefahren. Das Missbrauchspotenzial, insbesondere bei der Erstellung von Deepfakes oder irreführenden Inhalten, ist ein ernstes Problem, mit dem sich die KI-Community auseinandersetzen muss. Die Forscher selbst erkennen diese ethischen Bedenken an und drängen auf einen verantwortungsvollen Einsatz der Technologie.

Da KI-generierte Videos immer zugänglicher und fortschrittlicher werden, betreten wir bei der Erstellung digitaler Inhalte unbekanntes Terrain. Der Start von CogVideoX könnte einen ganz entscheidenden Moment darstellen, der möglicherweise die Macht von den großen Akteuren in diesem Bereich auf ein offeneres, dezentraleres Modell der KI-Entwicklung umverteilt.

Die tatsächlichen Auswirkungen dieser Demokratisierung sind noch ungewiss. Wird sie eine neue Welle der Kreativität und Innovation auslösen oder werden sich die bestehenden Probleme der Desinformation und digitalen Manipulation verschärfen?

Bildnachweis: Kerem Gülen/Mitten auf der Reise