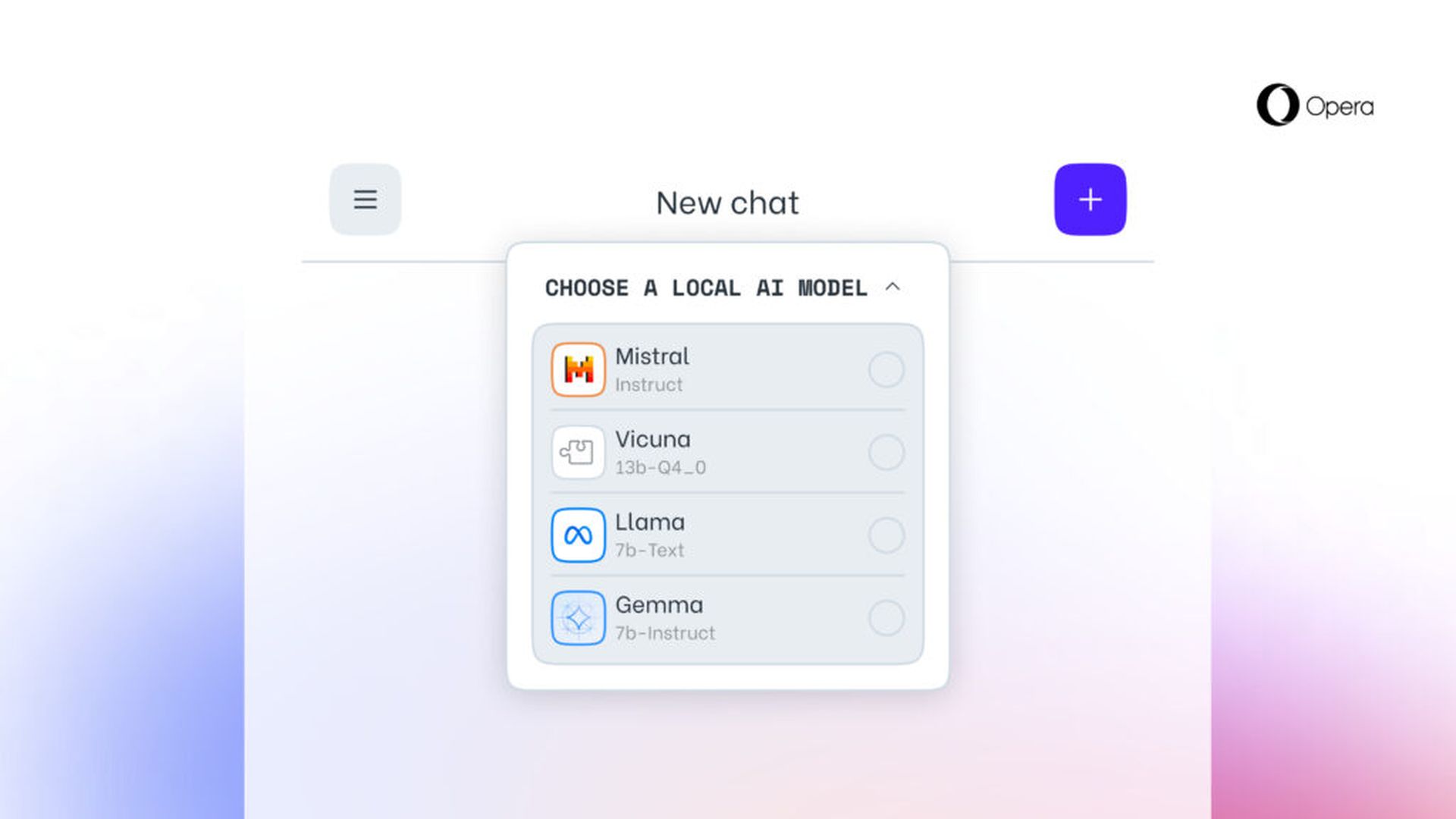

Oper enthüllt hat heute seine Initiative gestartet, experimentelle Unterstützung für 150 lokale Large Language Model (LLM)-Varianten zu integrieren, die aus rund 50 verschiedenen Modellfamilien stammen. Die Funktion wird zunächst im Developer-Stream in Opera One Einzug halten und damit einhergehen 150 Modelle aus mehr als 50 Familien aus denen Benutzer wählen können.

Dazu gehören die Vicuna und das Lama von Google bzw. Meta. Das bedeutet, dass die Funktion den Verbrauchern über das AI Feature Drops-Programm von Opera zur Verfügung steht und frühzeitigen Zugriff auf einige dieser KI-Funktionen ermöglichen würde. Diese Modelle werden über Ihren Browser auf Ihrem Computer ausgeführt und mit dem Open-Source-Framework Ollama ausgeführt. Alle derzeit angebotenen Modelle stammen aus der Ollama-Bibliothek, das Unternehmen hofft jedoch, in Zukunft auch einige aus anderen Quellen einzubeziehen.

Jeder davon benötigt mehr als 2 GB Speicherplatz auf Ihrem lokalen PC, so das Unternehmen. Um zu vermeiden, dass Ihnen der Speicherplatz ausgeht, sollten Sie Ihren freien Speicherplatz mit Bedacht nutzen. Interessanterweise versucht Opera nicht, die Daten zu speichern, wenn es in einer Modellform heruntergeladen wird.

Sie können andere Modelle auch online auf Websites wie HuggingFace und PoE auf Quora ausprobieren, sodass es sich wirklich um Ihre lokalen Modelltestanforderungen handelt.

Große Sprachmodelle unterstützen jetzt die Verarbeitung von Daten direkt auf dem Gerät des Benutzers und ermöglichen so den Einsatz generativer KI, während die Informationen privat und von externen Servern ferngehalten werden. Opera hat Pläne angekündigt, diesen innovativen Ansatz im Rahmen seines neuen AI Feature Drops-Programms über den Opera One-Entwicklerkanal für lokale LLMs einzuführen. Diese Initiative bietet Erstanwendern die Möglichkeit, aktuelle Versionen der KI-Funktionen des Browsers zeitnah und regelmäßig auszuprobieren. Ab heute haben Benutzer von Opera One Developer die Freiheit, das bevorzugte Modell für die Verarbeitung ihrer Daten auszuwählen.

Wie probiere ich integrierte LLMs in Opera aus?

Um sich mit diesen Modellen zu beschäftigen, sollten Benutzer Upgrade auf die aktuellste Opera Developer-Version Und Führen Sie eine Reihe von Schritten aus um diese aufregende Funktionalität zu aktivieren:

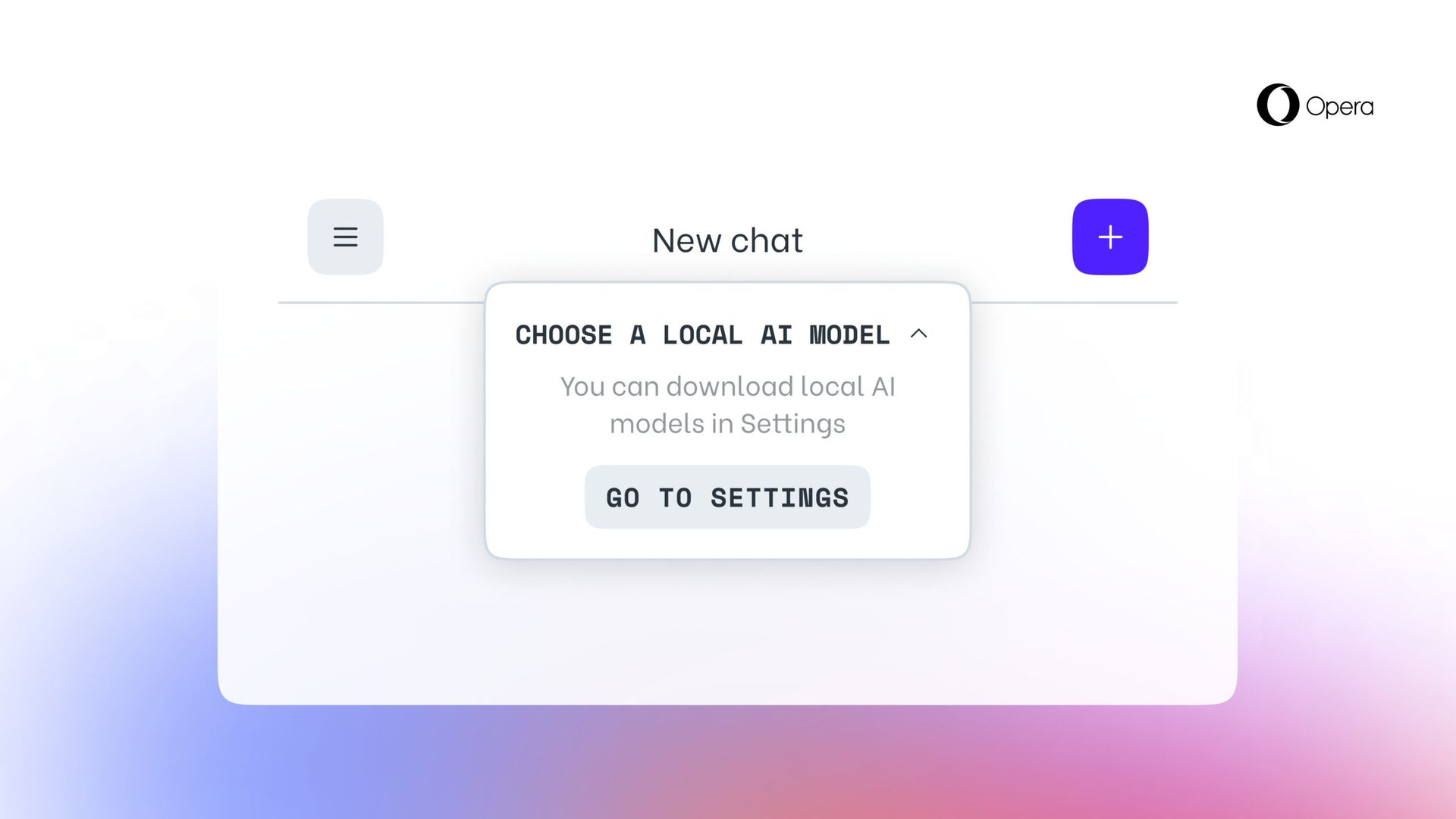

- Greifen Sie wie zuvor auf die Seitenleiste von Aria Chat zu. Oben im Chat gibt es ein Dropdown-Menü mit der Bezeichnung „Wählen Sie den lokalen Modus.”

- Wählen „Gehe zu den Einstellungen” aus diesem Menü.

- Dieser Bereich ermöglicht es Ihnen Erkunden Sie und entscheiden Sie, welche Modelle Sie herunterladen möchten.

- Für eine kleinere und schnellere Option sollten Sie das genannte Modell herunterladen GEMMA:2B-INSTRUCT-Q4_K_M indem Sie auf das Download-Symbol rechts davon klicken.

- Sobald der Download abgeschlossen ist, Klicken Sie auf die Menüschaltfläche in der oberen linken Ecke, um eine neue Chat-Sitzung zu starten.

- Auch hier sehen Sie oben im Chat ein Dropdown-Menü mit der Aufschrift „Wählen Sie den lokalen Modus” Hier können Sie das gerade installierte Modell auswählen.

- Geben Sie Ihre Eingabeaufforderung in den Chat einund das lokal gehostete Modell antwortet.

Die Teilnehmer wählen ein lokales LLM aus, das sie auf ihr Gerät herunterladen möchten. Dieser Ansatz erfordert zwischen 2 bis 10 GB Speicherplatz für jede Version und bietet eine Alternative zur Verwendung von Aria, der integrierten Browser-KI von Opera. Dieses Setup bleibt bestehen, bis der Benutzer eine neue Interaktion mit der KI initiiert oder sich für die Reaktivierung von Aria entscheidet.

Hervorgehobener Bildnachweis: Oper