Große Sprachmodelle (LLMs) haben bemerkenswerte Fähigkeiten bewiesen – sie können im Gespräch chatten, kreative Textformate generieren und vieles mehr. Doch wenn man sie bittet, detaillierte, sachliche Antworten auf offene Fragen zu geben, kann es immer noch zu Defiziten kommen. LLMs liefern möglicherweise plausibel klingende, aber falsche Informationen, sodass Benutzer vor der Herausforderung stehen, Fakten von Fiktionen zu unterscheiden.

Google DeepMind, das führende KI-Forschungsunternehmen, geht dieses Problem direkt an. Ihr jüngster Artikel: „Langform-Faktizität in großen Sprachmodellen” führt Innovationen ein, sowohl bei der Messung der sachlichen Genauigkeit als auch bei der Art und Weise, wie wir sie in LLMs verbessern können.

LongFact: Ein Maßstab für sachliche Genauigkeit

DeepMind befasste sich zunächst mit dem Fehlen einer robusten Methode zum Testen von Fakten in Langform. Sie haben LongFact erstellt, einen Datensatz mit über 2.000 herausfordernden Eingabeaufforderungen zur Faktensuche, die detaillierte Antworten mit mehreren Absätzen erfordern. Diese Eingabeaufforderungen decken ein breites Spektrum an Themen zum Testen ab LLMDie Fähigkeit, sachliche Texte in verschiedenen Themenbereichen zu verfassen.

SICHER: Suchgestützte Faktizitätsbewertung

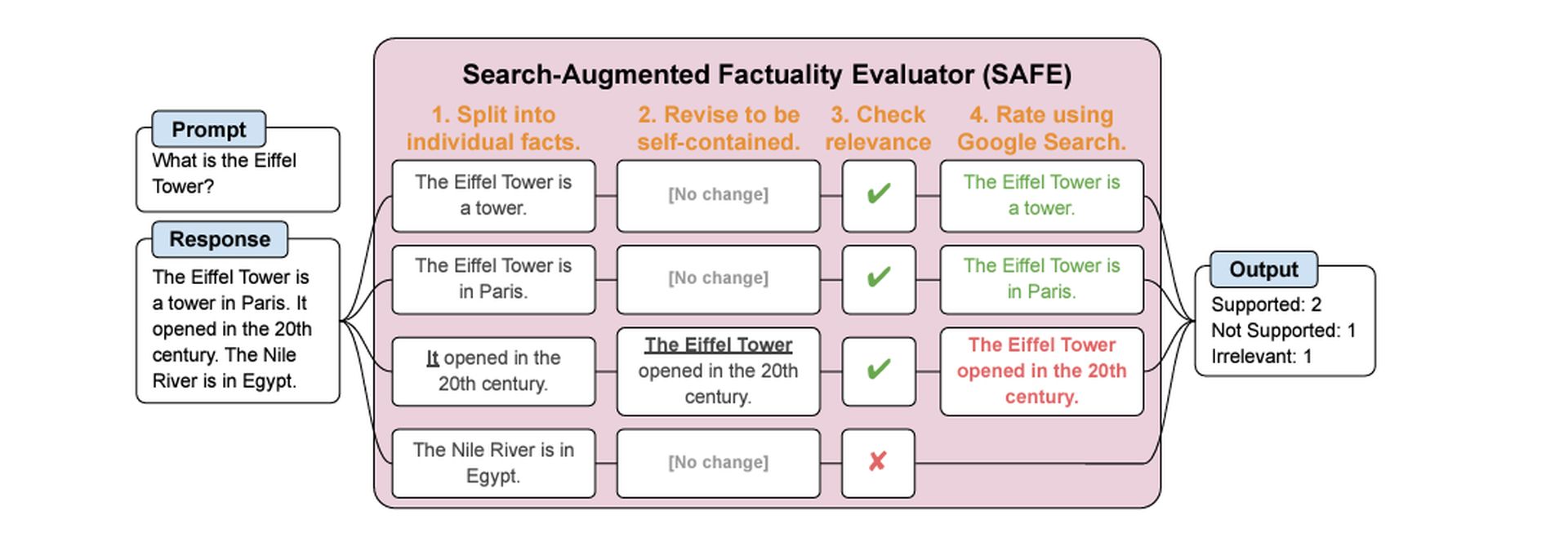

Die nächste Herausforderung bestand darin, herauszufinden, wie LLM-Antworten genau ausgewertet werden können. DeepMind hat das entwickelt Search-Augmented Factuality Evaluator (SICHER). Hier ist der Clou: SAFE selbst verwendet ein LLM, um diese Bewertung vorzunehmen!

So funktioniert das:

- Teilen Sie es auf: SAFE zerlegt eine lange LLM-Antwort in kleinere einzelne Sachaussagen.

- Suchen und überprüfen: Für jede sachliche Aussage erstellt SAFE Suchanfragen und sendet sie an die Google-Suche.

- Rufen Sie an: SAFE analysiert die Suchergebnisse und vergleicht sie mit der tatsächlichen Aussage, um festzustellen, ob die Aussage durch die Online-Beweise gestützt wird.

F1@K: Eine neue Metrik für lange Antworten

DeepMind schlug außerdem eine neue Methode zur Bewertung ausführlicher, sachlicher Antworten vor. Der herkömmliche F1-Score (der für Klassifizierungsaufgaben verwendet wird) war nicht für die Verarbeitung längerer, komplexerer Texte konzipiert. F1@K vergleicht Präzision (den Prozentsatz der bereitgestellten Fakten, die korrekt sind) mit einem Konzept namens Rückruf.

Der Recall berücksichtigt die ideale Antwortlänge eines Benutzers – schließlich könnte ein LLM durch die Bereitstellung einer einzigen richtigen Tatsache eine hohe Präzision erreichen, während eine detaillierte Antwort eine niedrigere Punktzahl erhalten würde.

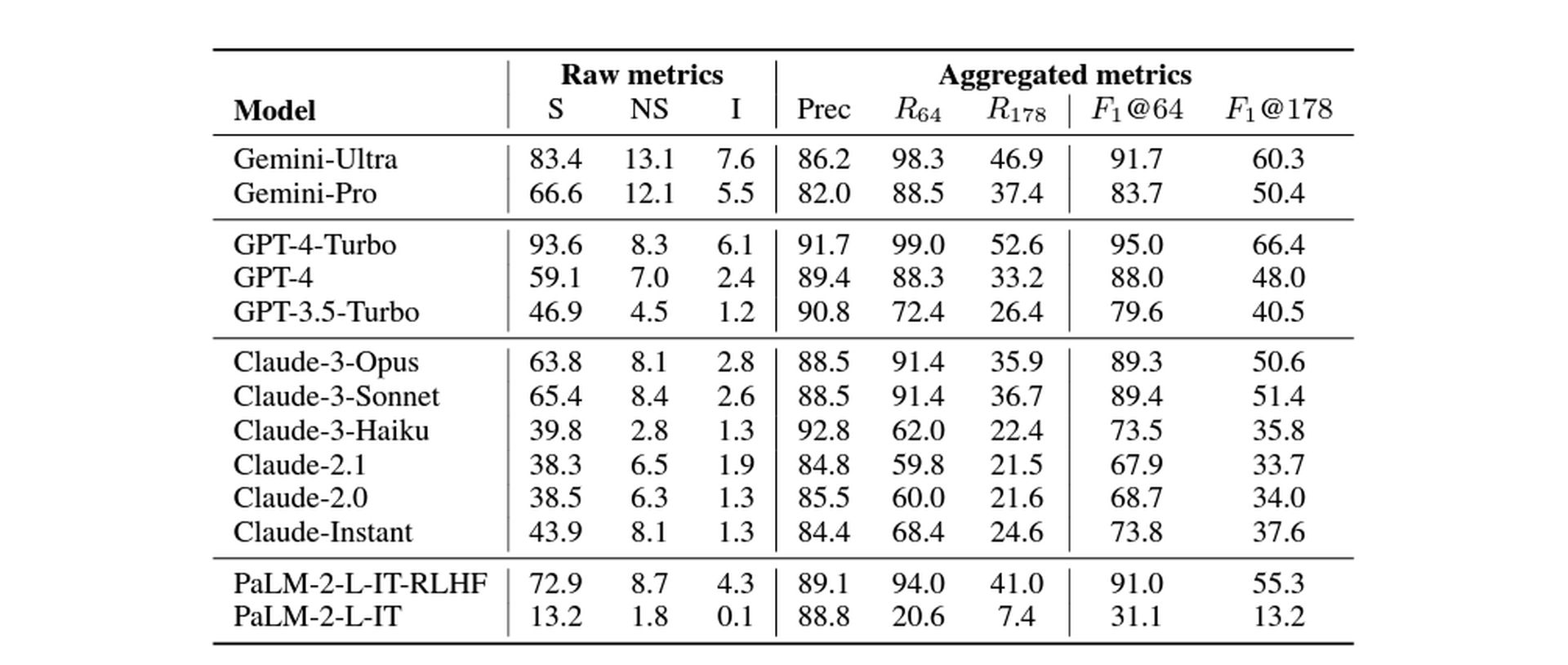

Größere LLMs, bessere Fakten

DeepMind hat eine Reihe großer Langue-Modelle unterschiedlicher Größe verglichen und ihre Ergebnisse stimmten mit der Annahme überein, dass größere Modelle tendenziell eine größere sachliche Genauigkeit in der Langform aufweisen. Dies kann durch die Tatsache erklärt werden, dass größere Modelle auf riesigen Text- und Codedatensätzen trainiert werden, was ihnen ein umfassenderes und umfassenderes Verständnis der Welt verleiht.

Stellen Sie sich einen LLM wie einen Studenten vor, der eine riesige Bücherbibliothek studiert hat. Je mehr Bücher der Schüler gelesen hat, desto wahrscheinlicher ist es, dass er auf sachliche Informationen zu einem breiten Themenspektrum gestoßen ist und diese im Gedächtnis behalten hat. Ebenso ist ein größerer LLM mit seinem breiteren Zugang zu Informationen besser in der Lage, sachlich fundierte Texte zu erstellen.

Um diese Messung durchzuführen, hat Google DeepMind die folgenden Modelle getestet: Zwillinge, GPT, Claude (Versionen 3 und 2) und Palme. Die Ergebnisse sind wie folgt:

Das Fazit: Vorsichtiger Optimismus

Die Studie von DeepMind zeigt einen vielversprechenden Weg zu LLMs auf, die zuverlässigere Sachinformationen liefern können. SAFE erreichte bei bestimmten Tests Genauigkeitsniveaus, die menschliche Bewerter übertrafen.

Es ist jedoch wichtig, die Einschränkungen zu beachten:

-

Suchmaschinenabhängigkeit: Die Genauigkeit von SAFE hängt von der Qualität der Suchergebnisse und der Fähigkeit des LLM ab, diese zu interpretieren.

-

Sich nicht wiederholende Fakten: Die F1@K-Metrik geht davon aus, dass eine ideale Antwort keine sich wiederholenden Informationen enthält.

Trotz möglicher Einschränkungen bringt diese Arbeit unbestreitbar einen entscheidenden Schritt weiter bei der Entwicklung wahrheitsgetreuer KI-Systeme. Während sich LLMs weiterentwickeln, könnte ihre Fähigkeit, Fakten genau zu vermitteln, tiefgreifende Auswirkungen darauf haben, wie wir diese Modelle verwenden, um Informationen zu finden und komplexe Themen zu verstehen.

Hervorgehobener Bildnachweis: Freepik