- Cerebras Systems stellt die Wafer Scale Engine 3 (WSE-3) vor, die als weltweit fortschrittlichster KI-Chip gilt und den KI-Supercomputer CS-3 mit einer Spitzenleistung von 125 PetaFLOPS antreibt.

- Der WSE-3-Chip verspricht, das KI-Training zu revolutionieren, die Effizienz deutlich zu steigern und gleichzeitig die Kosten- und Energieeffizienz beizubehalten. Er verfügt über vier Billionen Transistoren und verdoppelt die Leistung seines Vorgängers.

- Das CS-3-System mit 900.000 KI-Kernen und bis zu 1,2 Petabyte externem Speicher positioniert sich theoretisch unter den zehn besten Supercomputern weltweit und bietet ein beispielloses Potenzial für das Training und die Skalierbarkeit von KI-Modellen.

Die KI-Technologie, die von einigen als bahnbrechende Innovation gefeiert und von anderen als Segen für die Elite kritisiert wird, verfügt nun über einen bahnbrechenden Vorteil in ihrem Arsenal. Cerebras Systems hat den Schleier gelüftet Es handelt sich angeblich um den fortschrittlichsten KI-Chip der Welt, die Wafer Scale Engine 3 (WSE-3). Dieses Kraftpaket treibt den KI-Supercomputer Cerebras CS-3 an und verfügt über eine beispiellose Spitzenleistung von 125 PetaFLOPS sowie eine Skalierbarkeit, die die Grenzen des Möglichen verschiebt.

Was hat der WSE-3 von Cerebras zu bieten?

Wichtige Spezifikationen im Detail Pressemitteilung:

- 4 Billionen Transistoren

- 900.000 KI-Kerne

- 125 Petaflops maximale KI-Leistung

- 44 GB auf dem Chip SRAM

- 5-nm-TSMC-Prozess

- Externer Speicher: 1,5 TB, 12 TB, oder 1,2PB

- Trainiert KI-Modelle mit bis zu 24 Billionen Parametern

- Clustergröße von bis zu 2048 CS-3-Systemen

Bevor eine KI diese fesselnden Videos und Bilder erzeugen kann, durchläuft sie ein Training mit riesigen Datenmengenverschlingt das Energieäquivalent von über 100 Haushalte dabei. Allerdings verspricht dieser hochmoderne Chip zusammen mit den Computersystemen, die ihn nutzen, eine deutliche Beschleunigung und Effizienzsteigerung dieser Trainingsphase.

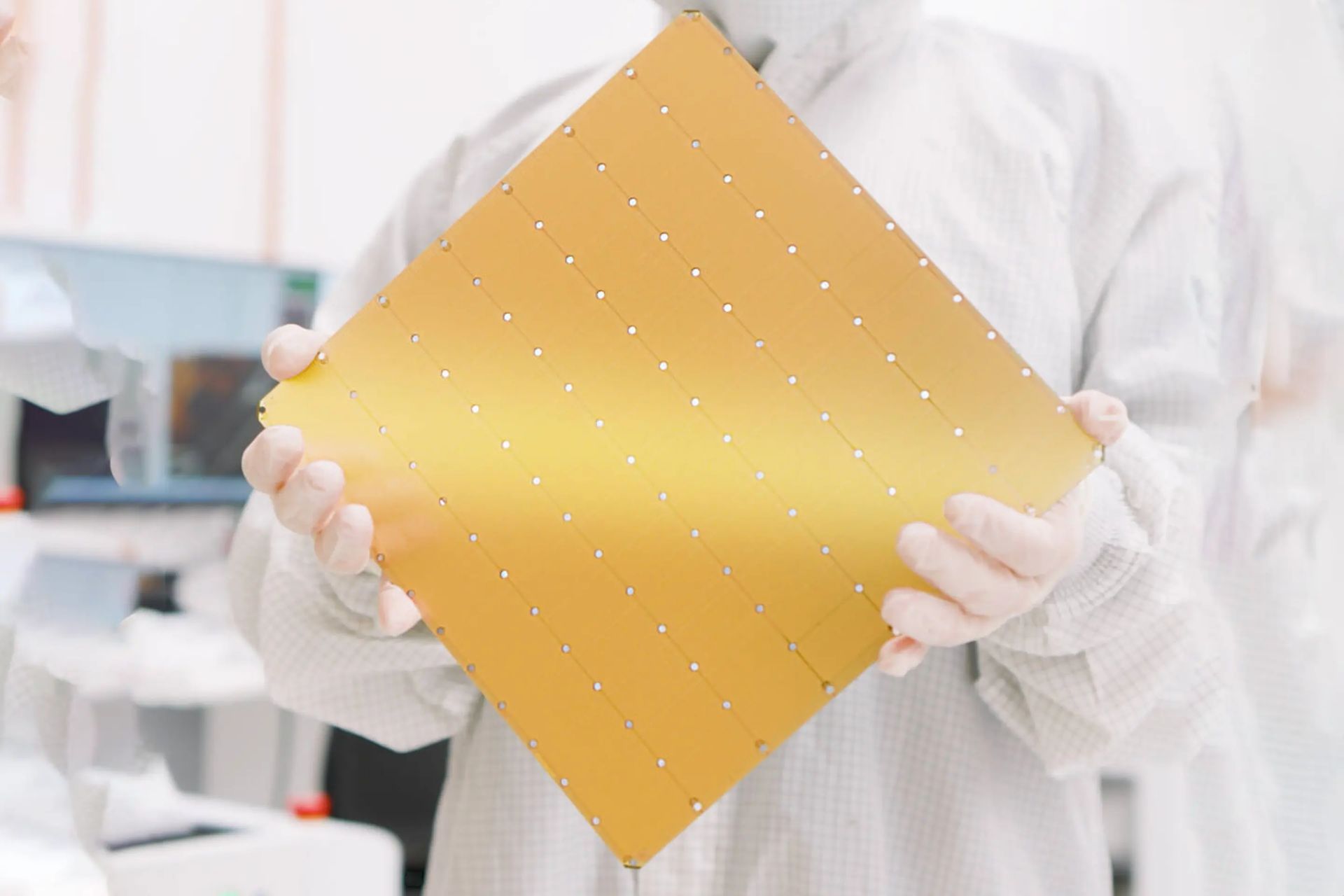

Der WSE-3-Chip, in der Größe vergleichbar mit einem Standard-Brettspiel, ist bemerkenswert mit vier Billionen Transistoren ausgestattet und erreicht die doppelte Leistung der vorherigen Iteration von Cerebras Systems – dem ehemaligen Spitzenreiter in Sachen Geschwindigkeit – und das bei gleichen Kosten und derselben Energieeffizienz. Integriert in das CS-3-System versprechen diese Chips, die Rechenleistung zu liefern, die einem ganzen Serverraum entspricht, und das alles kompakt in einer Einheit von der Größe eines Minikühlschranks.

Die USA verhandeln inmitten der Spannungen in China über den Verkauf von KI-Chips mit Nvidia

Cerebras betont, dass die CS-3 verfügt über 900.000 KI-Kerne und 44 GB On-Chip-SRAMin der Lage, eine KI-Spitzenleistung von zu erreichen 125 PetaFLOPS. Diese beeindruckende Spezifikation theoretisch positioniert den CS-3 unter den Top-10-Supercomputern weltweit. Ohne Benchmark-Tests bleibt die tatsächliche Leistung in realen Anwendungen jedoch spekulativ.

Um den unersättlichen Datenanforderungen der KI gerecht zu werden, bietet der CS-3 externe Speicherkonfigurationen von 1,5 TB auf stolze 1,2 Petabyte (PB), was 1.200 TB entspricht. Diese Kapazität ermöglicht das Training von KI-Modellen mit bis zu 24 Billionen Parameter, was die Größe der meisten aktuellen KI-Modelle, deren Parameter in Milliardenhöhe liegen, in den Schatten stellt, wobei GPT-4 auf rund 1,8 Billionen geschätzt wird. Cerebras schlägt vor CS-3 könnte Modelle mit einer Billion Parametern genauso mühelos trainieren, wie moderne GPU-basierte Systeme Modelle mit einer Milliarde Parametern verarbeiten.

Der innovative Wafer-Produktionsprozess hinter den WSE-3-Chips ermöglicht das skalierbare Design des CS-3. Es unterstützt das Clustering von bis zu 2.048 Einheiten und gipfelt in einem Supercomputing-Giganten, der 256 exaFLOPS erreichen kann. Dies würde die Leistung der weltweit führenden Supercomputer, die derzeit knapp über einem ExaFLOP arbeiten, in den Schatten stellen. Cerebras behauptet, dass diese beispiellose Fähigkeit das Training eines Llama 70B-Modells von Grund auf in nur einem Tag erleichtern könnte.

Hervorgehobener Bildnachweis: Kerem Gülen/Midjourney