Lernen Sie Mixtral 8x7B von Mistral AI kennen. Es ist superschlau im Umgang mit großen Datenmengen und kann bei Aufgaben wie dem Übersetzen von Sprachen und dem Generieren von Code helfen. Entwickler auf der ganzen Welt sind begeistert von dem Potenzial, ihre Projekte zu rationalisieren und die Effizienz zu verbessern. Mit seinem benutzerfreundlichen Design und seinen beeindruckenden Funktionen entwickelt sich Mixtral 8x7B schnell zu einem bevorzugten Werkzeug für die KI-Entwicklung.

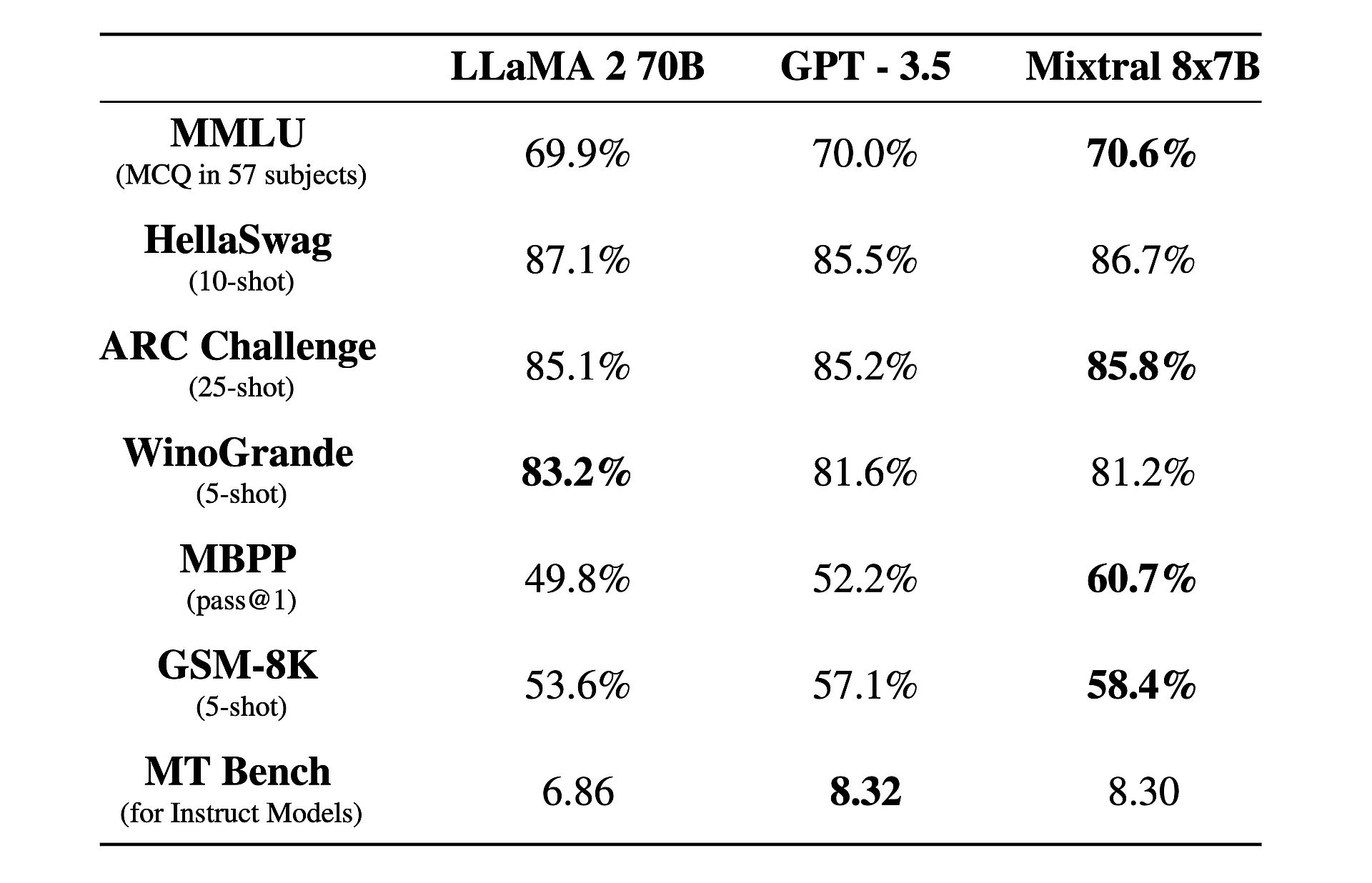

Außerdem gibt es eine interessante Tatsache: Die Leistung ist besser als GPT-3.5 Und Lama 2!

Was ist Mixtral 8x7B?

Mixtral 8x7B ist ein fortschrittliches Modell für künstliche Intelligenz, das von Mistral AI entwickelt wurde. Es nutzt eine einzigartige Architektur namens Sparse Mix-of-Experts (SMoE), um große Datenmengen effizient zu verarbeiten. Trotz seiner Komplexität ist Mixtral so konzipiert, dass es einfach zu verwenden und für verschiedene Aufgaben wie Sprachübersetzung und Codegenerierung anpassbar ist. Es übertrifft andere Modelle in puncto Geschwindigkeit und Genauigkeit und ist damit ein wertvolles Werkzeug für Entwickler. Außerdem ist es unter der Apache 2.0-Lizenz verfügbar, sodass jeder es frei verwenden und ändern kann.

Möchten Sie mehr erfahren? Im Wesentlichen funktioniert Mixtral 8x7B als reines Decoder-Modell und nutzt einen einzigartigen Ansatz, bei dem ein Feedforward-Block aus acht verschiedenen Parametergruppen, die als „Experten“ bezeichnet werden, auswählt. Diese Experten werden von einem Router-Netzwerk dynamisch ausgewählt, um jedes Token zu verarbeiten, was die Effizienz und Leistung steigert und gleichzeitig den Rechenaufwand minimiert.

Eine der Hauptstärken von Mixtral liegt in seiner Anpassungsfähigkeit und Skalierbarkeit. Capable kann Kontexte mit bis zu 32.000 Token verarbeiten und unterstützt mehrere Sprachen, darunter Englisch, Französisch, Italienisch, Deutsch und Spanisch. Mixtral ermöglicht es Entwicklern, ein breites Spektrum an Aufgaben einfach und präzise zu bewältigen.

Was Mixtral wirklich auszeichnet, ist sein Leistungs-Kosten-Verhältnis. Mit einer beeindruckenden Gesamtzahl von 46,7 Milliarden Parametern erreicht Mixtral eine bemerkenswerte Effizienz, indem nur ein Bruchteil dieser Parameter pro Token verwendet wird, was zu schnelleren Inferenzzeiten und geringeren Rechenkosten führt.

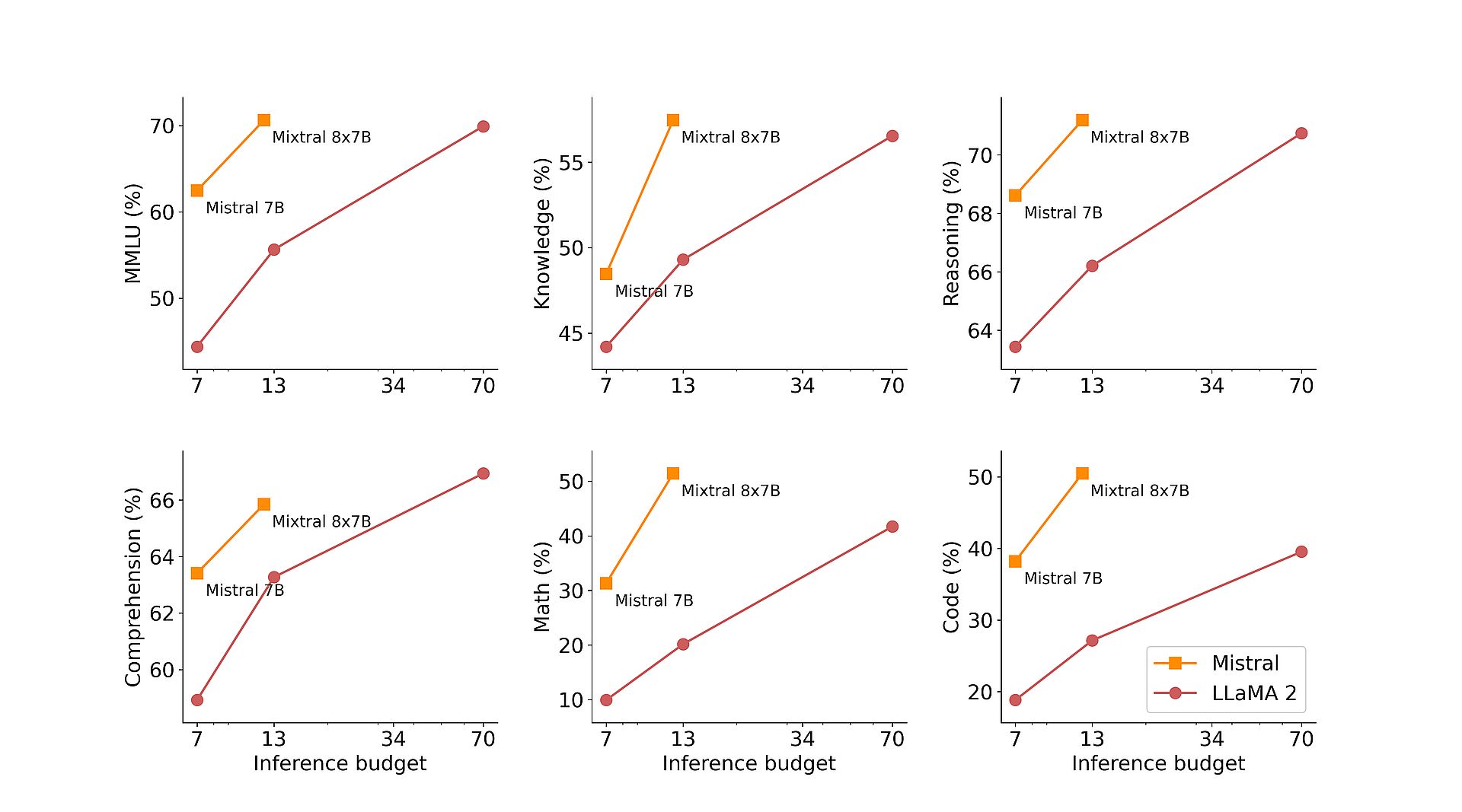

Darüber hinaus gewährleistet Mixtrals Vorschulung anhand umfangreicher, aus dem offenen Web extrahierter Datensätze Robustheit und Vielseitigkeit in realen Anwendungen. Ob es um Codegenerierung, Sprachübersetzung oder Sentimentanalyse geht, Mixtral liefert hervorragende Ergebnisse in verschiedenen Benchmarks und übertrifft traditionelle Modelle wie Llama 2 und übertrifft in vielen Fällen sogar GPT3.5.

Um seine Fähigkeiten weiter zu verbessern, hat Mistral AI Mixtral 8x7B Instruct eingeführt, eine spezielle Variante, die für Aufgaben zur Befolgung von Anweisungen optimiert ist. Mit einer beeindruckenden Punktzahl von 8,30 im MT-Bench festigt Mixtral 8x7B Instruct seine Position als führendes Open-Source-Modell für überwachte Feinabstimmung und Präferenzoptimierung.

Zusätzlich zu seinen technischen Fähigkeiten setzt sich Mistral AI dafür ein, den Zugang zu Mixtral zu demokratisieren, indem es zum vLLM-Projekt beiträgt und eine nahtlose Integration und Bereitstellung mit Open-Source-Tools ermöglicht. Dadurch können Entwickler die Leistungsfähigkeit von Mixtral für eine Vielzahl von Anwendungen und Plattformen nutzen und so Innovationen und Fortschritte im Bereich der künstlichen Intelligenz vorantreiben.

Groq KInicht Grok, röstet Elon Musk mit seinem „schnellsten LLM“

So verwenden Sie Mixtral 8x7B

Auf Mixtral 8x7B kann über Mistrals Endpunkt Mistral-Small zugegriffen werden, der sich im befindet Beta-Testphasene. Wenn Sie daran interessiert sind, frühzeitig Zugriff auf alle generativen und eingebetteten Endpunkte von Mistral zu erhalten, können Sie dies tun registrieren Jetzt. Wenn Sie sich registrieren, gehören Sie zu den Ersten, die alle Möglichkeiten von Mixtral 8x7B erleben und seine innovativen Lösungen entdecken können.