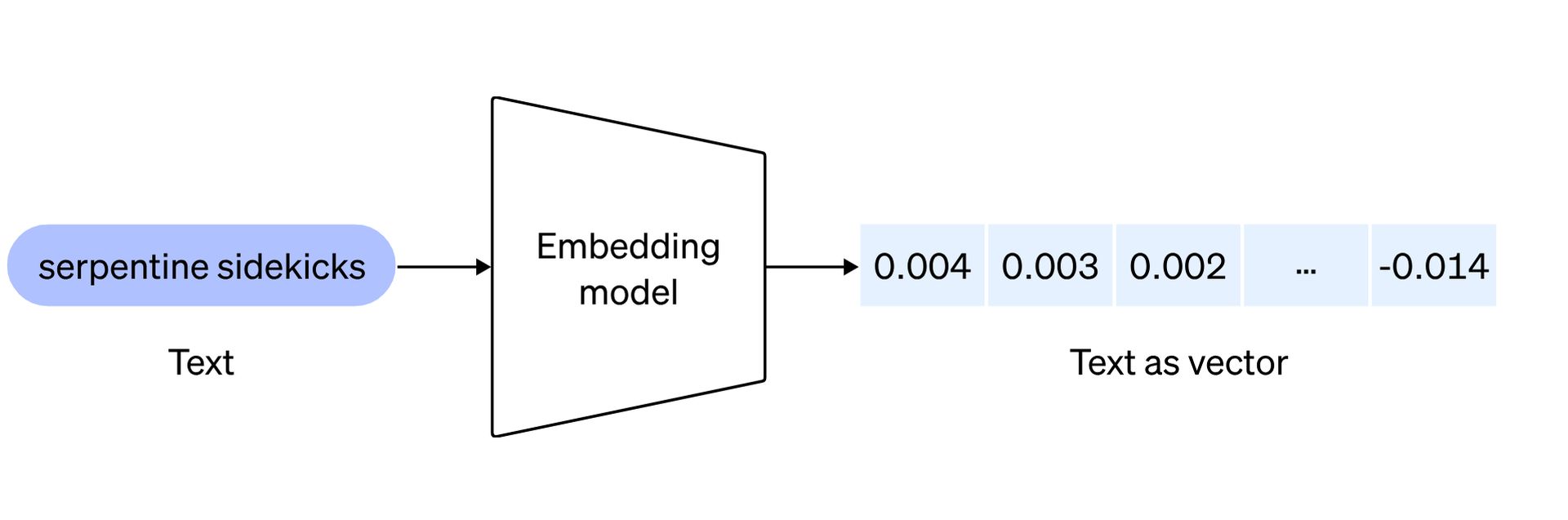

Der Bereich der künstlichen Intelligenz entwickelt sich mit neuen OpenAI-Einbettungsmodellen weiter. Sie sollen die Herangehensweise von Entwicklern an die Verarbeitung natürlicher Sprache neu definieren. Bevor wir uns mit den beiden bahnbrechenden Modellen befassen, die jeweils darauf ausgelegt sind, die Fähigkeiten von KI-Anwendungen zu verbessern, erfahren Sie hier Folgendes Einbettungen bedeuten:

Die Texteinbettungen von OpenAI dienen als Metrik zur Messung der Korrelation zwischen Textzeichenfolgen und finden Anwendungen in verschiedenen Bereichen, darunter:

- Suchen: Wird verwendet, um Ergebnisse basierend auf ihrer Relevanz für eine bestimmte Abfragezeichenfolge zu ordnen und so die Präzision der Suchergebnisse zu verbessern.

- Clustering: Wird zum Gruppieren von Textzeichenfolgen auf der Grundlage ihrer Ähnlichkeiten verwendet und erleichtert so die Organisation verwandter Informationen.

- Empfehlungen: Wird in Empfehlungssystemen verwendet, um Elemente vorzuschlagen, die in ihren Textzeichenfolgen Gemeinsamkeiten aufweisen, und so die Personalisierung von Vorschlägen zu verbessern.

- Anomalieerkennung: Wird zur Identifizierung von Ausreißern mit minimalem Zusammenhang verwendet und hilft bei der Erkennung unregelmäßiger Muster oder Datenpunkte.

- Diversitätsmessung: Wird zur Analyse von Ähnlichkeitsverteilungen verwendet und ermöglicht die Bewertung der Diversität innerhalb von Datensätzen oder Textkorpora.

- Einstufung: Wird bei Klassifizierungsaufgaben eingesetzt, bei denen Textzeichenfolgen nach ihrer ähnlichsten Bezeichnung kategorisiert werden, wodurch der Kennzeichnungsprozess in Anwendungen für maschinelles Lernen optimiert wird.

Jetzt sind Sie bereit, die neuen OpenAI-Einbettungsmodelle zu erkunden!

Neue OpenAI-Einbettungsmodelle sind da

Die Einführung der neuen OpenAI-Einbettungsmodelle markiert einen bedeutenden Sprung in der Verarbeitung natürlicher Sprache und ermöglicht es Entwicklern, Textinhalte besser darzustellen und zu verstehen. Schauen wir uns die Details dieser innovativen Modelle genauer an: Texteinbettung-3-klein Und Texteinbettung-3-groß.

Texteinbettung-3-klein

Dieses kompakte und dennoch leistungsstarke Modell weist gegenüber seinem Vorgänger text-embedding-ada-002 eine bemerkenswerte Leistungssteigerung auf. Beim Multi-Language-Retrieval-Benchmark (MIRACL) ist der durchschnittliche Wert von 31,4 % auf beeindruckende 44,0 % gestiegen. Auch beim Englisch-Aufgaben-Benchmark (MTEB) ist die durchschnittliche Punktzahl von 61,0 % auf 62,3 % lobenswert gestiegen. Was text-embedding-3-small jedoch auszeichnet, ist nicht nur die verbesserte Leistung, sondern auch seine Erschwinglichkeit.

| Evaluierungs-Benchmark | ada v2 | Texteinbettung-3-klein | Texteinbettung-3-groß |

| MIRACL-Durchschnitt | 31.4 | 44,0 | 54.9 |

| MTBB-Durchschnitt | 61,0 | 62.3 | 64,6 |

OpenAI hat die Preise erheblich gesenkt und ist im Vergleich zu text-embedding-ada-002 fünfmal kostengünstiger, wobei der Preis pro 1.000 Token von 0,0001 $ auf 0,00002 $ gesenkt wurde. Dies macht text-embedding-3-small nicht nur zu einer effizienteren Wahl, sondern auch zu einer leichter zugänglichen für Entwickler.

Texteinbettung-3-groß

text-embedding-3-large stellt die nächste Generation von Einbettungsmodellen dar und führt eine erhebliche Vergrößerung der Dimensionen ein und unterstützt Einbettungen mit bis zu 3072 Dimensionen. Dieses größere Modell bietet eine detailliertere und differenziertere Darstellung von Textinhalten. In puncto Leistung übertrifft text-embedding-3-large seinen Vorgänger in allen Benchmarks. Bei MIRACL ist die durchschnittliche Punktzahl von 31,4 % auf beeindruckende 54,9 % gestiegen, was die Kompetenz des Unternehmens bei der Suche in mehreren Sprachen unterstreicht.

| ada v2 | Texteinbettung-3-klein | Texteinbettung-3-groß | ||||

| Einbettungsgröße | 1536 | 512 | 1536 | 256 | 1024 | 3072 |

| Durchschnittlicher MTBB-Score | 61,0 | 61,6 | 62.3 | 62,0 | 64.1 | 64,6 |

Auch bei MTEB ist die durchschnittliche Punktzahl von 61,0 % auf 64,6 % gestiegen, was die Überlegenheit des Unternehmens bei Englischaufgaben unterstreicht. Mit einem Preis von 0,00013 US-Dollar pro 1.000 Token schafft text-embedding-3-large ein Gleichgewicht zwischen hervorragender Leistung und Kosteneffizienz und bietet Entwicklern eine robuste Lösung für Anwendungen, die hochdimensionale Einbettungen erfordern.

Treffen Google Lumiere AIBards Cousin, ein Videomacher

Native Unterstützung für die Verkürzung von Einbettungen

OpenAI erkennt die unterschiedlichen Bedürfnisse von Entwicklern an und führt native Unterstützung für die Verkürzung von Einbettungen ein. Mit dieser innovativen Technik können Entwickler die Einbettungsgröße anpassen, indem sie den API-Parameter „Dimensionen“ anpassen. Auf diese Weise können Entwickler einen Teil der Leistung gegen eine kleinere Vektorgröße eintauschen, ohne die grundlegenden Eigenschaften der Einbettung zu beeinträchtigen. Diese Flexibilität ist besonders wertvoll in Szenarien, in denen Systeme Einbettungen nur bis zu einer bestimmten Größe unterstützen, wodurch Entwicklern ein vielseitiges Tool für verschiedene Nutzungsszenarien zur Verfügung gestellt wird.

Zusammenfassend stellen die neuen Einbettungsmodelle von OpenAI einen bedeutenden Fortschritt in Bezug auf Effizienz, Erschwinglichkeit und Leistung dar. Ganz gleich, ob sich Entwickler für die kompakte, aber effiziente Darstellung von Text-Embedding-3-Small oder die umfangreicheren und detaillierteren Einbettungen von Text-Embedding-3-Large entscheiden, diese Modelle geben Entwicklern vielseitige Werkzeuge an die Hand, um tiefere Erkenntnisse aus Textdaten in ihrer KI zu gewinnen Anwendungen.

Für detailliertere Informationen zu den neuen OpenAI-Einbettungsmodellen klicken Sie auf Hier und erhalten Sie die offizielle Ankündigung.

Hervorgehobener Bildnachweis: Levart_Photographer/Unsplash