Eine coole Entwicklung hat sich jedoch mit OpenVoice ergeben, einer gemeinsamen Entwicklung von Teams des Massachusetts Institute of Technology (MIT), der Tsinghua-Universität in Peking und der kanadischen KI-Firma MyShell. OpenVoice ist eine Open-Source-Plattform für das Klonen von Stimmen, die sich durch schnelle Verarbeitung und erweiterte Anpassungsmöglichkeiten auszeichnet und sich von bestehenden Technologien zum Klonen von Stimmen unterscheidet.

Heute sind wir stolz darauf, unseren OpenVoice-Algorithmus als Open-Source-Lösung zu veröffentlichen und dabei unserem Kerngedanken gerecht zu werden: KI für alle.

Jetzt erleben: https://t.co/zHJpeVpX3t. Klonen Sie Stimmen mit beispielloser Präzision und detaillierter Klangsteuerung, von Emotionen bis hin zu Akzenten, Rhythmus, Pausen und Intonation, mit nur einem… pic.twitter.com/RwmYajpxOt

– MyShell (@myshell_ai) 2. Januar 2024

Um die Zugänglichkeit und Transparenz zu verbessern, hat das Unternehmen einen Link zu seiner gründlich überprüften Version veröffentlicht Forschungsbericht Einzelheiten zur Entwicklung von OpenVoice. Darüber hinaus haben sie Zugangspunkte bereitgestellt, über die Benutzer mit dieser Technologie experimentieren können. Dazu gehören die MyShell-Web-App-Schnittstelle, für die eine Benutzerregistrierung erforderlich ist, und Umarmendes Gesichtfür die Öffentlichkeit ohne Account zugänglich.

MyShell ist bestrebt, einen Beitrag zur breiteren Forschungsgemeinschaft zu leisten, und betrachtet OpenVoice nur als den Anfang. Für die Zukunft planen sie, die Unterstützung durch Zuschüsse, Datensätze und Computerressourcen auszuweiten, um die Open-Source-Forschung zu stärken. Das Leitprinzip von MyShell lautet „KI für alle“ und betont die Bedeutung von Sprache, Vision und Stimme als die drei Schlüsselkomponenten der zukünftigen künstlichen allgemeinen Intelligenz (AGI).

Im Forschungsbereich haben sich die Sprach- und Sehmodalitäten in Open-Source-Modellen erheblich weiterentwickelt, im Sprachsektor besteht jedoch weiterhin eine Lücke. Insbesondere besteht Bedarf an einem robusten, sofort reagierenden Modell zum Klonen von Stimmen, das anpassbare Funktionen zur Sprachgenerierung bietet. MyShell möchte diese Lücke schließen und die Grenzen der Sprachtechnologie in AGI erweitern.

Treffen Murf-KI: Text-to-Speech-Voiceovers in Sekundenschnelle

Wie verwende ich Myshell AI?

Folge diesen Schritten:

- Gehen Sie zur offiziellen Website von MyShell AI.

- Klicken Sie auf „App starten“

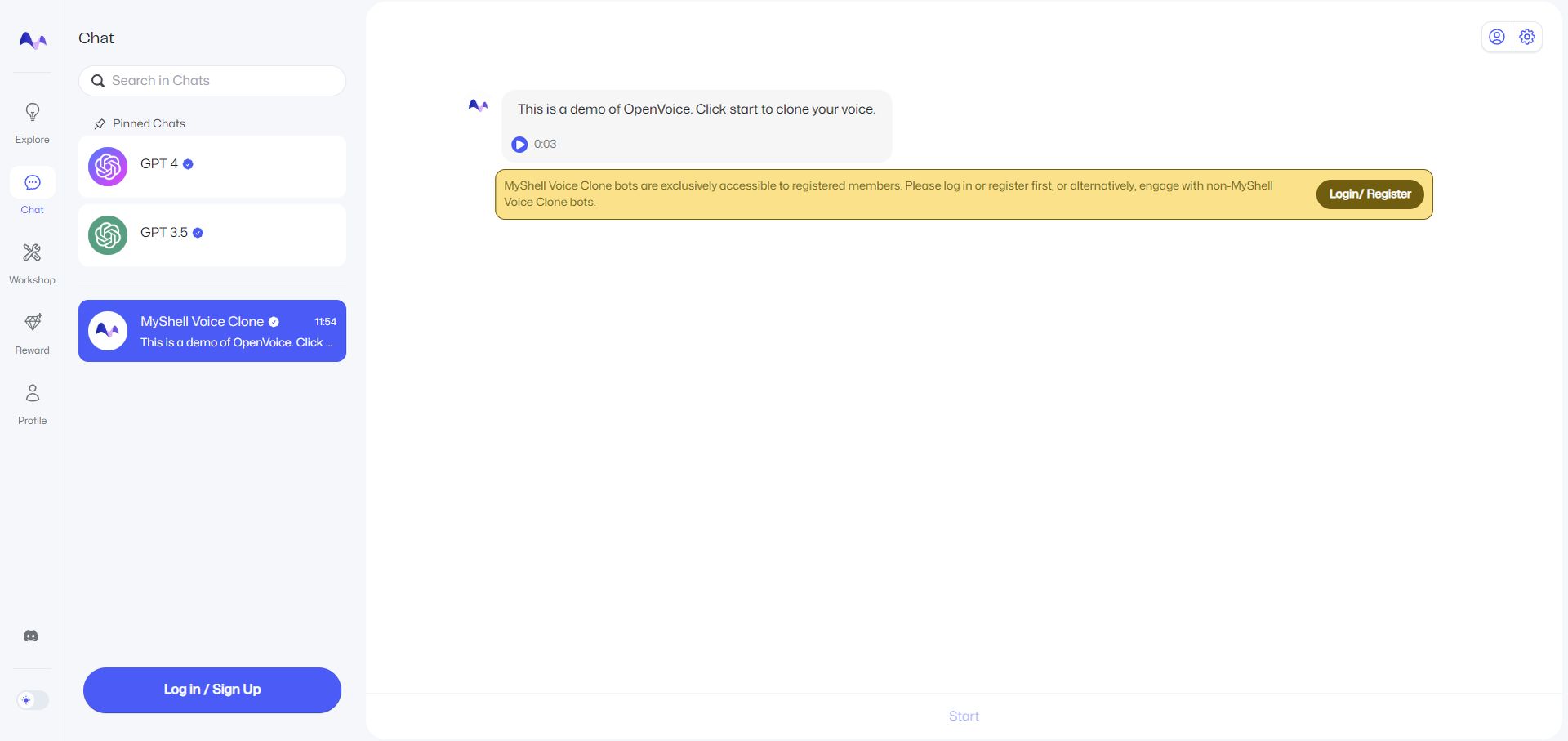

- Wählen Sie auf der linken Seite „Chat“ aus.

- Um die Funktion „MyShell Voice Clone“ nutzen zu können, müssen Sie sich mit einem Konto anmelden. Sie können jederzeit ein Google-Konto verwenden.

- Klicken Sie anschließend auf „Start“, es befindet sich unten auf der Seite.

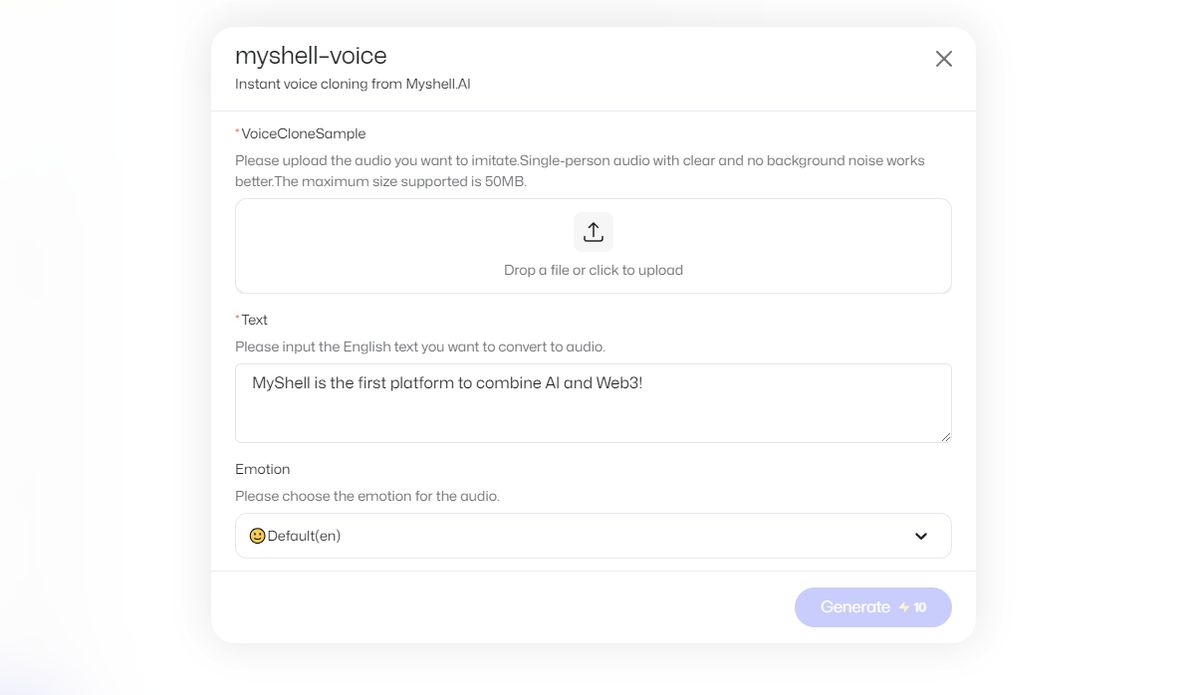

- Laden Sie eine Sprachaufnahme hoch und geben Sie den englischen Text ein, den Sie in Audio umwandeln möchten.

- Klicken Sie auf „Generieren“, dies kostet 10 In-App-Währung.

- Ihre Ausgabe wird Ihnen per Chat zugesandt.

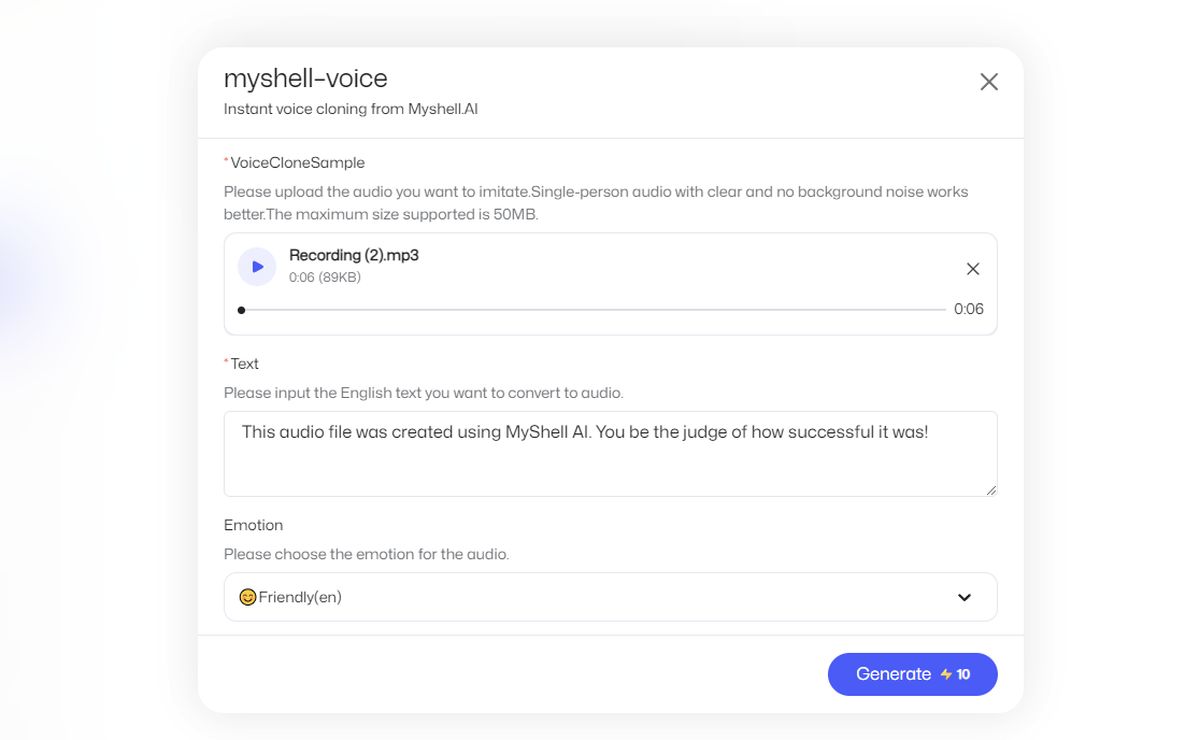

Anmerkung der Redaktion: Als Referenz habe ich eine eigene Sprachaufnahme hochgeladen, in der es heißt: „Die Technologie zum Klonen von Stimmen macht Fortschritte und Start-ups wie ElevenLabs haben bemerkenswerte Fortschritte gemacht.“

Dann wurde nach einer Ausgabe gefragt, die lautet: „Diese Audiodatei wurde mit MyShell AI erstellt. Wie erfolgreich es war, können Sie selbst beurteilen!“

Eingang:

Ausgabe:

Ich würde die Ausgabe nicht als sehr erfolgreich bezeichnen, aber es ist erstaunlich zu sehen, wie schnell sie ist. Fügen Sie hinzu, dass ich kein Muttersprachler bin.

Wie funktioniert die OpenVoice-Technologie?

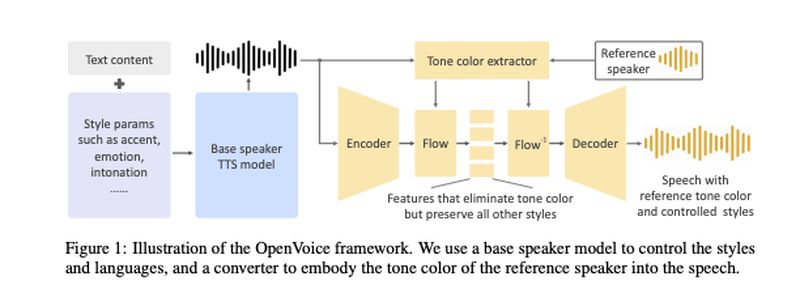

Die OpenVoice-Technologie, die von Qin, Wenliang Zhao und Xumin Yu von der Tsinghua-Universität zusammen mit Xin Sun von MyShell entwickelt wurde, wird in ihrer wissenschaftlichen Arbeit dargelegt. Diese KI zum Klonen von Stimmen basiert auf einer Dual-Modell-Architektur: einem Text-to-Speech (TTS)-Modell und einem „Tonkonverter“.

Das TTS-Modell ist für die Verwaltung von Stilparametern und Sprachen verantwortlich. Das Training wurde mit 30.000 Sätzen Audiobeispielen durchgeführt, darunter Stimmen mit amerikanischen und britischen Akzenten auf Englisch sowie Chinesisch- und Japanischsprechern. Diese Proben wurden deutlich gekennzeichnet, um die darin zum Ausdruck gebrachten Emotionen widerzuspiegeln. Aus diesen Clips lernte das Modell Nuancen wie Intonation, Rhythmus und Pausen.

Andererseits wurde das Tonwandlermodell mit einem umfangreichen Datensatz von über 300.000 Audioproben von mehr als 20.000 verschiedenen Sprechern trainiert.

In beiden Modellen wurde der Ton menschlicher Sprache in Phoneme umgewandelt – die grundlegenden Lauteinheiten, die Wörter unterscheiden. Diese wurden dann durch Vektoreinbettungen dargestellt.

Der einzigartige Prozess umfasst die Verwendung eines „Basislautsprechers“ im TTS-Modell in Kombination mit einem Ton, der aus den aufgezeichneten Audiodaten eines Benutzers abgeleitet wird. Durch diese Kombination können die Modelle nicht nur die Stimme des Benutzers reproduzieren, sondern auch die „Klangfarbe“, also den emotionalen Ausdruck des gesprochenen Textes, verändern.

Das Team fügte seiner Arbeit ein Diagramm bei, um zu veranschaulichen, wie diese beiden Modelle interagieren:

Sie betonen, dass ihre Methode konzeptionell unkompliziert und dennoch effektiv ist. Es erfordert außerdem deutlich weniger Rechenressourcen im Vergleich zu anderen Voice-Cloning-Methoden, wie etwa der Voicebox von Meta.

„Wir wollten das bislang flexibelste Modell zum sofortigen Klonen von Stimmen entwickeln. Flexibilität bedeutet hier flexible Kontrolle über Stile/Emotionen/Akzente usw. und kann sich an jede Sprache anpassen. Das konnte vorher niemand machen, weil es zu schwierig ist. Ich leite eine Gruppe erfahrener KI-Wissenschaftler und habe mehrere Monate damit verbracht, die Lösung zu finden. Wir haben festgestellt, dass es eine sehr elegante Möglichkeit gibt, die schwierige Aufgabe in einige machbare Teilaufgaben zu zerlegen, um das zu erreichen, was insgesamt zu schwierig erscheint. „Die entkoppelte Pipeline erweist sich als sehr effektiv, aber auch sehr einfach“, sagte Qin in einer E-Mail von VentureBeat.