Apple hat diskret das Ferret LLM eingeführt, ein multimodales Sprachmodell, das alles andere als gewöhnlich ist. Dieser stille Start weicht von der Norm ab, indem er Sprachverständnis mit Bildanalyse verbindet und so den Umfang der KI-Fähigkeiten neu definiert.

Ferret LLM wurde stillschweigend auf GitHub veröffentlicht und stellt Apples subtilen Schritt in Richtung Offenheit dar, der Entwickler und Forscher dazu einlädt, sein Potenzial auszuschöpfen. Allerdings drohen bei der Markteinführung Herausforderungen bei der Skalierung von Ferret im Vergleich zu größeren Modellen, was infrastrukturbedingte Hürden mit sich bringt. Dennoch ist der potenzielle Einfluss von Ferret auf Apple-Geräten beträchtlich und verspricht eine neue Dimension der Benutzerinteraktionen und ein tieferes Verständnis visueller Inhalte. Möchten Sie mehr erfahren? Wir haben alles zusammengetragen, was Sie über Apples neuesten Schritt in der KI-Landschaft wissen müssen.

Was ist Apple Ferret LLM?

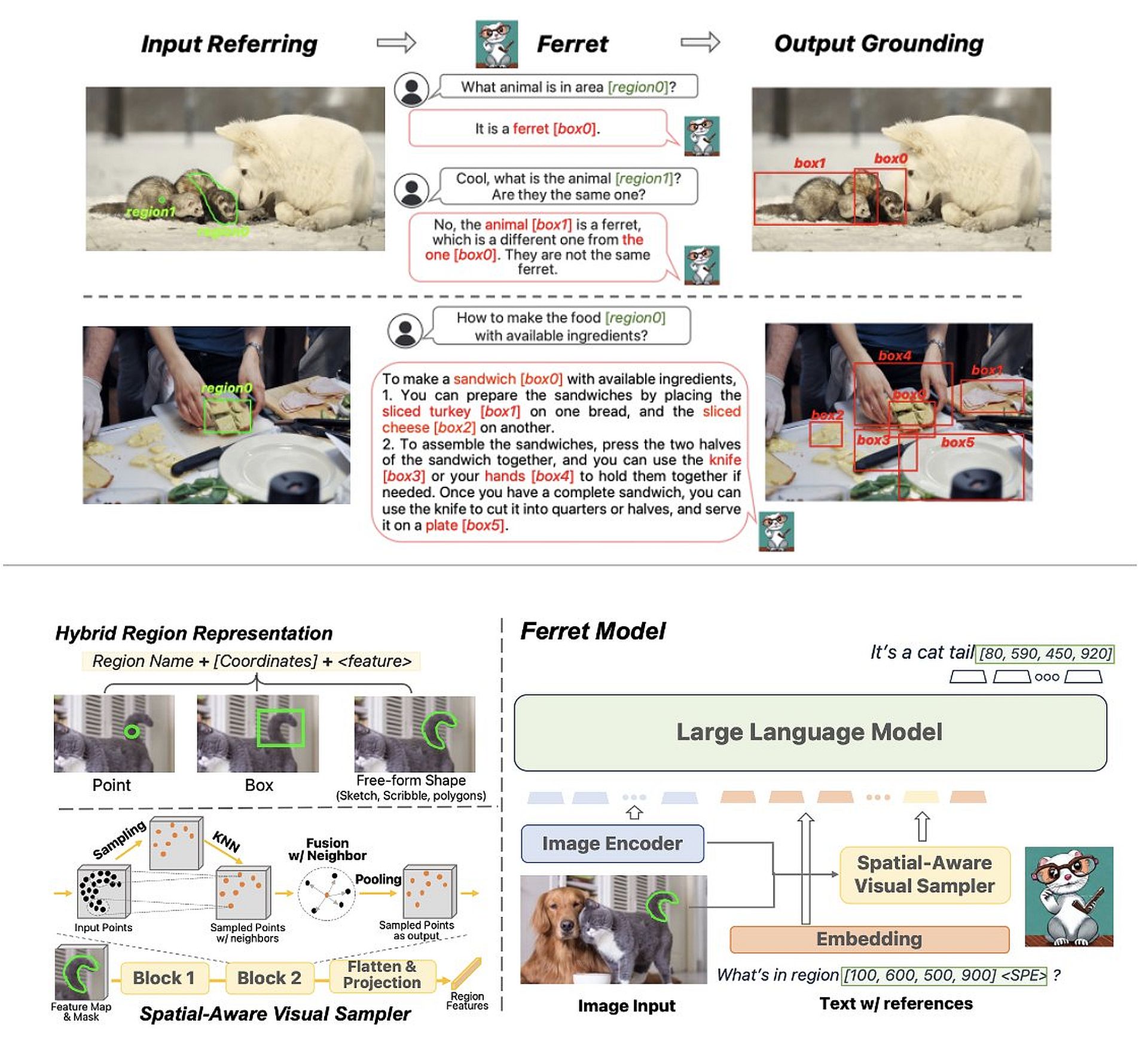

Ferret, ein multimodales Open-Source-LLM (Multimodal Large Language Model), das von Apple Inc. in Zusammenarbeit mit der Cornell University entwickelt wurde, zeichnet sich durch seine einzigartige Integration von Sprachverständnis und Bildanalyse aus. Veröffentlicht am GitHubEs weicht von traditionellen Sprachmodellen ab, indem es visuelle Elemente in seine Verarbeitung einbezieht.

So funktioniert das Apple Ferret LLM:

- Visuelle Integration: Ferret beschränkt sich nicht auf das Textverständnis, sondern analysiert bestimmte Bildbereiche und identifiziert darin enthaltene Elemente. Diese Elemente werden dann als Teil einer Abfrage verwendet, sodass Ferret auf Eingabeaufforderungen reagieren kann, die sowohl Text als auch Bilder umfassen.

- Kontextbezogene Antworten: Wenn Ferret beispielsweise gebeten wird, ein Objekt in einem Bild zu identifizieren, erkennt es nicht nur das Objekt, sondern nutzt auch umgebende Elemente, um tiefere Einblicke oder einen Kontext zu liefern, der über die bloße Objekterkennung hinausgeht.

Zhe Gan, ein Apple-KI-Forschungswissenschaftler, betonte die Fähigkeit von Ferret, Referenzen zu erstellen und zu erstellen Elemente in Bildern auf verschiedenen Detailebenen verstehen. Diese Flexibilität ermöglicht es Ferret, Anfragen mit komplexen visuellen Inhalten zu verstehen.

Was die Einführung von Ferret auszeichnet, ist seine technologische Leistungsfähigkeit und Apples strategischer Schritt in Richtung Offenheit. Abweichend von seiner normalerweise zurückhaltenden Natur hat Apple beschlossen, Ferret als zu veröffentlichen Open Source Modell. Dieser Wandel hin zur Transparenz bedeutet einen kollaborativen Ansatz, der Beiträge einlädt und ein Ökosystem fördert, in dem Forscher und Entwickler weltweit die Fähigkeiten des Modells verbessern, verfeinern und erkunden können

Zukünftige Herausforderungen

Das Auftauchen von Ferret läutet eine neue Ära in der KI ein, in der multimodales Verständnis eher zur Norm als zur Ausnahme wird. Seine Fähigkeiten öffnen Türen zu unzähligen Anwendungen in verschiedenen Bereichen, von verbesserter Inhaltsanalyse bis hin zu innovativen Mensch-KI-Interaktionen.

Allerdings steht Apple bei der Skalierung von Ferret aufgrund von Infrastruktureinschränkungen vor Herausforderungen, was Fragen über seine Fähigkeit aufwirft, mit Branchenriesen wie zu konkurrieren GPT-4 bei der Bereitstellung umfangreicher Sprachmodelle. Dieses Dilemma erfordert strategische Entscheidungen, die möglicherweise Partnerschaften oder die stärkere Übernahme von Open-Source-Prinzipien umfassen, um kollektives Fachwissen und Ressourcen zu nutzen.

Ausführlichere Informationen zum Apple Ferret LLM finden Sie unter seine arXiv-Seite.

Mögliche Auswirkungen von Apple Ferret LLM auf iPhones und andere Apple-Geräte

Die Einführung von Apples Ferret LLM könnte möglicherweise erhebliche Auswirkungen auf verschiedene Apple-Produkte haben, insbesondere durch die Verbesserung der Benutzererfahrung und Funktionalitäten auf folgende Weise:

Verbesserte bildbasierte Interaktionen

Die Bildanalyseintegration von Apple Ferret LLM in Siri könnte anspruchsvollere und kontextbezogenere Interaktionen ermöglichen. Benutzer können möglicherweise Fragen zu Bildern stellen oder Aktionen basierend auf visuellen Inhalten anfordern.

Die Fähigkeiten von Ferret könnten erweiterte visuelle Suchfunktionen innerhalb des Apple-Ökosystems vorantreiben. Benutzer können in Bildern nach Elementen oder Informationen suchen, was zu einem intuitiveren und umfassenderen Sucherlebnis führt.

Erweiterte Benutzerunterstützung

Die Fähigkeit von Ferret, Bilder zu interpretieren und kontextbezogene Informationen bereitzustellen, könnte Benutzern mit Barrierefreiheitsbedürfnissen von großem Nutzen sein. Es könnte sehbehinderten Benutzern dabei helfen, Objekte oder Szenen zu identifizieren und ihre täglichen Interaktionen mit Apple-Geräten zu verbessern.

Die Integration von Ferret könnte die Fähigkeiten von Apples ARKit erweitern und anspruchsvollere und interaktivere Augmented-Reality-Erlebnisse basierend auf Bildverständnis und kontextbezogenen Reaktionen ermöglichen.

Erweitertes Medien- und Inhaltsverständnis

Ferret könnte die Organisation und Suchfunktionen innerhalb der Fotos-App verbessern, indem es bestimmte Elemente in Bildern und Videos erkennt und indiziert und so eine intelligentere Kategorisierung und Suche ermöglicht.

Durch die Nutzung des Bildverständnisses von Ferret könnte Apple personalisiertere Inhaltsempfehlungen anbieten, die auf den Interaktionen der Benutzer mit visuellen Inhalten in seinem gesamten Ökosystem basieren.

Entwicklerinnovation

Entwickler könnten die Fähigkeiten von Ferret nutzen, um innovative Anwendungen in verschiedenen Bereichen, vom Bildungswesen bis zum Gesundheitswesen, zu erstellen, indem sie fortschrittliches Bild- und Sprachverständnis in ihre Apps integrieren.

Die Implementierung der Fähigkeiten von Ferret in Apple-Produkte würde jedoch von verschiedenen Faktoren abhängen, darunter der technologischen Machbarkeit, Überlegungen zum Datenschutz der Benutzer und dem Ausmaß der Integration in bestehende Apple-Software und -Hardware. Darüber hinaus werden die strategischen Entscheidungen von Apple hinsichtlich der Skalierbarkeit und des Einsatzes von Ferret innerhalb seiner Produktpalette die tatsächlichen Auswirkungen auf verbraucherorientierte Features und Funktionalitäten bestimmen.

Hervorgehobener Bildnachweis: Jhon Paul Dela Cruz/Unsplash