Meta hat zwei bahnbrechende Fortschritte im Bereich der generativen KI eingeführt: Emu Video und Emu Edit. Diese Entwicklungen stellen bedeutende Fortschritte im Bereich der generativen KI dar und bieten Einzelpersonen transformative Fähigkeiten, um ihre Kreativität auf innovative Weise auszudrücken.

Obwohl die Verwendung von KI-generierten Bildern und Videos viel Kritik hervorgerufen hat, bringt ihre ordnungsgemäße Verwendung viele potenzielle Vorteile mit sich. Benutzer können jetzt in Sekundenschnelle fast alles zeichnen, was sie sich vorstellen können, einschließlich KI-generierte Comics, auch ohne jegliche Bildung. Alles, was ein Mensch heutzutage tun muss, um ein atemberaubendes Bild zu erstellen, ist, sich einen Hinweis auszudenken und ihn aufzuschreiben.

Wir wissen fast alle, wie sehr sich Meta in den letzten Jahren auf KI-Technologien konzentriert hat, und haben vor einigen Tagen zwei leistungsstarke Tools zur Videoerstellung und Bildbearbeitung angekündigt Blogeintrag.

Was ist Emu-Video?

Emu Video ist eine revolutionäre Plattform zur Text-zu-Video-Generierung, die Folgendes nutzt Diffusionsmodelle um den Prozess zu rationalisieren. Der Videogenerierungsprozess ist in zwei verschiedene Phasen unterteilt:

- Generieren von Bildern basierend auf Textaufforderungen

- Anschließend Erstellung von Videos, die sowohl auf Text als auch auf Bildern basieren

Dieser Ansatz ermöglicht es Emu Video, einen effizienteren und effektiveren Arbeitsablauf im Vergleich zu früheren Methoden zu erreichen, die mehrere Modelle erforderten. Emu Video verwendet nur zwei Diffusionsmodelle, um hochauflösende (512 x 512) Vier-Sekunden-Videos mit einer Rate von 16 Bildern pro Sekunde zu produzieren.

Insbesondere haben menschliche Bewertungen die außergewöhnliche Leistung der Videogenerierung von Emu Video unterstrichen, die frühere Benchmarks deutlich übertrifft. Tatsächlich bevorzugten 96 % der Befragten das Modell von Emu Video gegenüber Make-A-Video in Bezug auf die Qualität, wobei 85 % den Vorzug in Bezug auf die Treue zur Textaufforderung gaben.

Die Vielseitigkeit von Emu Video wird außerdem durch seine Fähigkeit unter Beweis gestellt, vom Benutzer bereitgestellte Bilder basierend auf Textaufforderungen zu „animieren“.

Zu den Hauptmerkmalen gehören:

- Einheitliche Architektur für Videogenerierungsaufgaben,

- Unterstützung für:

- Nur Text

- Nur Bild

- Kombinierte Eingaben

- Ein faktorisierter Ansatz für effizientes Training

- Modernste Leistung bei menschlichen Bewertungen

Emu Video stellt einen Paradigmenwechsel in der Text-zu-Video-Generierung dar und nutzt Diffusionsmodelle, um den Prozess zu rationalisieren. Der zweistufige Ansatz der Plattform zur Videogenerierung stellt eine deutliche Abkehr von früheren Methoden dar, die mehrere Modelle erforderten.

In der ersten Phase generiert Emu Video Bilder basierend auf Textaufforderungen, während es in der zweiten Phase Videos erstellt, die sowohl auf Text als auch auf Bildern basieren. Dieser Ansatz ermöglicht es Emu Video, einen effizienteren und effektiveren Arbeitsablauf zu erreichen, was zu qualitativ hochwertigen Videos führt, die frühere Benchmarks deutlich übertreffen.

Emu Video verwendet nur zwei Diffusionsmodelle, um hochauflösende (512 x 512) Vier-Sekunden-Videos mit einer Rate von 16 Bildern pro Sekunde zu produzieren. Dieser optimierte Ansatz zur Videogenerierung wurde von den Nutzern gut angenommen: 96 % der Befragten bevorzugten in puncto Qualität das Modell von Emu Video gegenüber Make-A-Video. Darüber hinaus bevorzugten 85 % der Befragten das Modell von Emu Video im Hinblick auf die Treue zur Textaufforderung.

Die Vielseitigkeit von Emu Video wird außerdem durch seine Fähigkeit unter Beweis gestellt, vom Benutzer bereitgestellte Bilder basierend auf Textaufforderungen zu „animieren“. Mit dieser Funktion können Benutzer Videos erstellen, die auf ihre spezifischen Bedürfnisse und Vorlieben zugeschnitten sind. Emu Video verfügt außerdem über eine einheitliche Architektur für Videogenerierungsaufgaben, Unterstützung für Nur-Text-, Nur-Bild- und kombinierte Eingaben, einen faktorisierten Ansatz für effizientes Training und modernste Leistung bei menschlichen Bewertungen.

Möglicherweise erfahren Sie mehr darüber Emu-Video über den Link hier.

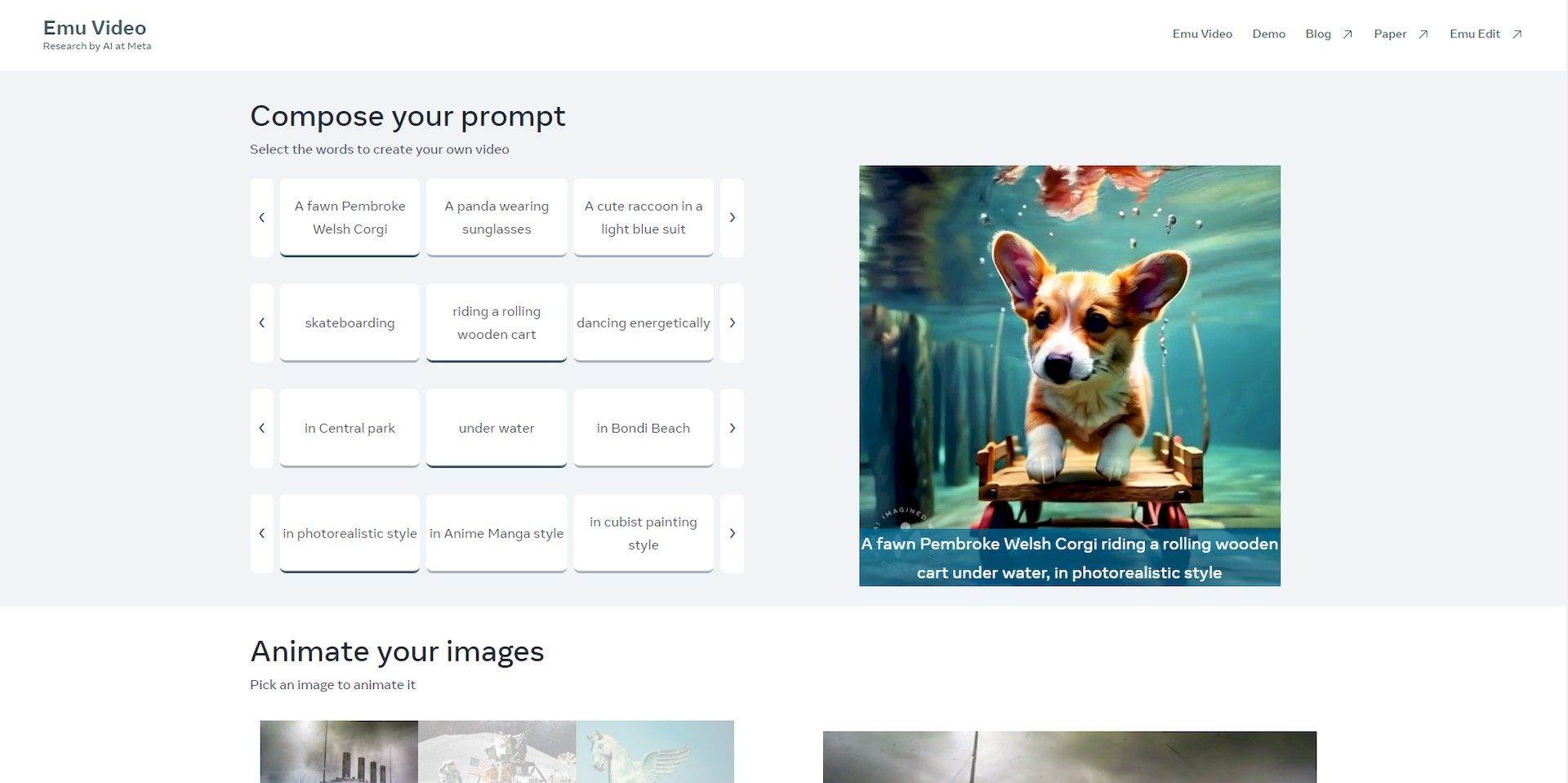

Meta hat auch eine Demo-Site veröffentlicht für Benutzer, die die Videogenerierungsfunktionen von Emu ausprobieren möchten.

In der Demo gibt es viele Optionen für generierte Videos, bei denen Sie das Thema, die Aktivität, den Ort und den Generierungsstil auswählen können. Außerdem gibt es unten auf der Website eine Suchregisterkarte für generierte Videos. Auch wenn Sie kein eigenes Video erstellen können, können Sie über diesen Link die Videos sehen, die Meta während der Recherche generiert hat.

Was ist Emu Edit?

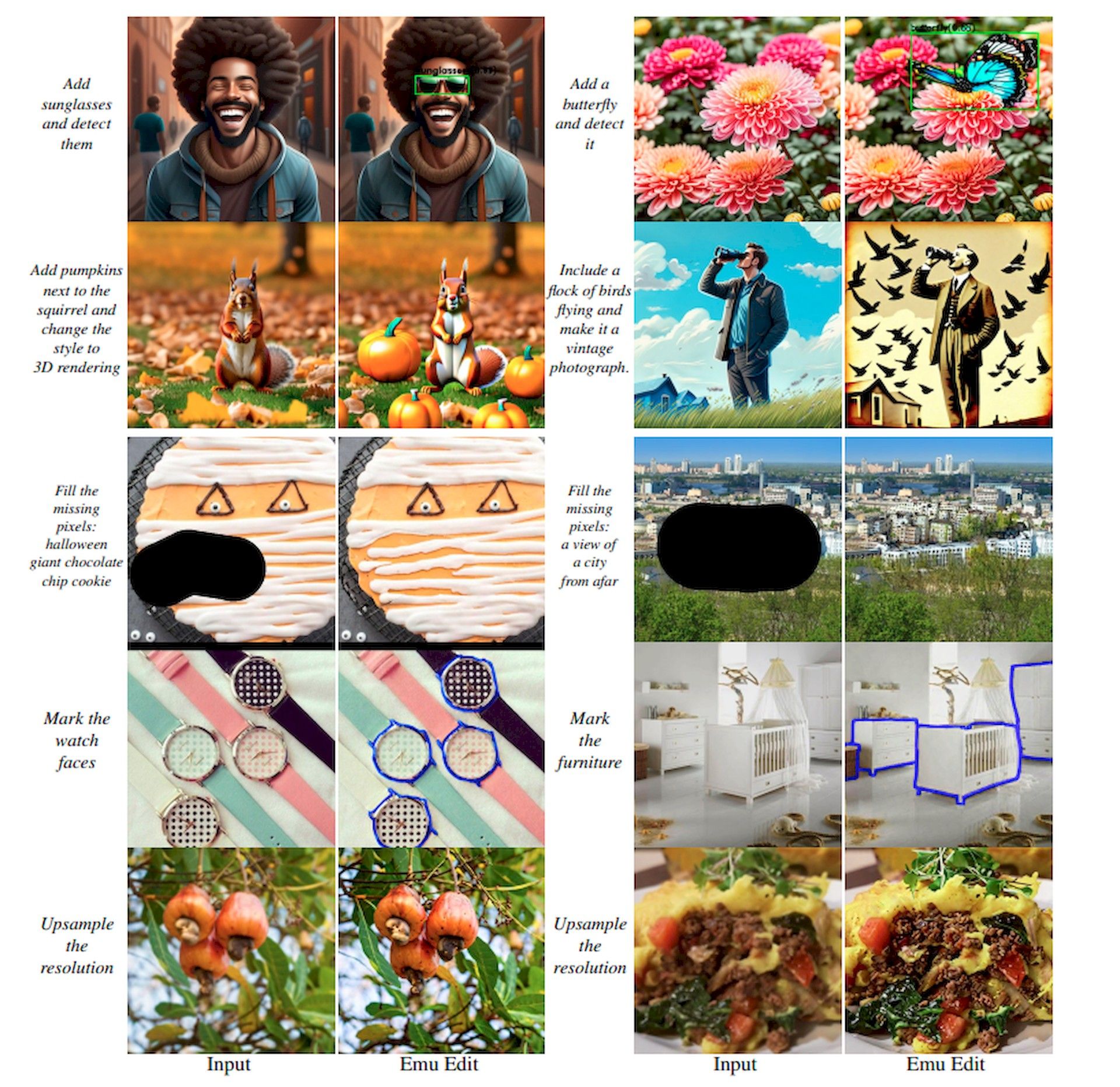

Emu Edit ist eine leistungsstarke Bildbearbeitungsplattform, die durch Erkennungs- und Generierungstechniken eine präzise Kontrolle über Bildbearbeitungsaufgaben bietet. Im Gegensatz zu herkömmlichen Bildbearbeitungsmethoden, die häufig zu übermäßigen Änderungen oder zu geringer Leistung führen, folgt Emu Edit den Anweisungen genau und stellt so sicher, dass nur relevante Pixel geändert werden. Das bedeutet, dass beim Hinzufügen von Text zu einer Baseballkappe die Kappe selbst unverändert bleibt. Metas wichtigste Erkenntnis ist die Integration von Computer-Vision-Aufgaben als Anweisungen in Bilderzeugungsmodelle und bietet so eine beispiellose Kontrolle bei der Bilderzeugung und -bearbeitung.

Emu wurde anhand eines großen Datensatzes synthetisierter Proben (10 Millionen) trainiert, um das Modell von Meta zu trainieren, was zu überlegenen Bearbeitungsergebnissen in Bezug auf Befehlsgenauigkeit und Bildqualität führte. In Metas Bewertungen zeigte Emu bei einer Reihe von Bildbearbeitungsaufgaben modernste Leistung und übertraf damit aktuelle Methoden.

Zu den Hauptfunktionen von Emu Edit gehören:

- Freiformbearbeitung durch Anleitung

- Präzise Pixelveränderung

- Beispiellose Kontrolle von Computer-Vision-Aufgaben

Die außergewöhnlichen Bearbeitungsergebnisse und die hochmoderne Leistung der Plattform machen sie zu einer ausgezeichneten Wahl für Benutzer, die qualitativ hochwertige Bilder erstellen möchten.

Benutzer können die lesen Emu Edit-Papier um mehr über das Modell der neuesten Generation von Meta zu erfahren. Das Papier bietet einen detaillierten Überblick über die Architektur, Trainingsmethodik und Leistungsmetriken von Emu Edit. Es enthält auch Beispiele für die Fähigkeiten von Emu Edit, die die Vielseitigkeit und Leistungsfähigkeit der Plattform demonstrieren.

Metas KI-Ambitionen

Meta (ehemals Facebook) hat in den letzten Jahren stark in die Forschung und Entwicklung im Bereich der künstlichen Intelligenz (KI) investiert und eine breite Palette an KI-fokussierten Produkten und Initiativen geschaffen. Diese Produkte werden zur Verbesserung der Kernprodukte des Unternehmens wie Facebook, Instagram und WhatsApp sowie zur Entwicklung neuer Produkte und Dienstleistungen eingesetzt.

Metas KI-gestütztes Übersetzungstool SeamlessM4T überbrückt nahtlos Sprachbarrieren und ermöglicht die Übersetzung von über 100 Sprachen mit bemerkenswerter Genauigkeit.

KI-gestützte Bild- und Videoerkennungsfunktionen ermöglichen es Meta außerdem, Objekte, Personen und Szenen in visuellen Inhalten zu identifizieren. Diese Technologie spielt eine entscheidende Rolle bei der Verbesserung der Anzeigenrelevanz, der Erleichterung der Inhaltserkennung und der Bekämpfung der Verbreitung unangemessenen Materials.

Die KI-Chatbots von Meta dienen als digitale Assistenten, die Kundensupport leisten, Anfragen beantworten und Aufgaben effizient und präzise ausführen. Diese Chatbots sind über Facebook Messenger, WhatsApp und andere Meta-Plattformen leicht zugänglich.

Die KI-Ambitionen von Meta erstrecken sich auch auf die Entwicklung fortschrittlicher Sprachmodelle, wie z Lama 2. Durch die Nutzung der Leistungsfähigkeit der KI hat Llama 2 bemerkenswerte Fähigkeiten beim Verstehen natürlicher Sprache, bei der Beantwortung von Fragen und bei der Textgenerierung bewiesen.

Wir wissen noch nicht, was die Zukunft bringt, aber eines ist sicher: Die technologische Entwicklung schreitet immer schneller voran und bald wird es viel einfacher sein, ein AAA-Spiel oder einen Film zu erstellen, der mit einem Hollywood-Meisterwerk mithalten kann.

Quellenangabe für das Feature-Bild: Igor Surkow/Unsplash.