Stellen Sie sich ein Spracherkennungsmodell vor, das nicht nur mehrere Sprachen versteht, sondern diese auch nahtlos übersetzt und identifiziert. Whisper v3 ist die Verkörperung dieser Vision. Es ist nicht nur ein Modell; Es ist eine dynamische Kraft, die die Grenzen des Audiodatenverständnisses neu gestaltet.

Die Fähigkeit, Sprachen in gesprochenen Worten zu transkribieren, zu übersetzen und zu identifizieren, war lange Zeit der heilige Gral der Technologie und OpenAI hat sie gerade verändert.

Die vielfältige Audio-Revolution von Whisper v3

Whisper v3 ist ein hochentwickeltes und vielseitiges Spracherkennungsmodell, das von OpenAI entwickelt wurde. Es ist Teil der Whisper-Modellfamilie und bringt erhebliche Verbesserungen und Funktionen mit sich. Lassen Sie uns in die Details von Whisper v3 eintauchen:

- Allzweck-Spracherkennungsmodell: Whisper v3 ist wie seine Vorgänger ein Allzweck-Spracherkennungsmodell. Es wurde entwickelt, um gesprochene Sprache in Text umzuwandeln, was es zu einem unschätzbar wertvollen Werkzeug für eine Vielzahl von Anwendungen macht, darunter Transkriptionsdienste, Sprachassistenten und mehr.

- Multitasking-Fähigkeiten: Eines der herausragenden Merkmale von Whisper v3 sind seine Multitasking-Fähigkeiten. Es kann eine Vielzahl sprachbezogener Aufgaben ausführen, darunter:

- Mehrsprachige Spracherkennung: Whisper v3 kann Sprache in mehreren Sprachen erkennen und ist somit für verschiedene sprachliche Kontexte geeignet.

- Sprachübersetzung: Es kann Sprache nicht nur transkribieren, sondern auch in verschiedene Sprachen übersetzen.

- Spracherkennung: Das Modell ist in der Lage, die im bereitgestellten Audio gesprochene Sprache zu identifizieren.

- Erkennung von Sprachaktivitäten: Whisper v3 kann feststellen, wann Sprache in Audiodaten vorhanden ist, was es für Anwendungen wie die Erkennung von Sprachbefehlen in Sprachassistenten nützlich macht.

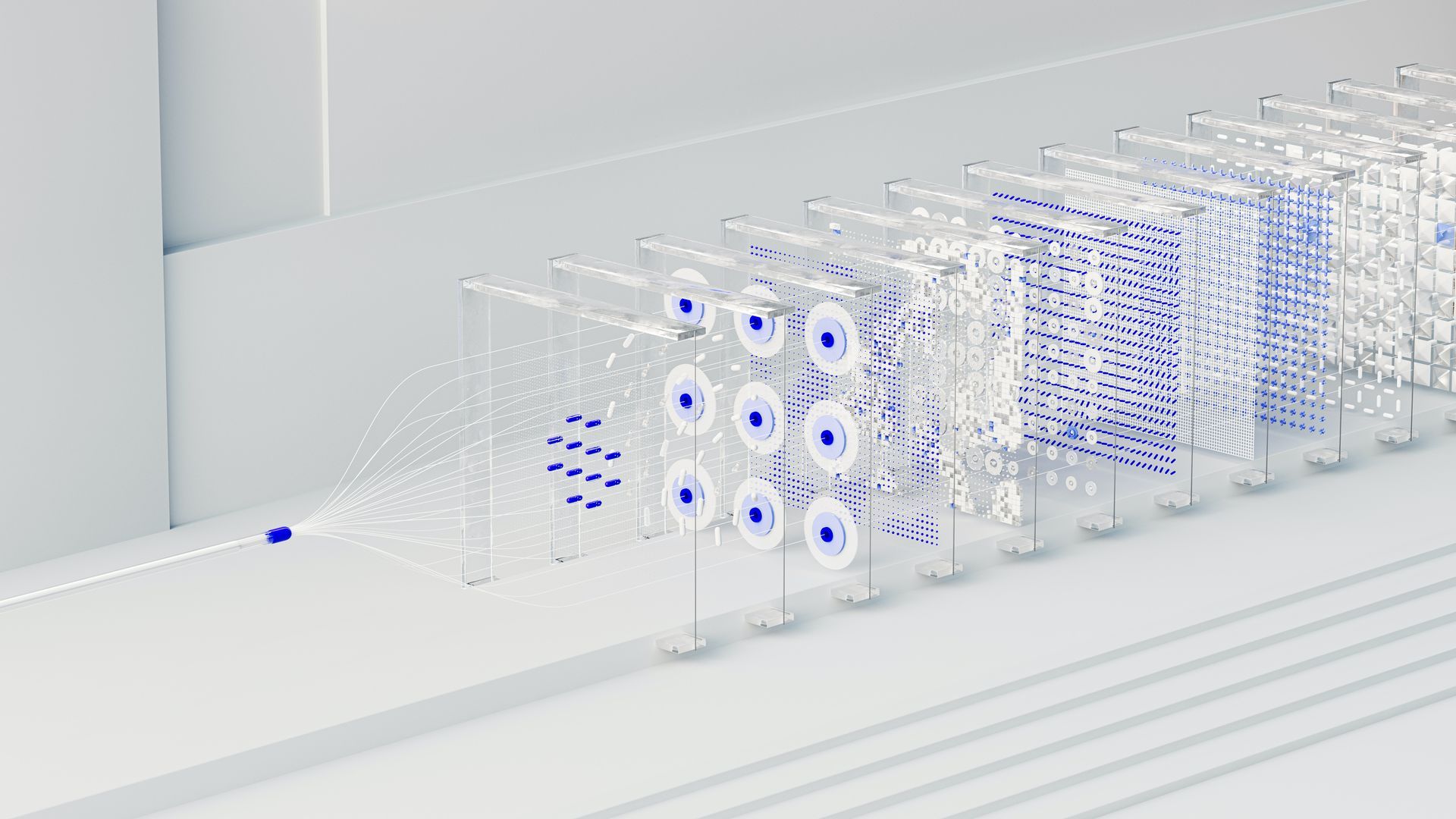

Whisper v3 basiert auf einem hochmodernen Transformer-Sequenz-zu-Sequenz-Modell. In diesem Modell wird eine Folge von Token, die die Audiodaten darstellen, verarbeitet und dekodiert, um die gewünschte Ausgabe zu erzeugen. Diese Architektur ermöglicht es Whisper v3, mehrere Stufen einer herkömmlichen Sprachverarbeitungspipeline zu ersetzen und so den Gesamtprozess zu vereinfachen.

Um verschiedene Aufgaben auszuführen, verwendet v3 spezielle Token, die als Aufgabenspezifizierer oder Klassifizierungsziele dienen. Diese Token helfen dem Modell dabei, die spezifische Aufgabe zu verstehen, die es ausführen muss.

Zusammenfassung des OpenAI Dev Day: ChatGPT wird sich weiter in den Alltag integrieren

Verfügbare Modelle und Sprachen

Whisper v3 bietet eine Reihe von Modellgrößen, von denen vier nur in englischer Sprache erhältlich sind. Diese Modelle unterscheiden sich hinsichtlich des Kompromisses zwischen Geschwindigkeit und Genauigkeit. Die verfügbaren Modelle und ihre ungefähren Speicheranforderungen und relativen Inferenzgeschwindigkeiten im Vergleich zum großen Modell sind wie folgt:

- Winzig: 39 Millionen Parameter, ca. 32x schneller als das große Modell und benötigt etwa 1 GB VRAM.

- Base: 74 Millionen Parameter, ca. 16x schneller und erfordert außerdem etwa 1 GB VRAM.

- Klein: 244 Millionen Parameter, ca. 6x schneller und benötigt etwa 2 GB VRAM.

- Mittel: 769 Millionen Parameter, ca. 2x schneller und erfordert etwa 5 GB VRAM.

- Groß: 1550 Millionen Parameter, die als Basis dienen und etwa 10 GB VRAM benötigen.

Die reinen englischen Modelle, insbesondere die tiny.en Und base.en Versionen weisen tendenziell eine bessere Leistung auf, wobei der Unterschied mit zunehmender Umstellung geringer wird small.en Und medium.en Modelle.

Die Leistung von Whisper v3 kann je nach der zu transkribierenden oder übersetzten Sprache erheblich variieren. Wortfehlerraten (WERs) und Zeichenfehlerraten (CERs) werden verwendet, um die Leistung verschiedener Datensätze zu bewerten. Die Leistung des Modells wird in den bereitgestellten Zahlen und Metriken detailliert beschrieben und bietet Aufschluss darüber, wie gut es verschiedene Sprachen und Aufgaben bewältigt.

So verwenden Sie Whisper v3

Um Whisper v3 effektiv nutzen zu können, ist es wichtig, die erforderliche Umgebung einzurichten. Das Modell wurde mit Python 3.9.9 und PyTorch 1.10.1 entwickelt. Es wird jedoch erwartet, dass es mit einer Reihe von Python-Versionen von 3.8 bis 3.11 sowie mit neueren PyTorch-Versionen kompatibel ist.

Darüber hinaus stützt es sich auf verschiedene Python-Pakete, einschließlich des Tiktokens von OpenAI für eine effiziente Tokenisierung. Die Installation von Whisper v3 kann mit den bereitgestellten Pip-Befehlen erfolgen. Es ist wichtig zu beachten, dass die Einrichtung des Modells auch die Installation von erfordert ffmpeg, ein Befehlszeilentool zur Audioverarbeitung. Je nach Betriebssystem können zur Installation unterschiedliche Paketmanager genutzt werden.

Für detailliertere Informationen klicken Sie Hier.

Abschluss

Whisper v3 ist ein vielseitiges Spracherkennungsmodell von OpenAI. Es bietet mehrsprachige Spracherkennung, Übersetzung, Spracherkennung und Sprachaktivitätserkennung. Es basiert auf einem Transformer-Modell und vereinfacht die Audioverarbeitung. Whisper v3 ist mit verschiedenen Python-Versionen kompatibel, verfügt über unterschiedliche Modellgrößen und ist über Befehlszeilen- und Python-Schnittstellen zugänglich. Unter der MIT-Lizenz veröffentlicht, fördert es Innovationen und ermöglicht Benutzern, Wissen aus gesprochener Sprache zu extrahieren und so Sprachbarrieren zu überwinden.

Hervorgehobener Bildnachweis: Andrew Neel/Pexels