Stability AI hat kürzlich FreeWilly vorgestellt, seine neuen Sprachmodelle, die auf „synthetischen“ Daten trainiert wurden. Die LLMs sind jetzt für den Masseneinsatz verfügbar und wurden vom Carper AI-Labor von Stability AI entwickelt.

Die beiden neuen LLMs, die am Freitag von Stability AI vorgestellt wurden, dem Unternehmen hinter der Bilderzeugungs-KI Stable Diffusion, das vom ehemaligen britischen Hedgefonds Emad Mostaque gegründet wurde, dem vorgeworfen wurde, seinen Lebenslauf aufzublähen, basieren beide auf Versionen von Metas LLaMA und LLaMA 2 Open-Source-Modelle, wurden jedoch auf einem völlig neuen, kleineren Datensatz trainiert, der synthetische Daten enthält.

Beide Modelle eignen sich hervorragend zur Lösung komplizierter Probleme in Spezialgebieten wie Jura und Mathematik sowie bei heiklen sprachlichen Details.

Die FreeWillys wurden von Stabilitys Tochtergesellschaft CarperAI unter einer „nichtkommerziellen Lizenz“ veröffentlicht, die ihre Nutzung für Gewinn-, Unternehmens- oder Geschäftszwecke verbietet. Vielmehr sollen sie die Forschung weiter vorantreiben und Open Access in der KI-Community fördern.

Was ist FreeWilly?

In Zusammenarbeit mit dem KI-Entwicklungsunternehmen CarperAI stellte Stability AI am 21. Juli 2023 FreeWilly1 und dessen Fortsetzung FreeWilly2 vor. FreeWilly1 wurde durch überwachte Feinabstimmung (Supervised Fine-Tuning, SFT) an synthetisch erstellten Datensätzen optimiert, die auf dem umfangreichen Sprachmodell von Meta, LLaMA-65B, basieren. Andererseits wird LLaMA 270B bei der Entwicklung von FreeWilly2 verwendet.

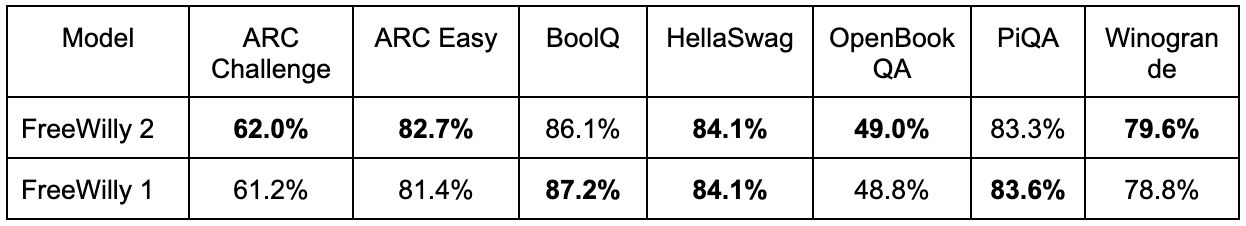

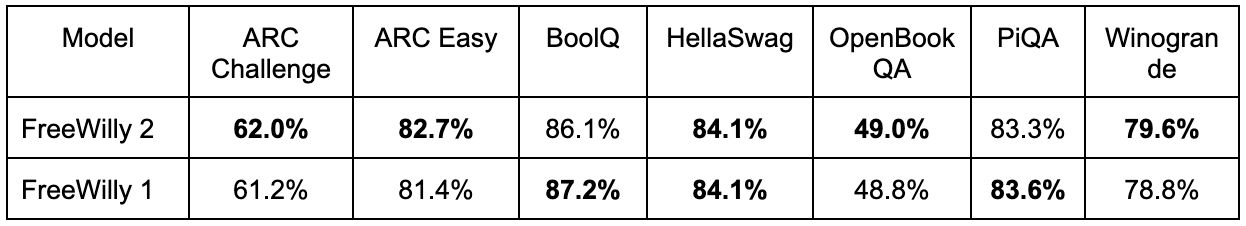

Berichten zufolge erfüllt FreeWilly2 mehrere Aufgaben auf Augenhöhe mit GPT-3.5. Unabhängige Benchmark-Tests, die von Stability AI-Forschern durchgeführt wurden, zeigten, dass FreeWilly2 ChatGPT mit GPT-3.5 übertraf, das eine Genauigkeit von 85,5 % erreichte, mit einer Genauigkeit von 86,4 % in „HellaSwag“, einer Inferenzaufgabe in natürlicher Sprache, die den gesunden Menschenverstand bewertet.

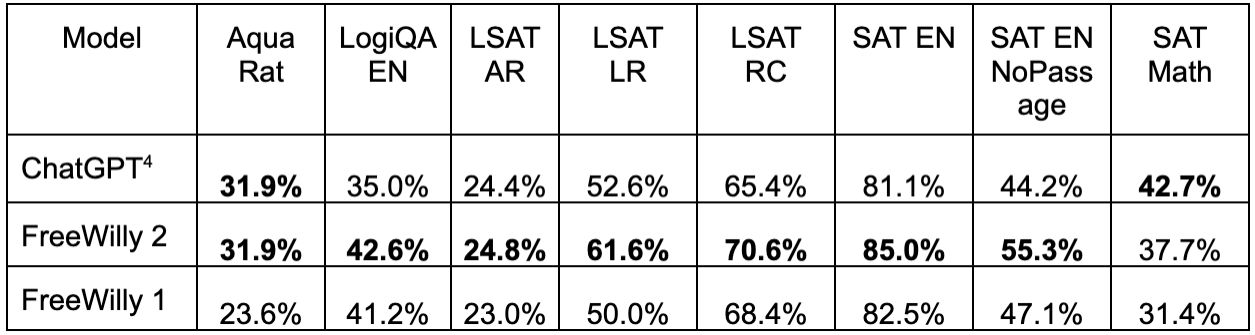

Mit Ausnahme des arithmetischen Teils des US-Hochschulaufnahmetests namens „SAT Math“ übertraf FreeWilly2 GPT-3.5 bei den meisten Aufgaben, wenn die Leistung mit der Benchmark-Software „AGIEval“ für große Sprachmodelle verglichen wurde.

Darüber hinaus legt Stability AI Wert auf die sorgfältige Veröffentlichung von FreeWilly-Modellen und die gründliche Risikobewertung durch ein internes, spezialisiertes Team. Das Unternehmen ermutigt regelmäßig externe Beiträge zur Verbesserung der Sicherheitsprotokolle.

Stabilitäts-KI verrät Stabiles Gekritzel: Skizze auf HD

„FreeWilly1 und FreeWilly2 setzen einen neuen Standard im Bereich der Open-Access-Modelle großer Sprachen. Beide treiben die Forschung erheblich voran, verbessern das Verständnis natürlicher Sprache und ermöglichen komplexe Aufgaben. Wir freuen uns über die endlosen Möglichkeiten, die diese Modelle der KI-Community bieten werden, und über die neuen Anwendungen, die sie inspirieren werden“, sagte Stability AI in seiner Ankündigung.

Erstaunliche Arbeit aus unserem Labor

! Wir sind so stolz, der Welt zeigen zu können, woran wir mitten in der Nacht gearbeitet haben! Herzlichen Glückwunsch an @dmayhem93 für die schlaflosen Nächte, um Ihnen diese unglaubliche Veröffentlichung zu bescheren! https://t.co/JqlWX6MA2L

– Carper, ein Stabilitäts-KI-Labor (@carperai) 21. Juli 2023

Forscher verwendeten den „Orca“-Trainingsprozess auf FreeWilly

Die Titel der Modelle sind Anspielungen auf den KI-Trainingsprozess „Orca“ von Microsoft-Forschern, der es „kleineren“ Modellen (die weniger Daten ausgesetzt sind) ermöglicht, eine ebenso gute Leistung zu erbringen wie großen Kernmodellen, die größeren Datensätzen ausgesetzt sind. (Dies ist kein Hinweis auf die Orcas, dass IRL ein Boot versenkt hat.)

FreeWilly1 und FreeWilly2 wurden speziell mit 600.000 Datenpunkten trainiert – nur 10 % der Größe des ursprünglichen Orca-Datensatzes – unter Verwendung der Anleitung von vier von Enrico Shippole erstellten Datensätzen. Dadurch waren sie sowohl deutlich erschwinglicher als auch umweltfreundlicher (verbrauchen weniger Energie und hinterließen einen geringeren CO2-Fußabdruck) als das ursprüngliche Orca-Modell und die meisten führenden LLMs. Die Modelle lieferten weiterhin eine hervorragende Leistung und erreichten teilweise sogar die Leistung von ChatGPT auf GPT-3.5 oder übertrafen diese sogar.

Um diese Modelle zu bewerten, verwendeten die Forscher das lm-eval-Harness von EleutherAI, zu dem sie AGIEval hinzufügten. Die Ergebnisse zeigen, dass beide FreeWilly-Modelle beim komplexen Denken, beim Erkennen sprachlicher Feinheiten und beim Lösen von Problemen in Spezialgebieten wie Jura und Mathematik außergewöhnlich gut abschneiden.

Nach Ansicht des Teams helfen die beiden Modelle dem Menschen, gesprochene Sprache besser zu verstehen und neue, bisher unpraktische Möglichkeiten zu schaffen. Sie erhoffen sich alle neuartigen Anwendungen dieser Modelle in der künstlichen Intelligenz.

Hervorgehobener Bildnachweis: Stabilitäts-KI