Meta hat kürzlich MusicGen angekündigt, einen KI-gestützten Musikgenerator, der eine Textbeschreibung in 12 Sekunden Audio umwandeln kann. Das Unternehmen hat es auch als Open-Source-Lösung bereitgestellt, obwohl Google den anderen Weg gewählt hat. Heute erklären wir, was MusicGen von Meta ist und wie man es verwendet!

Die meisten künstlerischen Aktivitäten konnten von der KI beeinflusst werden, und das Musikgeschäft steht nun fest unter ihrem Einfluss. Genauso wie ChatGPT oder andere große, auf Sprachmodellen basierende KI Texte erstellen, hat Meta kürzlich die Verfügbarkeit der Open-Source-Version ihres KI-Modells zum Generieren von Musik angekündigt.

Was ist MusicGen?

MusicGen basiert auf einem Transformer-Modell, wie auch die meisten heute verwendeten Sprachmodelle. MusicGen sagt den nächsten Abschnitt eines Musikstücks auf ähnliche Weise voraus, wie ein Sprachmodell die folgenden Buchstaben in einer Phrase vorhersagt.

Die Forscher verwenden den EnCodec-Audio-Tokenizer von Meta, um die Audiodaten in kleinere Teile zu zerlegen. MusicGen ist ein schneller und effektiver einstufiger Ansatz, der die Token-Verarbeitung parallel durchführt.

Für das Training nutzte die Crew 20.000 Stunden autorisierte Musik. Sie verwendeten 10.000 hochwertige Audioaufnahmen aus einem internen Datensatz sowie insbesondere Musikdaten von Shutterstock und Pond5.

Generative KI: Der Ursprung der beliebten KI-Tools

MusicGen ist außergewöhnlich in seiner Fähigkeit, sowohl Text- als auch Musikhinweise zu verarbeiten, sowie in der Effektivität des Designs und der Geschwindigkeit der Erstellung. Der Text legt den grundlegenden Stil fest, dem anschließend die Musik der Audiodatei folgt.

Sie können die Richtung der Melodie nicht genau ändern, sodass Sie sie beispielsweise in verschiedenen Musikstilen hören können. Es spiegelt sich nicht perfekt in der Ausgabe wider und dient nur als allgemeiner Leitfaden für die Generierung.

Es gab nicht viele qualitativ hochwertige Beispiele für die Musikgenerierung, die der Öffentlichkeit zugänglich gemacht wurden, obwohl viele andere Modelle Textgenerierung, Sprachsynthese, erstellte Grafiken und sogar kurze Videos ausführen.

Der Studienarbeit Das dazugehörige Buch, das auf der Preprint-Website von arXiv zugänglich ist, behauptet, dass eine der Hauptschwierigkeiten bei Musik darin besteht, dass das gesamte Frequenzspektrum durchlaufen werden muss, was ein intensiveres Sampling erfordert. Ganz zu schweigen von den komplizierten Kompositionen und sich überschneidenden Instrumenten der Musik.

Wie verwende ich MusicGen?

Durch das Hugging Face-APIBenutzer können MusicGen testen. Je nachdem, wie viele Benutzer es gleichzeitig verwenden, kann es jedoch einige Zeit dauern, Musik zu generieren. Für deutlich schnellere Ergebnisse können Sie die Hugging Face-Website nutzen, um Ihre eigene Instanz des Modells einzurichten. Wenn Sie über die erforderlichen Fähigkeiten und Ausrüstung verfügen, können Sie dies tun Laden Sie den Code herunter und führen Sie es stattdessen manuell aus.

Wenn Sie wie die meisten anderen die Website-Version ausprobieren möchten, gehen Sie wie folgt vor:

- Öffne dein Webbrowser.

- Gehe zum Hugging Face-Website.

- Klicken Räume oben rechts.

- Typ „MusicGen“ in das Suchfeld ein.

- Finden Sie die Version, die von veröffentlicht wurde Facebook.

- Geben Sie Ihr prompt in die Box am links.

- Klicken Generieren.

Wie funktioniert es?

Ihre Beschreibung wird vom MusicGen-Modell verwendet, um 12 Sekunden Audio zu generieren. Es kann auch eine Referenz-Audiodatei bereitgestellt werden, aus der eine komplexe Melodie erstellt wird. Durch die Verwendung des Referenzaudios wird sich das Modell bemühen, Musik zu erstellen, die den Geschmack des Benutzers besser widerspiegelt, indem es sich sowohl an die Beschreibung als auch an die bereitgestellte Melodie hält.

Wir präsentieren MusicGen: Ein einfaches und kontrollierbares Musikgenerierungsmodell. MusicGen kann sowohl durch Text als auch durch Melodie angeregt werden.

Wir veröffentlichen Code (MIT) und Modelle (CC-BY NC) für offene Forschung, Reproduzierbarkeit und für die Musik-Community: https://t.co/OkYjL4xDN7 pic.twitter.com/h1l4LGzYgf— Felix Kreuk (@FelixKreuk) 9. Juni 2023

Das Modell verwendet einen EnCodec-Audio-Tokenizer, der auf einem Transformer-Sprachmodell basiert, wie von Kreuk angegeben. Über die Hugging Face API können Benutzer MusicGen testen. Je nachdem, wie viele Benutzer es gleichzeitig verwenden, kann es jedoch einige Zeit dauern, Musik zu generieren. Um deutlich schnellere Ergebnisse zu erzielen, können Sie auf der Hugging Face-Website eine eigene Instanz des Modells einrichten. Wenn Sie über die erforderlichen Fähigkeiten und Geräte verfügen, können Sie den Code auch herunterladen und stattdessen manuell ausführen.

MusicGen vs. Google MusicLM

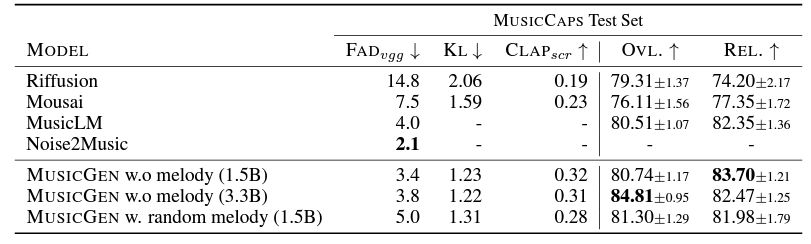

MusicGen scheint etwas bessere Ergebnisse zu erzielen. Die Forscher demonstrieren dies, indem sie die Ergebnisse von MusicGen mit denen von MusicLM, Riffusion und Musai auf einer Beispielwebsite vergleichen. Es ist in vier Modellgrößen erhältlich, von winzig (300 Millionen Parameter) bis groß (3,3 Milliarden Parameter), wobei letzteres das größte Potenzial für die Erstellung komplexer Musik bietet. Es kann lokal betrieben werden (eine GPU mit mindestens 16 GB RAM wird empfohlen).

Eines der zahlreichen Beispiele dafür, wie Meta KI nutzt, um seinen Verbrauchern immersive und fesselnde Erlebnisse zu bieten, ist MusicGen. Das Ziel von Meta besteht darin, eine gemeinsame virtuelle Welt namens Metaverse zu schaffen, in der Benutzer auf vielen Plattformen und Geräten interagieren, zusammenarbeiten und Spaß haben können. Dank MusicGen wird das Metaversum unterhaltsamer und musikalischer.